ECCV`24 | 比DragDiffusion快100倍!RegionDrag:快·準(zhǔn)·好的圖像編輯方法!港大&牛津

文章鏈接:https://arxiv.org/pdf/2407.18247

git鏈接:https://github.com/LuJingyi-John/RegionDrag

?

亮點(diǎn)直擊

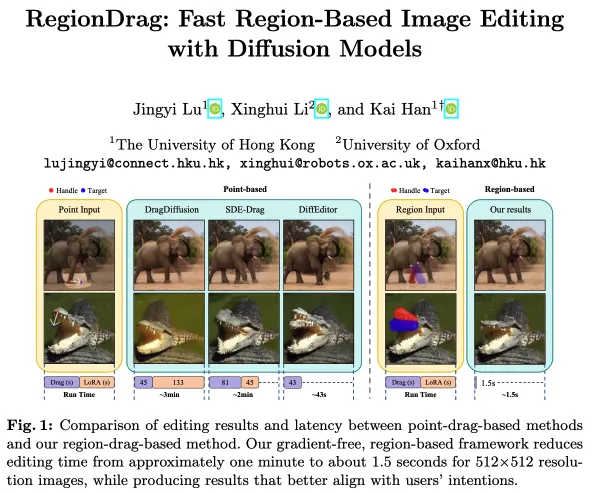

- 引入了一種基于區(qū)域的圖像編輯方法,以克服基于點(diǎn)拖拽方法的局限性,利用更豐富的輸入上下文來更好地對(duì)齊編輯結(jié)果與用戶的意圖。

- 通過采用無梯度的復(fù)制粘貼操作,基于區(qū)域的圖像編輯比現(xiàn)有方法快得多(見上圖1),在一次迭代中完成拖拽。

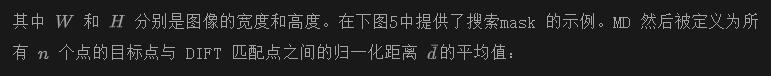

- 擴(kuò)展了兩個(gè)基于點(diǎn)拖拽的數(shù)據(jù)集,添加了基于區(qū)域拖拽的指令,以驗(yàn)證RegionDrag的有效性并為基于區(qū)域的編輯方法提供基準(zhǔn)。

基于點(diǎn)拖拽的圖像編輯方法,如DragDiffusion,已引起了廣泛關(guān)注。然而,由于點(diǎn)編輯指令的稀疏性,基于點(diǎn)拖拽的方法存在計(jì)算開銷大和用戶意圖誤解的問題。本文提出了一種基于區(qū)域的復(fù)制粘貼拖拽方法,RegionDrag,以克服這些局限性。RegionDrag 允許用戶以操作區(qū)和目標(biāo)區(qū)的形式表達(dá)其編輯指令,從而實(shí)現(xiàn)更精確的控制并減少模糊性。此外,基于區(qū)域的操作可以在一次迭代中完成編輯,速度比基于點(diǎn)拖拽的方法快得多。還引入了注意力交換技術(shù),以增強(qiáng)編輯過程的穩(wěn)定性。為了驗(yàn)證本文的方法,擴(kuò)展了現(xiàn)有的基于點(diǎn)拖拽的數(shù)據(jù)集,添加了基于區(qū)域拖拽的指令。實(shí)驗(yàn)結(jié)果表明,RegionDrag在速度、準(zhǔn)確性和與用戶意圖的對(duì)齊方面均優(yōu)于現(xiàn)有的基于點(diǎn)拖拽的方法。值得注意的是,RegionDrag在分辨率為512×512的圖像上完成編輯的時(shí)間少于2秒,這比DragDiffusion快了100倍以上,同時(shí)性能更優(yōu)。

編輯效果

RegionDrag

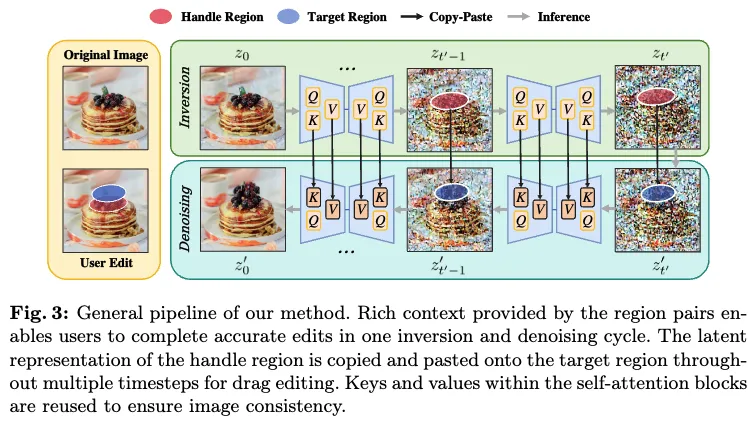

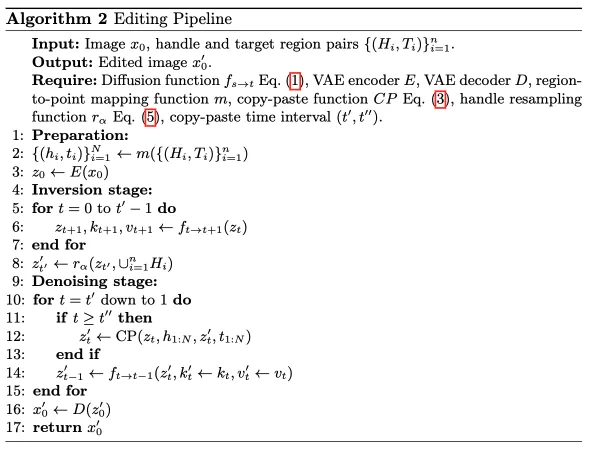

RegionDrag 允許用戶輸入操作區(qū)和目標(biāo)區(qū)對(duì),然后通過以下兩個(gè)主要步驟進(jìn)行編輯:

- 復(fù)制操作區(qū)覆蓋的潛在表示,并在反轉(zhuǎn)過程中存儲(chǔ)自注意力特征;

- 將復(fù)制的潛在表示粘貼到目標(biāo)位置,并在去噪過程中插入存儲(chǔ)的自注意力特征。

本節(jié)討論基于點(diǎn)拖拽方法的局限性,并介紹基于區(qū)域的輸入如何解決這些局限性。最后,展示了處理基于區(qū)域輸入的編輯流程。

從基于點(diǎn)的拖拽到基于區(qū)域的拖拽

盡管基于點(diǎn)拖拽的方法提供了一種直觀的用戶輸入方式,但從稀疏點(diǎn)中獲得的有限信息在編輯過程中對(duì)模型構(gòu)成了挑戰(zhàn)。具體來說,點(diǎn)指令會(huì)導(dǎo)致兩個(gè)主要問題:輸入模糊性和推理速度慢。

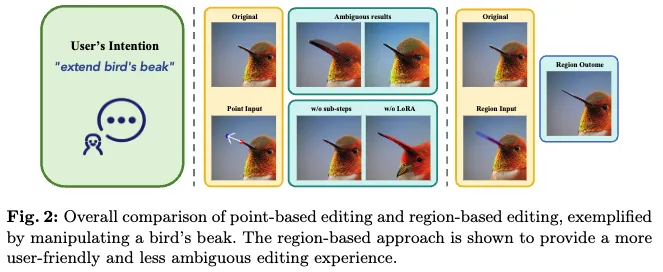

首先,點(diǎn)指令本質(zhì)上是模糊的。一種拖拽操作可能對(duì)應(yīng)多種可能的編輯效果。例如,用戶試圖在圖像中延長鳥的喙,如下圖2所示。用戶選擇鳥喙上的一個(gè)點(diǎn)并向左上角拖拽。然而,基于點(diǎn)拖拽的方法可能會(huì)誤解用戶的目標(biāo),認(rèn)為是要放大喙或者將整只鳥移動(dòng)到左側(cè),而不是延長喙,從而導(dǎo)致用戶意圖與模型輸出之間的不對(duì)齊。

其次,基于點(diǎn)拖拽的編輯涉及的復(fù)雜性需要相當(dāng)大的計(jì)算開銷。基于點(diǎn)拖拽的編輯具有挑戰(zhàn)性,因?yàn)槟P捅仨殢膯蝹€(gè)或少數(shù)點(diǎn)的運(yùn)動(dòng)中推斷出整個(gè)圖像的變化。為了在保持對(duì)象身份的同時(shí)執(zhí)行這種復(fù)雜的拖拽操作,基于點(diǎn)拖拽的方法嚴(yán)重依賴于兩個(gè)計(jì)算密集的步驟:為每個(gè)圖像訓(xùn)練一個(gè)獨(dú)特的LoRA和將拖拽過程分解為一系列子步驟。特別是,LoRA幫助模型保持原始圖像的身份,逐步拖拽則增加了實(shí)現(xiàn)預(yù)期編輯效果的機(jī)會(huì)。否則,編輯結(jié)果可能會(huì)受到顯著的身份扭曲或無效編輯的影響,如上圖2所示。問題的根源在于稀疏點(diǎn)對(duì)編輯施加的約束不足,因此模型必須依賴LoRA來防止扭曲,并通過迭代編輯在拖拽路徑上提供一定程度的額外監(jiān)督。因此,大多數(shù)基于點(diǎn)拖拽的方法需要幾分鐘才能編輯一張圖像,使其在現(xiàn)實(shí)世界應(yīng)用中不切實(shí)際。

解決這些問題的最簡單方法是鼓勵(lì)用戶提供足夠數(shù)量的點(diǎn)。然而,這種方法會(huì)導(dǎo)致用戶在指定和拖拽點(diǎn)時(shí)花費(fèi)過多時(shí)間。因此,作者設(shè)計(jì)了一種不僅對(duì)用戶友好且能為模型提供更多信息上下文的編輯形式,從而避免指令模糊、推理速度慢和用戶過度勞累。提出使用基于區(qū)域的操作來代替依賴拖拽點(diǎn)的方法,其中用戶指定一個(gè)操作區(qū)(H)以指示他們希望拖拽的區(qū)域,并指定一個(gè)目標(biāo)區(qū)(T)以展示他們希望實(shí)現(xiàn)的位置。然后,通過區(qū)域到點(diǎn)映射算法建立這兩個(gè)區(qū)域之間的密集映射,并通過一次反轉(zhuǎn)和去噪循環(huán)直接將操作區(qū)覆蓋的潛在表示復(fù)制到目標(biāo)區(qū)域來完成編輯。

盡管這種操作簡單,但它從兩個(gè)方面解決了模糊性和開銷問題:

- 基于區(qū)域的操作比拖拽點(diǎn)更具表現(xiàn)力和準(zhǔn)確性,從而顯著減少了模糊性。如圖2所示,通過簡單地畫一個(gè)更長的喙來表示延長鳥的喙,從而減少了基于點(diǎn)拖拽輸入的模糊性。

- 每個(gè)區(qū)域在密集映射后對(duì)應(yīng)大量的點(diǎn),因此它比稀疏點(diǎn)對(duì)編輯結(jié)果提供了更強(qiáng)的約束。結(jié)果是,不需要沿拖拽路徑插值中間點(diǎn)或渴望額外的監(jiān)督,編輯可以在一個(gè)步驟中完成。此外,操作區(qū)和目標(biāo)區(qū)可以大小不一且形狀任意,允許用戶方便地定義它們。

編輯流程

首先介紹基于區(qū)域的用戶輸入,然后介紹區(qū)域到點(diǎn)映射算法,最后介紹主要的工作流程。

?

用戶輸入:操作區(qū)和目標(biāo)區(qū)可以通過兩種方式定義:

- 輸入頂點(diǎn)以形成多邊形(例如三角形或四邊形)

- 使用畫筆工具刷出一個(gè)靈活的區(qū)域。

輸入形式的選擇主要取決于用戶的偏好。頂點(diǎn)適用于編輯定義明確的形狀,如移動(dòng)建筑物上的窗口;畫筆工具則更適合處理不規(guī)則的形狀,如彎曲的道路或人類的頭發(fā)。

?

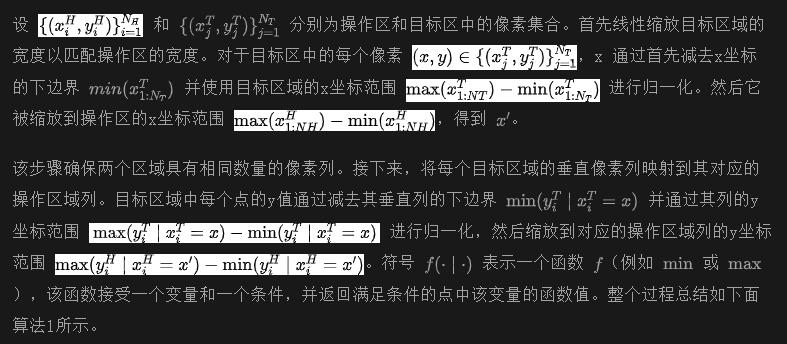

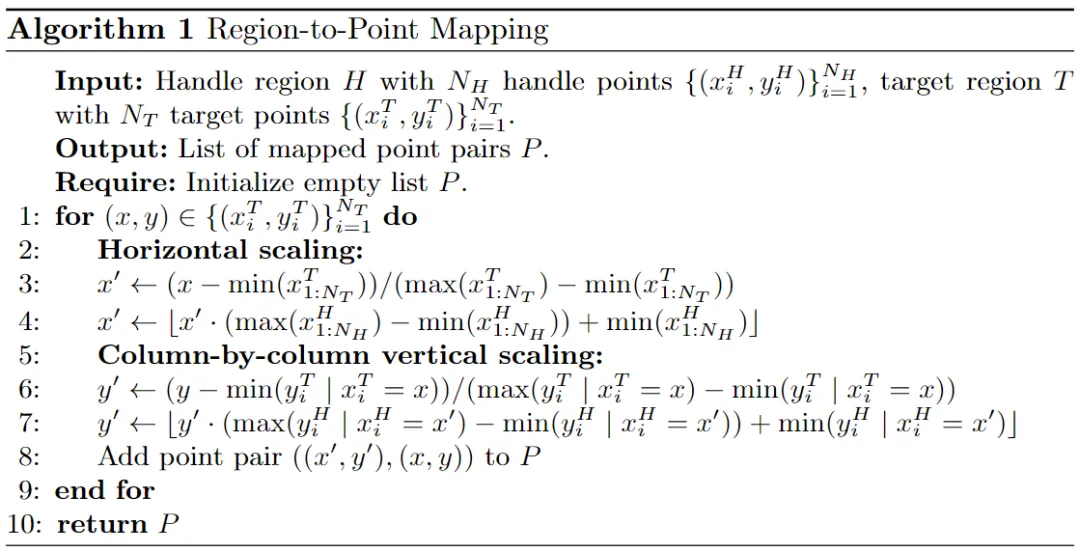

區(qū)域到點(diǎn)映射:為了在復(fù)制和粘貼潛在表示時(shí)保留原始空間信息,需要在操作區(qū)和目標(biāo)區(qū)之間建立密集的映射。如果區(qū)域限制為三角形或四邊形,可以使用仿射或透視映射計(jì)算轉(zhuǎn)換矩陣。然而,為任意形狀的刷出區(qū)域找到類似的轉(zhuǎn)換是具有挑戰(zhàn)性的。為了解決這個(gè)問題,提出了一種算法來數(shù)值地找到兩個(gè)區(qū)域之間的映射。

實(shí)驗(yàn)結(jié)果

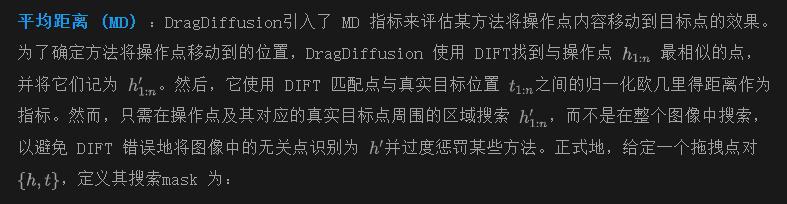

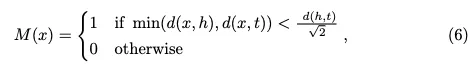

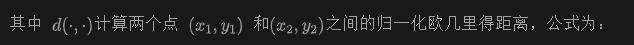

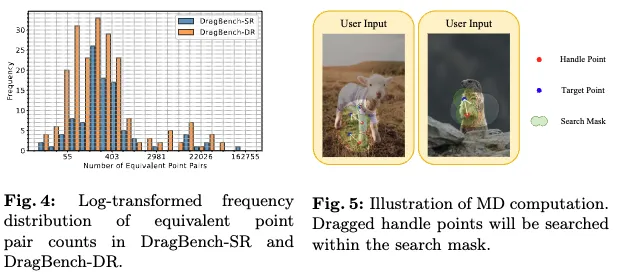

評(píng)估指標(biāo)

LPIPS:按照【24】的方法,使用 Learned Perceptual Image Patch Similarity (LPIPS) v0.1來測(cè)量編輯后圖像與原始圖像之間的身份相似性。LPIPS 計(jì)算圖像對(duì)之間的 AlexNet特征距離。高 LPIPS 分?jǐn)?shù)表明由于編輯而發(fā)生了意外的身份變化或偽影。較低的 LPIPS 分?jǐn)?shù)表明在編輯過程中對(duì)象的身份得到了很好的保留;然而,這并不一定意味著編輯效果更好,因?yàn)閮蓚€(gè)完全相同的圖像會(huì)產(chǎn)生 LPIPS 分?jǐn)?shù)為0。

實(shí)現(xiàn)細(xì)節(jié)

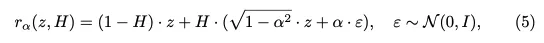

本文的方法使用 Python 實(shí)現(xiàn),依賴于 HuggingFace和 PyTorch庫。采用 Stable Diffusion v1-5 作為擴(kuò)散模型,圖像尺寸為 512 × 512,保持與之前基于擴(kuò)散的拖拽方法一致。使用 DDPM 采樣器進(jìn)行反轉(zhuǎn)和去噪采樣過程,配置為總共使用 20 個(gè)步驟。潛在表示反轉(zhuǎn)到時(shí)間步 t′ = 500(總共 1000 個(gè)步驟中的 SD1-5)。因此,進(jìn)行 10 次反轉(zhuǎn)步驟和 10 次去噪步驟。互相自注意力控制在所有時(shí)間步中都啟用,并且潛在的復(fù)制粘貼操作在 t'' = 200 處終止。噪聲權(quán)重a設(shè)置為 1。所有實(shí)驗(yàn)結(jié)果均在 NVIDIA Tesla V100 GPU 上獲得。

基準(zhǔn)對(duì)比

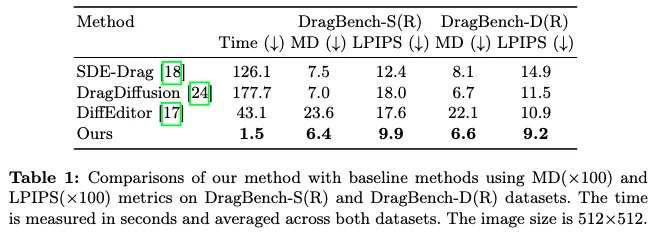

將 RegionDrag 與基于點(diǎn)拖拽的擴(kuò)散方法進(jìn)行比較,包括 DragDiffusion、SDE-Drag和 DiffEditor。由于 GAN 基于的方法在編輯 DragBench-S 和 DragBench-D 數(shù)據(jù)集中的多樣圖像時(shí)存在局限性,且需要領(lǐng)域特定的 StyleGAN 檢查點(diǎn),因此排除了 GAN 基于的方法。基于擴(kuò)散的方法在編輯任務(wù)中優(yōu)于 GAN 基于的方法,更適合評(píng)估。執(zhí)行時(shí)間在兩個(gè)數(shù)據(jù)集上取平均,并且所有方法均在同一設(shè)備上使用公開發(fā)布的代碼進(jìn)行測(cè)試。

定量評(píng)估

為了定量評(píng)估方法的編輯性能,使用 LPIPS 和平均距離作為指標(biāo),并將兩者均乘以 100 以便于說明。如下表1所示,RegionDrag 在 DragBench-S(R) 和 DragBench-D(R) 數(shù)據(jù)集上顯著優(yōu)于那些計(jì)算開銷大的基于點(diǎn)的方法。這些結(jié)果突顯了 RegionDrag 在保持圖像一致性同時(shí),在不同數(shù)據(jù)集上實(shí)現(xiàn)競爭性編輯結(jié)果的卓越性能。除了效果外,RegionDrag 在效率方面也表現(xiàn)出色。RegionDrag 實(shí)現(xiàn)了快速推理速度,編輯一個(gè) 512 × 512 的圖像大約需要 1.5 秒,比第二快的方法快 20 倍,比 DragDiffusion快 100 倍。鑒于復(fù)制粘貼操作引入的計(jì)算開銷可忽略不計(jì),RegionDrag 的推理時(shí)間與使用 SD1-5 生成一張 20 步的圖像相當(dāng)。

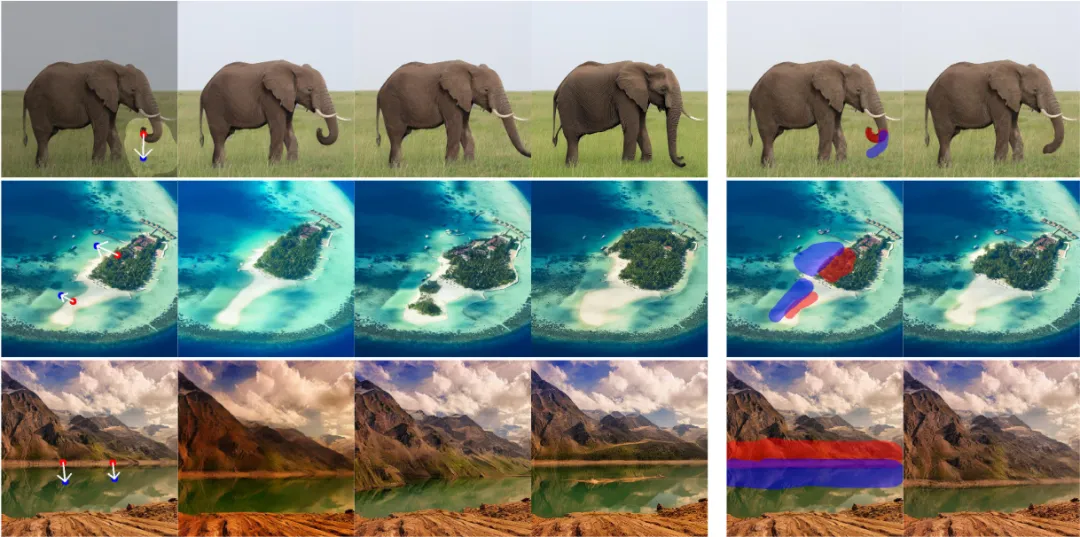

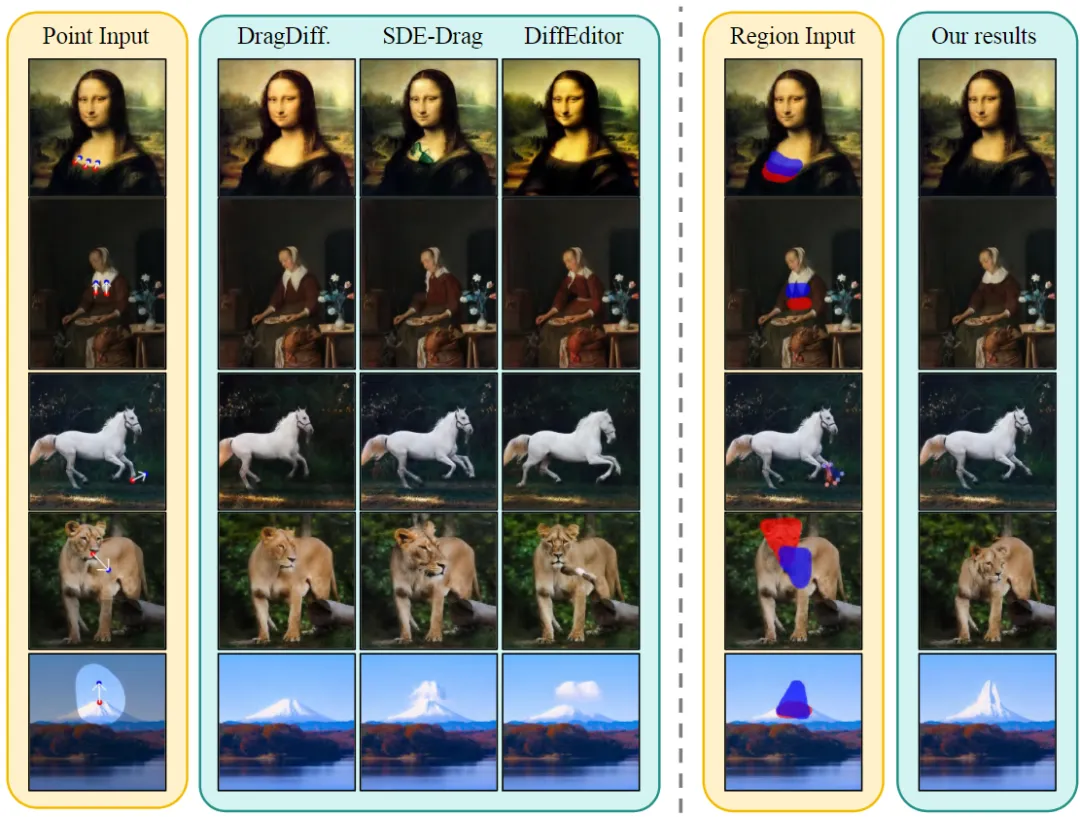

定性結(jié)果

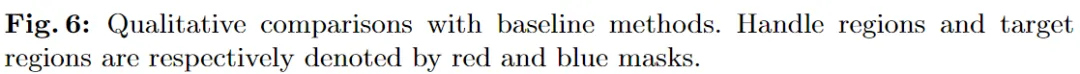

下圖6 比較了基于點(diǎn)拖拽和基于區(qū)域的編輯輸入及其對(duì)應(yīng)的結(jié)果,展示了 RegionDrag 的有效性。基于區(qū)域的方法利用了注釋區(qū)域提供的全面上下文來實(shí)現(xiàn)期望的修改,同時(shí)保持圖像的整體一致性,優(yōu)于基于點(diǎn)拖拽的編輯方法。

消融研究

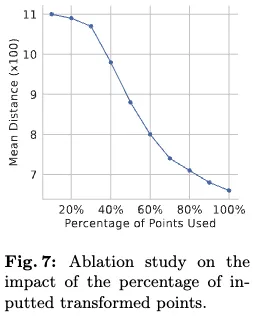

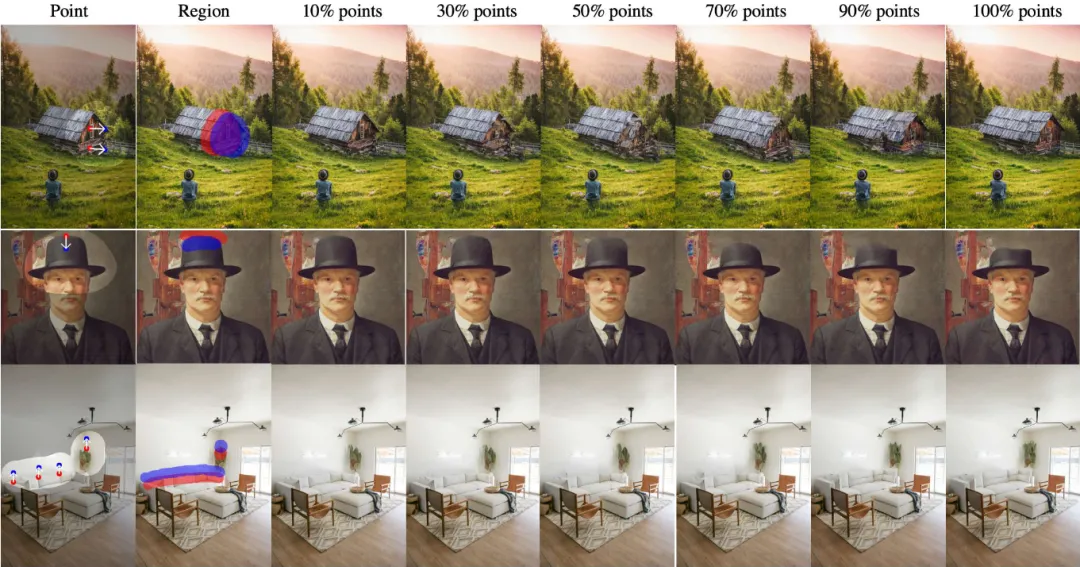

作者認(rèn)為點(diǎn)輸入的稀疏性導(dǎo)致了較差的編輯結(jié)果。為了定量證明這一點(diǎn),在 DragBench-DR 數(shù)據(jù)集上進(jìn)行了測(cè)試,通過隨機(jī)選擇每個(gè)樣本中等效轉(zhuǎn)換點(diǎn)的子集,并使用這些子集進(jìn)行推理。逐漸減少所選點(diǎn)的百分比,以觀察對(duì) MD 指標(biāo)的影響。如下圖7所示,隨著所用點(diǎn)的百分比減少,MD 的結(jié)果明顯呈上升趨勢(shì)。這表明,與基于區(qū)域的輸入相比,稀疏點(diǎn)輸入對(duì)輸出的約束較弱,導(dǎo)致編輯結(jié)果不令人滿意。這證實(shí)了在 RegionDrag 中采用基于區(qū)域的輸入的好處。

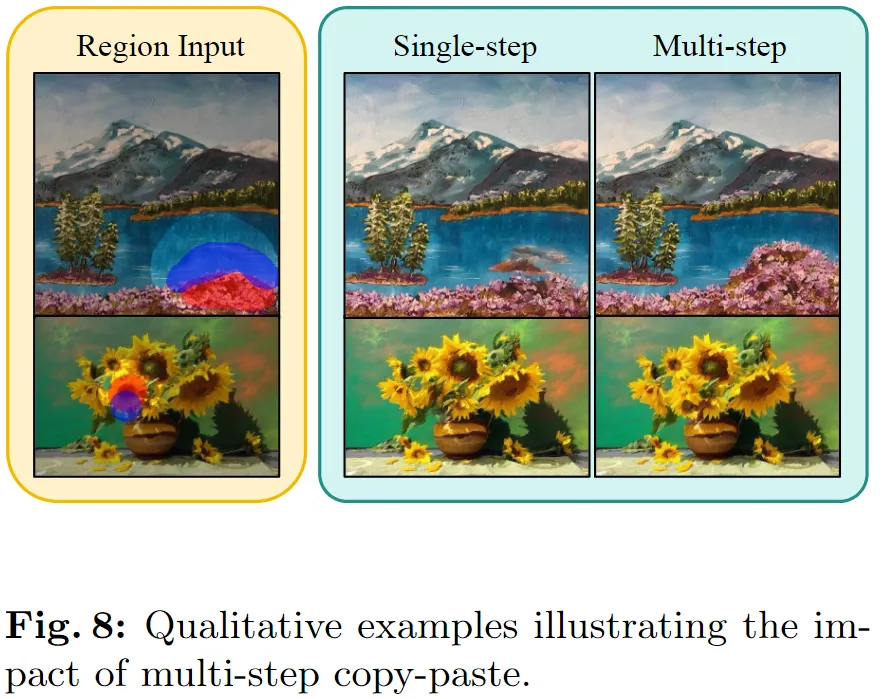

在去噪過程中,在時(shí)間間隔內(nèi)進(jìn)行圖像潛在表示的復(fù)制和粘貼。為了驗(yàn)證這一設(shè)計(jì),將其與僅在初始去噪時(shí)間步進(jìn)行復(fù)制粘貼的方法進(jìn)行了比較。下圖8顯示,僅在初始步驟進(jìn)行編輯可能會(huì)導(dǎo)致不可預(yù)測(cè)的結(jié)果,因?yàn)楹罄m(xù)的去噪階段可能會(huì)丟失這些編輯。多步復(fù)制粘貼通過在較小的時(shí)間步提供額外的指導(dǎo),同時(shí)保持圖像的保真度,從而解決了這一問題。

結(jié)論

本文引入了一個(gè)高效且有效的基于區(qū)域的編輯框架——RegionDrag,用于高保真圖像編輯。與現(xiàn)有的基于點(diǎn)拖拽的編輯方法不同,RegionDrag 從區(qū)域的角度重新審視了編輯問題。RegionDrag 通過復(fù)制和粘貼圖像的潛在表示和自注意力特征,實(shí)現(xiàn)了單步編輯,這不僅提供了卓越的效率,還達(dá)到了優(yōu)越的編輯性能。此外,基于現(xiàn)有數(shù)據(jù)集引入了兩個(gè)新的基準(zhǔn)測(cè)試,DragBench-SR 和 DragBench-DR,用于評(píng)估基于區(qū)域的編輯。實(shí)驗(yàn)結(jié)果一致證明了本文方法在效率和編輯性能上的卓越表現(xiàn)。

本文轉(zhuǎn)自 AI生成未來 ,作者:Jingyi Lu等