硬件不給力,如何窮玩深度神經(jīng)網(wǎng)絡(luò)?

深度學(xué)習(xí)的力量為其在真實(shí)世界的應(yīng)用創(chuàng)造出了巨大的機(jī)會。但深度學(xué)習(xí)的訓(xùn)練往往需要巨大的計(jì)算能力,有時(shí)候我們卻沒法(或沒錢)去使用強(qiáng)大的服務(wù)器或 NVIDIA 的 Jetson 那樣的嵌入式加速平臺。假如你需要使用一塊樹莓派開發(fā)板為你家的小院子開發(fā)一個(gè)目標(biāo)跟蹤器呢?換句話說,如果你需要在沒有加速器的 ARM CPU 上運(yùn)行一個(gè) CNN,你該怎么做?德國 BuddyGuard GmbH 的機(jī)器學(xué)習(xí)工程師 Dmytro Prylipko 近日在 LinkedIn 上發(fā)表了一篇文章,分享了他在弱硬件上運(yùn)行深度神經(jīng)網(wǎng)絡(luò)的經(jīng)驗(yàn)方法。

機(jī)器學(xué)習(xí)社區(qū)已經(jīng)在加速神經(jīng)網(wǎng)絡(luò)推理上進(jìn)行了很長一段時(shí)間的研究了,也已經(jīng)出現(xiàn)了大量可能有效的解決方案。在這篇文章中,我將嘗試回答一個(gè)簡單的問題:什么軟件庫/工具包/框架可以幫助改善我們訓(xùn)練好的模型的推理時(shí)間?出于文章篇幅的考慮,這篇文章我不會考慮修改網(wǎng)絡(luò)架構(gòu)(盡管這確實(shí)是一個(gè)好方法,比如 SqeezeNet),而是僅僅探討那些已經(jīng)可以在 ARM 設(shè)備上投入生產(chǎn)并且提供了 C/C++ 接口(因?yàn)槲覀兒苌僭谇度胧皆O(shè)備上使用 Lua 或 Python)的工具包和軟件庫。所以在這里我僅僅實(shí)驗(yàn)了 Caffe、TensorFlow 和 MXNet。

我們可以做什么

要加速你的計(jì)算,我們有兩個(gè)主要的大方向:1)修改模型;2)加速框架。當(dāng)然,也可能是將這兩者結(jié)合起來(而且確實(shí)是不錯的想法)。前一種方法往往需要使用更低的權(quán)重精度(也被稱為量化(quantization))和/或權(quán)重剪枝(weights pruning)。剪枝背后的思想是深度學(xué)習(xí)模型中的重要參數(shù)化冗余,而低精度方法(為浮點(diǎn)數(shù)使用了定點(diǎn)或動態(tài)定點(diǎn)表示)則利用了這樣一個(gè)事實(shí)——即推理過程并不需要高精度:因?yàn)檫\(yùn)算的線性本質(zhì)和非線性的動態(tài)范圍壓縮(dynamic range compression),量化誤差(quantization errors)往往傾向于亞線性地(sub-linearly)傳播,而不會引起數(shù)值不穩(wěn)定性(Vanhoucke, V., Senior, A., & Mao, M. (2011). Improving the speed of neural networks on CPUs)。此外,我們甚至可以使用低精度乘法來訓(xùn)練模型。結(jié)合 SIMD 指令(比如 SSE3),參數(shù)量化可以實(shí)現(xiàn)非常有效的計(jì)算加速。但是目前我們還很難找到同時(shí)使用了這兩者的解決方案。比如 Ristretto 可以執(zhí)行自動量化,但它卻并沒有利用其來降低計(jì)算成本。TensorFlow 也可以執(zhí)行量化,但其推理時(shí)間實(shí)際上卻增加了 5 到 20 倍,因?yàn)槠湎驁D(graph)中還引入了輔助量化/去量化節(jié)點(diǎn)(auxiliary quantize/dequantize nodes)。所以,如果空間上的考慮很重要,那么實(shí)際上我們可以將量化僅僅看作是一種壓縮網(wǎng)絡(luò)權(quán)重的方法。至少對于當(dāng)前的狀態(tài)而言,我們可以這樣考慮。

另一方面,我們也有用于框架的加速執(zhí)行時(shí)間(execution time)的方法,而不會影響到模型參數(shù)。這些方法基本上都是試圖優(yōu)化矩陣之間的乘法(GEMM)的通用計(jì)算技巧,并因此會同時(shí)影響卷積層(其計(jì)算通常是 im2col + GEMM)和全連接層。除此之外是 NNPACK:一個(gè)用于深度學(xué)習(xí)框架的加速包。這個(gè)加速包還曾得到過 Yann LeCun 的推薦!就我所知,NNPACK 使用了 FFT 來將時(shí)間域中的卷積運(yùn)算替換成了頻域中的乘法計(jì)算。

另一個(gè)方法是將網(wǎng)絡(luò)定義和權(quán)重翻譯成針對目標(biāo)進(jìn)行優(yōu)化過的代碼,而不是將它們運(yùn)行在同樣一個(gè)框架內(nèi)。這種方法的典型案例是 TensorRT。還有 CaffePresso 可以將 Caffe prototxt 翻譯成針對各種不同后端的更低級的規(guī)格。但是,TensorRT 的運(yùn)行需要 CUDA,而且只能在 NVIDIA GPU 上使用,而 CaffePresso 也需要某種硬件加速器(DSP、FPGA 或 NoC),所以這兩種都不適合用于我的測試硬件——樹莓派。

相關(guān)鏈接:

- Ristretto:http://lepsucd.com/?page_id=621

- NNPACK:http://github.com/Maratyszcza/NNPACK

- TensorRT:http://developer.nvidia.com/tensorrt

- CaffePresso:http://github.com/gplhegde/caffepresso

調(diào)測配置

當(dāng)謹(jǐn)慎地評估現(xiàn)存的解決辦法后,我發(fā)現(xiàn)下列方法能夠加速當(dāng)前流行的可用模型的推理:

- 如果你的構(gòu)架使用了 OpenBLAS,你可以嘗試其為深度學(xué)習(xí)進(jìn)行過優(yōu)化的分支:http://github.com/xianyi/OpenBLAS/tree/optimized_for_deeplearning

- NNPACK 能和其他一些框架(包括 Torch、Caffe 和 MXNet)聯(lián)合使用:http://github.com/Maratyszcza/NNPACK

- 當(dāng)在樹莓派上使用 TensorFlow 時(shí),你可以使用 NEON 指令集提供一些 optimization flags:http://github.com/tensorflow/tensorflow/tree/master/tensorflow/contrib/makefile#raspberry-pi

通過這些,我能列出以下調(diào)測配置:

- 帶有 OpenBLAS 主分支(master branch)的 Caffe 作為后端(caffe-openblas)

- 帶有 OpenBLAS 的深度學(xué)習(xí)優(yōu)化分支(caffe-openblas-dl)的 Caffe

- 使用 OPTFLAGS="-Os" (tf-vanilla) 編譯的 TensorFlow

- 使用 OPTFLAGS="-Os -mfpu=neon-vfpv4 -funsafe-math-optimizations -ftree-vectorize" (tf-neon-vfpv4) 編譯的 TensorFlow

- 帶有用于線性代數(shù)計(jì)算的 OpenBLAS (mxnet-openblas) 的 Vanilla MXNet

- 帶有 OpenBLAS 的深度學(xué)習(xí)優(yōu)化分支 (mxnet-openblas-dl) 的 MXNet

你可能會疑惑:配置中怎么沒有 NNPACK?這確實(shí)有點(diǎn)復(fù)雜,由 ajtulloch 制作的 Caffe 分支提供了使用 NNPACK 的最直接的方法。然而自從它被集成進(jìn)去以后,NNPACK API 就已經(jīng)改變了,并且目前我們不能編譯它)。Caffe2 對 NNPACK 有原生支持,但我不會考慮 Caffe2,因?yàn)樗幱趯?shí)驗(yàn)性階段并且?guī)缀鯇?Caffe 進(jìn)行了重構(gòu),相關(guān)的文檔也不多。另外一個(gè)選項(xiàng)就是使用 Maratyszcza/caffe-nnpack,雖然它比較老舊且沒有什么維護(hù)。

另外一個(gè)問題就是 NNPACK 自身。它并不提供在 Linux/ARM 上的交叉編譯(cross-compilation)配置,只有在 Android/ARM 上的交叉編譯(cross-compilation)配置。我的實(shí)驗(yàn)性構(gòu)建在與 MXNet 結(jié)合的目標(biāo)平臺上無法工作。我只能在臺式電腦上運(yùn)行它,但是我并沒有看到使用 OpenBLAS 會有更優(yōu)秀的表現(xiàn)。由于我的目標(biāo)是評估已經(jīng)可用的解決方法,所以我只能以后再做 NNPACK 的實(shí)驗(yàn)了。

相關(guān)鏈接:

- ajtulloch 制作的 Caffe 分支:http://github.com/ajtulloch/caffe/tree/nnpack-pr

- NNPACK API 編譯問題:https://github.com/Maratyszcza/NNPACK/issues/1#issuecomment-266416638

- Maratyszcza/caffe-nnpack:http://github.com/Maratyszcza/caffe-nnpack

- NNPACK Linux/ARM 問題:https://github.com/Maratyszcza/NNPACK/issues/35

硬件

所有的這些評估都是在四核 1.3 GHz CPU 和 1 GB RAM 的樹莓派 3 上執(zhí)行。操作系統(tǒng)是 32 位的 Raspbian,所以 CPU 不是 ARMv8 架構(gòu),而是 ARMv7 架構(gòu)。

- model name : ARMv7 Processor rev 4 (v7l)

- BogoMIPS : 38.40

- Features : half thumb fastmult vfp edsp neon vfpv3 tls vfpv4 idiva idivt vfpd32 lpae evtstrm crc32

- CPU implementer : 0x41

- CPU architecture: 7

- CPU variant : 0x0

- CPU part : 0xd03

- CPU revision : 4

測試草案

為了評估上述每個(gè)配置的性能,我們會使用相同的神經(jīng)網(wǎng)絡(luò)。也就是一個(gè)有 3 個(gè)卷積層和兩個(gè)全連接層且在頂部有 softmax 的微型卷積神經(jīng)網(wǎng)絡(luò):

- conv1: 16@7x7

- relu1pool1: MAX POOL 2x2conv2: 48@6x6

- relu2pool2: MAX POOL 3x3conv3: 96@5x5

- relu3fc1: 128 unitsfc2: 848 units

- softmax

該卷積神經(jīng)網(wǎng)絡(luò)有 1039744 個(gè)參數(shù)。雖然非常小,但它足夠處理許多計(jì)算機(jī)視覺任務(wù)。

該網(wǎng)絡(luò)使用 Caffe 進(jìn)行訓(xùn)練人臉識別任務(wù),并將其轉(zhuǎn)換為 TensorFlow 和 MXNet 格式從而使用這些框架進(jìn)行評估。為了評估前向通過時(shí)間(forward pass time),從 1 到 256 的批大小都進(jìn)行了測試,因?yàn)榕笮π阅苡泻艽蟮挠绊憽6鴮τ诿總€(gè)批大小,網(wǎng)絡(luò)執(zhí)行了 100 次前向通過,并為每一張圖像計(jì)算了平均時(shí)間。

評估結(jié)果和討論

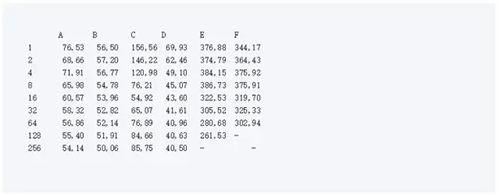

在下面的表格中,列出了平均前向通過的時(shí)間。其中,A 是 caffe-openblas, B 是 caffe-openblas-dl, C 代表 tf-vanilla, D 是 tf-neon-vfpv4, E 是 mxnet-openblas, F 是 mxnet-openblas-dl。

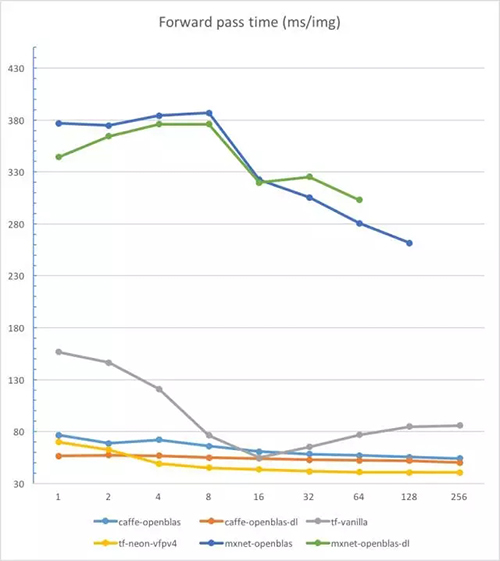

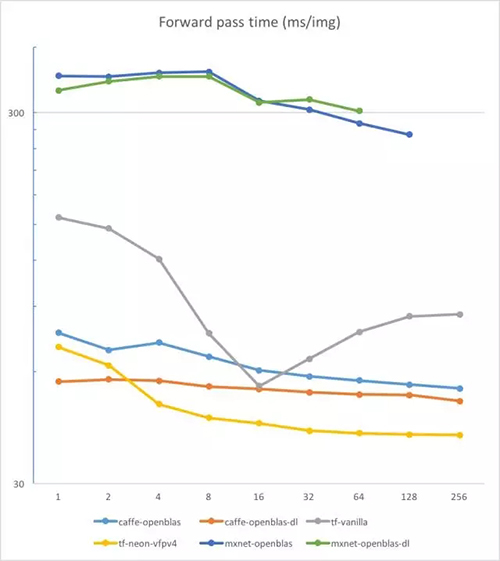

在對數(shù)尺度(logarithmic scale)尺度上我們來看一下:

這些結(jié)果讓我大吃一驚。首先,我沒有預(yù)料到在 CPU 上運(yùn)行 MXNet 有如此差的表現(xiàn)。但這看起來已經(jīng)是一個(gè)眾所周知的問題。此外,因?yàn)榇鎯ο拗疲鼰o法運(yùn)行 256 張圖片的 batch。第二個(gè)驚奇是優(yōu)化過的 TensorFlow 竟有如此好的表現(xiàn)。它甚至比 Caffe 的表現(xiàn)還好(在超過 2 的批大小上);光是從原始框架上看是很難預(yù)料這個(gè)結(jié)果的。但小心:不保證你能在任意 ARM 設(shè)備上使用這些 flags。

眾所周知,Caffe 的速度非常快。如果你要一張接一張地處理圖片,使用優(yōu)化過的 OpenBLAS 的 Caffe 將會是你***的選擇。想要有 10ms 的改進(jìn),你所要做的就只是簡單的輸入:

- cd OpenBLAS

- git checkout optimized_for_deeplearning

為了將我的小研究轉(zhuǎn)變成正式的東西,我仍需要做大量的工作:評估更多的模型,集成 NNPACK,以及研究更多的框架與 BLAS 后端的結(jié)合。但我希望它能幫助你了解目前***的解決方案的推理速度。

原文:https://www.linkedin.com/pulse/how-run-deep-neural-networks-weak-hardware-dmytro-prylipko

【本文是51CTO專欄機(jī)構(gòu)“機(jī)器之心”的原創(chuàng)譯文,微信公眾號“機(jī)器之心( id: almosthuman2014)”】