作者 | Dyaln & Afzal Ahmad

51CTO讀者成長計劃社群招募,咨詢小助手(微信號:CTOjishuzhan)

下面是一份最近泄露的文件,由一位匿名人士在公共 Discord 服務器上共享,該服務器已授予其重新發布的許可。它源于谷歌內部的一名研究員。我們已經驗證了它的真實性。

注意:該文件僅代表谷歌員工的意見,并非整個公司的意見。我們不同意下面寫的內容,我們詢問的其他研究人員也不同意,我們分享這份文件,是因為它提出了一些非常有趣的觀點。

一、我們沒有護城河,OpenAI 也沒有

我們在 OpenAI 做了很多仔細的研究。誰將跨越下一個里程碑?下一步將是什么?

但令人不安的事實是, 我們沒有能力贏得這場軍備競賽,OpenAI 也沒有。在我們爭吵不休的時候,第三派一直在悄悄地吃我們的午餐。

當然,我說的是開源。說白了,他們在蹭舔我們。

我們認為“主要開放問題”的東西,今天已經解決,并且已經掌握在人們手中。僅舉幾個:

手機上的 LLMs:人們在 Pixel 6 上以每秒 5 個 tokens 的速度運行基礎模型。

可擴展的個人 AI:您可以利用晚上時間在筆記本電腦上微調一個個性化 AI。

負責任的發布:這個與其說是“解決”,不如說是“避免”。整個網站充滿了藝術模型,沒有任何限制,文字也不甘落后。

多模態:當前的多模態 ScienceQA SOTA 訓練時間為一小時。雖然我們的模型在質量方面仍然略有優勢,但差距正在以驚人的速度縮小。開源模型更快、更可定制、更私密且功能更強大。他們用 100 美元和 13B 的參數做事,而我們在 1000 萬美元和 540B 的參數下苦苦掙扎。他們在幾周內完成,而不是幾個月。這對我們有深遠的影響:

(1)我們沒有秘方。我們最大的希望是向谷歌以外的其他人學習并與他們合作。我們應該優先考慮啟用 3P 集成。

(2)當免費的、不受限制的替代品在質量上相當時,人們不會為受限制的模型付費。我們應該考慮我們真正的增值在哪里。

巨型模型正在讓我們慢下來。從長遠來看,最好的模型是——這可以被快速地迭代。既然我們知道在<20B 參數范圍內有哪些可能,我們就應該做出小型變體,而不是事后才想到。

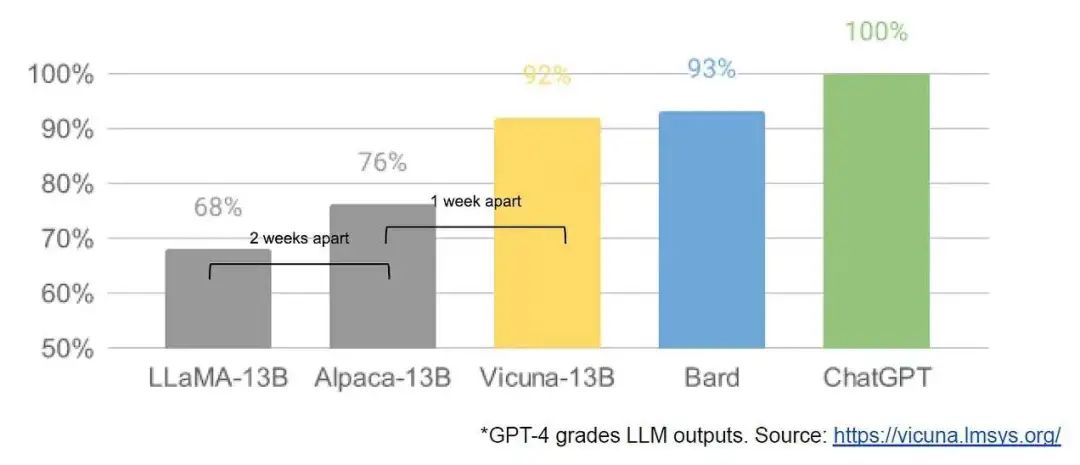

圖源:https://lmsys.org/blog/2023-03-30-vicuna/

二、發生了什么

3 月初,開源社區得到了他們第一個真正有能力的基礎模型,因為 Meta 的 LLaMA 被泄露給了公眾。它沒有指令說明或對話訓練的細節,也沒有 RLHF。盡管如此,社區立即理解了這件事情的重要性。

隨之而來的是巨大的創新涌現,而且間隔僅僅只有幾天(完整細目請參見時間表)。僅僅一個月后,我們就在這里,并且有指令調整、量化、質量改進、人工評估、多模態、RLHFRLHF 等各自的變體,其中許多是相互聯結的。

最重要的是,他們已經解決了任何人都可以修補的擴展問題。許多新想法都來自普通人。訓練和實驗的門檻,已經從一個主要研究機構的總產出下降到一個人、一個晚上和一臺功能強大的筆記本電腦。

三、為什么我們可以預見它的到來

在許多方面,這對任何人來說都不足為奇。緊隨著圖像生圖領域的復興,開源大語言模型也已然復興。相似之處并沒有在社區中消失,正如許多人所稱呼的LLM的“Stable Diffusion 時刻”。

在這兩種情況下,低成本的公眾參與,都是通過一種成本低得多的微調機制實現的,稱為低秩適應(low rank adaptation)或 LoRA,并結合了規模上的重大突破(圖像合成的 Stable Diffusion,LLM 的 Chinchilla )。

在這兩種情況下,獲得足夠高質量的模型都引發了世界各地個人和機構的一系列想法和迭代。在這兩種情況下,這都很快超過了大型企業。

這些貢獻在圖像生成領域至關重要,使 Stable Diffusion 走上了與 Dall-E 不同的道路。擁有一個開放的模型導致產品集成、市場、用戶界面同時發生的創新,這是 Dall-E 沒有做到的。

效果是顯而易見的:與 OpenAI 解決方案相比,在文化影響方面迅速占據主導地位,后者變得越來越無關緊要。LLM 領域內是否會發生同樣的事情還有待觀察,但廣泛的結構要素是相同的。

四、我們錯過了什么

推動開源最近取得成功的創新直接解決了我們仍在努力解決的問題。更多地關注他們的工作可以幫助我們避免重新發明輪子。

1.LoRA 是一種非常強大的技術,我們可能應該更加關注它

LoRA 通過將模型更新表示為低秩分解來工作,這將更新矩陣的大小,減少了多達數千倍。這允許以一小部分成本和時間進行模型微調。能夠在幾個小時內在消費類硬件上個性化語言模型是一件大事,特別是對于涉及近實時整合新的和多樣化的知識的愿望。事實上,這項技術的存在在谷歌內部并未得到充分利用,盡管它直接影響了我們一些最雄心勃勃的項目。

2.從頭開始重新訓練模型是一條艱難的道路

LoRA 如此有效的部分原因在于——與其他形式的微調一樣——它是可堆疊的。可以應用指令調整等改進,然后在其他貢獻者添加對話、推理或工具使用時加以利用。雖然單獨的微調是低秩的,但它們的總和不需要,允許模型的全秩更新隨著時間的推移而累積。

這意味著隨著新的更好的數據集和任務的出現,模型可以以低廉的成本保持最新,而無需支付全面運行的成本。

相比之下,從頭開始訓練巨型模型不僅會丟棄預訓練,還會丟棄在頂部進行的任何迭代改進。在開源世界中,這些改進很快就會占據主導地位,這使得全面重新培訓的成本極其高昂。

我們應該考慮每個新應用程序或想法是否真的需要一個全新的模型。如果我們真的有重大的架構改進來阻止直接重用模型權重,那么我們應該投資于更積極的蒸餾形式,使我們能夠盡可能多地保留上一代的功能。

3.如果我們可以在小型模型上更快地迭代,那么從長遠來看,大型模型的能力并不會更強

對于最流行的模型尺寸,LoRA 更新的生產成本非常低(約 100 美元)。這意味著幾乎任何有想法的人都可以產生一個想法并進行傳播。一天之內的培訓時間是常態。以這樣的速度,所有這些微調的累積效應很快就會克服尺寸劣勢。事實上,就工程師工時而言,這些模型的改進速度大大超過了我們使用最大變體所能做的,而且最好的已經在很大程度上與 ChatGPT 沒有區別。專注于維護地球上一些最大的模型實際上使我們處于劣勢。

4.數據質量比數據大小更好

其中許多項目都通過在小型、高度精選的數據集上進行訓練來節省時間。這表明數據縮放法則具有一定的靈活性。此類數據集的存在遵循了 Data Doesn't Do What You Think 中的思路,并且它們正迅速成為在 Google 之外進行訓練的標準方式。這些數據集是使用合成方法(例如從現有模型中過濾最佳響應)和從其他項目中提取的,這兩種方法在谷歌都不占主導地位。幸運的是,這些高質量的數據集是開源的,因此可以免費使用。

五、直接與開源競爭是一個失敗的主張

最近的進展對我們的業務戰略有直接的影響。如果沒有免費、高質量的替代品,誰會為有使用限制的 Google 產品付費?

我們不應該期望能夠趕上。開源的盛行是有原因的。開源有一些我們無法復制的顯著優勢。

六、我們需要他們,勝過他們需要我們

保守我們的技術秘密,始終是一個脆弱的提議。谷歌研究人員正定期前往其他公司,因此我們可以假設他們知道我們所知道的一切,并且只要該渠道開放,他們就會繼續這樣做。

而且,由于 LLM 的頂尖研究是負擔得起的,因此保持技術競爭優勢變得更加困難。世界各地的研究機構都在相互借鑒,以廣度優先的方式探索解決方案空間,這遠遠超出了我們自身的能力。我們要么在外部創新沖淡其價值時努力保守秘密,要么選擇嘗試相互學習。

七、個人不受與公司相同程度的許可證約束

這種創新的大部分發生在 Meta 泄露的模型權重之上。雖然隨著真正開放的模型變得更好,這將不可避免地發生變化,但關鍵是他們不必等待。“個人使用”提供的法律保護和起訴個人的不切實際意味著個人可以在這些技術炙手可熱的時候使用它們。

八、成為您自己的客戶意味著您了解用例

瀏覽人們在圖像生成空間中創建的模型,從動漫生成器到 HDR 風景,創意源源不斷。這些模型由深深沉浸在其特定子流派中的人們使用和創建,賦予我們無法企及的知識深度和同理心。

九、擁有生態系統:讓開源為我們工作

矛盾的是,所有這一切的一個明顯贏家是 Meta。因為泄露的模型是他們的,所以他們有效地獲得了整個星球的免費勞動力。由于大多數開源創新都發生在他們的架構之上,因此沒有什么能阻止他們將其直接整合到他們的產品中。

擁有生態系統的價值怎么強調都不為過。谷歌本身已在其開源產品(如 Chrome 和 Android)中成功使用了這種范例。通過擁有發生創新的平臺,谷歌鞏固了自己作為思想領袖和方向制定者的地位,獲得了塑造比自身更宏大的想法的能力。

我們對模型的控制越嚴密,我們做出開放替代方案的吸引力就越大。谷歌和 OpenAI 都傾向于防御性地傾向于發布模式,使他們能夠嚴格控制其模型的使用方式。但這種控制是虛構的。任何想將 LLM 用于未經批準的目的的人都可以簡單地選擇免費提供的模型。

谷歌應該讓自己成為開源社區的領導者,通過與更廣泛的對話合作來牽頭來做,而不是忽視其他力量。這可能意味著采取一些不舒服的步驟,比如發布小型 ULM 變體的模型權重。這必然意味著放棄對我們模型的一些控制。但這種妥協是不可避免的。我們不能希望既推動創新又控制創新。

十、結語:OpenAI 怎么樣?

考慮到 OpenAI 當前的封閉政策,所有這些關于開源的討論都會讓人覺得不公平。如果他們不愿意,我們為什么要分享?但事實是,我們已經以源源不斷的挖角高級研究人員的形式與他們分享一切。在我們阻止這種趨勢之前,保密是一個有爭議的問題。

最后,OpenAI 并不重要。他們在相對于開源的態度上犯了與我們相同的錯誤,他們保持優勢的能力必然受到質疑。除非他們改變立場,否則開源替代品可以并且最終會使它們黯然失色。至少在這方面,我們可以邁出第一步。

十一、時間線

- 2 月 24 日 ——LLaMA 啟動:模型小而能力強Meta 推出 LLaMA ,開源代碼,但不開源權重。在這一點上,LLaMA 沒有調整指令或對話。與當前的許多模型一樣,它是一個相對較小的模型(可在 7B、13B、33B 和 65B 參數下使用),并且已經訓練了相對較長的時間,因此相對于其大小來說能力相當強。

- 3 月 3 日——意外泄密帶來的井噴式創新一周之內,LLaMA 就被泄露給了公眾。對社區的影響不容小覷。現有許可證禁止將其用于商業目的,但突然之間任何人都可以進行試驗。從這一刻開始,創新來勢洶洶。

- 3 月 12 日 ——烤面包機上的語言模型一個多星期后,Artem Andreenko 讓模型在 Raspberry Pi 上運行。此時模型運行速度太慢而不實用,因為權重必須分頁進出內存。盡管如此,這為小型化的沖擊奠定了基礎。

- 3 月 13 日 ——在筆記本電腦上微調第二天,斯坦福發布了 Alpaca ,它為 LLaMA 添加了指令調優。然而,比實際重量更重要的是 Eric Wang 的 alpaca-lora 儲庫,它使用低階微調“在單個 RTX 4090 上數小時內”完成了此訓練。突然之間,任何人都可以微調模型來做任何事情,從而在低預算的微調項目中拉開了一場逐底競爭的序幕。論文自豪地描述了他們總共花費了幾百美元。更重要的是,低等級更新可以輕松地與原始權重分開分發,從而使它們獨立于 Meta 的原始許可。任何人都可以分享和應用它們。

- 3 月 18 日 ——無GPU運行Georgi Gerganov 使用 4 位量化,在 MacBook CPU 上運行 LLaMA。它是第一個速度足夠實用的“無 GPU”解決方案。

- 3 月 19 日 ——13B 模型與 Bard 實現“平替”第二天,多所大學聯合發布了 Vicuna ,并使用 GPT-4 驅動的 eval 來提供模型輸出的定性比較。雖然評估方法值得懷疑,但該模型實際上比早期變體更好。訓練費用:300 美元。值得注意的是,他們能夠使用來自 ChatGPT 的數據,同時繞過對其 API 的限制——他們只是對發布在 ShareGPT 等網站上的“令人印象深刻的”ChatGPT 對話示例進行了采樣。

- 3 月 25 日 ——選擇您自己的模型Nomic 創建了 GPT4All ,它既是一個模型,更重要的是一個生態系統。我們第一次看到模型(包括 Vicuna)聚集在一個地方。訓練費用:100 美元。

- 3 月 28 日——開源版 GPT-3Cerebras(不要與我們自己的 Cerebra 混淆)使用 Chinchilla 隱含的最佳計算計劃和 μ 參數化隱含的最佳縮放來訓練 GPT-3 架構。這大大優于現有的 GPT-3 克隆,并且代表了“在野外”首次確認使用 μ 參數化。這些模型是從頭開始訓練的,這意味著社區不再依賴 LLaMA。

- 3 月 28 日 ——一小時多模態訓練LLaMA-Adapter 使用一種新穎的參數高效微調 (PEFT) 技術,在一小時的訓練中引入了指令調優和多模態。令人印象深刻的是,他們僅使用 120 萬個可學習參數就可以做到這一點。該模型在多模態 ScienceQA 上實現了新的 SOTA。

- 4 月 3 日——真人無法區分 13B 開放模型和 ChatGPT伯克利推出了 Koala ,這是一種完全使用免費數據訓練的對話模型。他們采取了關鍵步驟來衡量他們的模型和 ChatGPT 之間的真實人類偏好。雖然 ChatGPT 仍然略有優勢,但超過 50% 的用戶要么更喜歡 Koala,要么沒有偏好。培訓費用:100 美元。

- 4 月 15 日 ——ChatGPT 級別的開源 RLHFOpen Assistant 啟動了一個模型,更重要的是,啟動了一個用于通過 RLHF 對齊的數據集。他們的模型在人類偏好方面與 ChatGPT 接近(48.3% 對 51.7%)。除了 LLaMA,他們還展示了這個數據集可以應用于 Pythia-12B,讓人們可以選擇使用完全開放的堆棧來運行模型。此外,由于數據集是公開可用的,因此對于小型實驗者而言,RLHF 從無法實現變為廉價且容易。

原文鏈接:https://www.semianalysis.com/p/google-we-have-no-moat-and-neither