67個主題,11528 個問題,全新中文大模型多任務基準CMMLU發布

MBZUAI,上海交通大學,微軟亞洲研究院合作完成了一個全面的中文大模型基準——CMMLU。

它涵蓋了 67 個主題,涉及自然科學、社會科學、工程、人文、以及常識等,可以全面地評估大模型在中文知識儲備和語言理解上的能力。他們測試了近 20 個先進的大模型包括最新的 GPT4,ChatGLM2 和 Baichuan-7B 等,發現大多數現有模型的難以達到 50%準確率,而隨機準確率為 25%。

圖片

圖片

- 論文地址:https://arxiv.org/abs/2306.09212

- 數據和評估代碼:https://github.com/haonan-li/CMMLU

本文所提出的 CMMLU,這是一個全新全面的中文評估數據集,旨在專門評估 LLM 在中文語言和文化背景下的高級知識和推理能力。

CMMLU 涵蓋了 67 個主題(如圖 1 所示),從小學到大學或專業水平。包括自然科學,以及人文和社會科學領域的學科,更包含了許多具有中國特色的內容,比如 「中國飲食文化」,「名族學」,「中國駕駛規則」等等。研究團隊已完全公開了數據,社區可以自由方便地利用和評估他們的模型在是否適用于以中國為核心的中文人群。完整的學科列表、每個學科測試的概念數量以及問題和答案長度的統計信息均在論文中提供。

圖片

圖片

為了更深入地了解 LLM 處理中文知識的能力,研究進行了全面的分析實驗。研究首先研究模型在各個學科上的表現。所有模型在不同學科上的表現存在不平衡,人文社科學科得分相對較高,而中國特定主題和自然科學得分較低。為了進一步研究這個問題,研究探索了思路鏈提示詞(Chain-of-Thought)和少樣本示例(Few-shot)對于幫助模型理解任務和提高推理能力的有效性。此外,團隊研究了模型大小對性能的影響,分析了問題長度與難度之間的關系,并探索了現有語言模型尚未有效解決的兩種特定問題類型。

CMMLU 測試基準

數據收集

CMMLU 數據集包含 11,528 個問題,涵蓋了 67 個學科。每個學科至少有 105 個問題,研究將其分 為包含 5 個問題的訓練樣本集(few-shot development set),以及包含超過 100 個問題的測試集(test set)。

數據格式

數據集中的每個問題都是一個包含 4 個選項的單選題,圖 2 是一個附加了提示的示例。對于數學公式、化學式和一些其他數學表達式,他們使用約一半的 Latex 和一半的純文本的混合方式,其中只有在一個表達式被廣泛使用且不易產生歧義時,才允許使用純文本(由注釋者判斷)。例如,水的化學式可以寫為純文本 「H2O」,或者使用 Latex 格式「 $H_{2}O$」。

實驗

為了在中文語境下提供現有開源 LLM 在語言理解方面的概覽,研究評估約 20 個不同規模、語言方向和階段(預訓練或微調)的先進 LLM,并且分析了它們在這個以知識為中心的基準測試上的性能,并研究了可能影響 LLM 性能的幾個因素。

實驗設置

研究的目標是評估 LLM 在預訓練和 / 或微調過程中所利用的知識。對于開源模型,研究遵循 MMLU 的方法獲取提示后的下一個標記的概率,并在 A’、B’、C’和 D’中選擇概率最高的選項作為模型的選擇。對于 ChatGPT 等非開源模型,研究生成輸出并使用一系列正則表達式提取模型的選擇。如果正則表達式沒有匹配到任何內容,他們會隨機選擇 A’、B’、C’、D’中的一個選項作為答案,以進行模型間的公平比較。研究對零樣本(不輸入示例)和少樣本(輸入少量示例)的設置都進行了實驗。

提示詞

研究使用短語 「以下是關于 [主題] 的單項選擇題,請直接給出正確答案的選項」引入每個問題。對于零樣本評估,研究直接在提示后呈現問題。對于少樣本評估,他們在問題之前提供多達 5 個帶有答案的示例。提示以短語「答案是:」結尾,如圖 2 中的示例所示。如果帶有少樣本示例的文本長度超過模型的最大長度,他們會動態刪除最長的(按子標記計算)示例。(最新榜單請看 github)

圖片

圖片

主要結果

表格 1 顯示了在 five-shot 設置下一些模型的性能。可以看出:GPT4 是整體性能最佳的模型,準確度達到 70.95%;在中文特定的 LLM 中,ChatGLM2-6B 模型規模最小卻展現出最佳的整體性能,Baichuan-7B 僅次于 ChatGLM2。

從學科類型的角度來看,相對于 STEM 學科,所有模型在人文學科、社會科學和其他學科中表現出更好的性能,他們認為這是由于 STEM 主題的固有難度所致。此外,雖然所有模型在中國特定類別中的表現相對較弱,略微超過其在 STEM 學科中的表現,但明顯落后于其他類別。

圖片

圖片

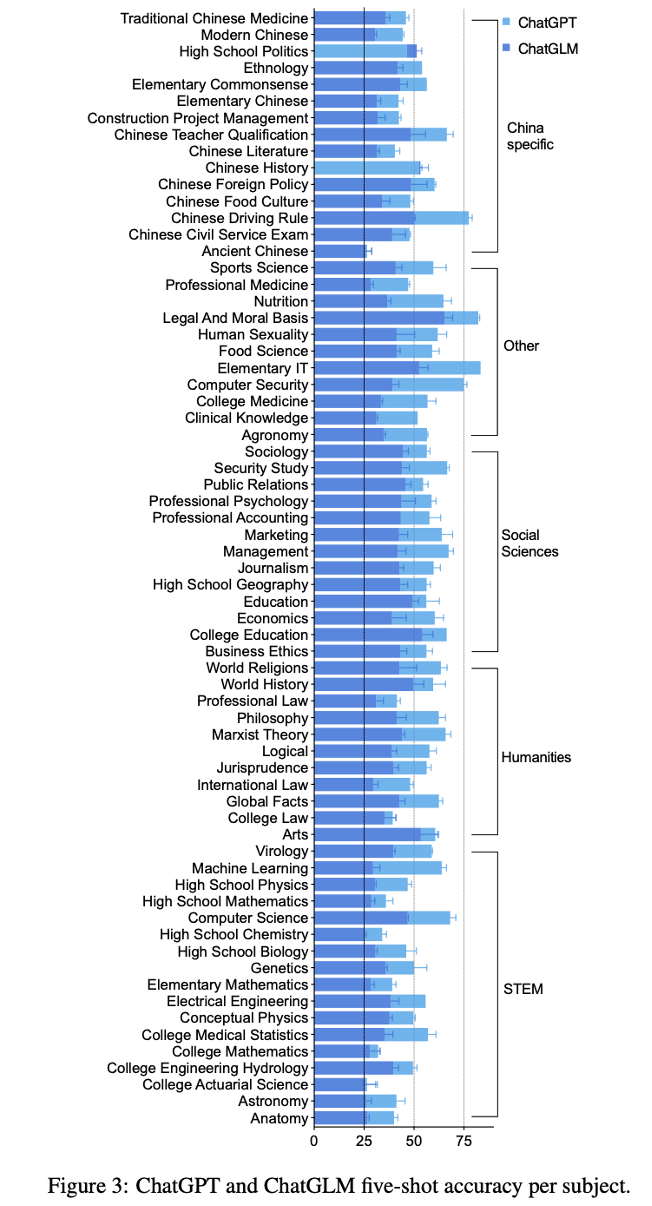

研究將中文模型 ChatGLM 與多語模型 ChatGPT 在每個學科上進行了比較,并對學科進行了分類,并在圖 3 中呈現了結果。具體的數值結果請在論文中查閱。

從圖中可以看出,模型的性能并不平衡,雖然在某些學科(如世界歷史)表現出色,但在其他學科(如數學)中表現較差。研究團隊觀察到,對于 ChatGLM 和 ChatGPT 來說,古漢語和大學精算學是最具挑戰性的學科,其結果接近隨機。而法律與道德基礎則是兩個模型中最容易的學科之一。

在大多數情況下,ChatGPT 的性能明顯優于 ChatGLM。比如說對于機器學習和計算機安全,ChatGPT 的準確度幾乎是 ChatGLM 的兩倍。然而,在中國特定類別中,ChatGLM 的性能明顯接近 ChatGPT。它甚至在中國歷史和高中政治中的表現超過了 ChatGPT。他們認為這是因為與 ChatGPT 相比,ChatGLM 在特別是中國特定類別中遇到了不同的數據來源。這些發現表明,為了適應具有不同語言背景的用戶,找到適合的數據來源對于多語種 LLM 非常重要。

分析

為了全面了解 LLM 在不同條件下的性能,該研究探究了三個可能提升模型性能的因素和三個可能 降低模型性能的因素。對于大多數分析,他們使用了前 3 個多語種模型:ChatGPT、Falcon-40B、LLaMA-65B,以及前 2 個中文模型:ChatGLM-6B 和 BatGPT-15B。

(具體分析細節請參看論文)

(1) 使用逐步思考的提示詞:

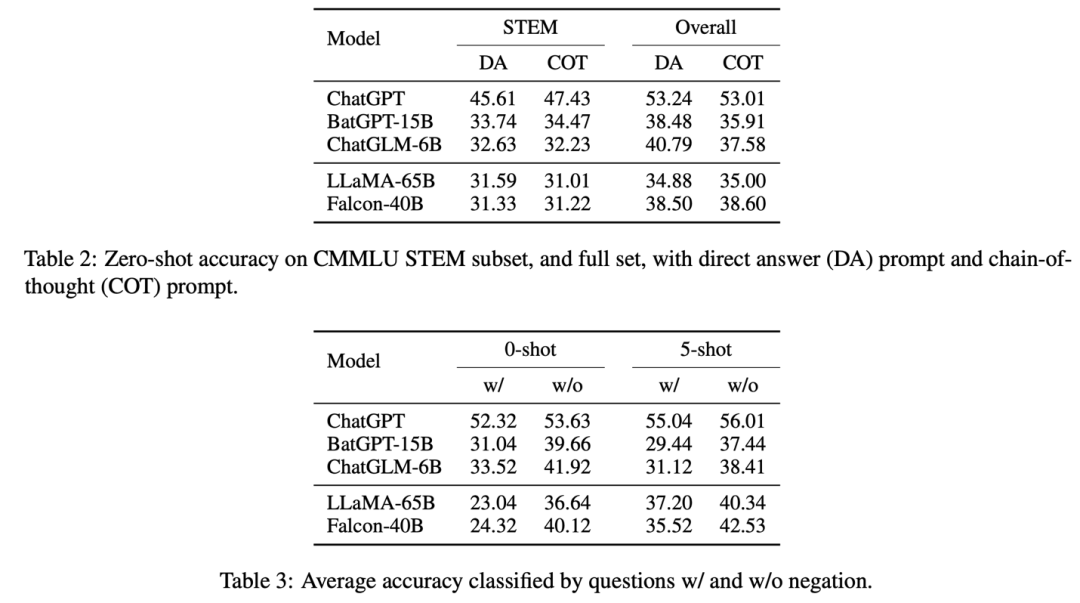

研究將提示從 「請直接給出正確答案的選項」修改為 「逐步分析并選出正確答案」。結果呈現在表格 2 中,所有子類別的細分結果請查閱論文。

圖片

圖片

研究發現,對于沒有進行微調的模型(LLaMA 和 Falcon),使用逐步思考的提示并沒有 明顯提高 STEM 和整體準確度。而對于進行了微調的模型(在表格 2 的第一部分),中文導向的模型(ChatGLM 和 BatGPT)的整體性能下降了約 3%,ChatGPT 的性能也略微下降了 0.2%。這些結果表明,逐步思考的提示確實有助于這些模型回答與 STEM 相關的問題。

(2) 增加輸入示例的數量:

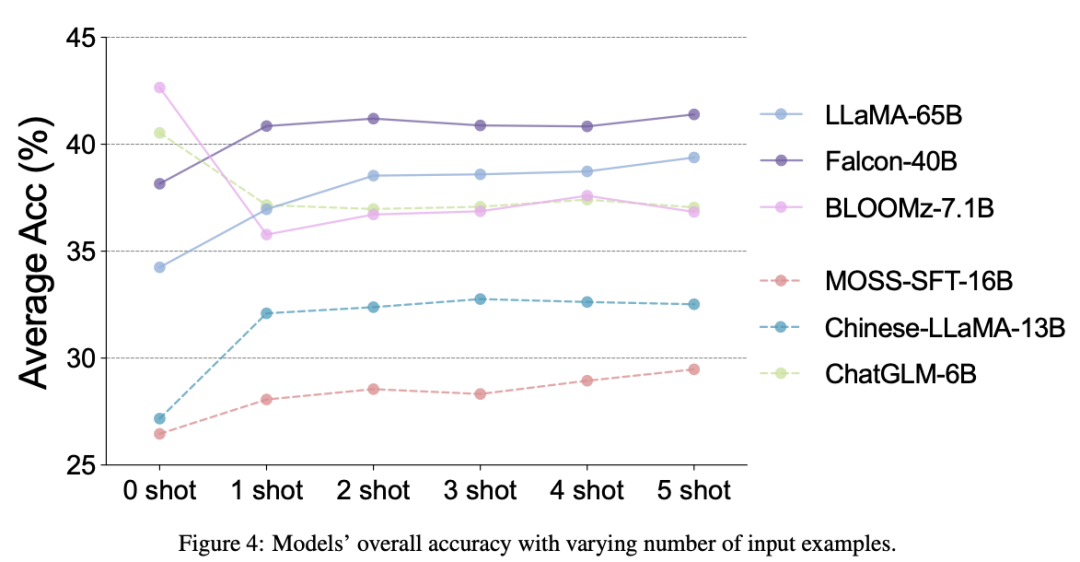

圖 4 展示了使用不同模型在不同數量少樣本示例的平均準確率。明顯可以看出,當提供一些示例時,大多數模型的性能有所提高。盡管隨著示例數量的增加可能會出現波動,但整體趨勢顯示出性能的提升。然而,對于 ChatGLM 和 BLOOMZ 模型,0-shot 設置的性能優于少樣本設置。研究團隊推測這是因為這些模型已經通過預訓練或微調過程廣泛利用了類似的問題和答案對,已經具備了全面理解問題的能力,不需要示例的支持 [3]。

(3) 在同一模型系列中使用更大尺寸的模型:

圖片

圖片

研究使用 LLaMA 系列模型的四個不同規模進行了考察:7B、13B(訓練于 1.0T tokens)、30B、65B(訓練于 1.4T tokens)。這些模型的 0-shot 和 5-shot 設置的整體準確率如圖 5 所示。從結果中,研究團隊觀察到隨著模型規模近似翻倍,準確率穩定增加約 5 個百分點。是否有可能擁有 500B 參數的 LLaMA 模型可以達到與 ChatGPT 相當的性能水平?而最近的研究表明,具有更少參數但使用高質量訓練數據的模型可以達到與一些更大模型(Falcon-40B 對比 LLaMA-65B)相當甚至更好的結果 [1]。如何高效地進一步提升 LLM 的性能仍然是一個未解決的問題。

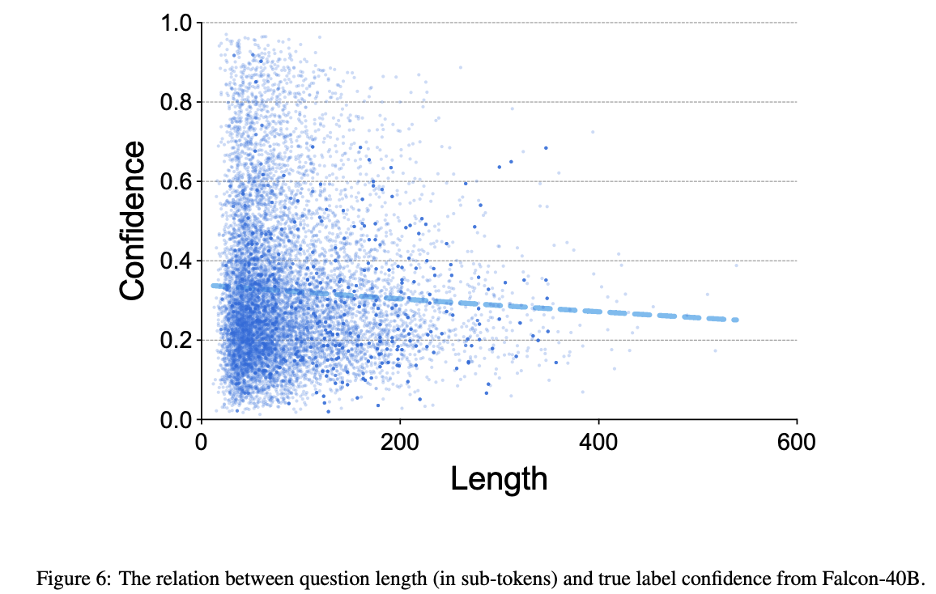

(4) 長度較長的問題:

研究將模型的真實標簽置信度(四個選項中的 softmax)視為問題難度的估計,并在圖 6 中比較了 Falcon-40B 的問題難度與問題長度之間的關系。研究進行了回歸分析,發現問題長度與真實標簽置信度之間的相關性略微正相關。

(5) 含有否定詞的問題:

先前的研究指出語言模型可能在處理否定句時遇到困難 [2]。為了研究該問題在中文語境中是否存在,本文比較了不同模型在包含否定詞和不包含否定詞的問題子集上的性能。結果在表格 3 中展示。

所有模型在包含否定詞的問題上的表現相對較差,強調了大型語言模型的這一常見限制。有趣的是,在沒有進行微調的模型上,少樣本示例緩解了否定問題的性能下降。這使研究團隊推斷,這些模型(LLaMA-65B 和 Falcon-40B) 在預訓練過程中已經獲得了相當多的知識。隨后的指導性微調或通過人類反饋進行強化學習可以幫助它們有效地解決否定問題。

圖片

圖片

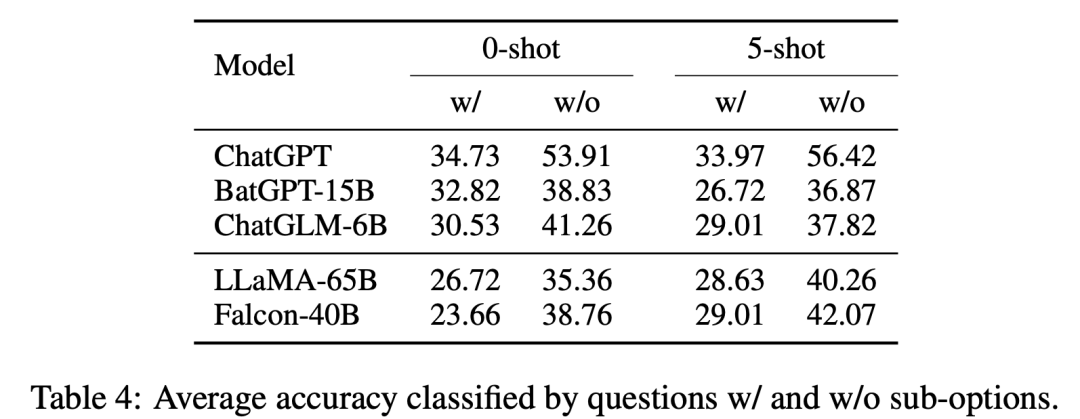

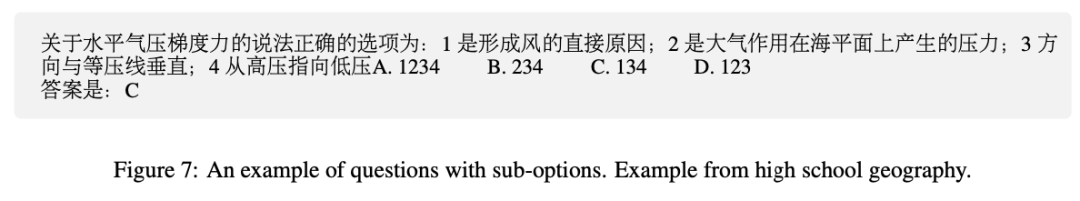

(6) 含有子選項的問題:

在各種中文考試中,有一種典型的問題類型稱為 「子選項問題」。這些問題包括一個主要陳述和多個子選項,并詢問子選項的數量、順序或選擇,需要模型具備更深層的推理和推斷能力(見圖 7 中的示例)。表格 4 顯示了評估結果。

所有這些 LLM 在子選項問題上的表現較弱。ChatGPT 在子選項問題上的性能顯著下降約 20%,而其他模型的下降范圍在 5% 至 15% 之間。對比多語言模型和中文定向模型,子選項問題與其他問題之間的性能差距較大超過 10%,后者性能差距在 10% 以下。這也許是因為訓練數據中的這種情況在中文語言中更為常見。

結論

本文介紹了 CMMLU,這是一個具有開創性意義的基準測試,旨在評估中文多任務語言理解能 力。研究的實驗發現揭示了現有大型語言模型中存在的改進機會。通過廣泛的分析,研究確定了影響模型性能的幾個因素,并提出了改進 LLM 的可行方向。研究團隊相信。他們的基準數據集和分析洞察力將使研究人員能夠有效評估和設計中文 LLM。

更多的研究內容可以查閱原始論文。