何愷明做科研也emo!最新QA完整版在此

AI大牛何愷明的一句話火了,他說:

科研中95%的時間是令人沮喪的。

什么???就連何愷明都覺得科研很煎熬?

沒錯,此話正是他最近在香港中文大學參加一個講座過程中所述:

△小紅書@阿巴阿巴(已授權)

而這只是何愷明這次講座內容中的一小部分,隨著網友們陸陸續續把其它片段po到小紅書上,關于他此次所談及的話題也逐漸清晰了起來——

有關科研,有關大模型,還有關AI for Science。

總而言之,片段視頻可謂是發一個火??一個,網友們也上演了一出大型追劇現場,看得那叫一個津津有味。

現在,量子位給家人們找來了完整版視頻!??

我們在不改變原意的基礎上,就大家最為感興趣的問答環節進行了梳理。

何愷明完整版問題解答

大模型的未來:數據效益是個問題

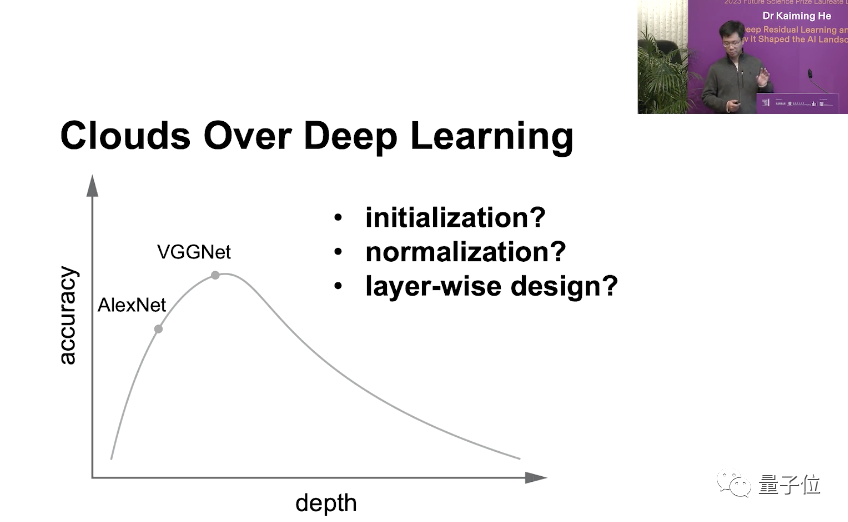

Q:您剛剛(演講)展示的圖片,呈現了深度網絡加深時,性能先上升后下降的趨勢。

起初人們可能誤認為是過擬合導致的,就增加數據量,問題確實得到了改善。但又發現當神經網絡真的非常深入時,性能還是會再次下降。而你的研究揭示了這其實與某種優化并不是最佳解決方案有關,基本上涉及三大要素:數據量、網絡深度、模型復雜度及其優化方式。

考慮到現如今的大模型數據量比以前要大得多,那么您認為可能存在哪些局限性?或者接下來應該如何應對數據模型復雜性和優化帶來的挑戰?

何愷明:通常,我們認為增加網絡的深度和寬度是提高神經網絡模型性能的方法。而在機器學習中,擬合與泛化之間存在權衡,也就是說要實現適當的擬合并減少過擬合。

目前要想減少過擬合、提高泛化,最有效的方法就是增加數據量。

雖然大量數據的擬合和記憶仍是一個挑戰,但大模型其實有足夠的能力做到這一點,事實也證明增加數據量是減少過擬合的最佳解決方案。

然而展望未來,數據帶來的效益是否會降低是個問題。

比如說,語言數據不是憑空產生的,而是由人類創造出來的。你在寫一些新的文本時,是帶有想分享信息、創作新知識等某種目的的。所以文本數據中的信息可能比許多其它形式的數據中的信息都要更豐富。

而一張新的照片可能并不會增加太多新的信息。盡管它看起來可能包含更多的信息,但實際上你每天用手機拍攝的內容也許只是你的食物或是自拍。

所以不同類型的數據所含信息量不同,繼續增加數據的回報可能會有所減少。我認為這將是未來的一個開放性的問題。

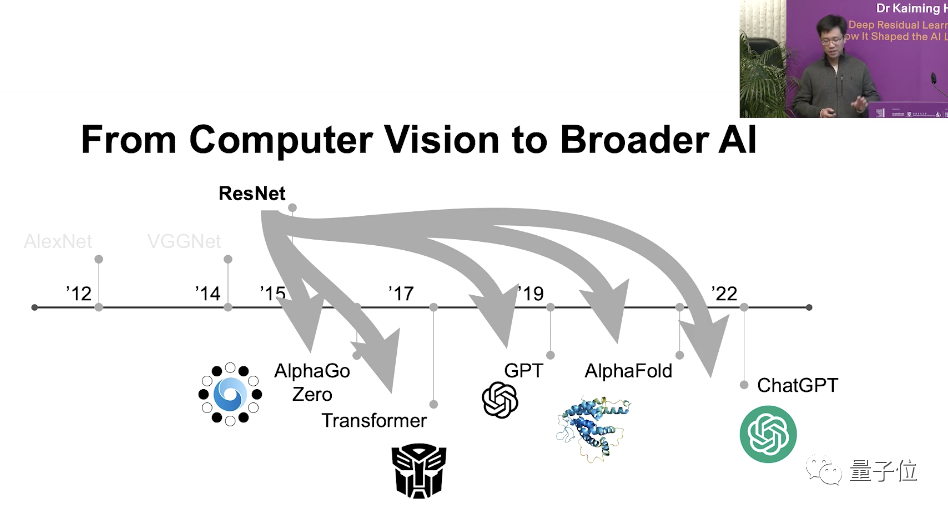

Q:您提到如今深度學習像是殘差學習已廣泛應用于多個領域,例如AlphaGo和AlphaFold等。

回顧一二十年前,研究人員會專注于研究每一個具體的小問題,手動設計各種算法。但現如今,大部分問題都是由更通用的模型來學習解決的。

那么您認為未來的發展趨勢是會出現一個能夠處理大多數任務的大型預訓練模型,而我們只需對其進行微調來適應特定的任務?還是說仍然有一些問題需要手動設計或用更具體的領域知識來解決?

何愷明:我認為這兩個方向將會同步發展。

在自然語言處理中,預訓練模型基本上是默認方法。但在計算機視覺領域,情況稍有不同,因為人們還沒有提出一個好的想法來開發所謂的視覺基礎模型。

這或許是因為視覺任務更為多樣化,而且更重要的是,語言是人類智慧的產物,而像素則來自于自然,這是語言和圖像之間的本質區別。

展望未來,我們希望神經網絡能夠處理更多的問題,比如科學問題、蛋白質、分子、材料,甚至是在數學、化學和物理中推導方程。

我們希望有通用基礎模型來解決大部分問題,但同時也期望有專家模型在特定領域推動技術進步。

Q:您認為AI距離能夠進行抽象數學研究還有多遠?如果我們繼續沿著現在的方向前進,我們最終會到達那個目標嗎?或者您認為兩者之間存在一個根本的鴻溝嗎?

何愷明:坦白說我并不是這個方向的專家,但是可能有兩種方法可以實現。一種是只是訓練一個大模型,然后希望這個模型能夠自行解決問題,但我不認為這是一個有前景的方向。

另一個方向是,如果你為大模型配備了一些代碼等能力,比如ChatGPT代碼解釋器。也就是說允許語言模型編寫代碼,這些代碼可以進行一些計算或是符號操作,然后那種計算可以給模型提供反饋。這樣的話,模型可以決定下一步要做什么。我認為這是一個更有前景的方法。

我們也可以考慮這樣一個情境,如果我們回到牛頓時代,我們有那個時代的所有文本和數據,并且在那個時代訓練了一個大語言模型,有一天這個模型是否可以告訴我們牛頓定律?

如果我們能做到這一點,那么如果我們只給它今天的數據,它會告訴我們一些還不知道的定律嗎?我認為這是非常高水平的人工智能。這是一個終極目標。

Q:您如何看待AI在藝術和人文學科中的未來應用?

何愷明:我不是這方面的專家。看起來藝術和人文真的是人類大腦中非常特殊的領域。我認為問題應該是,人類大腦與AI之間的根本區別是什么。

如果有一天我們可以物理地復制我們的大腦,但我們稱其為機器,那么那個大腦所做的事情可以稱之為藝術或人文嗎?還是我們應該繼續稱其為人工輸出呢?我認為這是一個哲學問題,更像是一個科幻問題。

未來三年研究重點:視覺自監督學習

Q:您未來三年的研究重點是什么?

何愷明:基本上,我會做所有事情。如今自然語言處理取得了很大成功,因為人們可以在語言數據上進行自監督學習,但計算機視覺尚未完全解決這一問題。

所以,我一直努力讓計算機視覺復制這種成功,也就是說我想讓視覺自監督學習也取得成功。

那么,成功的定義是什么呢?我希望看到與語言模型相同的規模效應:只是增加模型的大小、數據量,就能看到視覺模型具有更強大的能力。

不幸的是,這種情況尚未實現。如今,語言模型非常成功,視覺加上語言也非常成功。但對于計算機視覺來說,這還沒有實現。所以,這將是我接下來三年,甚至可能是我整個職業生涯的研究重點。

Q:您提到想要探索圖像領域的自監督。在自然語言處理中,句子詞匯中已經包含了一些語義知識,但在圖像中像素只是像RGB這樣,實際上不包含任何語義知識,它們來自自然。

所以我想知道,是否有只來自于圖像本身的監督?我也想知道如何定義這種自監督?

何愷明:我認為這是語言與視覺之間的根本區別,這也是我們想要解決但迄今尚未能解決的主要問題。我認為表示學習中最困難的部分是如何在語言問題中進行抽象和壓縮,這部分工作人類已經完成了。

圖像這方面,來自傳感器的輸入比語言更加自然,因此模型需要自己來完成壓縮和抽象的工作,這仍然是一個未解決的問題。

另一方面,我也認為僅從像素或圖像、視頻中進行自監督學習是不夠的。比如動物可以看到這個世界,但動物也會從這個世界中獲得其它反饋。所以它們可以采取行動,可以為了生存尋找食物、逃離捕食。所以它們有很多其它形式的信號、監督或從環境中獲得的獎勵,并不僅僅是視覺。

然后,我認為我們現在的視覺系統缺乏來自環境的反饋,這可能是視覺自監督學習的下一個研究主題。

選擇課題的標準:好奇心和熱情

Q:如何找到一個好的研究課題,可以發表為CVPR的那種?

何愷明:我認為發表不應該是最終的目標。發表應該是研究成果的起點,但不是終點。你的論文生命周期從發表的那一刻開始,我希望你能有這樣的預期。

但我還是會回答如何選擇研究課題,并希望你能將其發表。

我認為選擇課題最重要的標準是你對問題的好奇心和熱情。

好奇心是人類推進科學進步、探索未知問題的根本原因。我不關心是否發表,我只關心為什么這個問題會這樣表現,我只關心我如何解決這個問題。如果我發現了答案,那么可能就有了一篇論文;如果我沒能解決,那么也許只是有一篇小幅進展的論文,但那都不重要。

好奇心和熱情才應該是我們研究生涯的重心。

Q:您在研究中是如何保持好奇心和熱情的?對我來說,如果我發現實驗中出現了錯誤,我必須重新進行所有實驗,那真的很崩潰。

何愷明:我認為研究本就充滿了挫折、失敗和沮喪。實際上,它包含了你能想到的所有負面詞匯,這就是事實。如果你沒有經歷過這些,那意味著你并沒有進行最好的研究。

我的生活就是這樣,我有大約95%的時間都很失望,然后我會花5%的時間完成那篇論文,接著進入下一個循環,不斷經歷沮喪、挫敗和焦慮,直到下一項工作完成。享受那5%的時光,如此反復。

“AI將成為幾乎所有事情的基礎工具”

Q:我聽說您打算研究AI for Science,我對此非常感興趣。比如說,各學科領域的人都學習AI,然后用這些模型進行一些研究;計算機科學領域的人也與其他科學領域的人合作發表論文。您對此有什么看法呢?

何愷明:我相信AI會成為幾乎所有領域的基礎工具。回想約四五十年前,那時幾乎沒有計算機科學系,你可能需要在專門的計算機科學機構里學習一些有關計算機科學的知識。

但現在想想,基本上每一個學科都與某種計算、計算機程序、模擬、數據分析有關。因此,計算機科學現在實際上幾乎是每一個學科、每一個領域的工具。

所以,我預測在接下來的十年或是二十年內,AI將是下一代計算機科學,AI將成為幾乎所有事情的基礎工具。也許你不需要擁有一個有關AI的學位,也不需要進入一個專門的AI機構來學習有關AI的知識,但你會在你的科學問題中用AI發現新的模式、新的行為、新的現象。

我非常期待這一切的發生,這是我的目標,也是我對AI for Science的期望。

Q:您剛剛提到了這方面可能會產生的一些具體的應用。但是對于某些領域來說,數據量可能較小,數據質量可能也很低,這種情況您怎么看?

何愷明:數據量的大小都是相對的。比如圖像數據集,按照一二十年前的標準看現在的數據集可能是龐大的,但按今天的標準看它們相對較小。

我認為數據量的大小和相關的算法是相輔相成的,它們以一種螺旋式的方式相互促進。

也就是說,如果你有一定量的數據,你就會為它們開發算法。而當你發現你的算法可以從更多的數據中受益時,你可能會開始收集更多的數據,然后再根據新數據改進你的算法,如此往復。

所以,我認為這既是數據問題,也是算法問題。

Q:我看到ResNet的關鍵在于最大化地保持信號,我對此很感興趣。我正在研究構建光子神經網絡,發現它與模擬計算非常吻合,我們應該最大限度地保持信號強度,我認為這是很有創意的,殘差學習在模擬計算中將具有巨大的潛力。您對此有什么看法?

何愷明:我不確定我是否正確地理解了你的問題。我的評論是這樣的,當今的人工神經網絡最初是受到生物神經網絡的啟發,但隨后這兩個方向開始發散。

人工神經網絡是專門為某些應用或數據集而設計的,有的可能不具有生物學起源,像殘差連接就是這樣的。

但有趣的是,實際上還有許多并行的研究是關于映射人腦或動物腦中的連接模式。相關研究有時被稱為“連接學”之類的術語。

人們在那些人類或動物的神經網絡中發現了與當今最先進的人工神經網絡非常相似的模式。這些模式包括長距離跳過連接、循環連接和其他類型的反饋連接。

所以我認為人工智能與認知科學或腦科學可以相互受益。人腦中的發現可以啟發我們的AI設計。但另一方面,AI網絡中的成功實踐也可以啟發科學家更好地解釋我們的大腦。

用疑問解答AI模型可解釋性問題

Q:我的問題是關于AI模型的可解釋性。我發現一些AI模型表現得非常好,在某些指標上可以超越人類。然而,我們如何解釋AI模型的整體行為呢?我們是否可以對AI模型進行準確的預測,以及我們的AI模型是否真的可以變得非常可靠?我想知道您如何看待這個問題。

何愷明:我想問你一個問題,當你乘坐出租車時,為什么你會信任一個人類司機?這位司機一般對你來說是個陌生人,你并不了解他,你只知道他是個人類。

你會信任他是因為你覺得他的大腦是可以解釋的?還是因為你認為一個經過良好培訓、有豐富實踐經驗的人類司機在實際操作中大概率會做得很好?

我并不需要你的答案,這是我的疑問。人們也問過同樣的問題。為什么我們信任飛機?是因為我們有足夠的物理定律或數學推導可以確保飛機在空中飛行,還是因為飛機已經在空中被測試了數百萬次?

所以我相信,可解釋性是一個非常好的屬性,我真心鼓勵大家去追求它。但另一方面,我們需要認識到,我們系統的成功大部分也是基于實證來推動或驗證的。

One More Thing

何愷明博士畢業12年,再回港中文,校友們激動追星,會廳外面排滿了人。

有人表示提前一個小時去都搶不到位置:

前不久何愷明在美國MIT開展求職演講時,也是同樣的場面。身處現場的聽眾朋友傳消息道,有同學提前3個小時已經蹲在門口排隊了。

演講開始前半個小時,門口的隊伍據說都打了好幾個彎……

果然,AI大牛何愷明走到哪兒火??到哪兒。

視頻鏈接:https://cutv.cpr.cuhk.edu.hk/detail/1572?t=dr-kaiming-he-2023-future-science-prize-laureates-lecture