秒懂AI-深度學習四種常用激活函數(shù):Sigmoid、Tanh、ReLU和Softmax

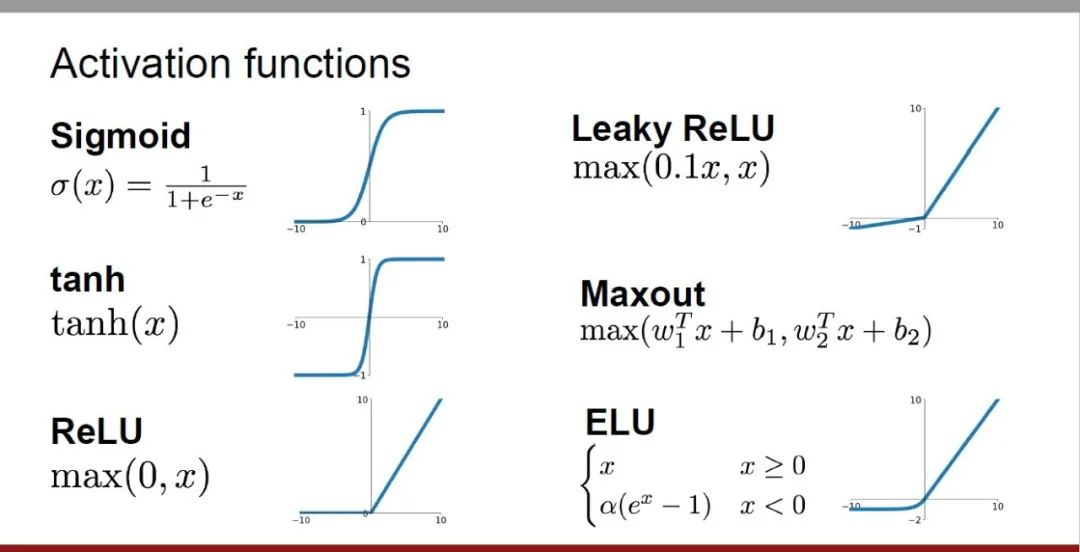

深度學習中的激活函數(shù)是神經(jīng)網(wǎng)絡中至關(guān)重要的組成部分,它們?yōu)樯窠?jīng)網(wǎng)絡引入非線性特性,使其能夠更好地學習和模擬復雜的輸入輸出關(guān)系。激活函數(shù)的選擇和使用對于神經(jīng)網(wǎng)絡的性能和訓練效果具有重要影響。

本文將介紹四種常用的激活函數(shù):Sigmoid、Tanh、ReLU和Softmax,從簡介、使用場景、優(yōu)點、缺點和優(yōu)化方案五個維度進行探討,為您提供關(guān)于激活函數(shù)的全面理解。

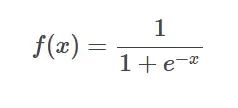

1、Sigmoid函數(shù)

SIgmoid函數(shù)公式

SIgmoid函數(shù)公式

簡介:Sigmoid函數(shù)是一種常用的非線性函數(shù),可以將任何實數(shù)映射到0到1之間。它通常用于將不歸一化的預測值轉(zhuǎn)換為概率分布。

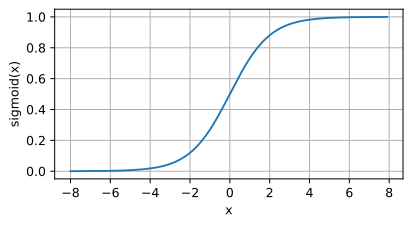

SIgmoid函數(shù)圖像

SIgmoid函數(shù)圖像

使用場景:

- 輸出限制在0到1之間,表示概率分布。

- 處理回歸問題或二元分類問題。

優(yōu)點:

- 可以將任何范圍的輸入映射到0-1之間,適合表示概率。

- 這個范圍是有限的,這使得計算更加簡單和快速。

缺點:在輸入值非常大時,梯度可能會變得非常小,導致梯度消失問題。

優(yōu)化方案:

- 使用ReLU等其他激活函數(shù):結(jié)合使用其他激活函數(shù),如ReLU或其變種(Leaky ReLU和Parametric ReLU)。

- 使用深度學習框架中的優(yōu)化技巧:利用深度學習框架(如TensorFlow或PyTorch)提供的優(yōu)化技巧,如梯度裁剪、學習率調(diào)整等。

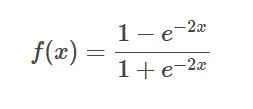

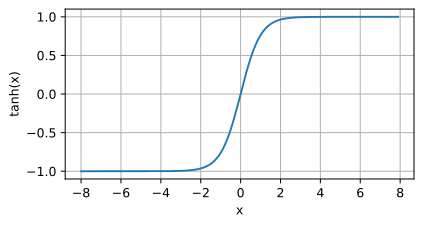

2、Tanh函數(shù)

Tanh函數(shù)公式

Tanh函數(shù)公式

簡介:Tanh函數(shù)是Sigmoid函數(shù)的雙曲版本,它將任何實數(shù)映射到-1到1之間。

Tanh函數(shù)圖像

Tanh函數(shù)圖像

使用場景:當需要一個比Sigmoid更陡峭的函數(shù),或者在某些需要-1到1范圍輸出的特定應用中。

優(yōu)點:提供了更大的動態(tài)范圍和更陡峭的曲線,可以加快收斂速度。

缺點:Tanh函數(shù)的導數(shù)在輸入接近±1時迅速接近于0,導致梯度消失問題。

優(yōu)化方案:

- 使用ReLU等其他激活函數(shù):結(jié)合使用其他激活函數(shù),如ReLU或其變種(Leaky ReLU和Parametric ReLU)。

- 采用殘差連接:殘差連接是一種有效的優(yōu)化策略,如ResNet(殘差網(wǎng)絡)。

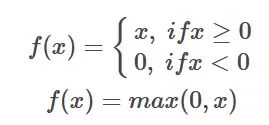

3、ReLU函數(shù)

ReLU函數(shù)公式

ReLU函數(shù)公式

簡介:ReLU激活函數(shù)是一種簡單的非線性函數(shù),其數(shù)學表達式為f(x) = max(0, x)。當輸入值大于0時,ReLU函數(shù)輸出該值;當輸入值小于或等于0時,ReLU函數(shù)輸出0。

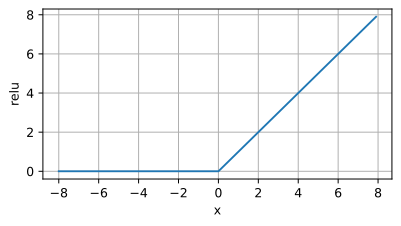

ReLU函數(shù)圖像

ReLU函數(shù)圖像

使用場景:ReLU激活函數(shù)廣泛應用于深度學習模型中,尤其在卷積神經(jīng)網(wǎng)絡(CNN)中。它的主要優(yōu)點是計算簡單、能有效緩解梯度消失問題,并能夠加速模型的訓練。因此,在訓練深度神經(jīng)網(wǎng)絡時,ReLU常常作為首選的激活函數(shù)。

優(yōu)點:

- 緩解梯度消失問題:與Sigmoid和Tanh等激活函數(shù)相比,ReLU在激活值為正時不會使梯度變小,從而避免了梯度消失問題。

- 加速訓練:由于ReLU的簡單性和計算高效性,它可以顯著加速模型的訓練過程。

缺點:

- “死亡神經(jīng)元”問題:當輸入值小于或等于0時,ReLU的輸出為0,導致該神經(jīng)元失效,這種現(xiàn)象稱為“死亡神經(jīng)元”。

- 不對稱性:ReLU的輸出范圍是[0, +∞),而輸入值為負數(shù)時輸出為0,這導致ReLU輸出的分布不對稱,限制了生成的多樣性。

優(yōu)化方案:

- Leaky ReLU:Leaky ReLU在輸入小于或等于0時,輸出一個較小的斜率,避免了完全的“死亡神經(jīng)元”問題。

- Parametric ReLU(PReLU):與Leaky ReLU不同的是,PReLU的斜率不是固定的,而是可以根據(jù)數(shù)據(jù)進行學習優(yōu)化。

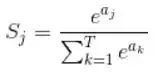

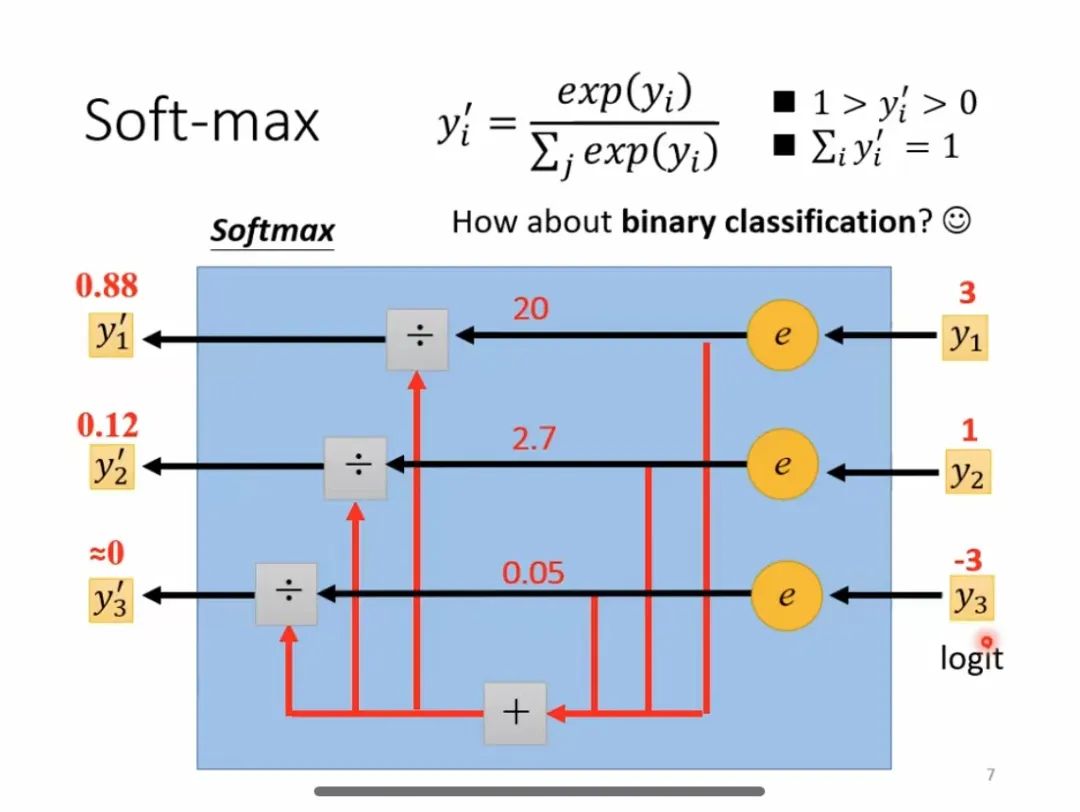

4、Softmax函數(shù)

Softmax函數(shù)公式

Softmax函數(shù)公式

簡介:Softmax是一種常用的激活函數(shù),主要用于多分類問題中,可以將輸入的神經(jīng)元轉(zhuǎn)化為概率分布。它的主要特點是輸出值范圍在0-1之間,且所有輸出值的總和為1。

Softmax計算過程

Softmax計算過程

使用場景:

- 在多分類任務中,用于將神經(jīng)網(wǎng)絡的輸出轉(zhuǎn)換為概率分布。

- 在自然語言處理、圖像分類、語音識別等領(lǐng)域廣泛應用。

優(yōu)點:在多分類問題中,能夠為每個類別提供一個相對的概率值,方便后續(xù)的決策和分類。

缺點:會出現(xiàn)梯度消失或梯度爆炸問題。

優(yōu)化方案:

- 使用ReLU等其他激活函數(shù):結(jié)合使用其他激活函數(shù),如ReLU或其變種(Leaky ReLU和Parametric ReLU)。

- 使用深度學習框架中的優(yōu)化技巧:利用深度學習框架(如TensorFlow或PyTorch)提供的優(yōu)化技巧,如批量歸一化、權(quán)重衰減等。