OpenAI陷巨大算力荒,國內大廠搶先破局!打破單芯片限制,算力效率提升33%

國內AI不行,是因為芯片不行?

我們跟國外的差距,是因為和英偉達芯片的差距過大?

最近,圈內有許多這樣的論調。

其實深挖下去,就會發現事實完全不是這樣。即使是英偉達最先進的芯片,依然無法滿足當下人工智能在算力上的需求。

隨著模型參數量和數據量的增加,智慧不斷涌現,我們對更大集群的需求,也更加迫切。無論是國外,還是在國內,大家離終點都很遙遠。

算力≠芯片

如今,大規模神經網絡的訓練現狀是這樣的。

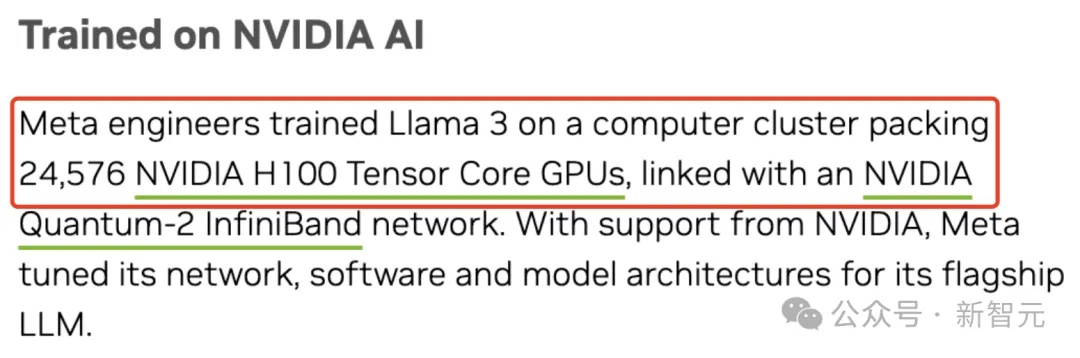

新鮮出爐的8B和70B參數的Llama 3訓練,需要24576塊H100組成的集群。

小扎曾透露截止今年底,Meta將建成由35萬塊H100搭建的基礎設施

小扎曾透露截止今年底,Meta將建成由35萬塊H100搭建的基礎設施

而據稱有1.8萬億參數的GPT-4,是在10000-25000張A100上完成了訓練。

圖片

圖片

爆火的Sora訓練參數量可能僅有30億,爆料稱,估計使用了4200-10500塊H100訓了1個月。

圖片

圖片

特斯拉FSD V12,則是在1000萬個海量視頻片段進行訓練,需要用大概10000塊H100,耗資3億美元。

圖片

圖片

就連奧特曼最近在20VC的采訪中,提及了OpenAI目前增長的「核心瓶頸」:

我們有世界上最優秀的研究人員和研究文化。如果計算資源不足,將會拖慢我們的步伐。

一句話概括就是:給我算力!

然而,由于摩爾定律限制,從14nm到7nm再到5nm的制程進步,所帶來的性能增益越來越有限。

我們需要有這樣一個認知,即AI對算力的需求無窮盡,不能僅依靠AI芯片去滿足算力需求。

那該怎么辦?

瓶頸何解?

其實,英偉達在GTC 24大會上推出的由DGX GB200系統構建的全新DGX SuperPOD,早已給出了答案。

通過在加速計算、網絡和軟件方面同時發力,新集群為萬億參數模型的訓練和推理,提供了穩定的支持。

而且與上一代產品相比,新一代DGX SuperPOD架構的網絡計算能力提升了4倍。

也就是說,剛剛的問題就迎刃而解了——通過更大的集群來突破算力的瓶頸。

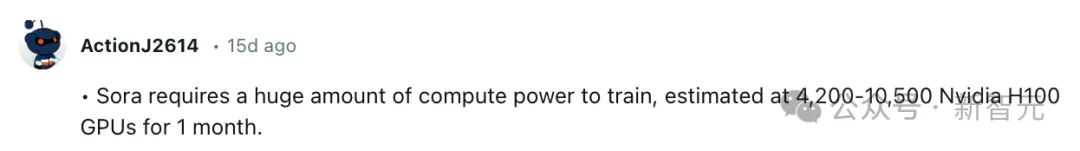

然而,隨著集成的芯片越來越多,我們不得不應對算法效率不高、計算資源不足、互聯帶寬受限等眾多技術挑戰。

圖片

圖片

計算資源不足

一方面,AI系統的性能主要源于GPU等加速器,因此需要其具備強大的異構擴展能力。

但是,傳統的計算機體系結構將加速計算模塊作為CPU的配屬,通過PCI-e總線接入系統,只支持有限數量的異構單元,限制了異構加速器的擴展性。

并且,同CPU的通信帶寬也十分有限。

互聯帶寬受限

另一方面,互聯成為了新的瓶頸。

AI集群早已從千卡、增長到萬卡、十萬卡,節點間并行所產生的海量通信需求,嚴重挑戰了現有的互聯能力。

比如,剛剛提到的GPT-4集群有2.5萬塊A100,而算力利用率(MFU)僅在32%到36%之間。

可見利用率非常之低,不過在當前技術條件下,幾乎觸頂了。

圖片

圖片

文章地址:https://www.semianalysis.com/p/gpt-4-architecture-infrastructure

部分原因是故障數量過多,需要從checkpoint重新啟動訓練。

如果OpenAI在云端使用A100的成本是1美元/h,那么僅這一次的訓練,成本就會高達6300萬美元。

算法效率不高

當然,系統不是全部,AI訓練是一個超級復雜的計算系統。

如果模型算法結構與硬件結構匹配不合理、并行化處理不科學等都會導致整個計算平臺的利用率偏低。

除此以外,機柜之間若想實現高速的互聯,不僅耗電,且散熱不夠的挑戰也需要面對。

總而言之,解決以上難題,我們需要創新:用系統性開創思維去應對AI的挑戰。

萬卡集群

如今很多人都愛說,AI產業的發展「缺芯少魂」,仿佛AI發展不起來,都是芯片制造業的責任。

但實際上呢?

稍微一分析就會知道,如今AI的算力設計已經到了萬卡級別,其中某一張卡的性能,并沒有決定性的作用。

對于動輒千億、萬億參數的大模型來說,單機、單卡的效率不再那么重要了。這時要看的,是算力平臺的整體效率。

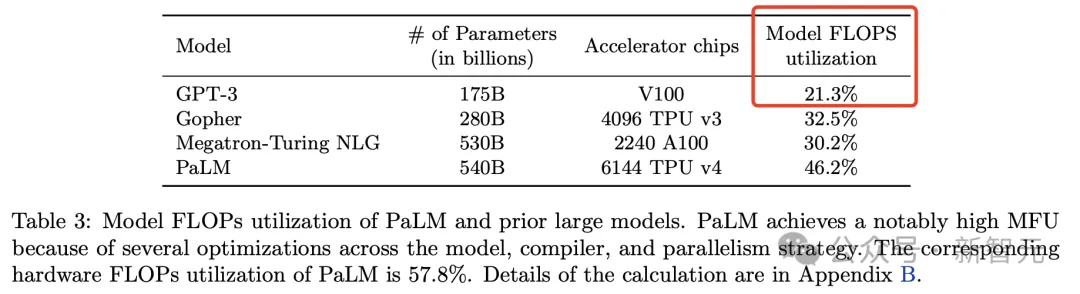

就拿GPT-3來說,它的訓練算法效率MFU只有21.3%,近79%的算力,都被浪費掉了。

論文地址:https://arxiv.org/pdf/2204.02311.pdf

之所以有如此嚴重的浪費,就是因為在大規模計算中,單點效率很有限。因此算力再強都沒有用,接近80%的時間,都是在等。

為什么?一是由于互聯帶寬的限制,二是由于算法沒有考慮帶寬的優化,導致效率奇低。

圖片

圖片

在這種情況下,系統的互聯優化、高效組織協調、算法優化,重要性也愈發凸顯。

硬件

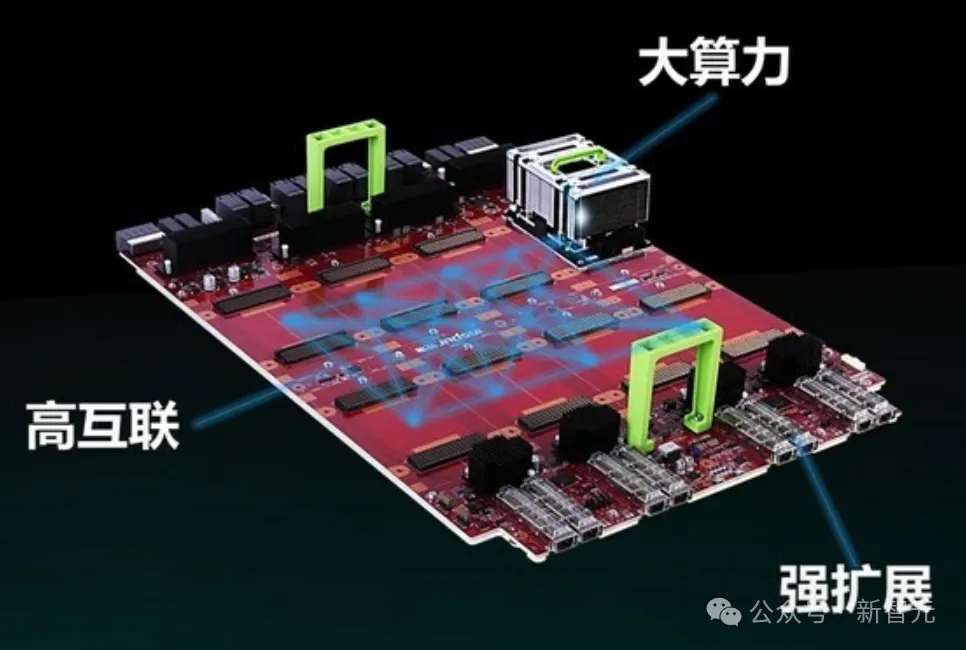

為此,浪潮信息在去年發布了「融合架構3.0」。

這是一個全新的大規模計算架構,通過高速互聯總線,對計算存儲進行了解耦。

圖片

圖片

當GPU算力不足時,需要構建一個GPU池,這樣一臺服務器可以對接不僅僅是8卡,可也以是16卡、32卡。

同時,用相對比較低的算力堆積也存在瓶頸,因為CPU和GPU之間需要有個最佳的配比。

針對不同模型的類型、以及模型之間的交互量,有些GPU發揮的作用大一些,有些小一些。

通過高速的系統總線將多個節點連接,CPU、GPU、內存全部基于池化去做,實現了融合架構和算法模型之間的適配。

這種全新的架構,不以芯片為核心的單機系統,而是以萬卡集群為設計出發點、以系統為核心的架構。

在未來,AI計算領域重要的創新點,就落在了如何發揮系統價值、提升系統效率上。

而這個系統里,接下來要解決的問題,就是如何互聯。

互聯

顯然,從千卡走向萬卡,系統集群之間的高速互聯變得愈加重要。

以往單一任務的AI工廠模式,早已不能滿足需求。

集群不僅僅是面向大模型訓練,還需提供服務,正是AICloud模式所能解決的。

但過去面向超級計算的專用網絡,無法很好地支持多用戶、多任務、多租戶的靈活需求。

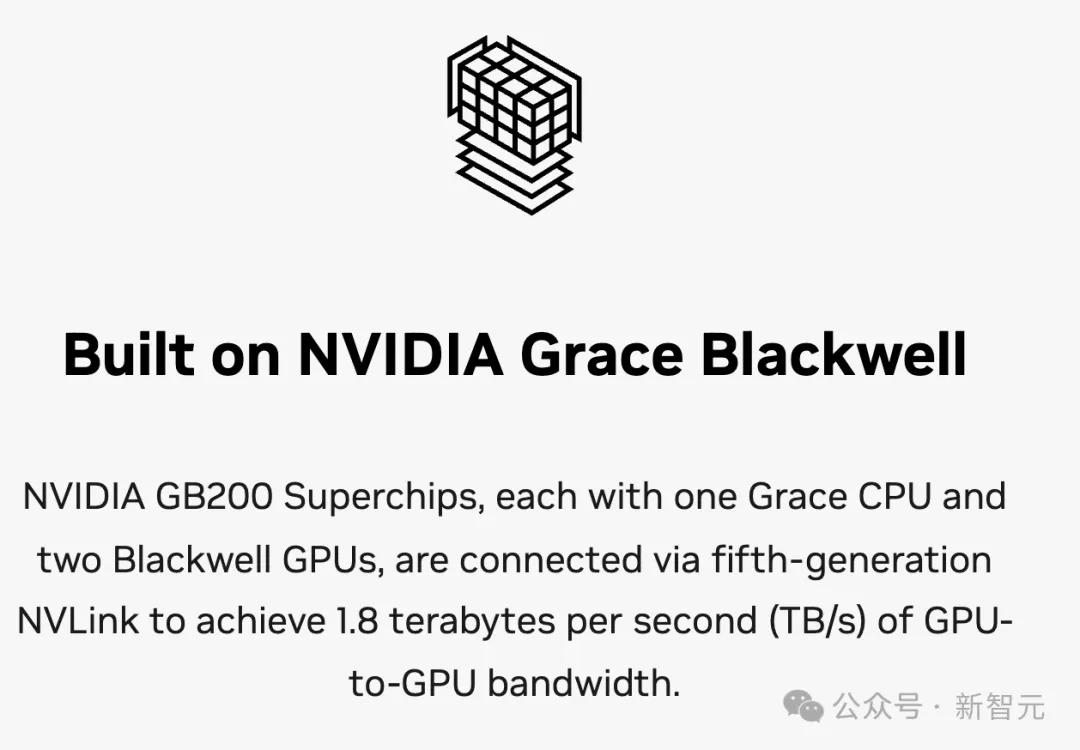

提升GPU與GPU之間的高速互聯,英偉達閉源NVLink網絡成為最典型的代表。

英偉達在DGX SuperPOD,利用了第五代NVLink鏈接,同時采用了Quantum-X800 InfiniBand網絡,可為系統中每個GPU提供高達每秒1800GB/s的帶寬。

可以看到,GPU點對點的通信效率已從2017年32GB/S,過渡到了如今最高的1800GB/S,提升了56倍。

圖片

圖片

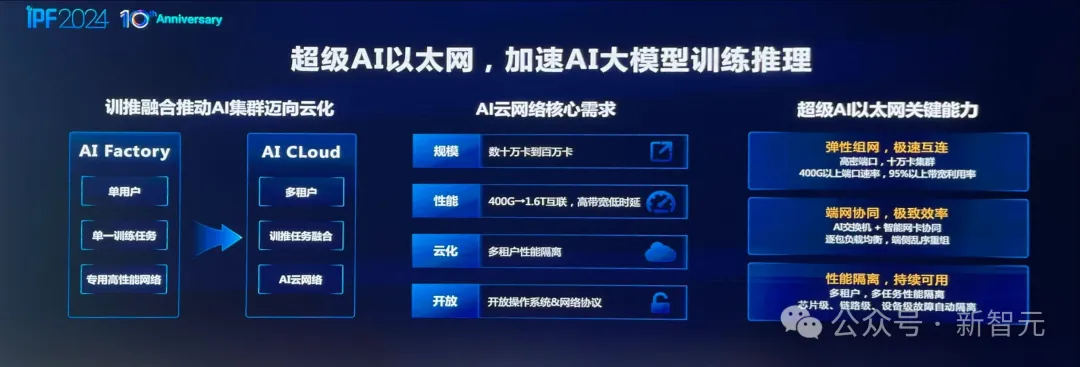

而在未來大模型訓練中,浪潮信息篤定的以「超級AI以太網」來支撐——相比于傳統RoCE可以實現1.6倍的效率提升。

為什么這么說?

圖片

圖片

因為,它能夠實現「端網協同」,為模型訓練帶來極致的計算效率。

端網協同,是指AI交換機和智能網卡之間,能夠實現緊密配合,并結合開放技術為網絡引入創新功能。

多路徑負載均衡功能,便是其中的一個最佳應用。

交換機(網側)可以部署逐包噴灑技術,最大地提升帶寬利用率,但會導致數據包亂序。

這個問題,是很難僅靠交換機本身去解決。

而智能網卡(端側)卻擁有足夠的算力和資源進行亂序重排,將不可能變成可能,大大釋放了網絡潛力。

具體來說,通過報文保序(亂序重組)技術,可將亂序達到的報文,重新編排順序上交到上層AI應用,將帶寬效率從60%提升到95%以上。

正是超級AI以太網的出現,實現了交換機和網卡更加緊耦合的配合。

一邊,交換機可以對網絡數據包進行精細化的路由調度。另一邊,智能網卡提供保序服務,實現了網絡流量的高效均衡。

與此同時,網卡可以針對交換機上標注出的多維遙測信息,進行動態可編程的擁塞控制,實現全程無阻塞、零丟包。

由交換機+智能網卡實現高效的網絡,便是「超級AI以太網」很典型的特點。

可見,若要真正發揮網絡的性能,不僅需要提供大帶寬,更重要的是通過良好的調度,提高「有效帶寬」。

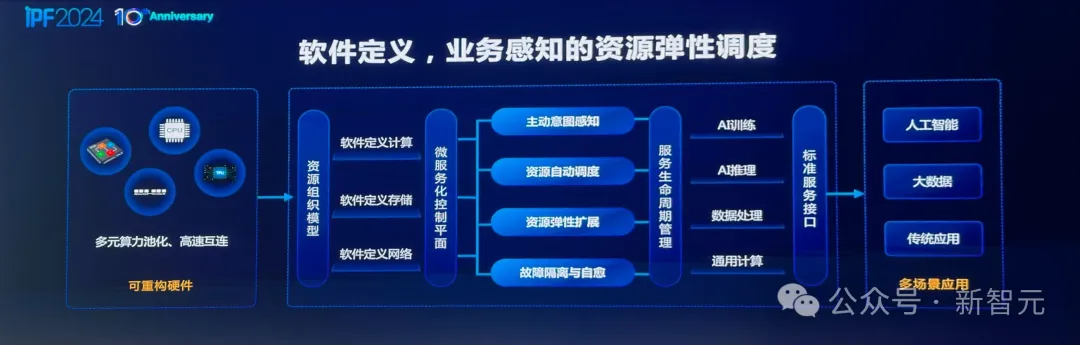

軟件

有了如此復雜的系統,就要開發相應的調度軟件,包括業務感知,資源自動調度和彈性擴展。

此外,在大模型開發過程中,故障隔離自愈變得越來越重要。

對于這一點,同樣可以通過軟件系統實現斷點續算——一旦出現故障,就可以無縫退回到上一個checkpoint。

圖片

圖片

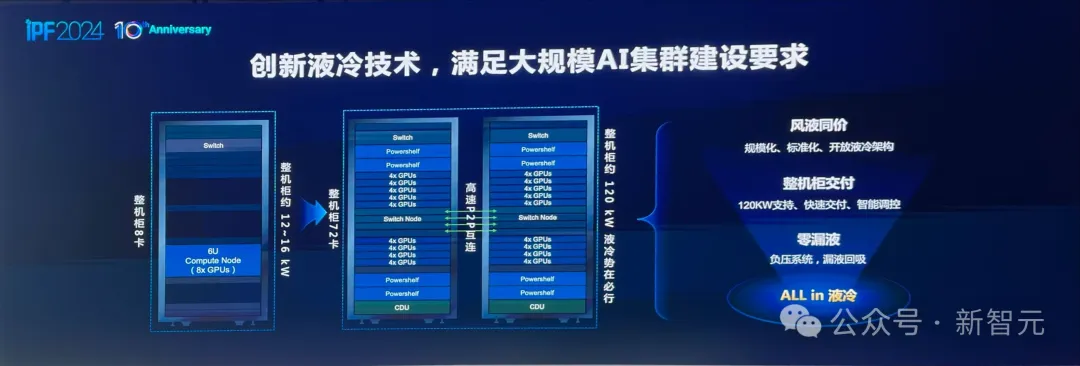

散熱

與此同時,在萬卡集群里面,要提升效率,就要使得每個節點的計算力越來越強。

所以,高密度AI計算是必然趨勢,這樣機柜供電就要從12-16千瓦走到120千瓦,散熱將逐漸走向液冷。

無獨有偶,英偉達也在最新的DGX SuperPOD中,采用的也是液冷散熱。

圖片

圖片

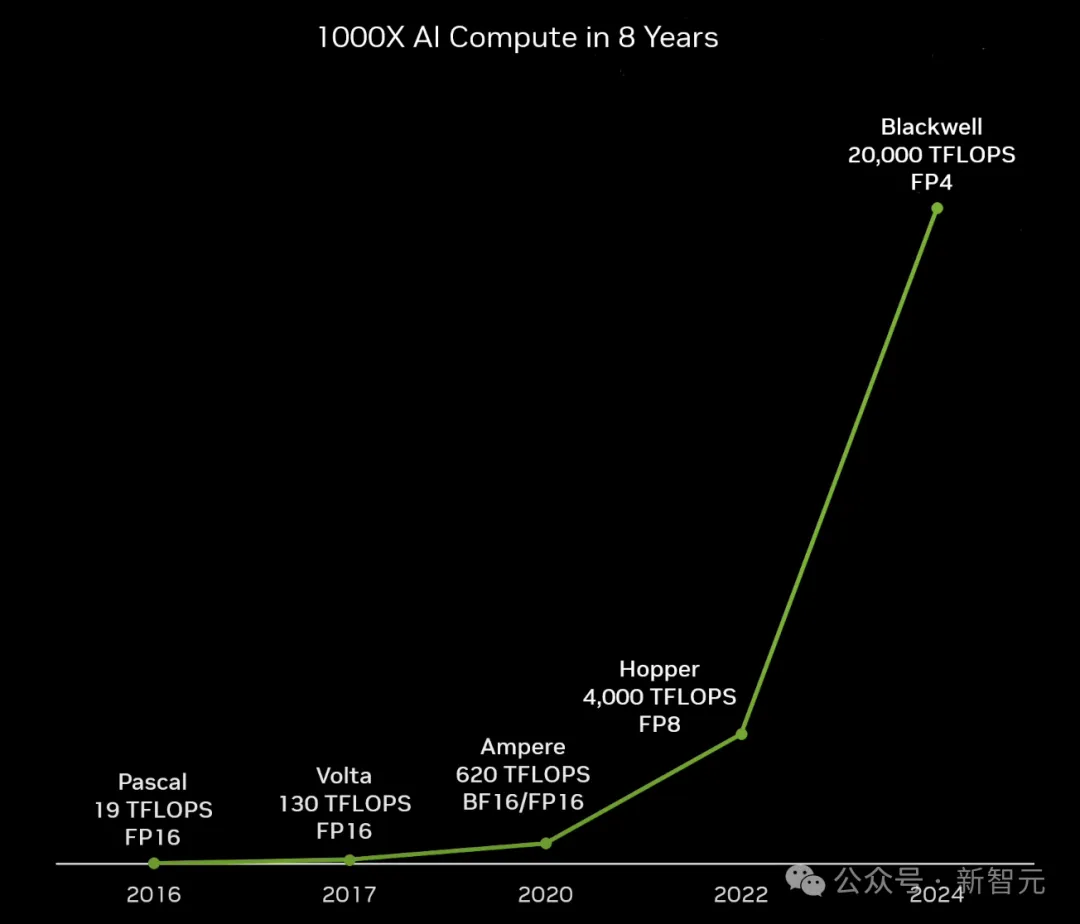

算法

而且,算力是驅動不僅僅是源于芯片,也要靠算法。

從2017年,Transformer誕生之日至今,如果按照摩爾定律(18個月芯片性能翻一番)來算,芯片性能只提升了8倍。

然而實際上,AI計算的性能,已經提升了超過1000倍。

圖片

圖片

這就絕不僅僅是由于芯片制程的優化,而是源于整個系統的提升。

從算法層面來看,過去的大模型精度是FP32,后來變成了FP16,到今年已經進入了FP8,在未來還會走向FP4。

這種變化之下,算法對算力的需求會急劇減小,但對創新會很饑渴。

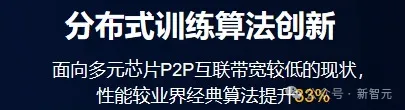

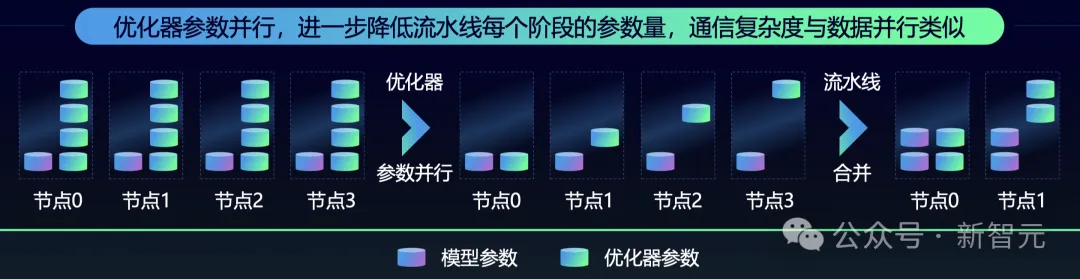

而浪潮信息正是基于包括算法并行、參數并行等技術上的優化,讓算力效率提升了33%之多。

圖片

圖片

具體來說,浪潮信息在源2.0上采用了非均勻流水并行+優化器參數并行(ZeRO)+ 數據并行 + Loss計算分塊的方法,相比于經典的3D并行方法,對帶寬的需求更小,同時還能獲得高性能。

舉個例子,在均勻流水并行的時候,24層模型分到8個計算設備上,每個設備上會平均分到3層。

從下圖中可以看到,這時內存在第一階段就已經達到了GPU的上限。由此,模型的訓練便需要更多設備、更長的流水并行線路,從而導致更低的算力效率。

而采用非均勻流水并行的方法,就可以根據模型每層對于內存的需求,結合內存的容量進行均衡分配,這樣就能在有限的算力資源里把模型訓起來了。

圖片

圖片

不過,流水線并行策略下,整個階段依然是比較長的。

針對這個問題,團隊通過引了優化器參數并行,進一步降低各個節點上內存的開銷。

內存空間省下來了,就可以合并成更大的流水線,減少節點使用數量,節省算力資源。

圖片

圖片

算法創新的理念,在大模型領域也有一個佐證——MoE。

一個千億級模型很難做到萬億級,是因為運算量和計算時間都遠遠超過了承載,效率奇低。

但混合專家系統MoE架構中,則是若干個千億參數模型的混合。

而且,這樣的專家調度系統,反而更符合人類大腦這種復雜的協同智慧涌現系統。

親身嘗試

發展AI應當「以系統為核心」的創新策略,正是浪潮信息多年來,在算力、大模型等領域深耕的結果。

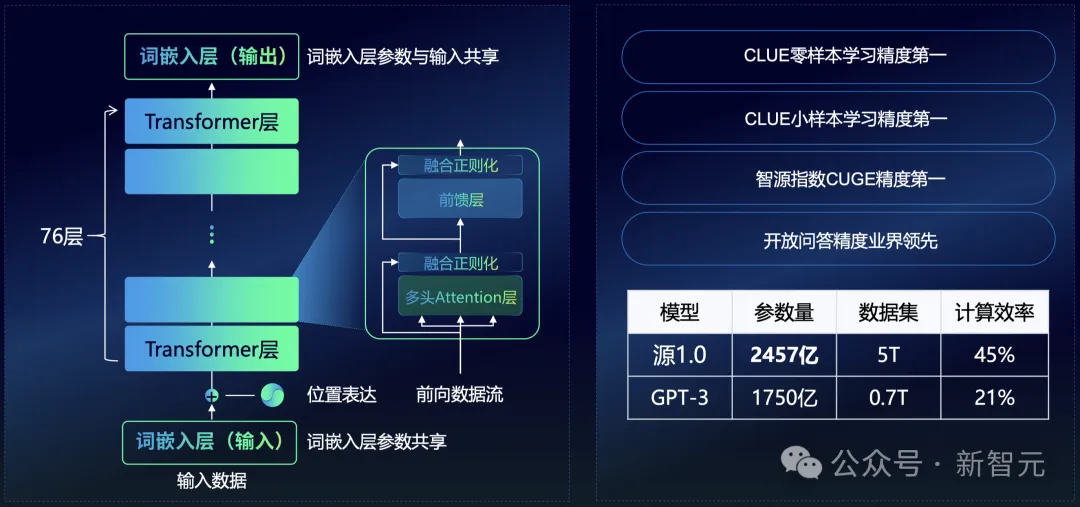

早在2021年,ChatGPT還未出世之前,浪潮信息已然成為大模型的踐行者之一,并發布了「源1.0」。

圖片

圖片

經過兩年多的迭代,千億級參數基礎大模型「源2.0」全面開源。

從某種角度上來講,他們做大模型,并不是希望成為一個靠大模型「吃飯」的公司。

而只是為了探索:LLM對計算的需求多大?萬卡互聯中什么最重要?應用場景是什么?創新的價值點在哪?

因為,只有親身嘗試去做,才能找到答案,獲得深刻的理解。

IPF 2024大會上,浪潮信息董事長彭震給舉了一個栗子:

團隊曾在國產平臺上做大模型訓練時,發現了互聯帶寬速率并不理想。為了克服這個的難題,工程師們在算法層做了大量的優化,采用了算法并行、參數并行,使得整個算力效率提升了33%。

要知道,一個芯片的性能提升30%,至少要制程迭代一次才行。但通過實踐,浪潮信息發現,軟件算法很快就可以解決這個問題。

再比如,在近2500億參數「源1.0」的開發中,團隊們獲得了一個認知大模型的基礎,即參數量的增加,LLM精度也得到了提升。

圖片

圖片

所以說,創新不是站在岸邊去想在水里怎么游泳,而是要投入其中,真干實干。

從解決問題的過程中,找到創新的路徑。

這便是浪潮信息一直以來所踐行的理念,通過技術、框架和規范的全方位創新構建計算系統,開辟AI新時代!

參考資料: