昆侖萬維攜手南洋理工大學搶發Q*算法:百倍提升7B模型推理能力

自 OpenAI 的 Q* 項目曝光后,引發業內眾多討論。據現有信息匯總,Q* 項目被視作 OpenAI 在探索人工通用智能(Artificial General Intelligence, AGI)道路上的一次重大嘗試,有望在包括數學問題解決能力、自主學習和自我改進等多個層面對人工智能技術帶來革新性突破。

英偉達科學家 Jim Fan、圖靈獎得主 Yann LeCun 等參與討論 OpenAI 的 Q* 實現方式

Meta 科學家田淵棟則認為 Q* 是 Q-learning 和 A* 的結合,且天然地適合推理任務,尤其在數學推理方面

不過迄今為止 OpenAI 沒有公開關于 Q* 算法的具體細節,其效果究竟如何我們并不得而知。

昆侖萬維自 Q* 項目曝光以來,一直密切關注 Q* 的動向,且在第一時間就成立研究小組嘗試開發自己的 Q* 算法,希望打破 OpenAI 的封鎖,提升現有開源模型的推理能力。

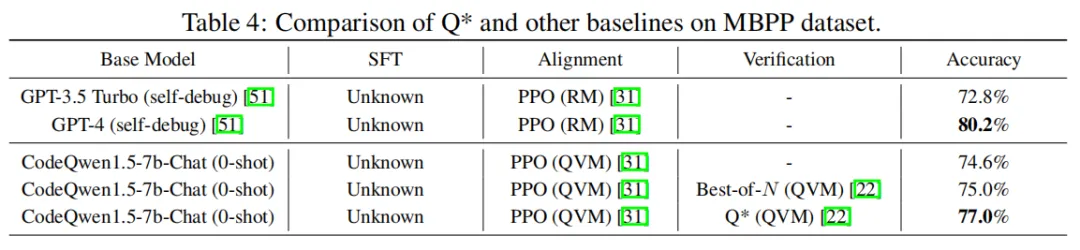

經過數月的嘗試,昆侖萬維攜手新加坡南洋理工大學成功開發了一個名為 Q* 的算法,能夠顯著提升現有大模型的推理能力。在 GSM8K 數據集上,Q* 幫助 Llama-2-7b 提升至 80.8% 的準確率,超越了 ChatGPT;在 MATH 數據集上,Q* 幫助 DeepSeek-Math-7b 提升至 55.4% 的準確率,超越了 Gemini Ultra;在 MBPP 數據集上,Q* 幫助 CodeQwen1.5-7b-Chat 提升至 77.0% 的準確率,縮小了與 GPT-4 的編程水平差距。

論文:Q*: Improving Multi-step Reasoning for LLMs with Deliberative Planning

論文鏈接:https://arxiv.org/abs/2406.14283

Q* 能夠幫助小模型達到參數量比其大數十倍、甚至上百倍模型的推理能力,這一算法不僅大幅提升了小模型的性能,還顯著降低了計算資源的需求,為人工智能的廣泛應用帶來了全新可能,開創了高效智能的新紀元。

復雜推理任務全盤規劃

在《Q*: Improving Multi-step Reasoning for LLMs with Deliberative Planning》論文中,研究人員首先將大語言模型的推理軌跡分解為若干個狀態,對于每一個狀態,參考 DeepCubeA 中的設計,通過將定義 Path Cost 的 g (s_t) 函數和定義 Accumulated Reward 的 Q*(s_t, a_t) 集成到同一個 f (s_t) 函數內,實現了對歷史狀態收益和未來期望收益的綜合考慮。最后利用 A* 搜索算法對狀態進行最佳優先搜索,實現了對復雜推理任務的全盤規劃,從而提升開源模型在推理任務上的性能。

其中 g (s_t) 表示當前軌跡中的多個歷史狀態,既 {s1,...,s_t},的聚合收益。

具體 g (s_t) 的函數形式可以通過人為定義,例如判斷當前代碼是否符合語法規則等,或者通過構建 Process Reward Model (PRM) 進行監督學習得到;g (s_t) 中的聚合方式可以為求和,最大值,最小值等。

為了獲得狀態 - 動作對 (s_t, a_t) 的最優 Q 值以實現規劃,研究人員在當前 LLM 策略生成的數據上通過監督學習的方式訓練了一個代理 Q 值模型圖片。訓練過程中的真實標簽圖片可以由三種不同的方式得到,包括離線強化學習,蒙塔卡羅采樣估計和利用更強大的語言模型補全。

實驗結果表明,昆侖萬維本次所提出的 Q* 框架,可以顯著地提升 LLM 的推理能力,在 GSM8K 數據集上,Q* 幫助 Llama-2-7b 提升至 80.8% 的準確率,超越了 ChatGPT;在 MATH 數據集上,Q* 幫助 DeepSeek-Math-7b 提升至 55.4% 的準確率,超越了 Gemini Ultra; 在 MBPP 數據集上,Q* 幫助 CodeQwen1.5-7b-Chat 提升至 77.0% 的準確率,縮小了與 GPT-4 的編程水平差距。

研究證明,Q* 能夠幫助參數量僅為 7b 的小模型達到參數量比其大數十倍甚至百倍模型的推理能力,大幅提升模型的性能,并顯著降低了計算資源的需求。目前,Q* 的研究尚在初級階段,算法在各個環節還有進一步的改進空間。未來,昆侖萬維會繼續深入此項研究,不斷提升國產開源模型推理能力,打破 OpenAI 閉源封鎖,為人工智能前沿技術發展帶來全新可能。