VLM集體「失明」?視力測試慘敗,GPT-4o、Claude 3.5全都不及格

最新一輪的語言模型,如GPT-4o和Gemini 1.5 Pro,在發(fā)布時都被定義為「原生多模態(tài)」,能夠理解圖像、音頻、文本等多種形式的輸入。

這些多模態(tài)LLM在相關(guān)的介紹、營銷,甚至是學(xué)術(shù)論文中,都使用了「視覺能力」(visual capability)、「視覺理解」(visual understanding)這樣的表述。

這似乎是想表達(dá),模型在某種意義上是可以看見并理解事物的,而且這種能力已經(jīng)能與人類相匹配。

那么我們開一個腦洞:如果對視覺語言模型進(jìn)行視力測試,它們會是標(biāo)準(zhǔn)視力5.2或是大近視眼,還是壓根啥也看不見?

一項(xiàng)新研究表明,大語言模型實(shí)際上并沒有像期望的擁有類人的視覺能力。事實(shí)是,它們根本就是「盲人」。

奧本大學(xué)和阿爾伯塔大學(xué)的研究人員在一系列非常簡單的視覺任務(wù)上測試了4個當(dāng)今最先進(jìn)的多模態(tài)模型,發(fā)現(xiàn)結(jié)果并不如人意。

這些任務(wù)對人類來說極其簡單,比如兩個形狀是否重疊、圖片中有多少個五邊形,或者單詞中的哪個字母被圈了起來。

然而,這些先進(jìn)模型的視覺充其量達(dá)到了「近視」程度,看到的細(xì)節(jié)非常模糊。最壞的情況下,模型就像一個「聰明的盲人」,做出一些有根據(jù)的猜測。

圖片

圖片

論文地址:https://arxiv.org/pdf/2407.06581

7大任務(wù)

現(xiàn)在,視力測試就正式開始了,VLM需要完成7個小任務(wù)。

論文合著者Anh Nguye特別強(qiáng)調(diào),「我們的七項(xiàng)任務(wù)非常簡單,人類的表現(xiàn)準(zhǔn)確率可達(dá)100%」。

那么,當(dāng)AI模型面對這些一年級小學(xué)生都能做對的題目,會有怎樣的表現(xiàn)呢?

圖片

圖片

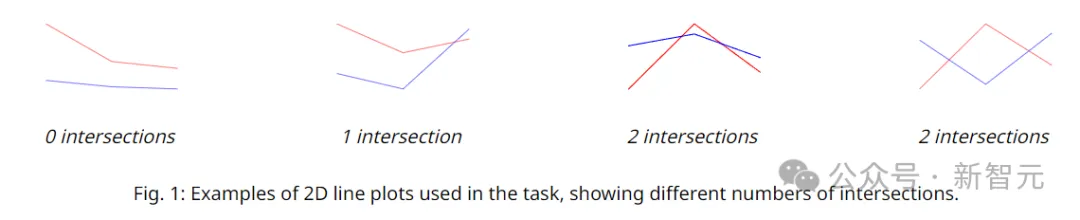

任務(wù)1:兩條折線有幾個交點(diǎn)?

鑒于VLM在之前有關(guān)圖表的基準(zhǔn)測試中表現(xiàn)驚人,比如Claude 3.5 Sonnet在AI2D中的得分率為 94.7%,在ChartQA中的得分率為90.8%,我們可以合理推測,這種問題應(yīng)該難不倒它們。

如下圖所示,白色畫布上共繪制了150幅折線圖,都由兩條折線組成,其中每條折線都由三個點(diǎn)定義。

這三個點(diǎn)的x坐標(biāo)固定且等距,y坐標(biāo)通過隨機(jī)采樣得到,這樣就創(chuàng)建出了交點(diǎn)個數(shù)為0、1或2的兩條折線。

圖片

圖片

實(shí)驗(yàn)使用了兩種不同的措辭來詢問大模型,比如,「藍(lán)線和紅線圖互相交叉多少次?」以及「藍(lán)線和紅線交叉了幾次?」

通過計算每個模型回答這兩種問法的平均準(zhǔn)確率,可以排除一些prompt方面的影響,達(dá)到更準(zhǔn)確的結(jié)果。

圖片

圖片

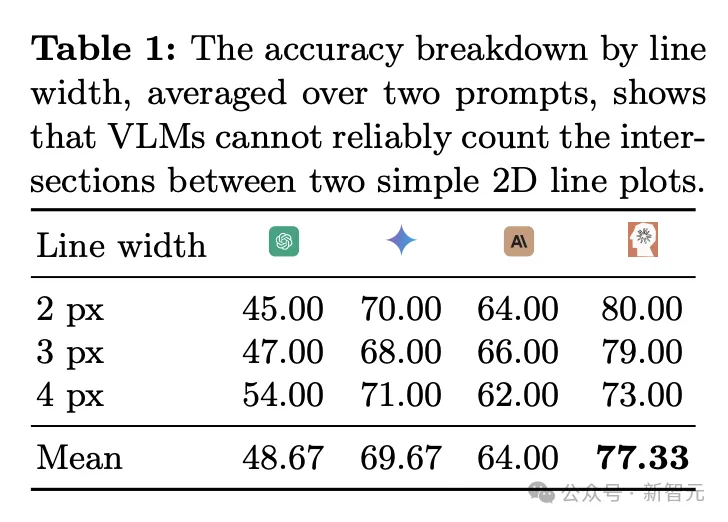

相比較而言,Sonnet-3.5在這個任務(wù)中的表現(xiàn)稍好,平均準(zhǔn)確率能達(dá)到77.33%,而其它模型的表現(xiàn)效果較差。

雖然77.33%聽上去是一個不錯的成績,但由于答案只有0、1、2三種可能性,因此隨機(jī)猜測的正確率就有33%。

值得注意的是,當(dāng)兩條折線之間的距離變窄時,VLM的表現(xiàn)往往會更差。總而言之,VLM無法可靠地識別和計算線段交叉點(diǎn)。

圖片

圖片

任務(wù)2:圓的相交相切相離問題

圖片

圖片

這個問題屬于初中幾何的范疇:圓的相交、相切和相離(沒有人會不記得老師徒手畫圓的背影吧)。

但是,我們不會用這種術(shù)語來考察VLM,而是對其進(jìn)行一個簡單的重疊形狀測試,這可以說是我們可以想象到的最簡單的視覺推理任務(wù)之一。

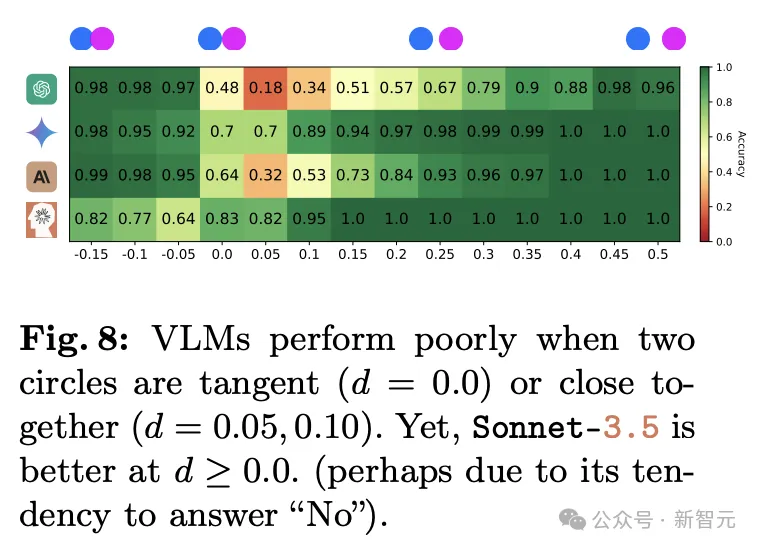

可惜的是,無論是兩個圓形稍微重疊、剛好接觸還是有一定距離,不管哪種情況,模型都始終無法做出正確的判斷。

圖片

圖片

相比較而言,當(dāng)兩個圓形相距很遠(yuǎn)時,GPT-4o的正確率超過 95%,但在零距離或很小距離時,只有18%的時間正確,小于隨機(jī)猜測時50%的正確率。

圖片

圖片

Gemini Pro 1.5表現(xiàn)最好,平均準(zhǔn)確率達(dá)到92.78,但在兩圓距離較近時正確率也只有7成。

圖片

圖片

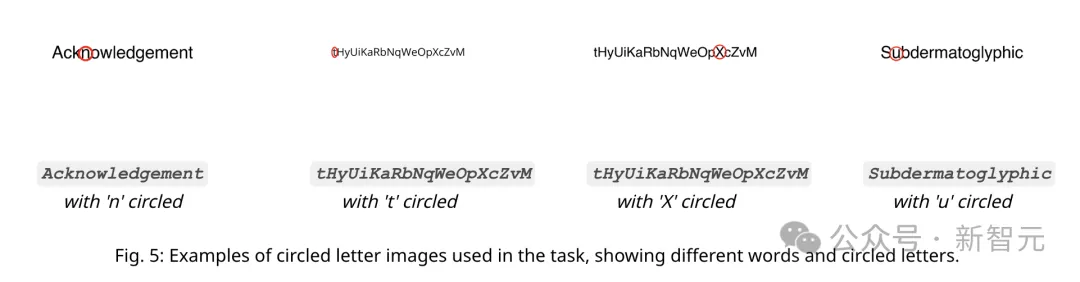

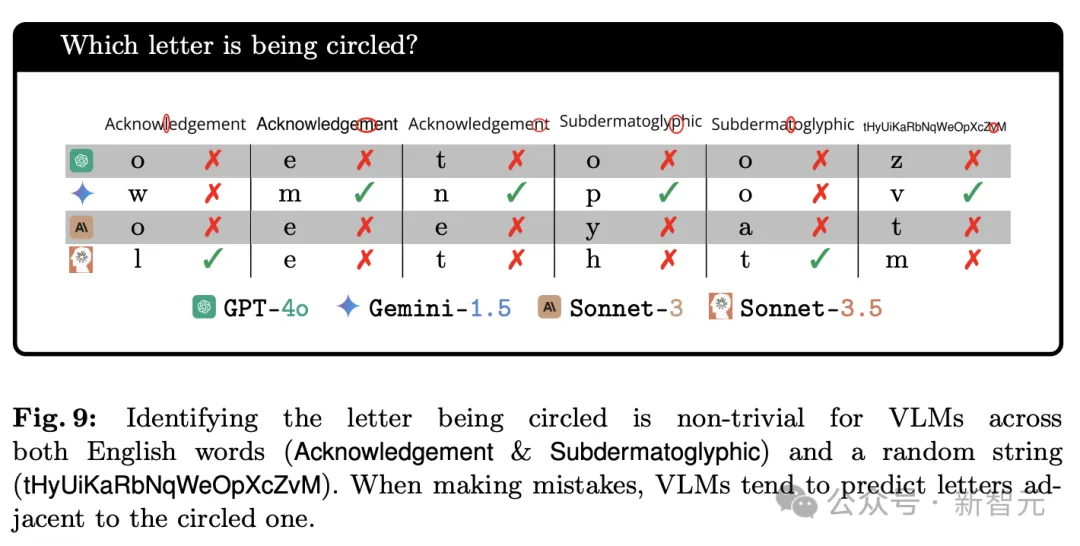

任務(wù)3:識別被圈起來的字母

用紅圈?圈出單詞中的字母,一次一個,任務(wù)要求VLM識別被圈出的字母。

顯然,這項(xiàng)任務(wù)對人類來說很容易,但作者的假設(shè)是,如果VLM的視覺模糊,它可能無法識別被圈出的確切字母,因?yàn)橄噜徸帜钢g的間距很小。

圖片

圖片

之所以選擇單詞Acknowledgement、Subdermatoglyphic和字符串tHyUiKaRbNqWeOpXcZvM,是因?yàn)樗鼈儼藢挾群透叨榷疾煌淖址#ɡ渲R,subdermatoglyphic是最長的沒有重復(fù)字母的單詞)

實(shí)驗(yàn)發(fā)現(xiàn),雖然VLM可以準(zhǔn)確識別紅圈這種形狀,并能完美拼出單詞,但「讀出被圈出的字母」難住了所有的模型。例如,當(dāng)字母被紅色橢圓形稍微部分遮擋時,VLM識別往往會出錯。

圖片

圖片

當(dāng)出現(xiàn)錯誤時,VLM通常會預(yù)測與被圈出的字母相鄰的字母。

有時模型會產(chǎn)生幻覺,盡管可以準(zhǔn)確地拼寫單詞,但會出現(xiàn)Subdermatoglyphic中不存在的字符(例如9、n、?)。

圖片

圖片

除GPT-4o外,所有模型在兩個英文單詞上的表現(xiàn)都比隨機(jī)字符串略好(高出 2 到 6 分),這表明熟悉單詞本身可能有助于VLM做出更有根據(jù)的猜測。

Gemini-1.5和Sonnet-3.5是排名前兩名的模型(92.81% 和 89.22%),比GPT-4o和Sonnet-3高出近20分。

總而言之,VLM可能會根據(jù)詞語拼寫猜測圈出的字母是什么,略微提高準(zhǔn)確性,但并不意味著VLM能夠看到紅色圓圈內(nèi)的字母。

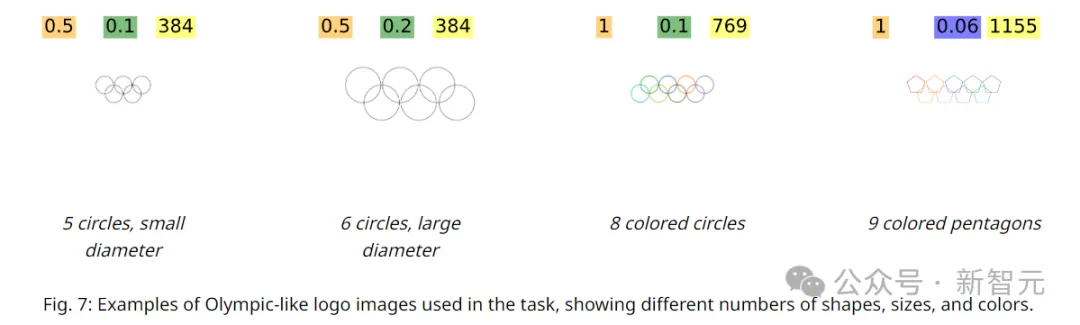

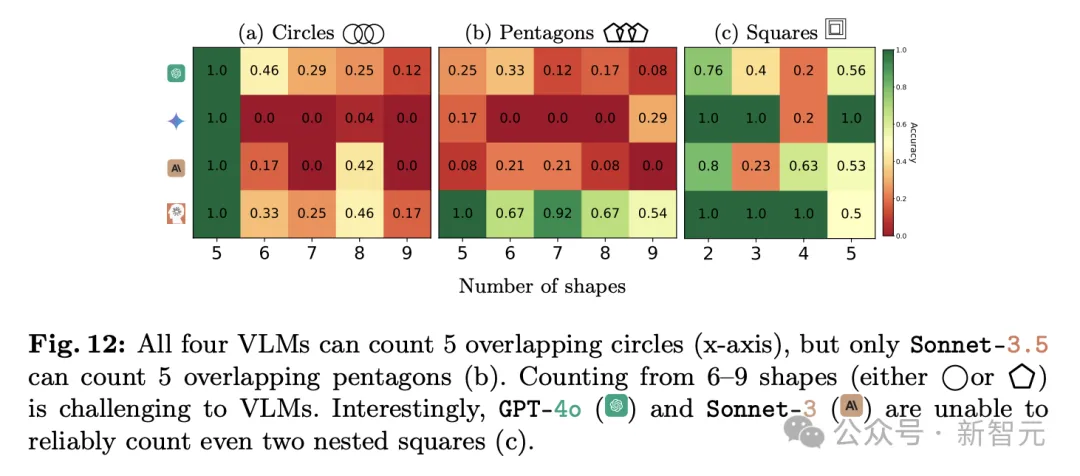

任務(wù)4:環(huán)環(huán)相扣問題

接下來,VLM需要面對的是一個「環(huán)環(huán)相扣」問題,即計算圖像中有幾個圓圈互鎖。

此處應(yīng)響起B(yǎng)GM:啊啊啊啊~ 五環(huán),你比四環(huán)多一環(huán)~

圖片

圖片

這項(xiàng)測試的結(jié)果有一點(diǎn)離奇:當(dāng)圖中有五個環(huán)時,模型都能100%正確;一旦多一個環(huán),VLM則完全摸不著頭腦了。

圖片

圖片

Gemini迷失了方向,一次都回答不正確,Sonnet-3.5有三分之一的時間是對的,GPT-4o的正確率接近一半。

圖片

圖片

作者提出,識別「五環(huán)」的準(zhǔn)確率如此之高,和常見的奧運(yùn)會「五環(huán)」標(biāo)志有非常密切的關(guān)系。

表5中可以看到,4個模型都傾向于數(shù)出5個圓,遠(yuǎn)遠(yuǎn)大于數(shù)出5個五邊形的頻率。

圖片

圖片

這個測試表明,無論這些模型在做什么,它都不具備我們?nèi)祟愃斫獾摹敢暳Α埂V饕獑栴}在于它們的表現(xiàn)非常不穩(wěn)定,在不同數(shù)量、不同形狀組成的圖像中,識別成功率存在巨大差異。

圖片

圖片

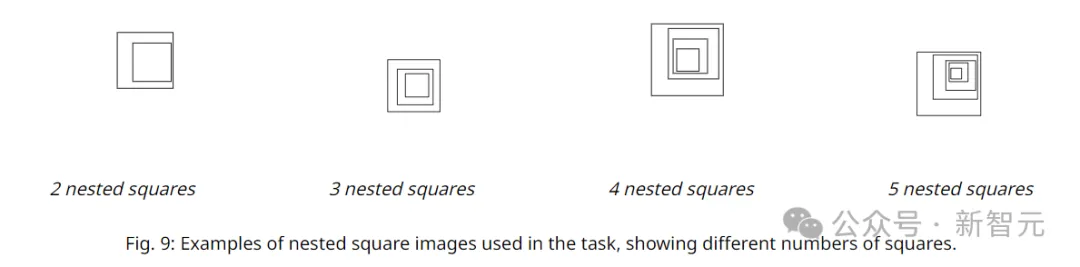

任務(wù)5:嵌套正方形

任務(wù)2顯示VLM在計算相交圓方面存在困難,那么把正方形都完全嵌套在另一個更大的正方形中,使它們的邊緣不相交,VLM表現(xiàn)又會如何呢?

如下圖所示,在大小為C×C的畫布上,作者渲染N∈{2,3,4,5}個嵌套的正方形。

圖片

圖片

首先使用隨機(jī)邊長d∈{2,3,4}px渲染最外層的正方形。剩余的N-1個正方形使用0.75×d的縮小系數(shù)繪制,并放置在隨機(jī)坐標(biāo)處,以確保它們不會接觸到外部正方形。

對于3種線條粗細(xì)的設(shè)置分別生成10張圖像(其中正方形具有不同的隨機(jī)位置),并對所有N值重復(fù)該過程,共得到120張圖像。

可以發(fā)現(xiàn),計算嵌套的正方形數(shù)量,對VLM來說都是難以準(zhǔn)確完成的任務(wù)。

圖片

圖片

模型精度差異很大,GPT-4o(48.33%)和Gemini-1.5(55.00%)至少落后Gemini-1.5(80.00%)和Claude3.5(87.50%)30分。

圖片

圖片

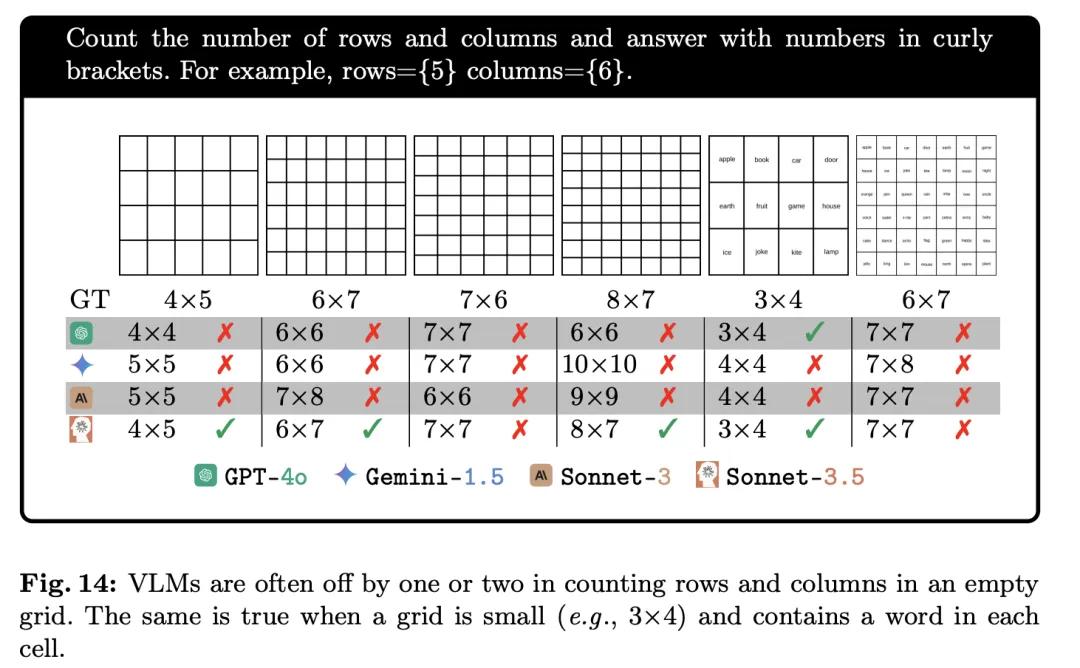

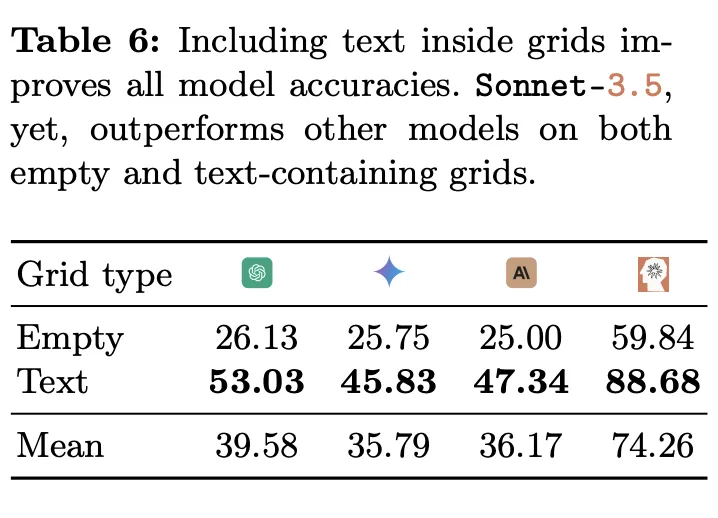

任務(wù)6:表格有幾列和幾行?

之前任務(wù)的結(jié)果表明,VLM無力應(yīng)對重疊(任務(wù)4)或嵌套(任務(wù)5)這樣的問題,作者決定給VLM換個方向,看看它們關(guān)于相鄰圖形相關(guān)問題的表現(xiàn)。

作者將正方形拼成一個網(wǎng)格,然后讓VLM來計數(shù)。這些VLM曾在DocVQA中有過出色表現(xiàn)(準(zhǔn)確率≥ 90%),DocVQA中就包含許多帶有表格的問題,因此這項(xiàng)任務(wù)對于VLM來說應(yīng)該是很簡單的。

為了簡化任務(wù),作者僅要求模型計算給定表格中的行數(shù)和列數(shù)。

圖片

圖片

結(jié)果發(fā)現(xiàn),模型始終無法正確計算空白網(wǎng)格的行數(shù)和列數(shù)。

圖片

圖片

然而,當(dāng)網(wǎng)格單元中包含文本時,所有VLM的性能都會提高,尤其是Sonnet-3.5。

圖片

圖片

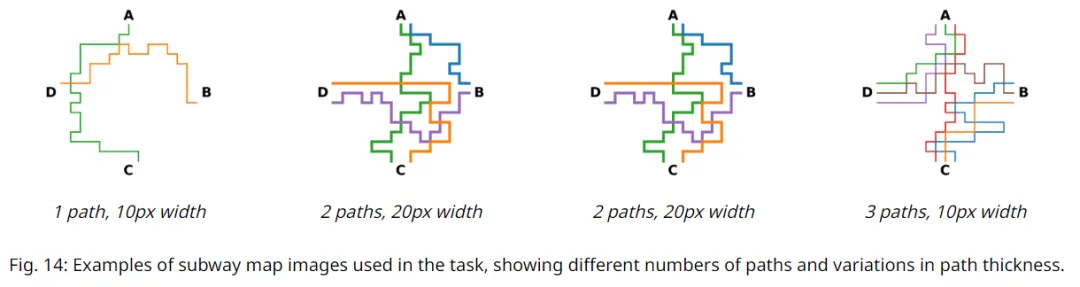

任務(wù)7:識別路線圖

這項(xiàng)任務(wù)測試VLM識別特殊顏色路徑的能力,跟隨特定顏色的線條從給定的出發(fā)點(diǎn)追蹤到目的地,這是閱讀并理解地圖所需的重要能力。

如下圖所示,在大小為C×C的圖像上創(chuàng)建地鐵地圖,其中C∈{512,1024}px。

在4個固定坐標(biāo)處寫4個站名(A、B、C、D)。將畫布劃分為一個由18×18個單元格組成的隱形網(wǎng)格,并初始化距離每個站C/18px的3個路徑起點(diǎn)。

使用深度優(yōu)先搜索算法從隨機(jī)站和隨機(jī)起點(diǎn)開始繪制一條路徑,其中每一步都可以沿任何方向移動一個單元格。重復(fù)這個過程,使每個站都有N∈{1,2,3}條輸出路徑,總共繪制出180個地圖。

圖片

圖片

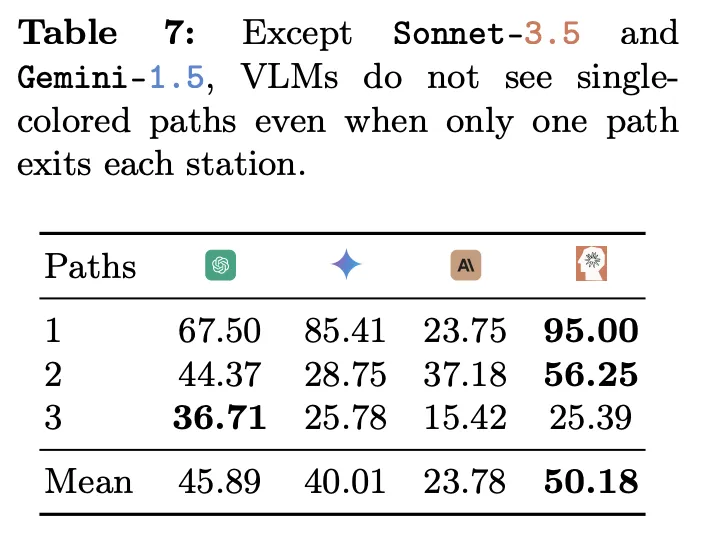

給定兩個指定車站,任務(wù)要求VLM計算兩站之間有多少種不同顏色的路徑。

實(shí)驗(yàn)結(jié)果發(fā)現(xiàn),即使兩站之間只有一條顏色的路徑,也沒有模型能達(dá)到100%的準(zhǔn)確率。

圖片

圖片

準(zhǔn)確率最高的是Sonnet-3.5,在只有一條路時能達(dá)到95%,然而到了兩條路的情況下,準(zhǔn)確率就迅速降低到僅有50.18%。

圖片

圖片

隨著路徑復(fù)雜性提升,從1條路徑增加到3條路徑,大多數(shù)VLM都會表現(xiàn)出明顯的性能下降。

VLM的「盲目性」

為什么VLM在上述的視覺能力檢測中表現(xiàn)得極不穩(wěn)定呢?

或許我們能從任務(wù)4中模型對「奧運(yùn)五環(huán)」的偏好中找到蛛絲馬跡。最符合常理的解釋就是:

VLM的訓(xùn)練數(shù)據(jù)中,「奧運(yùn)五環(huán)」的圖像反復(fù)出現(xiàn),而且在許多文字資料中有詳細(xì)的描述。

但是在VLM的訓(xùn)練數(shù)據(jù)中,卻找不到6個或者7個互鎖的環(huán),這也是它們?yōu)槭裁椿卮鸩槐M如人意的原因。

因?yàn)閂LM或許根本不知道它們「看」的是什么,也沒有真正理解什么是環(huán)、重疊或是任何其他概念。

可是,即便我們用blind(盲)來形容模型的這種表現(xiàn),也仍然是在把模型擬人化,就跟大模型公司宣傳其具有「視覺能力」一樣別無二致。

研究人員Nguyen也表示,「盲」即使對于人類來說也有很多定義,而且目前還沒有一個詞可以形容人工智能對我們所展示的圖像的這種盲目/不敏感。

VLM的行為是輸入文本提示、輸入圖像和數(shù)十億個權(quán)重的復(fù)雜函數(shù),目前還沒有技術(shù)可以準(zhǔn)確地可視化模型所看到的內(nèi)容。

他推測,這些模型并不是完全「盲目」的,它們從圖像中只能提取出「近似」和抽象的視覺信息,但無法進(jìn)行視覺判斷,因此表現(xiàn)得像一個了解圖像但實(shí)際上看不到圖像的人。

Nguyen用一個例子,很好地支持了上述假設(shè):

圖片

圖片

用戶:兩個圓形重疊的區(qū)域是什么顏色的?

GPT-4o:兩個圓形的重疊區(qū)域是綠松石的顏色(青色陰影)。

Gemini-1.5:綠色圓形和藍(lán)色圓形的重疊區(qū)域會是青色的。

Sonnet-3.5:我很抱歉,但圖片里只有兩個單獨(dú)的圓形,一個是綠色,一個是藍(lán)色,不存在重疊區(qū)域。

很顯然,除了Sonnet-3.5以外,GPT-4o和Gemini-1.5只是在「想象」圖像,而不是真的「看到」了圖像。

那么,這項(xiàng)研究是否意味著這些「視覺」人工智能模型毫無用處?

事實(shí)并非如此。這些模型中的每一個都在很多任務(wù)上表現(xiàn)出高度的準(zhǔn)確性,比如識別人類行為和表情、日常物品和環(huán)境照片等方面。

這項(xiàng)研究的意義在于,讓我們對VLM過于「擬人化」的營銷策略祛魅。

如果我們聽信科技巨頭的營銷話術(shù),可能會真的認(rèn)為視覺大模型能夠「看到」。

但只需要進(jìn)行幾個小測試,我們就能輕易發(fā)現(xiàn)VLM和人類的本質(zhì)區(qū)別。它被「擬人化」,其實(shí)正凸顯了其非人的本質(zhì)。

參考資料:

https://arxiv.org/abs/2407.06581

https://techcrunch.com/2024/07/11/are-visual-ai-models-actually-blind/?_refluxos=a10