Karpathy觀點惹爭議:RLHF不是真正的強化學習,谷歌、Meta下場反對

AI 大牛 Karpathy 又來科普人工智能概念了。

昨日,他發推表示,「基于人類反饋的強化學習(RLHF)只是勉強算得上是強化學習(RL)。」

Karpathy 的全文解釋如下:

RLHF 是訓練大語言模型(LLM)的第三個(也是最后一個)主要階段,前兩個階段分別是預訓練和監督微調(SFT)。我認為 RLHF 只是勉強算得上 RL,它沒有得到廣泛的認可。RL 很強大,但 RLHF 卻不然。

讓我們看看 AlphaGo 的例子,它是使用真正的 RL 訓練的。計算機玩圍棋(Go)游戲,并在實現獎勵函數最大化的回合(贏得比賽)中訓練,最終超越了最厲害的人類棋手。AlphaGo 沒有使用 RLHF 進行訓練,如果它用了,效果就不會那么好。

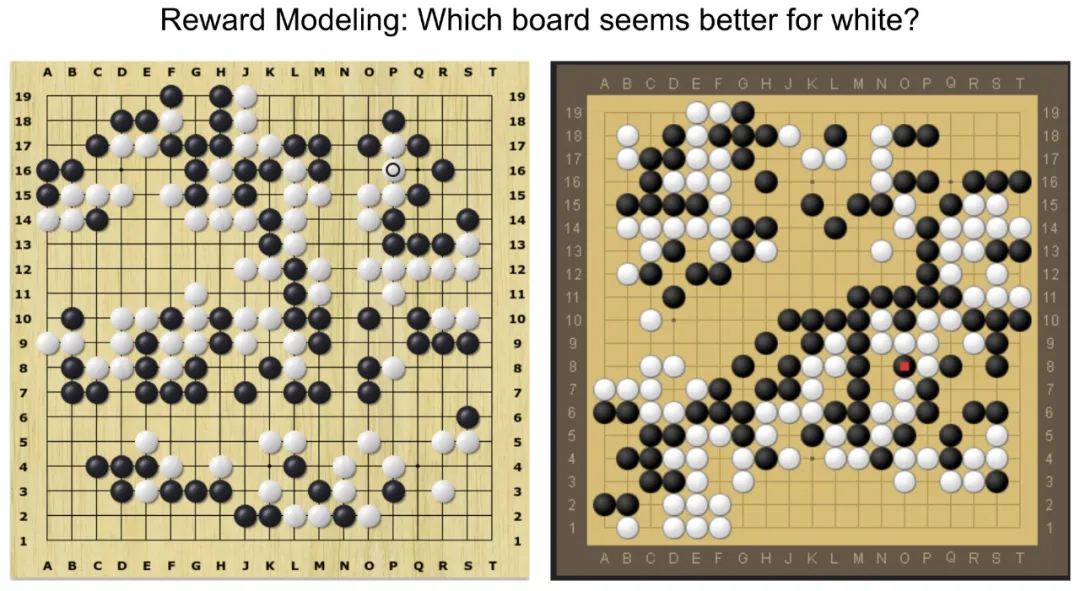

用 RLHF 訓練 AlphaGo 會是什么樣子呢?首先,你要給人類標注員兩個圍棋棋盤的狀態,然后問他們更喜歡哪一種:

然后你會收集到 10 萬個類似的比較,并訓練一個「獎勵模型」(RM)神經網絡來模擬人類對棋盤狀態的氛圍檢查(vibe check)。你要訓練它同意人類判斷的平均水平。一旦我們有了獎勵模型氛圍檢查,你就可以針對此運行 RL,學習如何下出帶來良好氛圍的棋步。顯然,這不會在圍棋中產生任何太有趣的結果。

這主要有以下兩個根本的、獨立的原因:

1) 氛圍可能會產生誤導,這不是實際獎勵(贏得比賽)。這是一個糟糕的智能體目標。更糟糕的是,2) 你會發現你的 RL 優化偏離了軌道,因為它很快發現棋盤狀態與獎勵模型相反。請記住,獎勵模型是一個龐大的神經網絡,使用數十億參數來模擬氛圍。有些棋盤狀態超出了自身訓練數據的分布范圍,實際上并不是良好狀態,但卻從獎勵模型中獲得了非常高的獎勵。

出于同樣的原因,我有時感到驚訝的一點是 RLHF 工作竟然適用于 LLM。我們為 LLM 訓練的獎勵模型只是以完全相同的方式進行氛圍檢查,它會對人類評分者在統計學上看起來喜歡的助手響應給出高分。這不是正確解決問題的實際目標,而是人類認為好的智能體目標。

其次,你甚至無法長時間地運行 RLHF,因為你的模型很快學會以游戲獎勵模型的方式來做出響應。這些預測看起來真的非常奇怪,你會看到你的 LLM 助手開始對很多 prompt 做出無意義的響應,比如「The the the the the the」。這在你看來是荒謬的,但隨后你查看獎勵模型氛圍檢查,卻發現出于某種原因,獎勵模型會認為這些看起來很棒。

你的 LLM 發現了一個對抗性示例,它超出了獎勵模型訓練數據的范圍,處于未定義的范圍。你可以通過反復講這些特定示例添加到訓練集來緩解這一情況,但下次仍會找到其他對抗性示例。你甚至無法運行 RLHF 進行很多優化步驟。你執行了幾百或幾千步之后必須調用它,因為你的優化將開始與獎勵模型博弈。這并不是 AlphaGo 那樣的 RL。

不過,RLHF 是構建 LLM 助手的一個非常有用的步驟。我認為這有幾個微妙的原因,其中我最喜歡的一點是通過 RLHF,LLM 助手會從生成器 - 判別器的 gap 中受益。也就是說,對于很多問題類型,人類標注員從幾個候選答案中選出最佳答案要比從頭寫出理想答案容易得多。一個很好的例子是像「生成一首回形針詩」這樣的 prompt。一個普通的人類標注員很難從頭寫出一首好詩來作為監督微調示例,但可以在給定幾個候選答案(詩)的情況下選出一首較好的。因此 RLHF 是一種從人類監督的「容易度」差距中獲益的方式。

還有一些其他原因,比如 RLHF 有助于緩解幻覺。如果獎勵模型是一個足夠強大的模型,能夠在訓練期間發現 LLM 編造的東西,則可以學會用低獎勵來懲罰這種行為,教會模型在不確定時避免冒險獲取事實性知識。但令人滿意的幻覺緩解和處理是另外的事情,這里不做延伸。總之,RLHF 確實有用,但它不是 RL。

到目前為止,還沒有一個針對 LLM 的生產級 RL 在開放域得到令人信服的實現和大規模展示。直觀地說,這是因為在開放式問題解決任務中獲得實際獎勵(即贏得比賽)非常困難。在圍棋這類封閉、類博弈的環境中,一切都很有趣。其中動態受到限制,獎勵函數評估成本很低,不可能進行博弈。

但是,你如何為總結一篇文章提供客觀的獎勵?或者回答關于某個 pip 安裝的模棱兩可的問題?或者講個笑話?或者將一些 Java 代碼重寫為 Python?實現這些在原則上并非不可能, 但也非易事,需要一些創造性思維。無論誰能令人信服地解決這個問題,都將能夠運行真正的 RL,使得 AlphaGo 在圍棋中擊敗了人類。有了 RL,LLM 在解決開放域問題中才有可能真正擊敗人類。

Karpathy 的觀點得到一些人的附議,并指出 RLHF 與 RL 的更多差異。比如 RLHF 沒有進行適當的搜索,主要學習利用預訓練軌跡的子集。相比之下,在進行適當的 RL 時,離散動作分布通常會通過在損失函數中添加熵項來增噪。Kaypathy 認為,原則上你可以輕松地為 RLHF 目標添加熵獎勵,這在 RL 中也經常這樣做。但實際上似乎并不多見。

谷歌研究科學家 Kevin Patrick Murphy 也完全同意 Karpathy 的觀點。他認為 RLHF 更像是一個具有字符串值操作的上下文「強盜」,其中 prompt 是上下文,所以不能稱為完整的 RL。此外將日常任務的獎勵形式化是困難的部分(他認為或許可以叫做對齊)。

圖源:https://x.com/sirbayes/status/1821421936045597022

不過,另一位谷歌高級研究科學家 Natasha Jaques 認為 Karpathy 的觀點是錯誤的。她認為智能體在與人互動時,給出人類喜歡的答案才是真正的目標。

超出分布范圍并不是 RLHF 獨有的問題。如果僅僅因為人類反饋比運行無限的圍棋模擬更受限,并不意味著這不是一個不值得解決的問題,只會讓它成為一個更具挑戰性的問題。她希望這成為一個更有影響力的問題,畢竟在 LLM 中減少偏見比在圍棋中擊敗人類更有意義。使用貶義的話術,比如 Karpathy 說獎勵模型是一種氛圍檢查,這是愚蠢的。你可以用同樣的論點來反對價值估計。

她覺得 Karpathy 的觀點只會阻止人們從事 RLHF 工作,而它是目前唯一可行的減輕 LLM 偏見和幻覺可能造成嚴重傷害的方法。

圖源:https://x.com/natashajaques/status/1821631137590259979

Meta 研究者 Pierluca D'Oro 不同意 Karpathy 的主要觀點,但同意「RLHF is just barely RL」這一標題。他認為通常用于微調 LLM 的 RLHF 幾乎不能算是 RL。

主要觀點如下:在強化學習中,追求一個「完美的獎勵」概念是不現實的,因為大多數復雜任務中,除了目標的重要性,執行方式同樣重要。盡管在圍棋等明確規則的任務中,RL 表現出色。但在涉及復雜行為時,傳統 RL 的獎勵機制可能無法滿足需求。他主張研究如何在不完美的獎勵模型下提高 RL 的性能,并強調了反饋循環、魯棒 RL 機制以及人機協作的重要性。

圖源:https://x.com/proceduralia/status/1821560990091128943