清華新VLA框架加速破解具身智能止步實(shí)驗(yàn)室“魔咒”,LLM開(kāi)銷節(jié)省4-6倍 | NeurIPS'24

計(jì)算、存儲(chǔ)消耗高,機(jī)器人使用多模態(tài)模型的障礙被解決了!

來(lái)自清華大學(xué)的研究者們?cè)O(shè)計(jì)了DeeR-VLA框架,一種適用于VLA的“動(dòng)態(tài)推理”框架,能將LLM部分的相關(guān)計(jì)算、內(nèi)存開(kāi)銷平均降低4-6倍。

(VLA:視覺(jué)-語(yǔ)言-動(dòng)作模型,代表一類用于處理多模態(tài)輸入的模型)

簡(jiǎn)單來(lái)說(shuō),DeeR-VLA就像人的決策系統(tǒng):簡(jiǎn)單任務(wù)快速思考,復(fù)雜任務(wù)仔細(xì)思考。通過(guò)多出口架構(gòu),模型在足夠計(jì)算后即可提前“剎車”,避免浪費(fèi)算力。

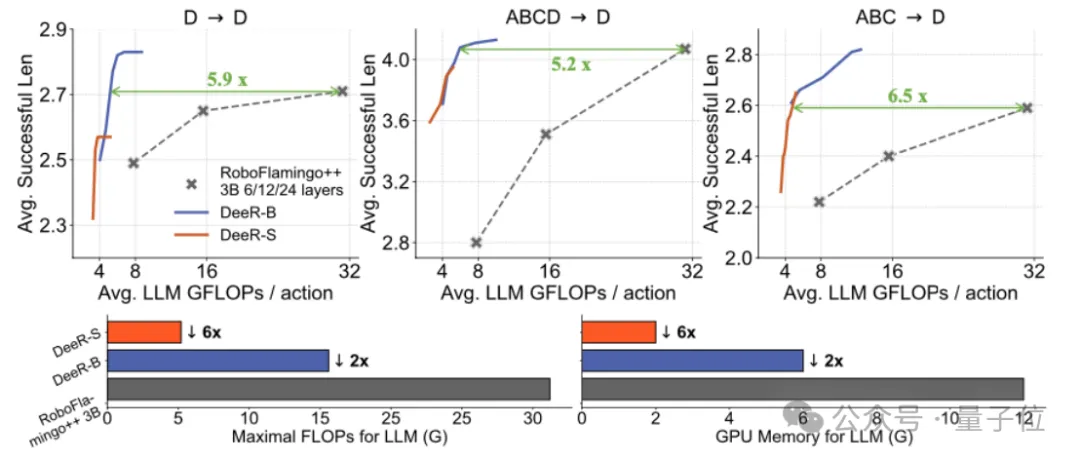

在CALVIN機(jī)器人操作基準(zhǔn)測(cè)試中,DeeR-VLA實(shí)現(xiàn)了大語(yǔ)言模型(LLM)計(jì)算成本減少5.2-6.5倍,GPU內(nèi)存減少2-6倍,同時(shí)保持了性能不受影響。

大模型存在冗余性

近年來(lái),多模態(tài)大語(yǔ)言模型(MLLM)讓機(jī)器人具備了前所未有的理解與執(zhí)行能力。通過(guò)語(yǔ)言指令和視覺(jué)信息的結(jié)合,機(jī)器人可以完成復(fù)雜任務(wù),比如“抓起藍(lán)色物體并放到桌上”。

一些前沿模型,如RT-2,甚至可以泛化到新任務(wù)或新物體。然而,要讓這些強(qiáng)大的模型走進(jìn)實(shí)際場(chǎng)景,還有一道難題需要解決——MLLM雖然聰明,但也“貪吃”。

每次推理動(dòng)輒調(diào)用數(shù)十億參數(shù),消耗巨大的計(jì)算資源。

這對(duì)于嵌入式機(jī)器人平臺(tái)來(lái)說(shuō)是致命的——GPU內(nèi)存不足、計(jì)算時(shí)間長(zhǎng)、電池續(xù)航不夠,直接讓“通用機(jī)器人”的夢(mèng)想止步于實(shí)驗(yàn)室。

然而實(shí)際上,在機(jī)器人控制領(lǐng)域,很多實(shí)際應(yīng)用場(chǎng)景并沒(méi)有我們想象的那么復(fù)雜。

論文作者通過(guò)觀察發(fā)現(xiàn),絕大多數(shù)任務(wù)實(shí)際上可以通過(guò)較小的模型就能完成,只有在面對(duì)少數(shù)復(fù)雜場(chǎng)景時(shí),才需要調(diào)用完整的大型多模態(tài)模型。

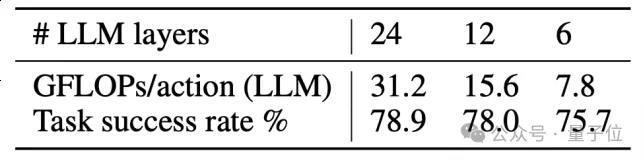

以Calvin數(shù)據(jù)集為例的實(shí)驗(yàn)結(jié)果便充分體現(xiàn)了這一點(diǎn):當(dāng)使用24層的OpenFlamingo作為基座模型時(shí),相比于6層的模型,任務(wù)完成率僅提高了3.2%,但計(jì)算成本卻增加了整整4倍。

這無(wú)疑凸顯了現(xiàn)有的多模態(tài)大模型對(duì)大部分簡(jiǎn)單機(jī)器人任務(wù)的冗余性。

這一發(fā)現(xiàn)引發(fā)了對(duì)現(xiàn)有模型設(shè)計(jì)的深刻思考:

為什么在大多數(shù)簡(jiǎn)單任務(wù)中還要使用高計(jì)算資源的復(fù)雜模型?

在很多情況下,使用更大的模型不僅沒(méi)有帶來(lái)明顯的性能提升,反而浪費(fèi)了寶貴的計(jì)算資源。

作者認(rèn)為,如何根據(jù)任務(wù)的復(fù)雜性動(dòng)態(tài)調(diào)整模型的規(guī)模,才能在不犧牲性能的情況下,最大化計(jì)算效率,成為了提升機(jī)器人智能的關(guān)鍵。

DeeR-VLA的設(shè)計(jì)

DeeR-VLA框架的核心在于其靈活的動(dòng)態(tài)推理機(jī)制,能夠根據(jù)任務(wù)復(fù)雜度智能調(diào)節(jié)LLM的計(jì)算深度。

這意味著,DeeR-VLA能夠在不同場(chǎng)景中激活任意規(guī)模的模型。

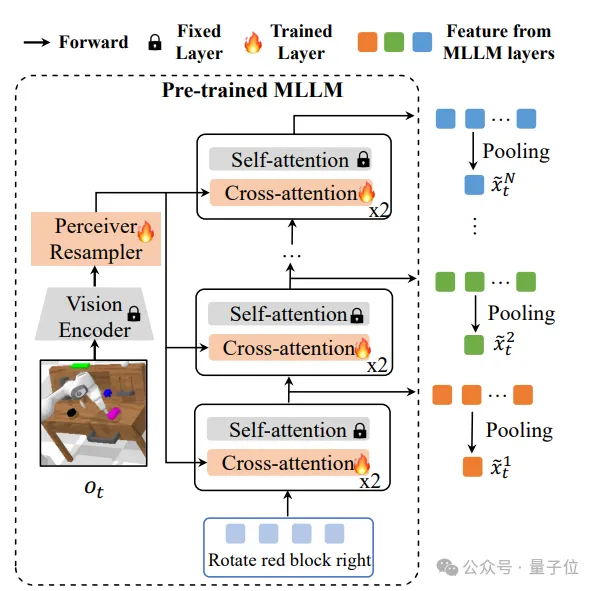

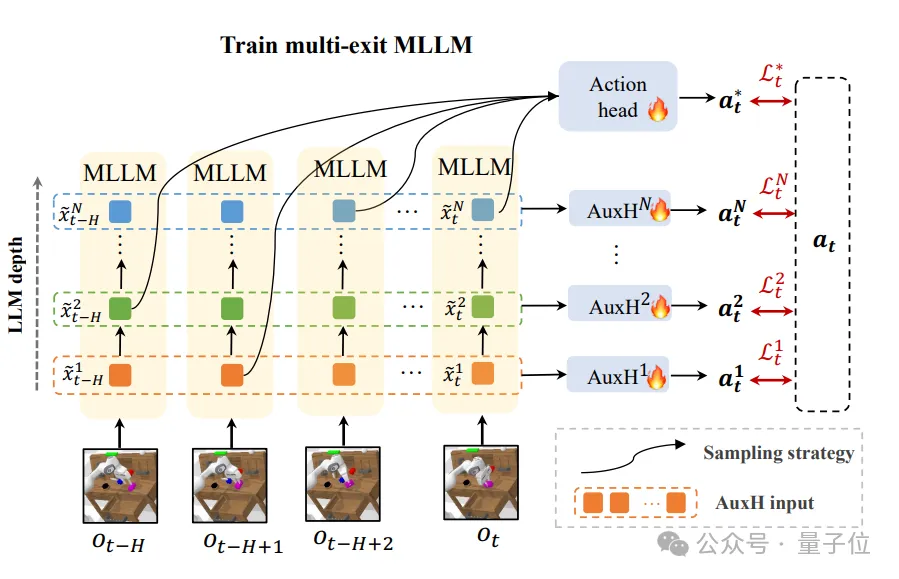

為了實(shí)現(xiàn)這一目標(biāo),DeeR-VLA引入了多出口架構(gòu),該架構(gòu)能在多模態(tài)大語(yǔ)言模型中按需選擇性激活不同的層級(jí)。

以下是其關(guān)鍵技術(shù)組件:

- 多出口MLLM結(jié)構(gòu): DeeR-VLA通過(guò)在MLLM中引入多出口架構(gòu),將模型劃分為多個(gè)階段,每個(gè)階段都可以輸出中間結(jié)果。一旦任務(wù)復(fù)雜度達(dá)到某個(gè)出口的需求,模型就會(huì)提前停止計(jì)算,避免激活更多層級(jí)。

- 特征池化方法: 每個(gè)出口的中間特征通過(guò)特征池化技術(shù)進(jìn)行壓縮,提取出最核心的信息。這種方法確保即便在早期退出,模型也能生成適用于后續(xù)動(dòng)作預(yù)測(cè)的高質(zhì)量特征。

- 動(dòng)作預(yù)測(cè)頭設(shè)計(jì): 在每個(gè)出口后,模型通過(guò)輕量級(jí)的動(dòng)作預(yù)測(cè)頭,將特征轉(zhuǎn)化為機(jī)器人具體的執(zhí)行動(dòng)作(如機(jī)械臂的位置和夾爪的開(kāi)合狀態(tài))。

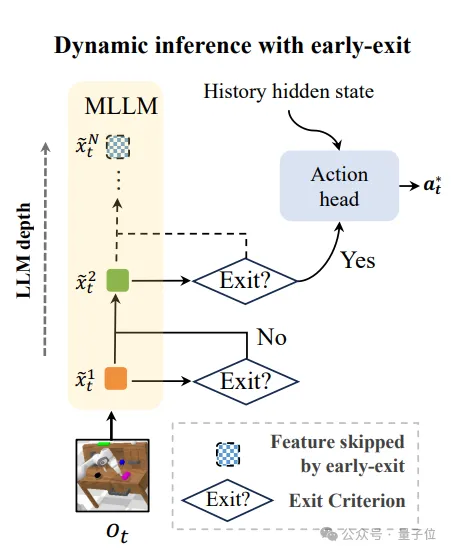

DeeR-VLA使用了一種獨(dú)特的動(dòng)作一致性準(zhǔn)則來(lái)決定是否提前退出。

通過(guò)對(duì)比相鄰出口的動(dòng)作預(yù)測(cè)結(jié)果,若結(jié)果差異小于閾值,則推斷模型已經(jīng)達(dá)到收斂狀態(tài),無(wú)需進(jìn)一步計(jì)算。

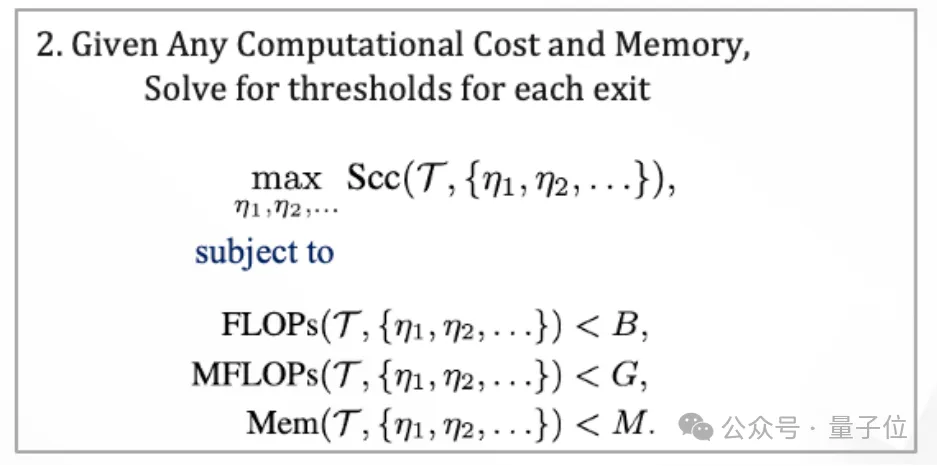

動(dòng)作一致性的閾值無(wú)需手動(dòng)設(shè)置,模型可以自動(dòng)計(jì)算出合適的閾值來(lái)滿足給定的設(shè)定平均計(jì)算成本、峰值計(jì)算、顯存預(yù)算,動(dòng)態(tài)調(diào)整計(jì)算規(guī)模,以適應(yīng)不同的硬件環(huán)境和實(shí)時(shí)性需求。

為了自動(dòng)尋找最佳退出閾值,DeeR-VLA還引入了貝葉斯優(yōu)化方法。在訓(xùn)練或?qū)嶋H應(yīng)用中,該方法通過(guò)探索和反饋不斷微調(diào)退出策略,確保計(jì)算資源的最優(yōu)分配。

在DeeR-VLA中,動(dòng)態(tài)推理時(shí),模型根據(jù)確定性的標(biāo)準(zhǔn)在每個(gè)時(shí)間步選擇合適的出口,并匯集時(shí)序上每一個(gè)時(shí)刻的特征生成最終的預(yù)測(cè)。

然而,在訓(xùn)練階段,由于缺乏明確的終止標(biāo)準(zhǔn),模型并不清楚時(shí)序上出口特征的分布,這導(dǎo)致訓(xùn)練時(shí)的行為與推理時(shí)有所不同。

為了解決這一問(wèn)題,DeeR-VLA引入了隨機(jī)出口采樣策略。

在訓(xùn)練過(guò)程中,模型在每個(gè)時(shí)間步隨機(jī)選擇一個(gè)出口進(jìn)行計(jì)算,這樣可以確保模型在所有出口序列上都能進(jìn)行有效學(xué)習(xí),并生成高質(zhì)量的預(yù)測(cè)。

這種策略有效減少了訓(xùn)練和推理之間的分布差異,使得模型能夠更好地應(yīng)對(duì)動(dòng)態(tài)推理過(guò)程中的不確定性。

此外,論文作者還引入了輔助預(yù)測(cè)頭(Auxiliary Heads)作為額外的監(jiān)督信號(hào),對(duì)每個(gè)出口的特征進(jìn)行優(yōu)化,使其更適合于動(dòng)作預(yù)測(cè)任務(wù)。

實(shí)驗(yàn)驗(yàn)證

DeeR-VLA框架在CALVIN長(zhǎng)Horizon多任務(wù)語(yǔ)言控制挑戰(zhàn)(LH-MTLC)基準(zhǔn)上進(jìn)行評(píng)估。該基準(zhǔn)目的是測(cè)試機(jī)器人在自然語(yǔ)言指令下執(zhí)行任務(wù)序列的能力,其中每個(gè)任務(wù)序列包含五個(gè)子任務(wù)。

由于多模態(tài)大模型中LLM部分占據(jù)主要的參數(shù)量,DeeR-VLA主要關(guān)注LLM部分的計(jì)算量和顯存占用,而不是整體框架的節(jié)省。

通過(guò)在不同環(huán)境設(shè)置下的測(cè)試,DeeR-VLA展現(xiàn)了出色的表現(xiàn),尤其是在任務(wù)成功率與計(jì)算效率之間的平衡。

與其他SOTA方法相比,DeeR-VLA在任務(wù)成功率上保持競(jìng)爭(zhēng)力的同時(shí),LLM部分的計(jì)算資源消耗大幅減少。

例如,在D→D設(shè)置下,DeeR-VLA以更少的計(jì)算量(5.9倍減少的FLOPs)和2倍更低的GPU內(nèi)存消耗,依然達(dá)到了RoboFlamingo++的性能。

為了驗(yàn)證DeeR-VLA在實(shí)際推理中的效率,研究團(tuán)隊(duì)在Nvidia V100 GPU上對(duì)DeeR和RoboFlamingo++進(jìn)行了比較。

結(jié)果表明,DeeR-VLA的LLM部分的推理時(shí)間比RoboFlamingo++減少了68.1%,且兩者在任務(wù)成功率上幾乎相同。

這一實(shí)驗(yàn)證明了DeeR-VLA框架不僅在理論上能夠減少計(jì)算負(fù)擔(dān),而且在實(shí)際應(yīng)用中也能顯著提升推理速度。

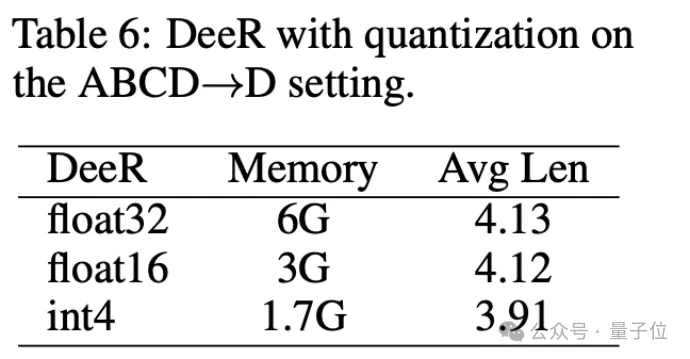

同時(shí),DeeR-VLA框架能夠與量化技術(shù)相結(jié)合,進(jìn)一步減少模型LLM部分的內(nèi)存使用。

論文作者介紹

該論文的一作是清華大學(xué)自動(dòng)化系三年級(jí)博士生Yue Yang,他專注于強(qiáng)化學(xué)習(xí)、世界模型、多模態(tài)大模型和具身智能的研究。

此前他作為核心作者的論文《How Far is Video Generation from World Model: A Physical Law Perspective》被國(guó)內(nèi)外眾多大佬Yan Lecun,xie saining,Kevin Murphy等轉(zhuǎn)發(fā)。

另一位一作王語(yǔ)霖同樣是清華大學(xué)的博士生。兩位作者的導(dǎo)師都是黃高。

論文作者主頁(yè):https://yueyang130.github.io/。

論文鏈接:https://arxiv.org/abs/2411.02359v1。

代碼和模型鏈接:https://github.com/yueyang130/DeeR-VLA。