藏不住了!OpenAI的推理模型有時(shí)用中文「思考」

OpenAI o1 在推理時(shí)有個(gè)特點(diǎn),就像有人考試會(huì)把關(guān)鍵解題步驟寫在演草紙上,它會(huì)把推理時(shí)的內(nèi)心 os 分點(diǎn)列出來(lái)。

然而,最近 o1 的內(nèi)心 os 是越來(lái)越不對(duì)勁了,明明是用英語(yǔ)提問(wèn)的,但 o1 開(kāi)始在演草紙上用中文「碎碎念」了。

比如這道編碼題,前面 o1 還在老老實(shí)實(shí)用英語(yǔ),后腳就進(jìn)入了「中文時(shí)間」。

這波操作,怎么看都像留子寫論文的反向操作:先用中文打草稿,再翻譯成英文交作業(yè),倒反天罡了。

這件事先在 reddit 上掀起了一陣討論,匿名發(fā)帖者表示:「我只見(jiàn)過(guò) Deepseek 的模型這樣做,但我不知道為什么 OpenAI 的模型會(huì)突然偏向中文啊!」

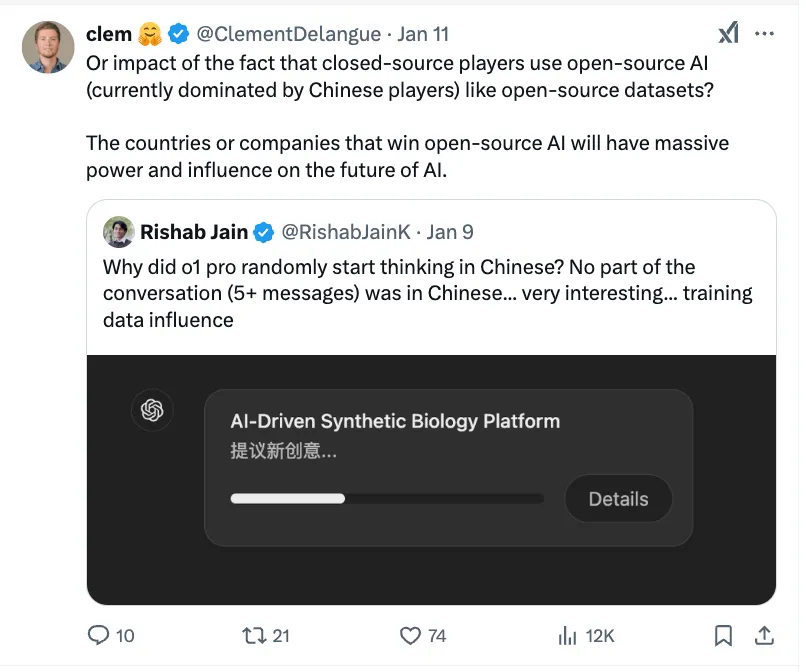

神經(jīng)科學(xué) × AI 研究員 Rishab Jain 也在 X 上表示疑惑:「為啥 o1 突然開(kāi)始用中文思考了?明明整個(gè)對(duì)話(5 + 條消息)都是英文啊...... 很有意思...... 該不會(huì)是訓(xùn)練數(shù)據(jù)在作祟吧?」

OpenAI 并未做出解釋,甚至都沒(méi)有承認(rèn)這一現(xiàn)象。

谷歌的 Gemini 也出現(xiàn)了類似的行為。它會(huì)在段落中間隨機(jī)插入古吉拉特語(yǔ)(印度的一種主要語(yǔ)言)單詞。ChatGPT 也可能會(huì)用沒(méi)有出現(xiàn)在對(duì)話中的語(yǔ)言來(lái)定義網(wǎng)頁(yè)左邊列表里整個(gè)對(duì)話的名稱。

這種多語(yǔ)言能力者的現(xiàn)象不只出現(xiàn)在推理或語(yǔ)言模型中,多模態(tài)模型也「躺槍」,有網(wǎng)友提到自己在跟 GPT-4o 對(duì)話的時(shí)候,它也會(huì)半途隨機(jī):「讓我們說(shuō)中文?」

那么,這到底是怎么一回事呢?

難道是 o1 套殼「QwQ」的事,藏不住了?

嗯,AI 專家們也不太確定。但他們先針對(duì)推理模型提出了幾種推測(cè)。

訓(xùn)練數(shù)據(jù)的鍋?

Hugging Face CEO Clément Delangue 在 X 上轉(zhuǎn)貼,表示:「或許這是因?yàn)殚]源公司在使用(目前是中國(guó)機(jī)構(gòu)主導(dǎo))的開(kāi)源 AI 和開(kāi)源數(shù)據(jù)集?」

他還提到:「未來(lái)在開(kāi)源 AI 領(lǐng)域勝出的國(guó)家或公司,將在 AI 的未來(lái)發(fā)展中擁有巨大的影響力和話語(yǔ)權(quán)。」

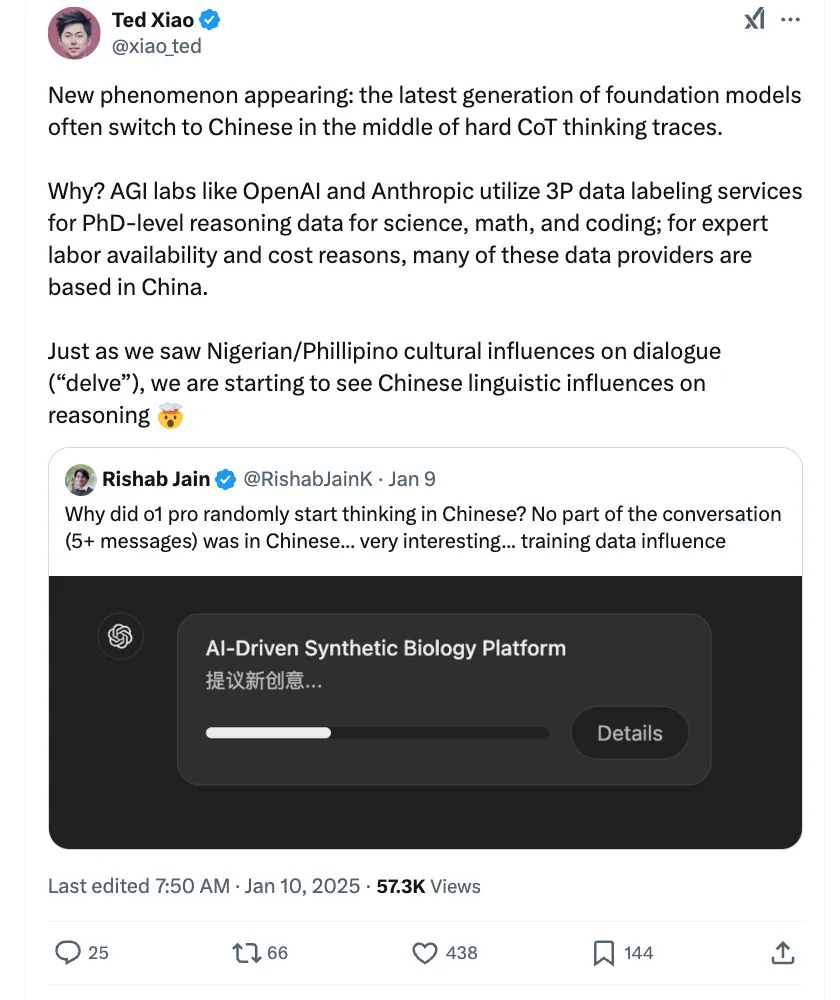

「OpenAI 和 Anthropic 的實(shí)驗(yàn)室都會(huì)使用第三方數(shù)據(jù)標(biāo)注服務(wù)來(lái)處理科學(xué)、數(shù)學(xué)和編程方面的博士級(jí)推理數(shù)據(jù),」RT-X 系列的主要作者、Google DeepMind 研究員 Ted Xiao 做出了進(jìn)一步解釋,「出于專業(yè)勞動(dòng)力可用性和成本考慮,許多這些第三方數(shù)據(jù)標(biāo)記供應(yīng)商都位于中國(guó)。」

而 o1 切換到中文可能是這種影響的一個(gè)例子。

軟件工程師 @ClaudiuDP 也表示:「可能是 AI 的訓(xùn)練數(shù)據(jù)中里,一些需要用來(lái)構(gòu)建回答的信息是用中文寫的。」

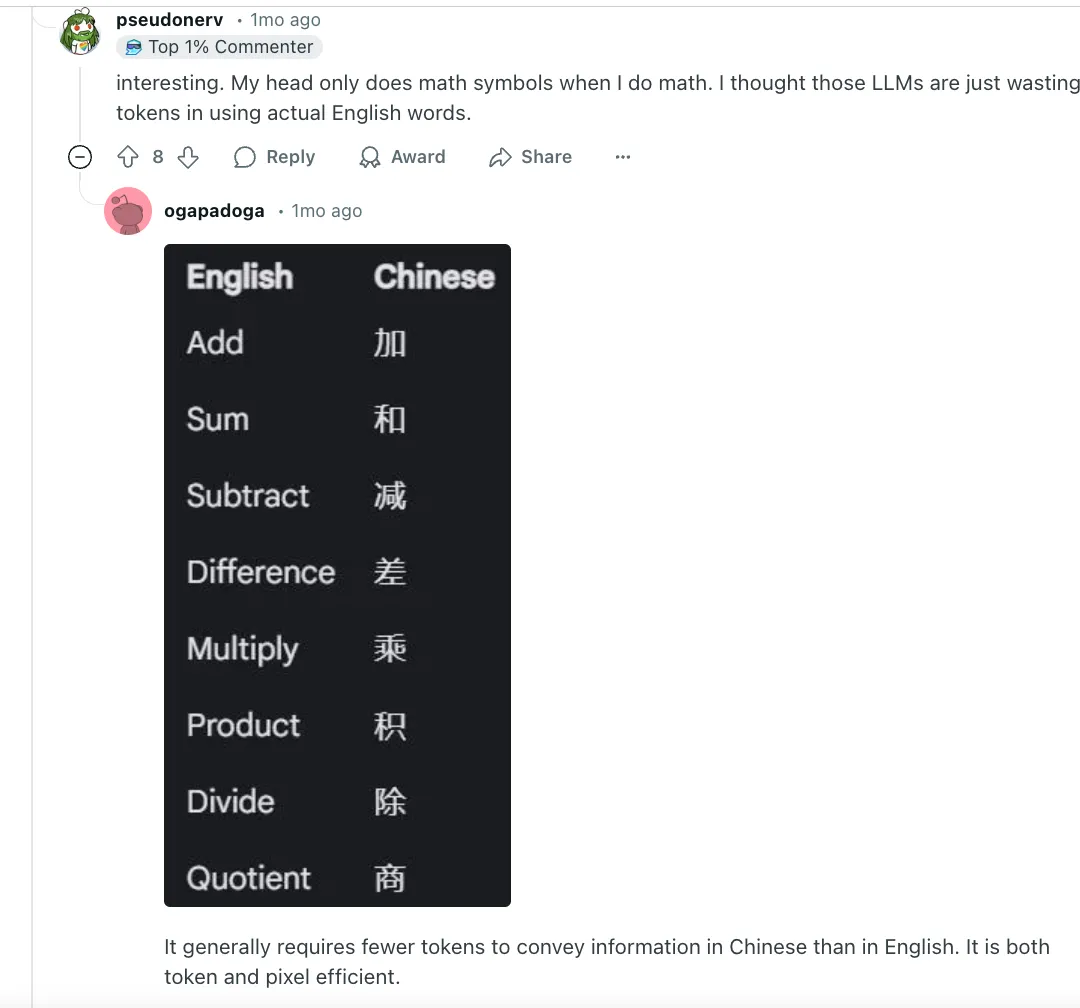

除了中文占訓(xùn)練數(shù)據(jù)的比重高之外,由于是中文是象形文字系統(tǒng),一個(gè)漢字往往可以表達(dá)一個(gè)完整的概念,相比之下,英文可能需要多個(gè)字母才能表達(dá)同樣的概念。這可能也是一種「節(jié)省 token」的策略?

「AI 選擇用中文思考,是因?yàn)橹形脑谀承┍磉_(dá)上更經(jīng)濟(jì),可以直接解概念壓縮包?」

「在思維鏈中,同等 token,選中文能思考得更深?」

「與英語(yǔ)相比,中文壓縮了 token 的使用。我懷疑這是否是原因,但節(jié)省這些冗長(zhǎng)的內(nèi)部推理模型的成本是明智之舉。」

解起數(shù)學(xué)題來(lái)尤為直觀,比如小 A 還在卷子上拼「Quotient」,而旁邊的中國(guó)同學(xué)的「商」字已經(jīng)寫完了。

選擇了最順手的語(yǔ)言?

然而,有些專家并不認(rèn)同應(yīng)該讓數(shù)據(jù)標(biāo)注背鍋。因?yàn)槌酥形模琽1 突然切換到印地語(yǔ)、泰語(yǔ)等其他語(yǔ)言的可能性也很大。

他們提出了不同的觀點(diǎn):「o1 可能只是在選擇最順手的語(yǔ)言來(lái)解題,或者只是單純的幻覺(jué)。」

「模型并不知道什么是語(yǔ)言,也不知道語(yǔ)言之間有什么不同,」阿爾伯塔大學(xué)助理教授、AI 研究員 Matthew Guzdial 對(duì) TechCrunch 表示,「對(duì)它來(lái)說(shuō)這些都只是文本。」

事實(shí)上,模型眼中的語(yǔ)言,和我們理解的完全不同。模型并不直接讀單詞,而是處理 tokens。以「fantastic」為例,它可以作為一個(gè)完整的 token;可以拆成「fan」、「tas」、「tic」三個(gè) token;也可以完全拆散,每個(gè)字母都是一個(gè) token。

但這種拆分方式也會(huì)帶來(lái)一些誤會(huì)。很多分詞器看到空格就認(rèn)為是新詞的開(kāi)始,但實(shí)際上不是所有語(yǔ)言都用空格分詞,比如中文。

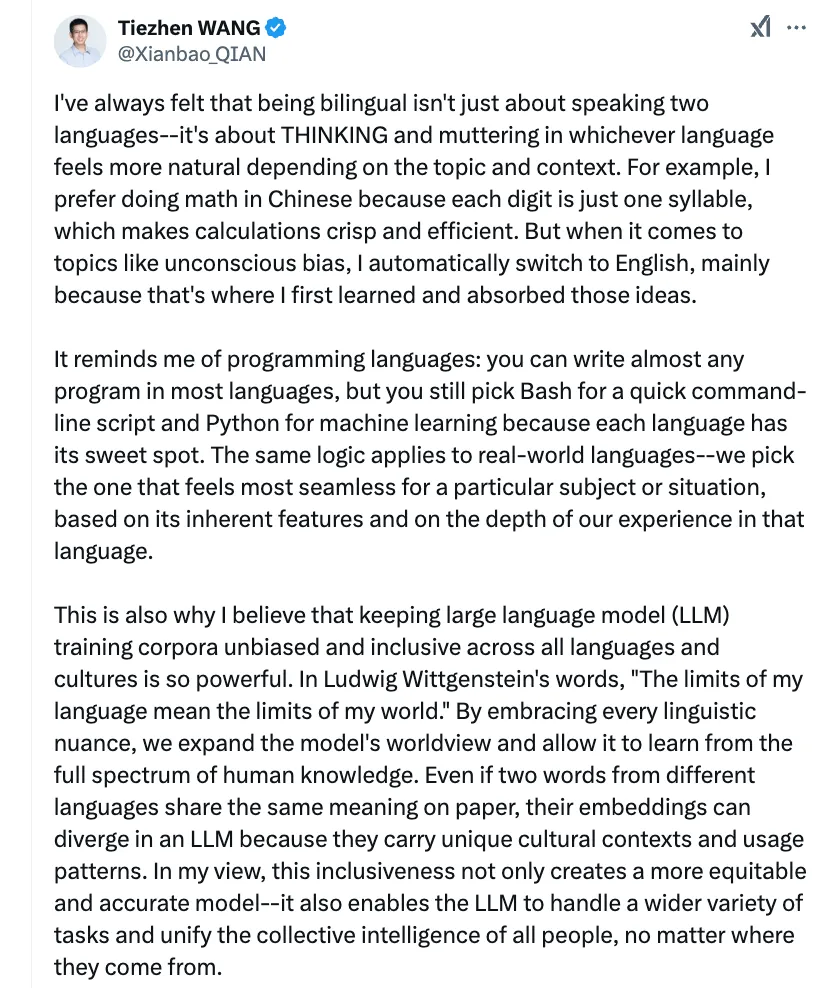

Hugging Face 的工程師 Tiezhen Wang 認(rèn)同 Guzdial 的看法,認(rèn)為推理模型語(yǔ)言的不一致性可能是訓(xùn)練期間建立了某種特殊的關(guān)聯(lián)。

他類比了人類的思維過(guò)程,會(huì)說(shuō)雙語(yǔ)并不僅僅是會(huì)說(shuō)兩種語(yǔ)言,而是一種獨(dú)特的思維方式:大腦會(huì)自然地選擇最適合當(dāng)下場(chǎng)景的語(yǔ)言。就像用中文算數(shù)學(xué)比較簡(jiǎn)潔高效,每個(gè)數(shù)字只需一個(gè)音節(jié),但討論「無(wú)意識(shí)偏見(jiàn)」時(shí)卻自然切換到英文,因?yàn)樽畛蹙褪怯糜⑽膶W(xué)習(xí)這個(gè)概念。

這種語(yǔ)言切換就像程序員選擇編程語(yǔ)言一樣自然 —— 雖然大多數(shù)編程語(yǔ)言都能完成任務(wù),但我們還是會(huì)選擇用 Bash 寫命令行,用 Python 做機(jī)器學(xué)習(xí),因?yàn)槊糠N語(yǔ)言都有它的「最佳場(chǎng)景」。

「工具要看場(chǎng)合」,這也啟發(fā)訓(xùn)練 AI 時(shí)也要讓它接觸多種語(yǔ)言,學(xué)習(xí)到不同文化中的獨(dú)特思維方式,這種包容性也能讓 AI 更全面,也更公平。

有許多 AI 專家與 Wang 的觀點(diǎn)不謀而合。

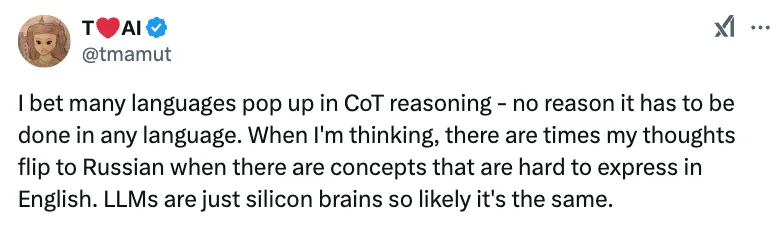

「在思維鏈推理過(guò)程中,肯定會(huì)冒出很多種語(yǔ)言,用哪種語(yǔ)言思考都行。就像我自己,當(dāng)某些概念用英語(yǔ)很難表達(dá)時(shí),我的思維就會(huì)自動(dòng)切換到俄語(yǔ)。大語(yǔ)言模型就是硅基大腦,可能也是同理。」

「這是訓(xùn)練過(guò)程中產(chǎn)生的一個(gè)現(xiàn)象。Deepseek 的 R1 模型也有同樣的表現(xiàn)。在訓(xùn)練過(guò)程中,模型會(huì)搜索那些最能幫助它得出正確結(jié)論的詞。而其他語(yǔ)言中的詞向量往往能更好地影響它的推理過(guò)程。」

同時(shí),不少圈內(nèi)人表示,既然切換語(yǔ)言對(duì)思考有幫助,而且用戶最終看到的還是英文結(jié)果,那這完全 OK。

「作為一個(gè)中國(guó)人,我經(jīng)常在腦子里用英文思考,因?yàn)槲沂请p語(yǔ)者。所以我一點(diǎn)也不驚訝大語(yǔ)言模型會(huì)用中文思考,畢竟它們也是多語(yǔ)言通。只要最后輸出的是預(yù)期語(yǔ)言就行,我覺(jué)得這不能算是幻覺(jué)。不過(guò),這是不是要進(jìn)一步思考:最好的 AI 思考方式,是不是應(yīng)該是一種與具體語(yǔ)言無(wú)關(guān)的隱藏狀態(tài)?」

「半路用中文思考」不是 bug,反而是一個(gè)意外的驚喜,說(shuō)明 AI 出現(xiàn)了「以我為主,為我所用」的智能涌現(xiàn)?