顛覆LLM格局!AI2新模型OLMo2,訓練過程全公開,數(shù)據(jù)架構雙升級

最近,非營利研究機構AI2上新了OLMo2系列模型,他們稱之為「迄今為止最好的完全開源模型」。

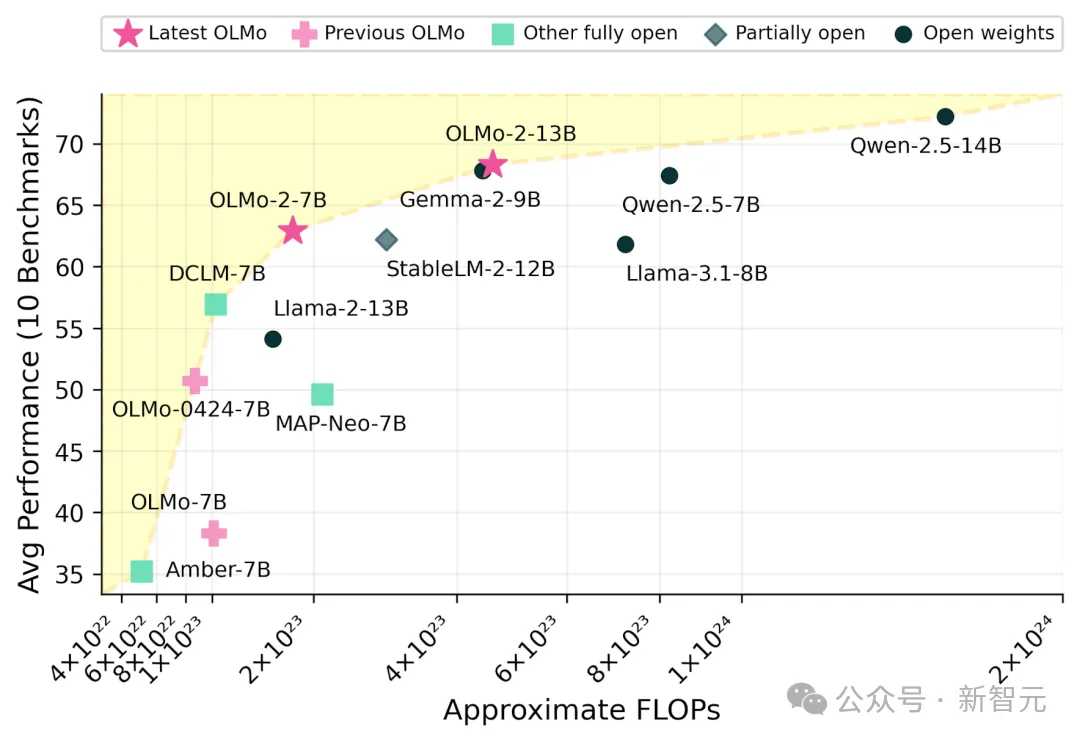

OLMo 2系列包含7B和13B兩個型號,相比如Llama 3.1和Qwen 2.5等開源模型達到了同等甚至更優(yōu)的性能,同時FLOPS計算量更少,在性能和計算效率之間取得了極佳的平衡,為開源LLM開辟了新的可能性。

不同大小開源模型的性能對比,OLMo 2的表現(xiàn)優(yōu)于同參數(shù)規(guī)模模型

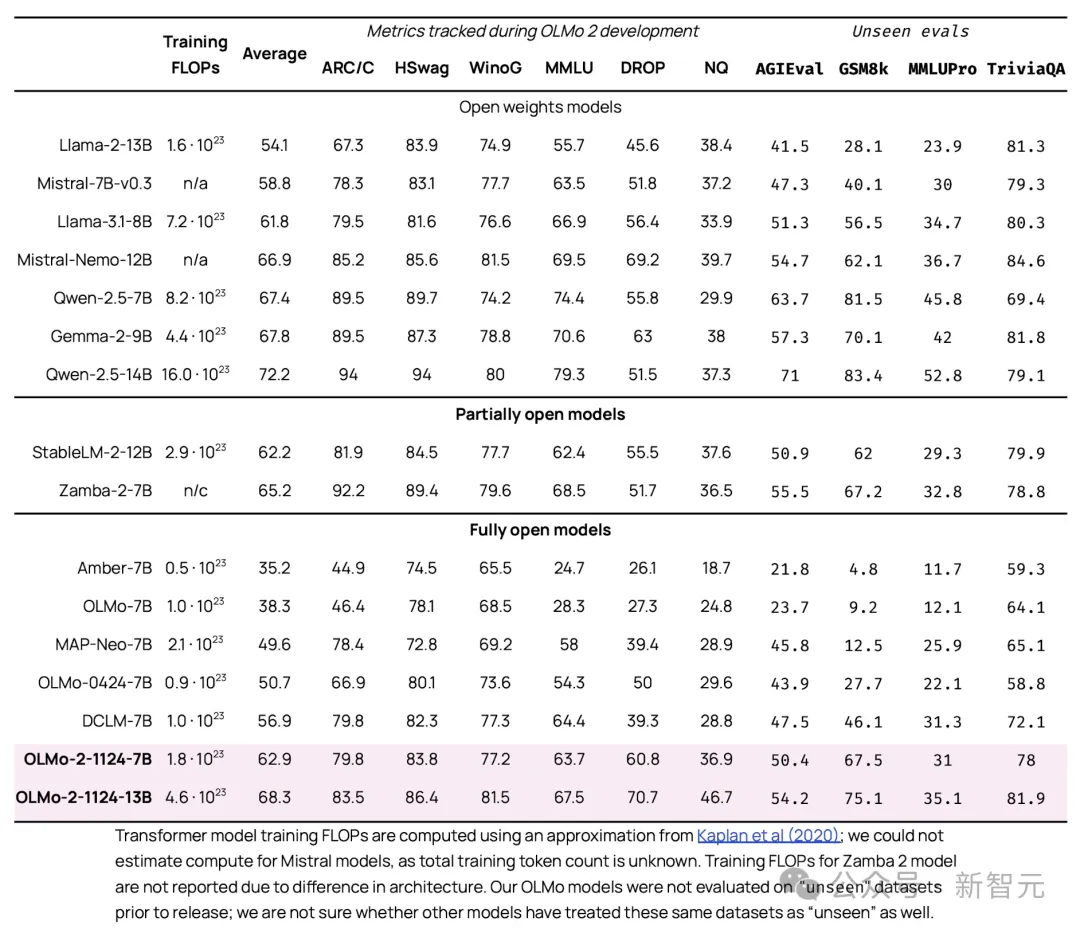

在多個下游任務上,OLMo 2展現(xiàn)出了強大的泛化能力和適應能力。在10個基準上,OLMo-2-13B的性能全面超越了Llama-2-13B,OLMo-2-8B的基準均分也超過了Llama-3.1-8B。

訓練過程全公開

不同于Llama、Qwen這類只開源模型權重的項目,這次AI2也秉持了一貫的開源風格,即不止發(fā)布了訓練好的OLMo 2模型權重,還公開了訓練數(shù)據(jù)、代碼、訓練過程。這無疑為之后的LLM的研究和應用提供了寶貴的資源。

論文地址:https://arxiv.org/pdf/2501.00656

OLMo 2的訓練過程分為3個階段,分別是預訓練、中期訓練和后期的指令調(diào)優(yōu)。預訓練數(shù)據(jù)混合了高質(zhì)量的網(wǎng)頁數(shù)據(jù)、代碼數(shù)據(jù)和學術論文數(shù)據(jù)等。

在預訓練階段,OLMo 2通過多種技術改進了訓練穩(wěn)定性,例如過濾重復的n-gram、使用更好的初始化方法、架構改進和超參數(shù)調(diào)整。這確保了模型在訓練過程中不會出現(xiàn)崩潰或損失激增,從而提高了最終模型的性能。

預訓練使用的高質(zhì)量數(shù)據(jù)集

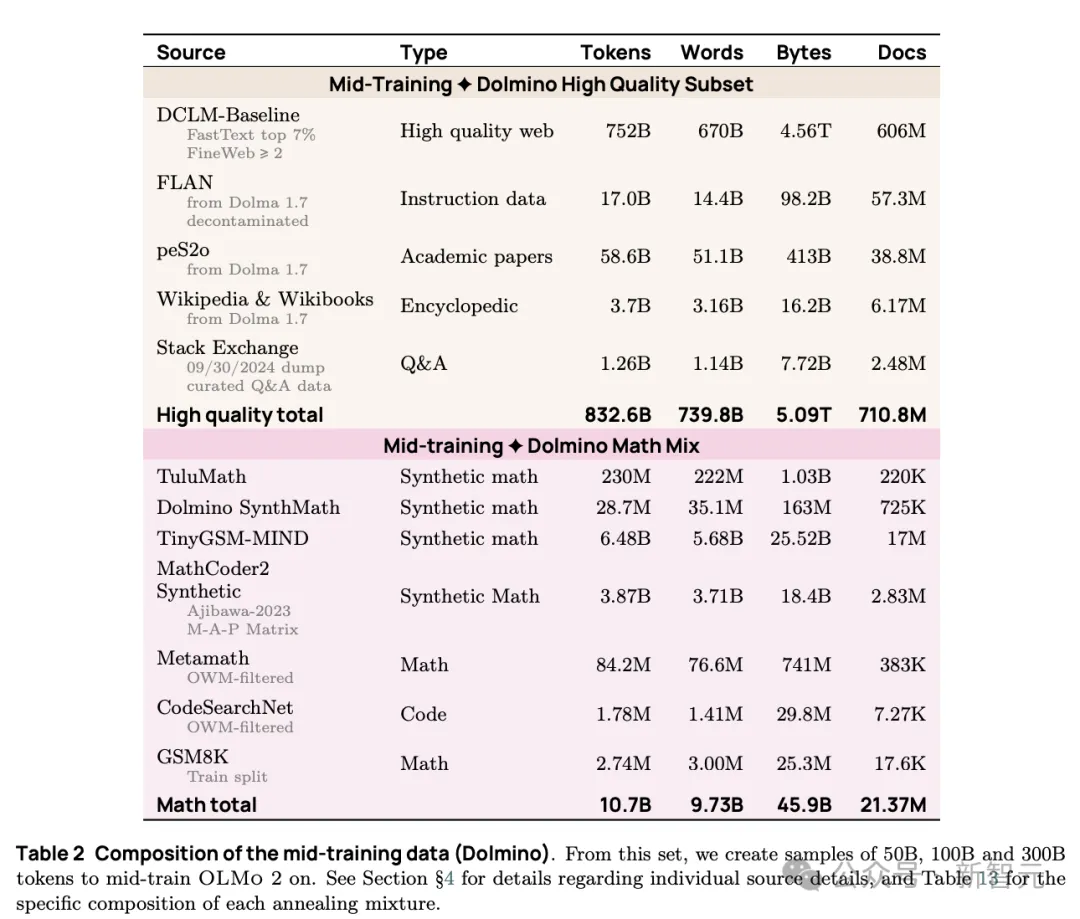

中期訓練階段使用高質(zhì)量的領域特定數(shù)據(jù)(例如數(shù)學數(shù)據(jù)),以及合成數(shù)據(jù),來增強模型的能力,特別是在數(shù)學任務上的表現(xiàn);加上微退火技術評估以及選擇高質(zhì)量的數(shù)據(jù)源,進一步優(yōu)化了中期訓練的效果。

中期訓練使用的高質(zhì)量數(shù)據(jù)集

最后的指令調(diào)優(yōu)階段,研究人員基于Tülu 3的指令調(diào)優(yōu)方法,開發(fā)了OLMo 2-Instruct模型,專注于使用許可數(shù)據(jù),并擴展最終階段的強化學習與可驗證獎勵(RLVR)。

此外,監(jiān)督微調(diào)(SFT)、直接偏好優(yōu)化(DPO)和RLVR等多階段訓練,顯著提高了模型的指令跟隨能力和生成質(zhì)量。

OLMo 2的開源是全方位的,包括所有用于復制和擴展這些模型所需的訓練和評估代碼、數(shù)據(jù)集、模型檢查點、日志及超參數(shù)的選擇等,相比只開源權重,使更多研究人員和開發(fā)者能夠使用和改進這些模型。

通過開源所有組件,OLMo 2促進了對語言模型行為和使用的理解和研究,促進語言模型研究的透明度和可重復性,這些足以成為之后研究所依賴的基礎設施。

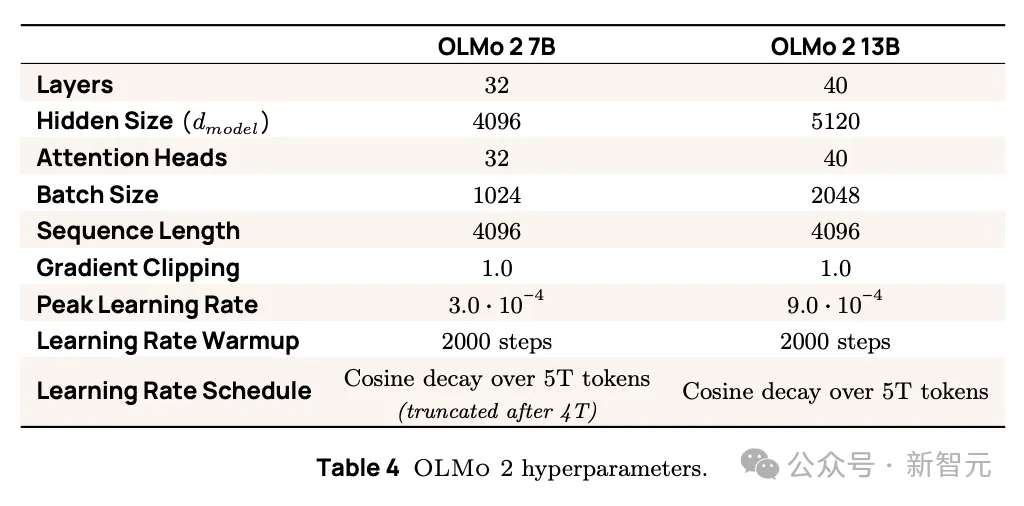

OLMo 2 7B和13B模型的訓練過程中的超參數(shù)

多管齊下造就「低碳」LLM

在大規(guī)模語言模型訓練中,計算資源和環(huán)境影響是不可忽視的因素。Deepseek V3能夠以20分之一的成本進行訓練,而OLMo 2團隊也通過減少主機-設備同步、數(shù)據(jù)預處理、數(shù)據(jù)緩存等多種方法降低了訓練成本,并取得了顯著的成效。

OLMo 2的訓練主要在兩個集群上進行:Jupiter和Augusta。Jupiter集群配備了128個節(jié)點,每個節(jié)點有8張H100,總共1024個GPU;Augusta集群由160個A3 Mega虛擬機組成,每個虛擬機也有8張H100,總共1280個GPU。

OLMo 2的7B模型在4.05萬億token上進行訓練,13B模型在5.6萬億token上進行訓練。訓練時間取決于模型的參數(shù)規(guī)模和訓練數(shù)據(jù)量。

同時為了降低能源消耗,團隊使用水冷系統(tǒng)來降低GPU的溫度和功耗,從而提高訓練效率并降低電力成本。

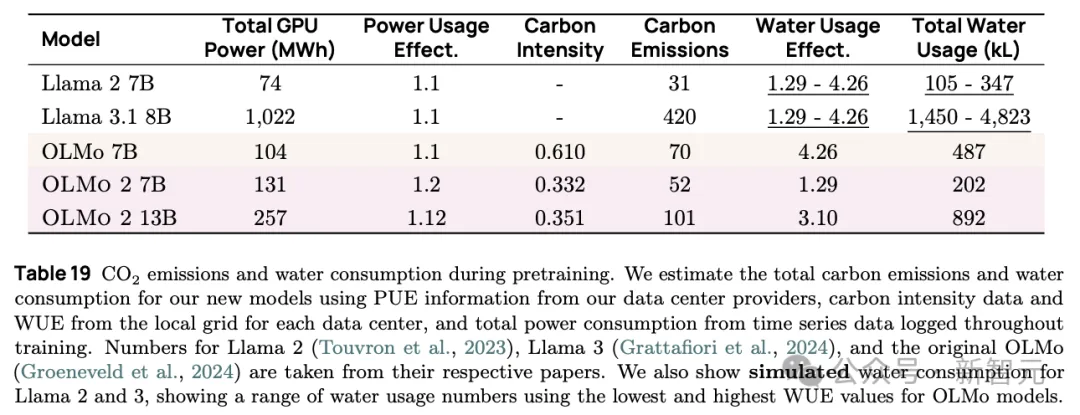

這些措施加在一起,相比訓練同大小的Llama 3.1所消耗的1022MWh電力,OLMo 2 7B訓練過程中總計只消耗了131MWh的電力,相當于只有約10分之一的耗電量,顯著降低了訓練過程消耗的算力,能源及碳足跡。

OLMo 和Llama訓練能耗的對比

OLMo 2的發(fā)布,標志著開源LLM的持續(xù)進步,為相關領域的研究建立一個新生態(tài)系統(tǒng)。在這個生態(tài)系統(tǒng)中,新的訓練方法和技術需要被理解和分享。