2024圖靈獎頒給強化學(xué)習(xí)兩位奠基人!ChatGPT、DeepSeek背后功臣戴上遲來的冠冕

2024年圖靈獎,頒給了強化學(xué)習(xí)之父!

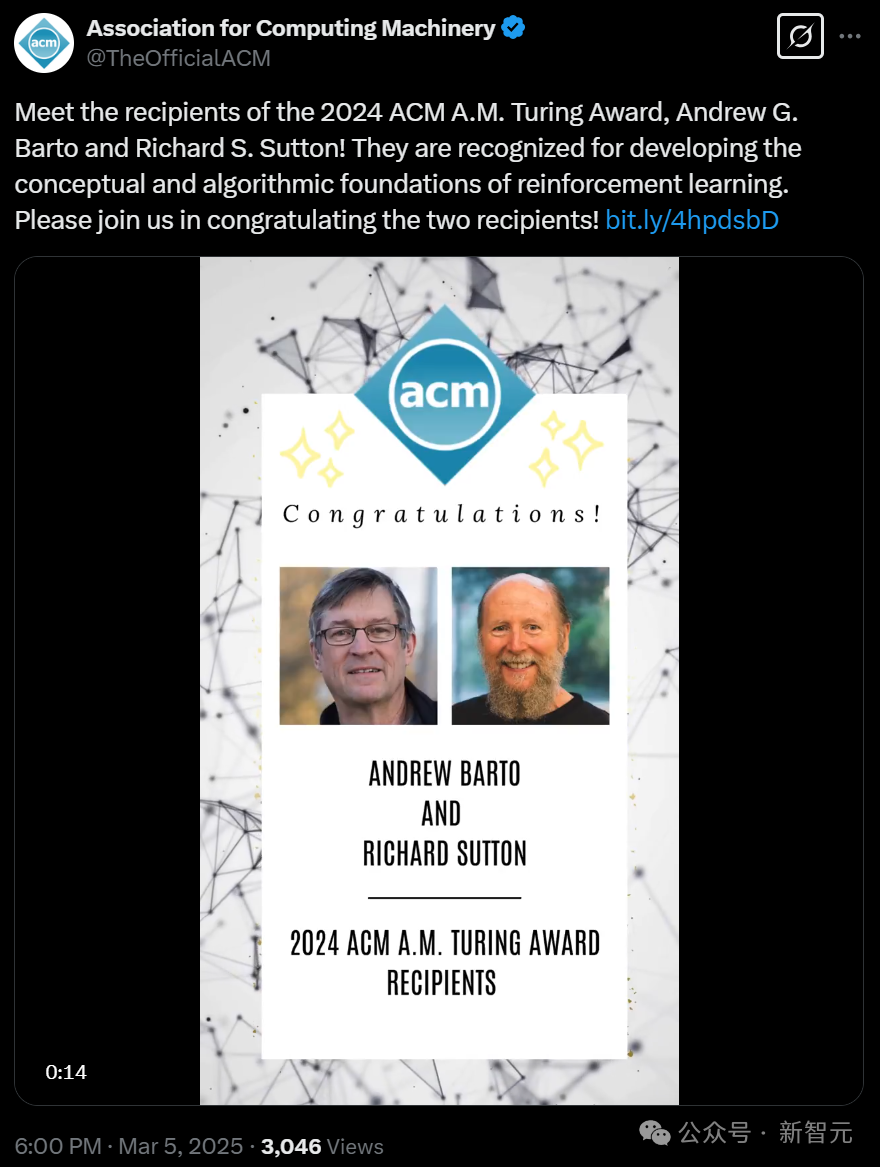

就在剛剛,計算機(jī)學(xué)會ACM宣布:Andrew G. Barto和Richard S. Sutton為2024年ACM圖靈獎獲得者,以表彰他們?yōu)閺娀瘜W(xué)習(xí)奠定了概念和算法基礎(chǔ)。

繼諾貝爾獎之后,AI學(xué)者再次將圖靈獎收歸囊中。

圖片

圖片

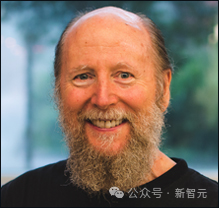

「強化學(xué)習(xí)之父」Richard S. Sutton和他的導(dǎo)師Andrew G. Barto,都為強化學(xué)習(xí)做出了奠基性的貢獻(xiàn)。

從1980年代開始的一系列論文中,二人就引入了強化學(xué)習(xí)的核心理念,構(gòu)建了數(shù)學(xué)基礎(chǔ),并開發(fā)了強化學(xué)習(xí)的關(guān)鍵算法——這是創(chuàng)建智能系統(tǒng)最為重要的方法之一。

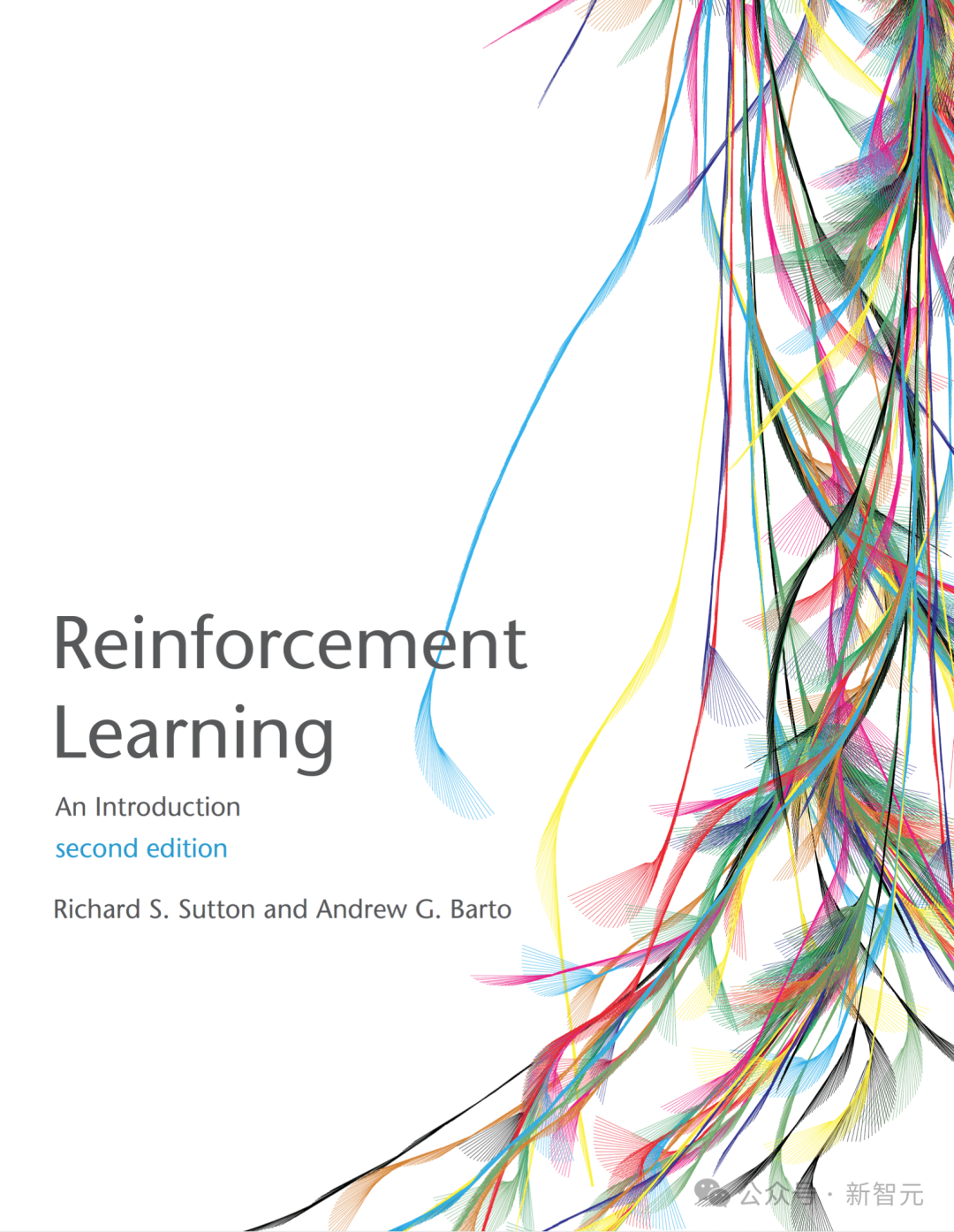

1998年,Sutton和Barto共同撰寫了「Reinforcement Learning: An Introduction」(強化學(xué)習(xí)導(dǎo)論),這本書至今仍被視為該領(lǐng)域的奠基之作。目前,已被引用了超過75,000次。

如今,Barto是馬薩諸塞大學(xué)阿姆赫斯特分校信息與計算機(jī)科學(xué)系的名譽教授。

Sutton是阿爾伯塔大學(xué)計算機(jī)科學(xué)教授,Keen Technologies的首席研究員,以及阿爾伯塔機(jī)器智能研究所(Amii)的特聘研究員。

ACM A.M. 圖靈獎常被譽為「計算機(jī)領(lǐng)域的諾貝爾獎」,獎金高達(dá)100萬美元,由谷歌提供資金支持。該獎項以奠定了計算科學(xué)數(shù)學(xué)理論基礎(chǔ)的英國數(shù)學(xué)家艾倫·圖靈(Alan M. Turing)的名字命名。

得知自己獲得今年圖靈獎的消息時,Sutton感到非常震驚。

就在最近,Sutton才剛發(fā)文引述了圖靈的名言

就在最近,Sutton才剛發(fā)文引述了圖靈的名言

RL之父和他的博導(dǎo)

AI行業(yè)一直努力最大化機(jī)器知識容量。而身處這個行業(yè)的Richard Sutton,長期以來一直在思考一個更為基礎(chǔ)的問題——機(jī)器如何學(xué)習(xí)?

隨著「Reinforcement Learning:An Introduction」的出版,這本強化學(xué)習(xí)領(lǐng)域的「圣經(jīng)」在數(shù)十年后,仍然有著重要的意義。因為這些思想本質(zhì)上看似簡單,卻對更廣泛的AI行業(yè)產(chǎn)生著持續(xù)的影響。

Reinforcement Learning: Summary and Review | Bill Mei

Reinforcement Learning: Summary and Review | Bill Mei

Sutton這樣解釋他的研究方法:研究必須從小處著手;這種基礎(chǔ)研究,不會立即為最新技術(shù)帶來明顯的改進(jìn)。

早在1978年,二人便開始合作。

當(dāng)時,Sutton正在馬薩諸塞大學(xué)阿默斯特分校攻讀博士學(xué)位,而他的導(dǎo)師正是Barto。隨后,Sutton又跟著Barto完成了博士后研究。

他們編寫了一些最早的RL算法,就像人類或機(jī)器學(xué)習(xí)的方式一樣,讓機(jī)器通過反復(fù)試錯獲取知識。

圖片

圖片

雖然Sutton由此贏得了學(xué)術(shù)界的贊譽,但在某種程度上,卻讓他跟谷歌、微軟、OpenAI等大公司構(gòu)建的LLM所代表主流理論,產(chǎn)生了分歧。

在他看來,這些技術(shù)只是在模仿人類行為,并未真正認(rèn)識到自己的行動,并且從中學(xué)習(xí)——

我認(rèn)為它們并不在通往AGI的正確道路上。

強化學(xué)習(xí)的核心,是確保機(jī)器「從經(jīng)驗中學(xué)習(xí)」,或者理解反饋并從錯誤中學(xué)習(xí)。

然而,LLM是從海量歷史數(shù)據(jù)中提取信息來生成回應(yīng)的,所以它們的智能程度也僅僅與其神經(jīng)網(wǎng)絡(luò)在給定時間的規(guī)模相當(dāng)。

因此,LLM天然就有一種「愚蠢的弱點」。雖然可以調(diào)整對書面問題的回答,但它們的主要目標(biāo),僅僅是確定文本鏈中的下一個輸出而已。

對于如今的許多AI系統(tǒng),Sutton都評價為「在于你互動時完全不會學(xué)習(xí)」。

比如在他看來,ChatGPT就不會根據(jù)自己的經(jīng)驗改變?nèi)魏螜?quán)重;它對結(jié)果漠不關(guān)心,也真正缺乏認(rèn)知;它對發(fā)生的任何事都不會驚訝,因為它本來對于發(fā)生的事就沒有任何預(yù)期。

圖片

圖片

Sutton的谷歌DeepMind前同事Michael Bowling如此評價他——

當(dāng)世界其他地方都在追逐大語言模型應(yīng)用時,Rich仍在堅守基礎(chǔ)研究的陣地。

在以后,當(dāng)人們希望看到能真正和人類互動的AI系統(tǒng),他們可能會意識到,Sutton對強化學(xué)習(xí)的貢獻(xiàn)是多么意義重大。

而且在過去五年中,RL也越來越被重視。引起全球轟動的DeepSeek,就是用RL通過正反饋循環(huán)來訓(xùn)練AI的。

在阿爾伯塔機(jī)器智能研究所(Amii)負(fù)責(zé)人Cam Linke看來,Sutton是一位為人謙遜、不事張揚的專業(yè)人士。他摒棄了科學(xué)領(lǐng)域常見的傳統(tǒng)等級制度或政治因素,對他來說科學(xué)過程才是關(guān)鍵所在。

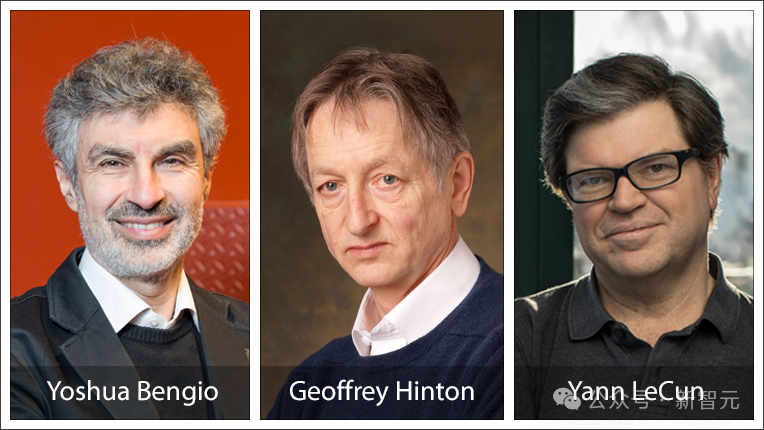

繼Geoffrey Hinton和Yoshua Bengio在2018年與Yann LeCun一起因?qū)ι疃壬窠?jīng)網(wǎng)絡(luò)研究的貢獻(xiàn)獲獎后,Sutton是最新一位獲得圖靈獎的加拿大研究者。

他表示,自己將自己看作是一個強化學(xué)習(xí)智能體,通過經(jīng)驗在各個層面學(xué)習(xí),比如踢到腳趾后調(diào)整走路的方式,或者接受一份工作,從中獲得樂趣。

圖片

圖片

什么是強化學(xué)習(xí)?

AI領(lǐng)域通常關(guān)注于構(gòu)建AI智能體——即能夠感知和行動的實體。

更智能的AI智能體能夠選擇更好的行動方案。因此,知道哪些行動方案更好對AI至關(guān)重要。

獎勵——這一借用自心理學(xué)和神經(jīng)科學(xué)的術(shù)語——表示一個提供給AI智能體與其行為質(zhì)量相關(guān)的信號。

強化學(xué)習(xí)(RL)就是在這種獎勵信號的引導(dǎo)下學(xué)習(xí)找到更好行動方案的過程。

從獎勵中學(xué)習(xí)的理念對于動物訓(xùn)練師來說已經(jīng)存在了數(shù)千年。

后來,艾倫·圖靈(Alan Turing)在1950年的論文《計算機(jī)器與智能》中探討了「機(jī)器能思考嗎?」這一問題,并提出了一種基于獎勵和懲罰的機(jī)器學(xué)習(xí)方法。

雖然圖靈稱他曾進(jìn)行一些初步實驗,而且Arthur Samuel在1950年代后期開發(fā)了一個能通過自我對弈進(jìn)行學(xué)習(xí)的跳棋程序,但在隨后的幾十年里,AI的這一研究方向幾乎沒有取得任何進(jìn)展。

到了1980年代初,受到心理學(xué)觀察的啟發(fā),Barto和他的博士生Sutton開始將強化學(xué)習(xí)構(gòu)建為一個通用問題框架。

他們借鑒了馬爾可夫決策過程(MDP)提供的數(shù)學(xué)基礎(chǔ),在這個過程中,AI智能體在具有隨機(jī)性的環(huán)境中做出決策,在每次狀態(tài)轉(zhuǎn)換后接收獎勵信號,目的是將長期累積的獎勵最大。

與標(biāo)準(zhǔn)MDP理論假設(shè)AI智能體已知MDP的所有信息不同,強化學(xué)習(xí)框架允許環(huán)境和獎勵是未知的。

強化學(xué)習(xí)的信息需求最小,結(jié)合MDP框架的通用性,使得強化學(xué)習(xí)算法可以應(yīng)用于廣泛的問題領(lǐng)域。

Barto和Sutton,無論是合作還是與其他研究者協(xié)作,都開發(fā)出了許多強化學(xué)習(xí)的基本算法。

包括他們最重要的貢獻(xiàn)——時間差分學(xué)習(xí),它在解決獎勵預(yù)測問題方面取得了重要突破,此外還有策略梯度方法和將神經(jīng)網(wǎng)絡(luò)作為表示學(xué)習(xí)函數(shù)的工具的使用。

他們還提出了結(jié)合學(xué)習(xí)和規(guī)劃的AI智能體設(shè)計,證明了將環(huán)境知識作為規(guī)劃基礎(chǔ)的價值。

正如前文提到的,「Reinforcement Learning: An Introduction」這本書使數(shù)千名研究人員能夠理解并為這一領(lǐng)域做出貢獻(xiàn),更重要的是,它還在繼續(xù)激發(fā)當(dāng)今計算機(jī)科學(xué)中的許多重要研究活動。

盡管Barto和Sutton的算法是幾十年前開發(fā)的,但在過去十五年中,通過與深度學(xué)習(xí)算法(由2018年圖靈獎獲得者Bengio、Hinton和LeCun開創(chuàng))相結(jié)合,強化學(xué)習(xí)的實際應(yīng)用取得了重大突破——深度強化學(xué)習(xí)技術(shù)。

圖片

圖片

強化學(xué)習(xí)最引人注目的例子是AlphaGo計算機(jī)程序在2016年和2017年戰(zhàn)勝世界頂尖人類圍棋選手。

近幾年的另一個重大成就是聊天機(jī)器人ChatGPT的出現(xiàn)。

ChatGPT是一個LLM,其訓(xùn)練分為兩個階段,第二階段采用了一種稱為基于人類反饋的強化學(xué)習(xí)(RLHF)技術(shù),以更好地捕捉人類的期望和偏好。

強化學(xué)習(xí)在許多其他領(lǐng)域也取得了顯著成功。

一個備受矚目的研究案例是機(jī)器人在手中操作和解決物理(魔方)問題的運動技能學(xué)習(xí),這表明完全在模擬中進(jìn)行強化學(xué)習(xí),最終也可能在顯著不同的現(xiàn)實世界中取得成功。

圖片

圖片

其他的應(yīng)用領(lǐng)域包括網(wǎng)絡(luò)擁塞控制、芯片設(shè)計、互聯(lián)網(wǎng)廣告、優(yōu)化算法、全球供應(yīng)鏈優(yōu)化、提升聊天機(jī)器人的行為和推理能力,甚至改進(jìn)計算機(jī)科學(xué)中最古老的問題之一的矩陣乘法算法。

最后,這項部分受到神經(jīng)科學(xué)啟發(fā)的技術(shù)也反過來回饋了神經(jīng)科學(xué)。最近的研究,包括Barto的工作,表明人工智能中開發(fā)的特定強化學(xué)習(xí)算法,為有關(guān)人類大腦中多巴胺系統(tǒng)的大量發(fā)現(xiàn)提供了最佳解釋。

獲獎人介紹

Andrew Barto

Andrew Barto是馬薩諸塞大學(xué)阿默斯特分校信息與計算機(jī)科學(xué)系榮譽退休教授。是IEEE和AAAS的Fellow。

Barto于1970年從密歇根大學(xué)獲得數(shù)學(xué)學(xué)士學(xué)位。在閱讀了Michael Arbib and McCulloch和Pitts的作品后,他對利用計算機(jī)和數(shù)學(xué)來模擬大腦產(chǎn)生了興趣,五年后因一篇關(guān)于元胞自動機(jī)的論文獲得了該校的計算機(jī)科學(xué)博士學(xué)位。

他于1977年作為博士后研究員開始在馬薩諸塞大學(xué)阿默斯特分校的職業(yè)生涯,此后曾擔(dān)任多個職位,包括副教授、教授和系主任。

此前,他曾獲得包括馬薩諸塞大學(xué)神經(jīng)科學(xué)終身成就獎、IJCAI研究卓越獎和IEEE神經(jīng)網(wǎng)絡(luò)學(xué)會先驅(qū)獎在內(nèi)的眾多獎項。

Richard Sutton

Richard Sutton是阿爾伯塔大學(xué)計算機(jī)科學(xué)教授,Keen Technologies的研究科學(xué)家,以及阿爾伯塔機(jī)器智能研究所(Amii)的首席科學(xué)顧問。是AAAI、英國皇家學(xué)會和加拿大皇家學(xué)會的Fellow。

在2017年至2023年期間,他曾擔(dān)任DeepMind的杰出研究科學(xué)家。

在加入阿爾伯塔大學(xué)之前,他于1998年至2002年在AT&T香農(nóng)實驗室AI部門擔(dān)任首席技術(shù)專家。

Sutton獲得了斯坦福大學(xué)心理學(xué)學(xué)士學(xué)位,并在馬薩諸塞大學(xué)阿默斯特分校獲得計算機(jī)與信息科學(xué)的碩士和博士學(xué)位。

Sutton獲得的榮譽包括國際AI聯(lián)合會研究卓越獎、加拿大AI協(xié)會終身成就獎和馬薩諸塞大學(xué)阿默斯特分校杰出研究成就獎。

參考資料:

https://awards.acm.org/turing