Agent遇見(jiàn)圖譜,檢索能力大幅提升

https://arxiv.org/pdf/2511.18194

agent-as-a-Graph: Knowledge Graph-Based Tool and Agent Retrieval for LLM Multi-Agent Systems一、落腳點(diǎn)在哪?

1.1 背景:多智能體系統(tǒng)正從“玩具”走向“生產(chǎn)線”

- 隨著 GPT-4、Claude3 等 LLM 成熟,業(yè)界流行把“一個(gè)通用大模型”拆成“一群專(zhuān)業(yè)小代理”:

代碼代理、SQL 代理、財(cái)務(wù)代理、合規(guī)代理……

每個(gè)代理又外掛十幾個(gè)到上千個(gè) MCP(Model Context Protocol)工具/函數(shù)。

- 結(jié)果:一次用戶提問(wèn)可能觸發(fā) 100+ 代理 × 1000+ 工具 = 10 萬(wàn)級(jí)別“候選技能包”。

核心矛盾:如何 1 秒內(nèi)把 query 路由到“最會(huì)干這活兒的代理 + 工具”?

1.2 已有方案為什么不夠用?

流派 | 典型做法 | 致命短板 |

Agent-Only | 只拿“代理簡(jiǎn)介”做向量檢索 | 代理描述一句“我懂金融”——到底會(huì)啥?隱藏了 100 個(gè)工具細(xì)節(jié),經(jīng)常漏掉關(guān)鍵能力。 |

Tool-Only | 把每個(gè)工具當(dāng)獨(dú)立文檔檢索 | 找到了“查匯率”工具,卻忽略它藏在“外匯交易代理”里——需要密鑰、上下文、多步流程,孤立工具根本跑不通。 |

拼接派 | 把“代理+工具”文本直接拼長(zhǎng)向量 | 多跳查詢(xún)時(shí)語(yǔ)義漂移;長(zhǎng)文本向量稀釋?zhuān)琑ecall 雪崩。 |

一句話總結(jié):“代理層”與“工具層”被粗暴地二選一,導(dǎo)致粗粒度誤選或細(xì)粒度失聯(lián)。

二、Agent-as-a-Graph 是什么?

圖片

圖片

核心思想:別再二選一,把代理和工具同時(shí)“落圖”——

- 節(jié)點(diǎn):代理節(jié)點(diǎn) A + 工具節(jié)點(diǎn) T

- 邊:own(T)=A,一條“屬于”關(guān)系

- 統(tǒng)一向量空間:A/T 共用同一個(gè) embedding 索引

- 檢索時(shí):先向量召回,再“順著邊”把工具歸并到父代理,保證最終返回的是可執(zhí)行的代理集合。

官方 Slogan:“Agent-as-a-Graph = 知識(shí)圖譜 RAG + 類(lèi)型感知加權(quán)排序 + 圖遍歷歸約”

三、技術(shù)拆解:三步走流程

3.1 建圖 & 索引(離線)

- 解析所有 MCP 服務(wù)器清單 → 抽取 (代理名, 代理描述, 工具列表)

- 構(gòu)建二部圖 G=(A∪T, E):

- A 節(jié)點(diǎn)存“代理描述”

- T 節(jié)點(diǎn)存“工具名+工具描述”

- 邊 E 為“擁有”關(guān)系,可存儲(chǔ)在 Neo4j、Amazon Neptune 等標(biāo)準(zhǔn)圖庫(kù)

- 把 A、T 節(jié)點(diǎn)文本統(tǒng)一送進(jìn)同一個(gè) bi-encoder 得到向量,寫(xiě)入一個(gè)混合索引(向量+圖)

→ 至此,代理與工具被當(dāng)成“同等公民”可一起檢索, yet 血緣關(guān)系仍在圖里。

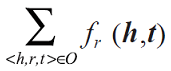

3.2 在線檢索(算法 1 濃縮版)

輸入:用戶 query q

① 向量 TOP-N:從混合索引里拿 N 個(gè)最相關(guān)節(jié)點(diǎn)(A 或 T)

② Type-specific wRRF 重排:

- 對(duì)每條候選 e,如果是工具,分母 k+rank 乘 α_T;如果是代理,乘 α_A

- 作者實(shí)驗(yàn)最優(yōu) α_A : α_T = 1.5 : 1(輕微偏向代理,提升穩(wěn)定性)

③ 圖遍歷歸約:

- 遍歷重排后列表,遇到工具就沿著 own(·) 邊找爹代理

- 保留前 K 個(gè)不重復(fù)代理作為最終答案,保證“可執(zhí)行”

復(fù)雜 query 可先做“步驟分解”(step-wise querying),每步獨(dú)立走上述流程,跨步可換代理。

3.3 關(guān)鍵創(chuàng)新點(diǎn)

模塊 | 創(chuàng)新 | 效果 |

知識(shí)圖譜雙節(jié)點(diǎn) | 首次把 A/T 同時(shí)作為一等節(jié)點(diǎn) | 既保留工具細(xì)粒度,又不丟代理上下文 |

類(lèi)型感知 wRRF | 按“節(jié)點(diǎn)類(lèi)型”而非“檢索方法”給權(quán)重 | 無(wú)需訓(xùn)練,可解釋旋鈕 α_A/α_T |

圖歸約 | 保證最終輸出的是“代理”而非散落工具 | 下游系統(tǒng)直接拿到可調(diào)用實(shí)體 |

四、實(shí)驗(yàn):數(shù)字說(shuō)話

圖片

圖片

數(shù)據(jù)集:LiveMCPBench

- 70 個(gè)真實(shí) MCP 服務(wù)器、527 個(gè)工具

- 95 條人工標(biāo)注多跳問(wèn)題,平均 2.68 步、2.82 工具、1.4 代理

指標(biāo):Recall@K / mAP@K / nDCG@K

主結(jié)果(OpenAI ada-002,K=5)

方法 | Recall@5 | nDCG@5 | 相對(duì)提升 |

最強(qiáng)基線 ScaleMCP | 0.74 | 0.40 | — |

Agent-as-a-Graph(無(wú)權(quán)重) | 0.83 | 0.46 | +12% / +15% |

+ 最優(yōu)權(quán)重 (α_A=1.5) | 0.85 | 0.47 | +14.9% / +17.5% |

跨編碼器穩(wěn)健性:

用 8 款 embedding(VertexAI、Amazon Titan、OpenAI 3-large、all-MiniLM…)重復(fù)實(shí)驗(yàn),Recall@5 方差僅 0.02,全部>0.80,證明結(jié)構(gòu)紅利遠(yuǎn)大于編碼器差異。

圖片

圖片

消融:

- 去掉圖遍歷 → Recall 掉 7%

- 極端 α_A=3 → Recall 掉 9%

- 極端 α_T=3 → Recall 掉 5%

→ 再次驗(yàn)證“輕微代理偏向 + 圖歸約”是甜點(diǎn)區(qū)。

五、對(duì)開(kāi)發(fā)者的啟示

1.別再硬拼長(zhǎng)文本

把“代理介紹+工具清單”一股腦塞進(jìn)同一個(gè)向量,看似簡(jiǎn)單,實(shí)則稀釋語(yǔ)義。拆節(jié)點(diǎn)、建圖、再歸并,Recall 直接+10~15%。

2.類(lèi)型權(quán)重 = 免費(fèi)午餐

wRRF 無(wú)訓(xùn)練、可解釋?zhuān)瑑蓷l超參 α_A、α_T 就能讓系統(tǒng)“傾向大局”或“傾向細(xì)節(jié)”。線上遇到新領(lǐng)域,先網(wǎng)格搜索 30 分鐘,一般就能提幾個(gè)點(diǎn)。

3.圖數(shù)據(jù)庫(kù)不是“重型”玩具

作者用 Neo4j 存儲(chǔ)區(qū)區(qū) 70 服務(wù)器 + 527 工具,毫秒級(jí)遍歷。對(duì)于企業(yè)已有 KG 團(tuán)隊(duì),直接把 MCP 清單導(dǎo)成 csv,LOAD CSV 1 小時(shí)即可上線。

4.與 Orchestration 框架天然互補(bǔ)

LangGraph、AutoGen、CrewAI 等負(fù)責(zé)“讓代理怎么協(xié)作”;Agent-as-a-Graph 回答“到底叫哪幾個(gè)代理來(lái)協(xié)作”。兩者拼接,即可形成“檢索-編排-執(zhí)行”閉環(huán)。

六、局限與未來(lái)

- 動(dòng)態(tài)工具發(fā)現(xiàn):當(dāng)前圖是靜態(tài)的,代理運(yùn)行期若動(dòng)態(tài)注冊(cè)新工具,需要增量寫(xiě)圖。

- 權(quán)重自適應(yīng):α_A/α_T 仍靠網(wǎng)格搜索,下一步可讓 LLM 根據(jù) query 語(yǔ)義自動(dòng)預(yù)測(cè)權(quán)重。

- 多語(yǔ)言 & 多模態(tài):實(shí)驗(yàn)僅用英文文本,工具參數(shù)、返回結(jié)構(gòu)等異構(gòu)信息尚未編碼進(jìn)節(jié)點(diǎn)。

- 超大規(guī)模:百萬(wàn)級(jí)代理 × 千萬(wàn)級(jí)工具時(shí),向量+圖混合索引如何分片、如何分布式遍歷,仍是開(kāi)放問(wèn)題。

七、一句話收個(gè)尾

Agent-as-a-Graph 用“一張圖”把“誰(shuí)能干啥”說(shuō)得清清楚楚:工具不再隱身,代理不再背鍋,檢索一次到位,多智能體終于可 scale 到生產(chǎn)級(jí)。

如果你正在搭建“大模型+工具”的落地系統(tǒng),不妨給候選池加一張圖——14.9% 的 Recall 提升,可能比你換更大的模型來(lái)得便宜得多。