最新研究提出混合動態剪枝方法,升級Transformer推理效率 精華

自2017年Transformer模型問世以來,它在自然語言處理(NLP)和計算機視覺等領域取得了顯著進展。Transformer模型通過其獨特的自注意力機制,能夠捕捉輸入序列中的長程依賴關系,從而在機器翻譯、文本分類、問答系統等任務中表現出色。與傳統的循環神經網絡(RNN)和長短期記憶網絡(LSTM)相比,Transformer模型在處理長序列數據時具有更高的效率和準確性。

Transformer模型的成功也帶來了新的挑戰,由于其復雜的計算結構和高內存需求,Transformer模型在實際應用中,尤其是在資源受限的邊緣設備上部署時,面臨著巨大的困難。為了克服這些挑戰,研究人員不斷探索新的方法來提高Transformer模型的推理效率,同時保持其高性能。

Transformer模型的主要挑戰在于其計算復雜度和內存需求。具體來說Transformer模型的自注意力機制需要計算輸入序列中每個元素與其他所有元素之間的關系,這導致計算復雜度為隨著輸入序列長度的增加,計算成本和內存需求呈指數增長。此外Transformer模型的前饋神經網絡(FFN)部分也需要大量的計算資源。FFN由兩個全連接層組成,使用GELU作為激活函數,提供非線性變換。這些計算操作在實際應用中會占用大量的計算時間和內存,尤其是在處理長序列數據時。

為了在資源受限的環境中高效部署Transformer模型,研究人員提出了多種優化方法,包括模型剪枝、量化、稀疏化等。然而,這些方法在實際應用中仍然面臨許多挑戰,例如如何在不顯著降低模型性能的情況下實現高效的剪枝和稀疏化。

7 月 20 日發表于著名國際學術交流平臺arXiv的論文《Hybrid Dynamic Pruning: A Pathway to Efficient Transformer Inference》提出了一種名為混合動態剪枝(Hybrid Dynamic Pruning, HDP)的算法-架構協同設計方法,旨在通過剪枝不重要的計算單元和近似計算來提高Transformer模型的推理效率。HDP方法結合了塊剪枝、頭剪枝和近似計算,通過動態調整剪枝策略,實現了高效的計算和內存利用。

HDP方法包括以下幾個方面的創新:

- 基于整數的行平衡塊剪枝:通過剪除注意力矩陣中不重要的塊,減少計算復雜度和內存訪問。

- 基于整數的頭剪枝:在計算初期評估頭的重要性,剪除不重要的注意力頭。

- 近似計算:通過生成分數部分并將其與剪枝后的整數結果相加,得到最終輸出,減少計算量。

- ASIC 架構:以高效執行 HDP,利用僅編碼器模型將關鍵路徑減少一半,并提高吞吐量和硬件利用率。可用作協處理器,與現有的神經網絡加速器兼容。通過精心設計的管道和架構優化,顯著提高性能并降低能耗。

此外論文還設計并實現了兩種協處理器架構(HDP-Edge和HDP-Server),用于在移動和服務器平臺上加速HDP算法。這些創新方法和硬件設計顯著提高了Transformer模型的推理效率,為在資源受限環境中部署高性能Transformer模型提供了新的途徑。

這篇論文的研究團隊由多位在電子工程和計算機科學領域具有豐富經驗的學者組成,Ghadeer A. Jaradat的研究方向包括深度學習和硬件加速器設計;Mohammed F. Tolba專注于算法優化和高效計算;Ghada Alsahli在機器學習和數據處理方面有深入研究;Hani Saleh是IEEE會員,研究領域涵蓋嵌入式系統和硬件設計;Mahmoud Al-Qutayri也是IEEE會員,專注于電子系統和計算架構;Thanos Stouraitis是IEEE終身會士,擁有豐富的數字信號處理和計算機架構經驗;Baker Mohammad是IEEE會員,研究方向包括硬件加速器和高效計算。這個團隊結合了算法優化和硬件設計的專業知識,致力于提高Transformer模型的推理效率。通過他們的共同努力,論文提出的HDP方法為高效Transformer推理提供了新的解決方案。

Transformer模型概述

Transformer模型迅速成為自然語言處理(NLP)和計算機視覺等領域的主流模型,主因是其獨特的架構設計使其在處理長序列數據時表現出色。Transformer模型由編碼器(Encoder)和解碼器(Decoder)兩部分組成,每部分又由多個Transformer塊(Transformer Block)堆疊而成。

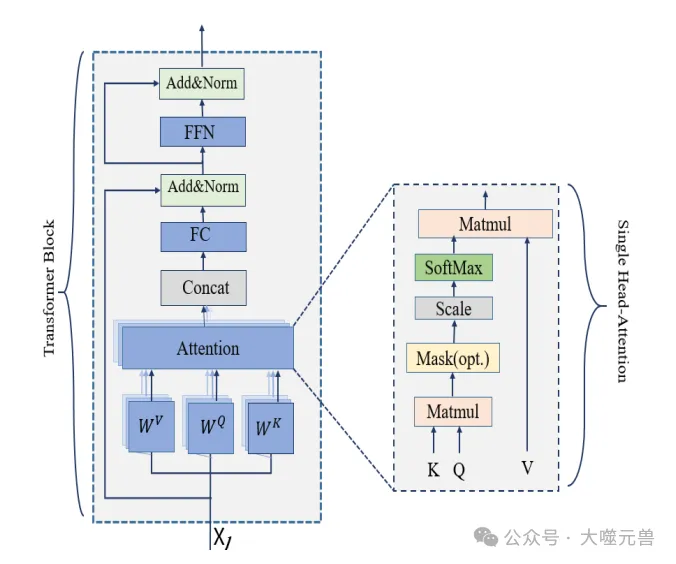

圖 1:Transformer區塊

每個Transformer塊包含以下幾個主要組件:

- 多頭自注意力機制(Multi-Head Self-Attention):這是Transformer的核心組件,用于捕捉輸入序列中各個元素之間的關系。

- 前饋神經網絡(Feed Forward Neural Network, FFN):用于對每個位置的表示進行進一步的非線性變換。

- 歸一化層(Normalization Layer):用于穩定和加速訓練過程。

編碼器和解碼器的結構相似,但在功能上有所不同。編碼器的主要任務是將輸入序列轉換為一組連續的表示,而解碼器則根據這些表示生成輸出序列。在實際應用中,編碼器和解碼器可以堆疊多個層,以提高模型的表達能力。

自注意力機制是Transformer模型的核心創新之一。它通過計算輸入序列中每個元素與其他所有元素之間的關系,來捕捉長程依賴關系。具體來說自注意力機制包括以下幾個步驟:

- 輸入嵌入(Input Embedding):將輸入序列中的每個元素轉換為一個向量表示。

- 查詢、鍵和值(Query, Key, Value):將輸入嵌入分別映射到查詢(Q)、鍵(K)和值(V)三個向量空間。映射過程通過三個不同的權重矩陣實現。

- 計算注意力分數(Attention Scores):通過計算查詢向量與鍵向量的點積,得到注意力分數矩陣。點積結果再除以向量維度的平方根進行縮放,以避免點積值過大。

- 應用Softmax函數:對注意力分數矩陣的每一行應用Softmax函數,得到注意力權重矩陣。Softmax函數將分數轉換為概率分布,使得每一行的權重和為1。

- 加權求和:將注意力權重矩陣與值向量相乘,得到加權求和結果。這個結果代表了輸入序列中每個元素對其他所有元素的加權平均。

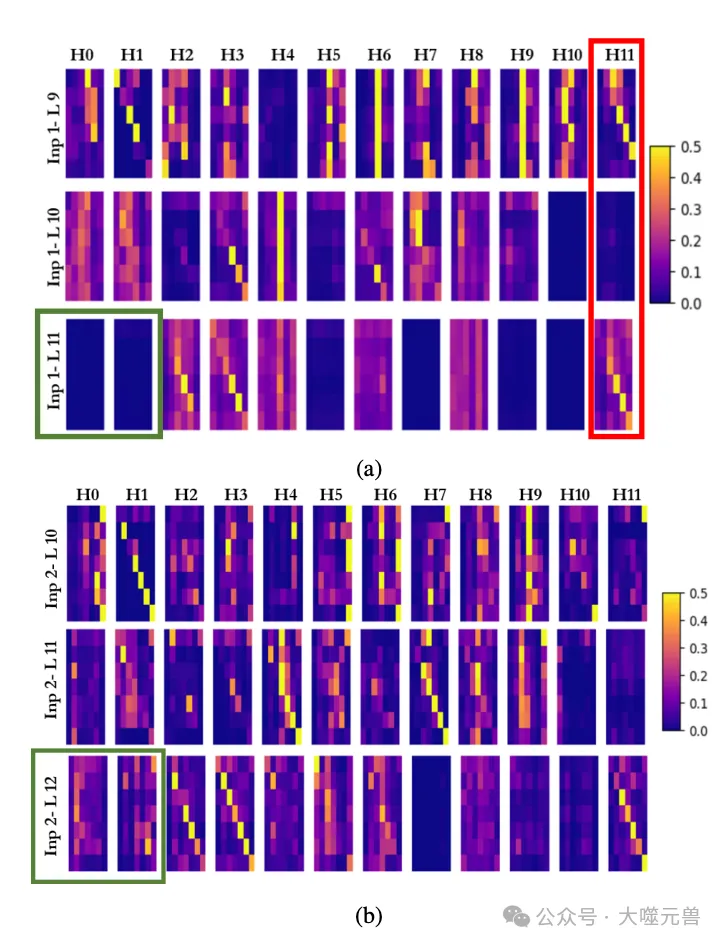

圖2:BERT-Base 模型中針對 (a) 輸入 1、(b) 輸入 2 的注意力概率分析。紅色框表示同一輸入在不同層(第 9、10 和 11 層)的單個頭部(Head11)的注意力概率變化。綠色框突出顯示了同一頭部和具有兩個不同輸入的層之間的注意力概率對比。第 11 層的頭部 0 和頭部 1 對于輸入 1 顯示較低的值,而同一層的頭部 1 和頭部 2 對于輸入 2 顯示明顯較高的值。

多頭自注意力機制通過并行計算多個不同的注意力頭(Attention Heads),使模型能夠捕捉到輸入序列中不同層次的關系。每個注意力頭獨立計算注意力分數,并將結果拼接在一起,經過線性變換后得到最終的輸出。

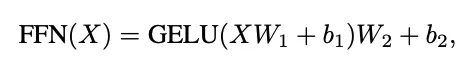

前饋神經網絡(FFN)是Transformer塊中的另一個重要組件。它由兩個全連接層(Fully Connected Layers)組成,負責對每個位置的表示進行進一步的非線性變換。FFN的具體計算過程如下:

其中,X表示輸入向量,W1和W2是權重矩陣,b1和b2是偏置向量,GELU是高斯誤差線性單元(Gaussian Error Linear Unit)激活函數。

FFN的作用主要有以下幾點:

- 非線性變換:通過GELU激活函數,FFN引入了非線性變換,使模型能夠捕捉到更復雜的特征。

- 特征提取:通過兩個全連接層的線性變換,FFN能夠提取輸入向量中的高維特征。

- 位置獨立處理:FFN對每個位置的表示進行獨立處理,不依賴于其他位置的上下文信息。這使得FFN能夠并行處理輸入序列中的所有位置,提高計算效率。

Transformer模型通過自注意力機制和前饋神經網絡的結合,能夠高效地處理長序列數據,并在多種任務中取得了優異的性能。然而Transformer模型的高計算復雜度和內存需求也帶來了實際應用中的挑戰。論文提出的混合動態剪枝方法,旨在通過剪枝不重要的計算單元和近似計算,顯著提高Transformer模型的推理效率,為在資源受限環境中部署高性能Transformer模型提供了新的解決方案。

混合動態剪枝(HDP)方法

混合動態剪枝(Hybrid Dynamic Pruning, HDP)是一種算法-架構協同設計方法,旨在通過剪枝不重要的計算單元和近似計算來提高Transformer模型的推理效率。HDP方法結合了塊剪枝、頭剪枝和近似計算,通過動態調整剪枝策略,實現了高效的計算和內存利用。具體來說,HDP方法包括以下幾個方面的創新。

- 基于整數的行平衡塊剪枝:通過剪除注意力矩陣中不重要的塊,減少計算復雜度和內存訪問。

- 基于整數的頭剪枝:在計算初期評估頭的重要性,剪除不重要的注意力頭。

- 近似計算:通過生成分數部分并將其與剪枝后的整數結果相加,得到最終輸出,減少計算量。

這些方法在不顯著降低模型性能的情況下,實現了高效的剪枝和稀疏化,從而顯著提高了Transformer模型的推理效率。

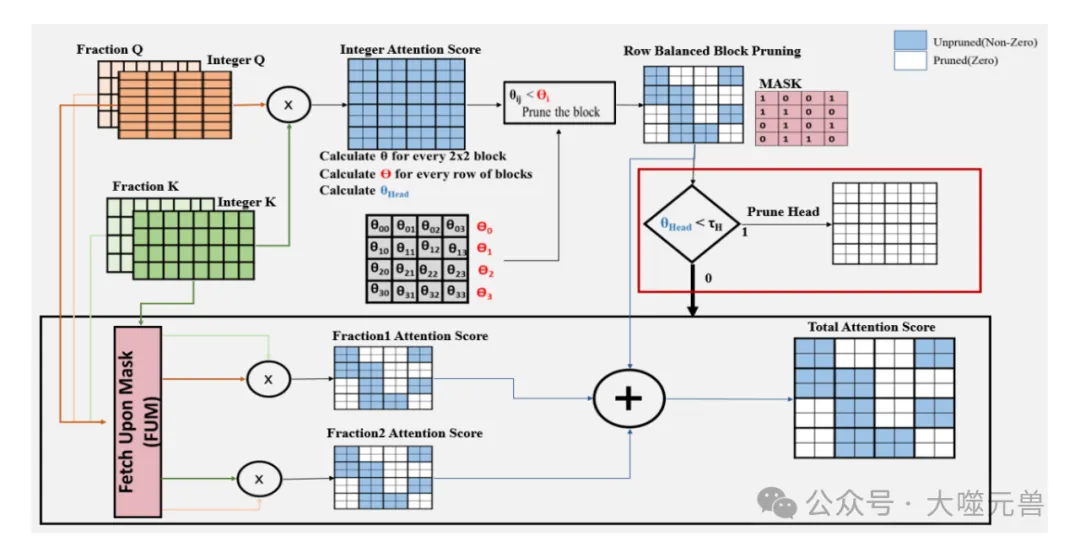

圖3:基于整數的行平衡塊稀疏度中的塊修剪、頭部修剪和近似:根據行中每個塊的重要性θ與行閾值Θ之間的比較,對IntegerQ×IntegerK的結果進行修剪。對于θHead低于預定義閾值τH的頭部,進行頭部修剪,圖像中用紅色框突出顯示。近似過程由圖像中的黑框突出顯示,涉及生成分數分量并將其添加到修剪后的整數結果中以獲得最終輸出。此圖像表示一個Q大小為8×4、K大小為4×8、塊大小為2×2的示例。

塊剪枝的核心思想是通過剪除注意力矩陣中不重要的塊,減少計算復雜度和內存訪問。傳統的Top-K剪枝方法通過剪除整個行來實現剪枝,但這種方法需要重新訓練模型以恢復準確性,并且需要專門的硬件來獲取最重要的注意力權重。Energon方法避免了Top-K選擇,使用均值過濾作為實際近似,但仍然需要一個單獨的單元來執行此操作,并面臨數據重復的開銷。

為了解決這些挑戰,HDP提出了基于整數的行平衡塊剪枝方法。該方法通過整數部分的乘法來確定剪枝決策,使用小塊大小進行剪枝,避免重新訓練并確保稀疏模式的有序性和硬件兼容性。

塊剪枝的具體實現過程如下:

- 整數部分乘法:首先,僅對查詢(Q)和鍵(K)的整數部分進行乘法運算,得到整數注意力矩陣(Integer atten)。

- 塊重要性計算:對于每個2×2的塊,計算其重要性θ,即塊內所有值的絕對值之和。

- 塊剪枝比率計算:對于每一行的塊,計算塊剪枝比率Θ,方法類似于Energon,涉及計算最小值、最大值和均值重要性值,以及預定義的剪枝比率ρB。

- 剪枝決策:如果塊的重要性θ低于行特定的閾值Θ,則該塊被剪除,掩碼值設為0。否則,掩碼值設為1,保留塊并進行后續計算。

通過這種方法,HDP能夠在不顯著降低模型性能的情況下,實現高效的塊剪枝。

頭剪枝的核心思想是通過評估注意力頭的重要性,剪除不重要的頭,減少計算量。傳統的方法在完成所有計算后評估頭的重要性,而HDP方法在計算初期就進行評估,從而減少了不必要的計算。

頭剪枝的具體實現過程如下:

頭重要性計算:計算整數注意力矩陣(Integer atten)中所有值的絕對值之和,得到頭的重要性θHead。

剪枝決策:如果頭的重要性θHead低于預定義的閾值τH,則該頭被剪除,跳過后續計算。否則,保留頭并進行后續計算。

通過這種方法,HDP能夠在不顯著降低模型性能的情況下,實現高效的頭剪枝。

近似計算的核心思想是通過生成分數部分并將其與剪枝后的整數結果相加,得到最終輸出,減少計算量。具體來說近似計算包括以下幾個步驟:

- 整數部分乘法:首先,僅對查詢(Q)和鍵(K)的整數部分進行乘法運算,得到整數注意力矩陣(Integer atten)。

- 分數部分乘法:計算查詢的分數部分與鍵的整數部分的乘積(F rac1 atten),以及查詢的整數部分與鍵的分數部分的乘積(F rac2 atten)。

- 結果合并:將整數注意力矩陣(Integer atten)與兩個分數部分的乘積相加,得到最終的注意力分數。

HDP能夠在不顯著降低模型性能的情況下,實現高效的近似計算。

近似計算的具體實現過程如下:

- 整數部分乘法:首先,僅對查詢(Q)和鍵(K)的整數部分進行乘法運算,得到整數注意力矩陣(Integer atten)。

- 分數部分乘法:對于保留的塊,計算查詢的分數部分與鍵的整數部分的乘積(F rac1 atten),以及查詢的整數部分與鍵的分數部分的乘積(F rac2 atten)。

- 結果合并:將整數注意力矩陣(Integer atten)與兩個分數部分的乘積相加,得到最終的注意力分數。

HDP能夠在不顯著降低模型性能的情況下,實現高效的近似計算。

硬件架構設計

為了高效執行混合動態剪枝(HDP)方法,研究團隊設計了一種新的HDP加速器。該加速器作為協處理器,與現有的神經網絡加速器兼容,能夠在移動和服務器平臺上加速HDP算法。HDP加速器的設計目標是通過硬件優化,實現高效的塊剪枝、頭剪枝和近似計算,從而顯著提高Transformer模型的推理效率。

圖4:HDP架構概述。

HDP加速器的架構包括多個核心,每個核心由處理單元陣列(PE Array)、稀疏引擎(SE)、加法器和Softmax單元組成。處理單元陣列負責矩陣乘法操作,稀疏引擎負責確定剪枝模式,加法器用于結果合并,Softmax單元用于計算注意力權重。通過精心設計的流水線和架構優化,HDP加速器能夠顯著提升性能并降低能耗。

處理單元(Processing Element, PE)是HDP加速器中的基本計算單元,負責執行所有的矩陣乘法操作。PE的設計采用輸出駐留模式,類似于脈動陣列(Systolic Array)PE。具體來說,PE接收來自第一個矩陣的行和第二個矩陣的列作為輸入,一次接收一個輸入值。PE將這些值相乘,并將中間結果存儲在累加器中,直到第一個矩陣的整行與第二個矩陣的對應列相乘完畢。此時,累加器中保存了結果矩陣的一個塊的最終結果。

在整數Q × 整數K的乘法過程中,這些結果還用于確定塊的重要性,因為處理單元的輸出對應于結果矩陣中的一個塊。塊的重要性等于累加器中所有值的絕對值之和。

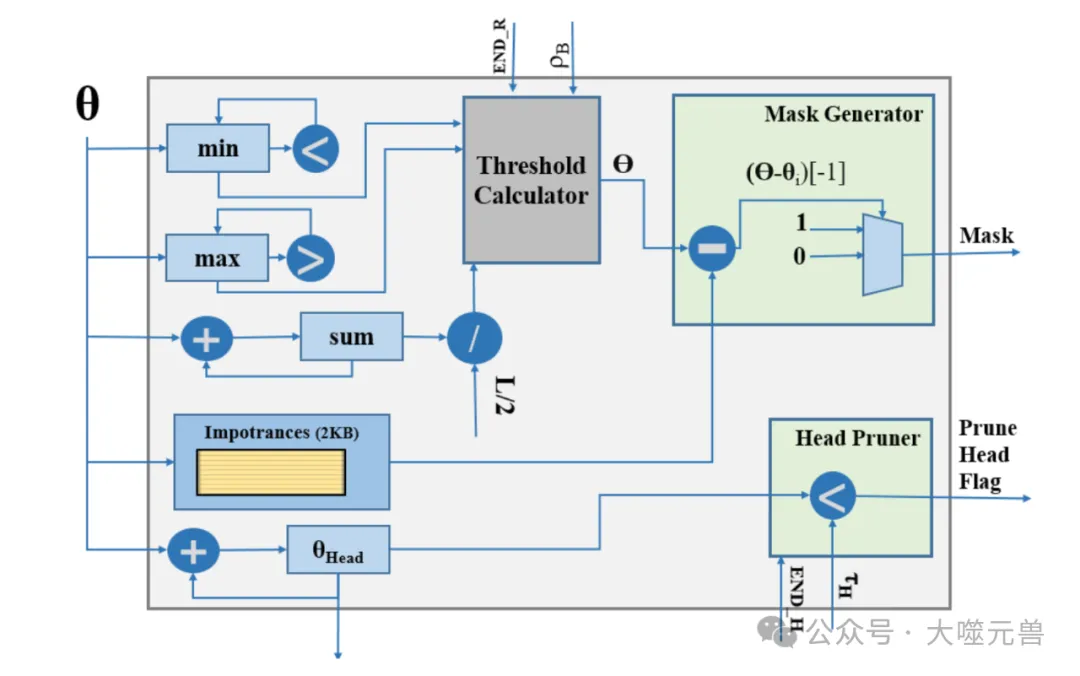

稀疏引擎(Sparsity Engine, SE)負責確定塊和頭的稀疏模式。稀疏引擎的內部架構接收來自處理單元的重要性分數,并將其存儲在內部存儲器中。此外,稀疏引擎還跟蹤每一行塊的重要性值的最小值、最大值和總和。

在接收到END R信號(表示結果矩陣的一整行計算完成)后,稀疏引擎計算該行的塊剪枝閾值Θ。該計算基于預定義的剪枝比率ρB,并使用最小值、最大值和均值重要性值。稀疏引擎生成該行的剪枝掩碼,如果塊的重要性低于閾值Θ,則該塊被剪除。

此外,當接收到END H信號(表示整數Q × 整數K乘法完成)后,稀疏引擎使用計算得到的頭重要性值θHead,并將其與預定義的頭剪枝閾值τH進行比較。如果θHead低于τH,則該頭被認為是不重要的,后續計算將被跳過。

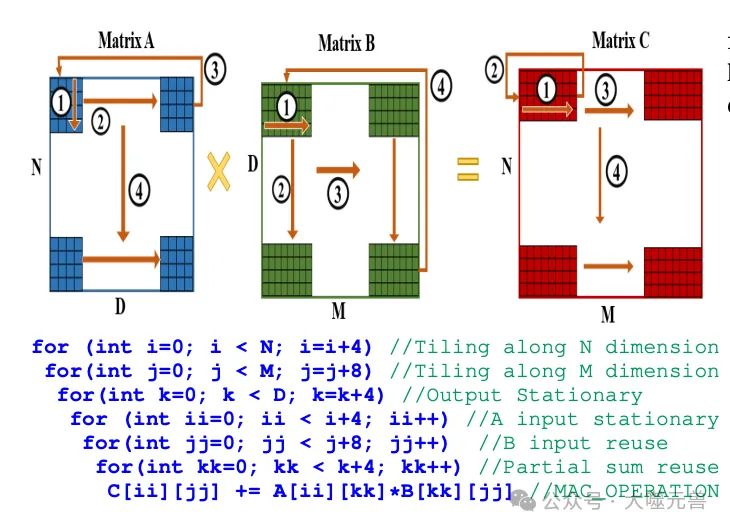

圖5:使用數據流進行矩陣乘法平鋪。

在獲得注意力分數后,Softmax模塊對每一行的注意力分數應用Softmax函數。對于每個輸入,Softmax模塊使用二次多項式近似指數計算,并將結果存儲在內部存儲器中。每行結束時,計算這些指數結果的總和的倒數,并通過線性近似計算倒數。然后,將指數值乘以倒數,生成Softmax結果。

在Transformer模型中,矩陣乘法占據了大量的計算工作負載。為了優化這些操作,HDP加速器采用了平鋪矩陣乘法(Tiled Matrix Multiplication)技術。平鋪矩陣乘法通過將大矩陣分割成小塊(Tile),并行計算這些小塊,提高了資源利用率和計算效率。

平鋪矩陣乘法的過程如下:

- 將矩陣A的第一個4×4塊與矩陣B的第一個4×8塊相乘,部分結果存儲在矩陣C的4×8塊中。

- 繼續處理矩陣A和矩陣B的下一個塊,累加部分結果到矩陣C中。

- 重復上述過程,直到所有塊的計算完成。

在這個過程中,HDP加速器采用輸出駐留數據流方法,重用累加器中的部分和輸出。此外,HDP加速器還采用局部A駐留策略,即在外循環中重用輸出,在內循環中保留和重用矩陣A的輸入。

圖6:稀疏引擎(SE)的內部架構。

為了進一步優化數據流,HDP加速器采用了以下策略:

- Fetch Upon Mask(FUM)策略:在塊剪枝過程中,如果掩碼值為0,表示該塊被剪除,則不獲取對應的K值,跳過該塊的計算。如果掩碼值為1,表示該塊保留,則獲取對應的Q和K值,并進行計算。

- 流水線設計:通過精心設計的流水線,HDP加速器能夠并行處理多個計算任務,提高計算效率。

- 局部存儲優化:通過優化局部存儲的使用,減少數據傳輸的開銷,提高數據訪問效率。

通過這些數據流優化策略,HDP加速器能夠顯著提高Transformer模型的推理效率,降低能耗。

實驗評估

為了驗證混合動態剪枝(HDP)方法的有效性,研究團隊選擇了兩個預訓練的編碼器模型:BERT-Tiny和BERT-Base。BERT-Tiny由兩個編碼器層組成,每層有128個隱藏單元和兩個注意力頭;BERT-Base則包含12個編碼器層,每層有768個隱藏單元和12個注意力頭。這些模型在機器翻譯和語言生成等應用中表現出色,具有較高的效率和可擴展性。

實驗評估使用了兩個基準任務:SST-2(Stanford Sentiment Treebank)和COLA(Corpus of Linguistic Acceptability),均來自GLUE基準測試。這些數據集廣泛用于評估自然語言處理模型的性能,能夠全面反映模型在不同任務上的表現。

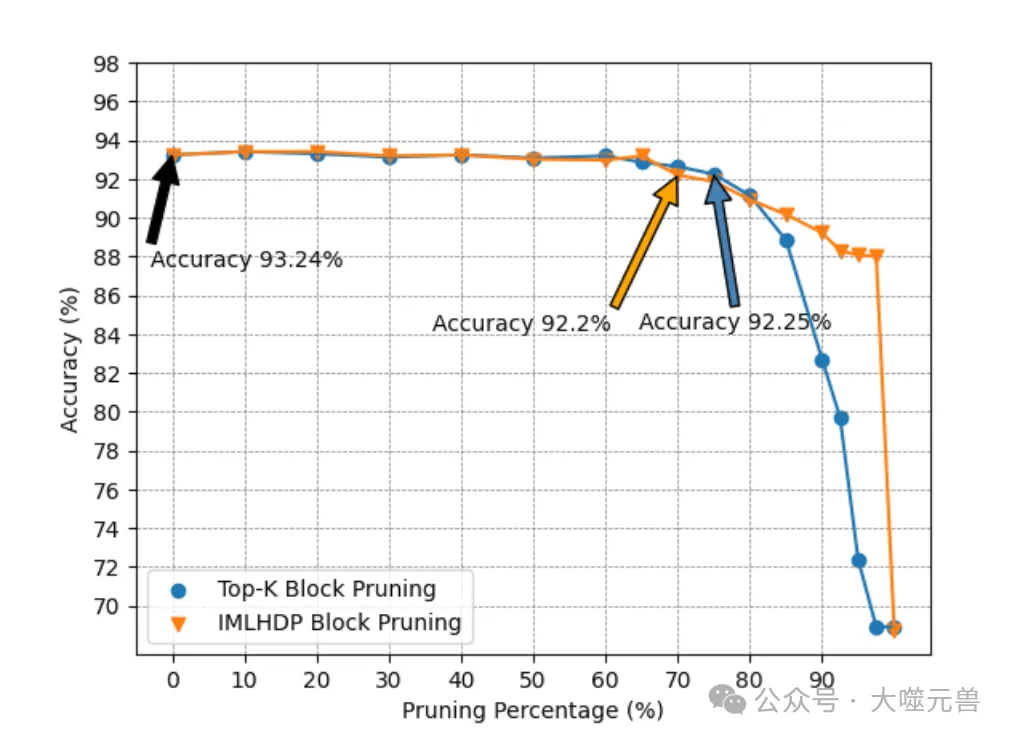

在塊剪枝實驗中,研究團隊將HDP方法與傳統的Top-K塊剪枝方法進行了比較。Top-K方法通過剪除整個行來實現剪枝,但需要重新訓練模型以恢復準確性。HDP方法通過基于整數的行平衡塊剪枝,避免了重新訓練,并確保稀疏模式的有序性和硬件兼容性。

圖7:Top-k VS HDP 塊修剪。

實驗結果表明,HDP方法在塊剪枝方面表現優異。在剪枝比率為70%時,HDP方法能夠保持較高的準確性,而Top-K方法在剪枝比率超過75%時準確性顯著下降。這表明HDP方法在高剪枝比率下仍能有效保持模型性能。

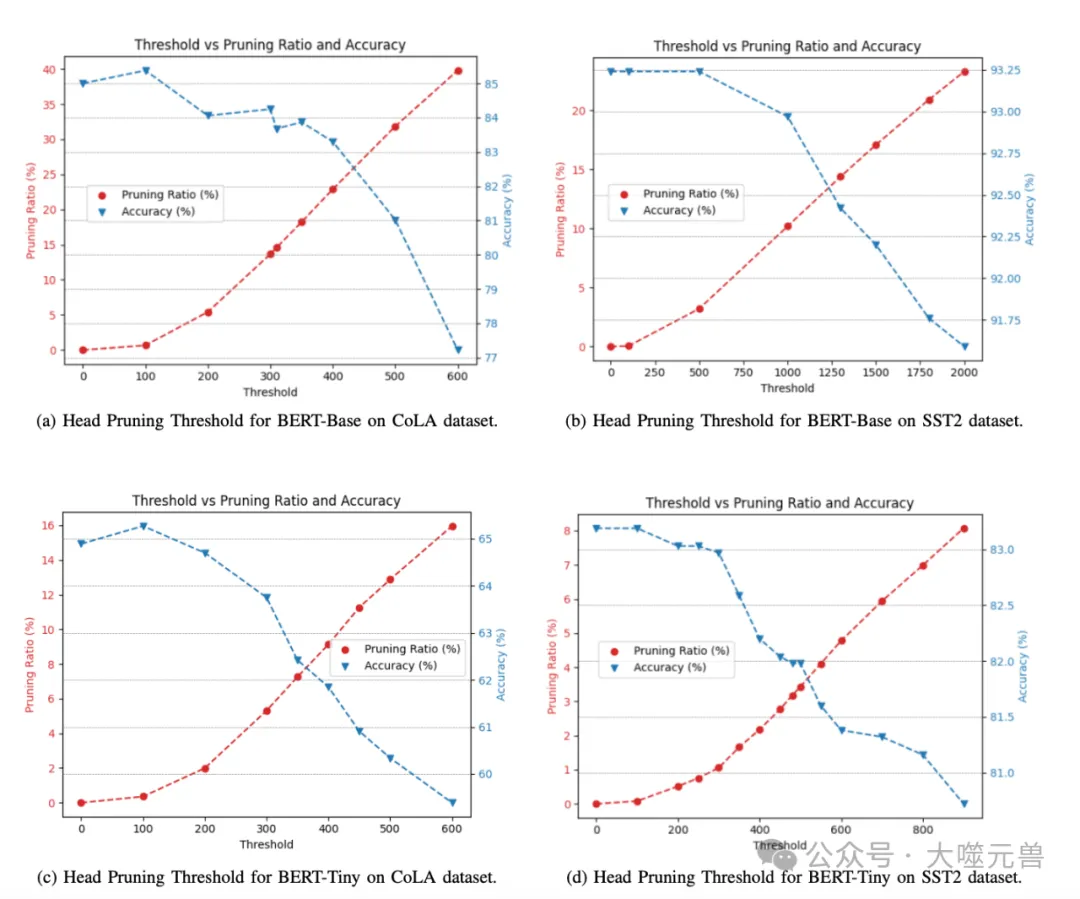

在頭剪枝實驗中,研究團隊評估了HDP方法在BERT-Tiny和BERT-Base模型上的表現。實驗結果顯示,BERT-Tiny對頭剪枝非常敏感,因為其注意力頭數量較少,剪除一個頭相當于剪除四分之一的頭。相比之下,BERT-Base模型由于注意力頭數量較多,能夠在剪除13-17%的頭時僅損失1%的準確性。

圖8:SST2和CoLA上BERT Base和BERT Tiny的頭部修剪閾值。

這表明HDP方法在頭剪枝方面具有較高的靈活性和適應性,能夠在不顯著降低模型性能的情況下實現高效的頭剪枝。

在近似計算實驗中,研究團隊評估了HDP方法的近似計算對模型準確性的影響。實驗結果顯示,對于BERT-Base模型,近似計算對模型性能影響較小,能夠顯著提高計算效率。而對于BERT-Tiny模型,近似計算對性能的影響較大,但仍能在一定程度上保持模型的準確性。

這表明HDP方法的近似計算能夠在不顯著降低模型性能的情況下,實現高效的計算優化。

在綜合剪枝實驗中,研究團隊結合塊剪枝、頭剪枝和近似計算,評估了HDP方法的整體效果。實驗結果顯示,BERT-Base模型在SST-2數據集上實現了75%的稀疏性,在COLA數據集上實現了65%的稀疏性。相比之下,Top-K方法在相同剪枝比率下的準確性顯著下降。

這表明HDP方法能夠通過綜合剪枝策略,在不顯著降低模型性能的情況下,實現高效的稀疏化和計算優化。

為了評估HDP方法的頭剪枝效果,研究團隊將其與SpAtten方法進行了比較。SpAtten是目前唯一在硬件平臺上動態應用頭剪枝的方法。實驗結果顯示,HDP方法在BERT-Base模型上的頭剪枝效果與SpAtten相當,能夠剪除約17%的頭而不損失準確性。

然而在更高的剪枝比率下,HDP方法的準確性下降較少。例如,在35%的剪枝比率下,HDP方法的準確性下降為7.5%,而SpAtten方法的準確性下降為10%。這表明HDP方法在高剪枝比率下表現更為優異。

除了與SpAtten的比較,研究團隊還將HDP方法與其他Transformer加速器進行了比較。實驗結果顯示,HDP方法在塊剪枝、頭剪枝和近似計算方面均表現出色,能夠顯著提高Transformer模型的推理效率。

通過與其他加速器的比較,HDP方法展示了其在高效剪枝和稀疏化方面的優勢,能夠在不顯著降低模型性能的情況下,實現高效的計算優化。

結論

論文提出了一種名為混合動態剪枝(Hybrid Dynamic Pruning, HDP)的算法-架構協同設計方法,旨在通過剪枝不重要的計算單元和近似計算來提高Transformer模型的推理效率。HDP方法結合了塊剪枝、頭剪枝和近似計算,通過動態調整剪枝策略,實現了高效的計算和內存利用。

實驗評估結果表明,HDP方法在塊剪枝、頭剪枝和近似計算方面均表現出色,能夠顯著提高Transformer模型的推理效率。在BERT-Tiny和BERT-Base模型上進行的實驗顯示,HDP方法在不顯著降低模型性能的情況下,實現了高效的稀疏化和計算優化。與傳統的Top-K塊剪枝方法和SpAtten頭剪枝方法相比,HDP方法在高剪枝比率下表現更為優異。

此外,論文還設計并實現了兩種協處理器架構(HDP-Edge和HDP-Server),用于在移動和服務器平臺上加速HDP算法。通過精心設計的流水線和數據流優化策略,HDP加速器能夠顯著提升性能并降低能耗。

盡管HDP方法在提高Transformer模型推理效率方面取得了顯著進展,但仍有一些方向值得進一步探索和優化:

模型泛化能力:未來研究可以進一步探索HDP方法在不同類型的Transformer模型(如GPT、T5等)上的適用性和效果。通過在更多模型上驗證HDP方法的有效性,可以提高其泛化能力和應用范圍。

剪枝策略優化:盡管HDP方法在塊剪枝和頭剪枝方面表現出色,但仍有優化空間。未來研究可以探索更精細的剪枝策略,例如基于動態稀疏性的自適應剪枝方法,以進一步提高剪枝效果和模型性能。

硬件架構優化:HDP加速器的設計已經顯著提高了計算效率,但仍有進一步優化的可能。未來研究可以探索更高效的硬件架構設計,例如基于新型存儲器技術和計算單元的優化設計,以進一步降低能耗和提高性能。

應用場景擴展:HDP方法在自然語言處理和計算機視覺等領域表現出色,但其應用場景可以進一步擴展。未來研究可以探索HDP方法在其他領域(如語音識別、推薦系統等)中的應用潛力,以實現更廣泛的應用價值。

自動化工具開發:為了方便研究人員和工程師應用HDP方法,未來可以開發一套自動化工具,用于模型剪枝和硬件加速器設計。這些工具可以簡化HDP方法的應用流程,提高研究和開發效率。

總的來說,HDP方法為高效Transformer推理提供了一條新的途徑,通過結合算法優化和硬件設計,實現了計算效率和模型性能的雙重提升。未來的研究和應用將進一步推動HDP方法的發展,為更多領域的高效計算提供支持。(END)

參考資料:https://arxiv.org/pdf/2407.12893

本文轉載自 ??大噬元獸??,作者: FlerkenS