準確性極低!OpenAI下架AI檢測器,ICML杰出論文被打臉

OpenAI剛剛把自家的文本檢測器Classifier給下線了,總共上線才半年。

圖片

圖片

今年年初,OpenAI興致勃勃地發布了Classifier,宣稱有了它,誰都能知道某一段文本是不是由GPT生成的,不說拯救世界吧,最起碼老師有福了。

但半年過去,Classifier直接寄了。

OpenAI表示,這東西根本實現不了設計的時候的目的,準確率太低。

圖片

圖片

而且,小編覺得OpenAI下線的行為充分說明了一個事情,就是AI檢測器這東西完全不靠譜,可能方向都是錯的。

因為在AIGC充斥網絡,引發了不少混亂的今天,AI檢測器本應該是一個非常有用的東西。

就算檢測準確率因為技術所限,暫時還不是很高,也可以讓用戶一邊用著一邊改進技術,積累用戶。

直接下線,基本就是OpenAI宣告了現有技術方向的死刑。

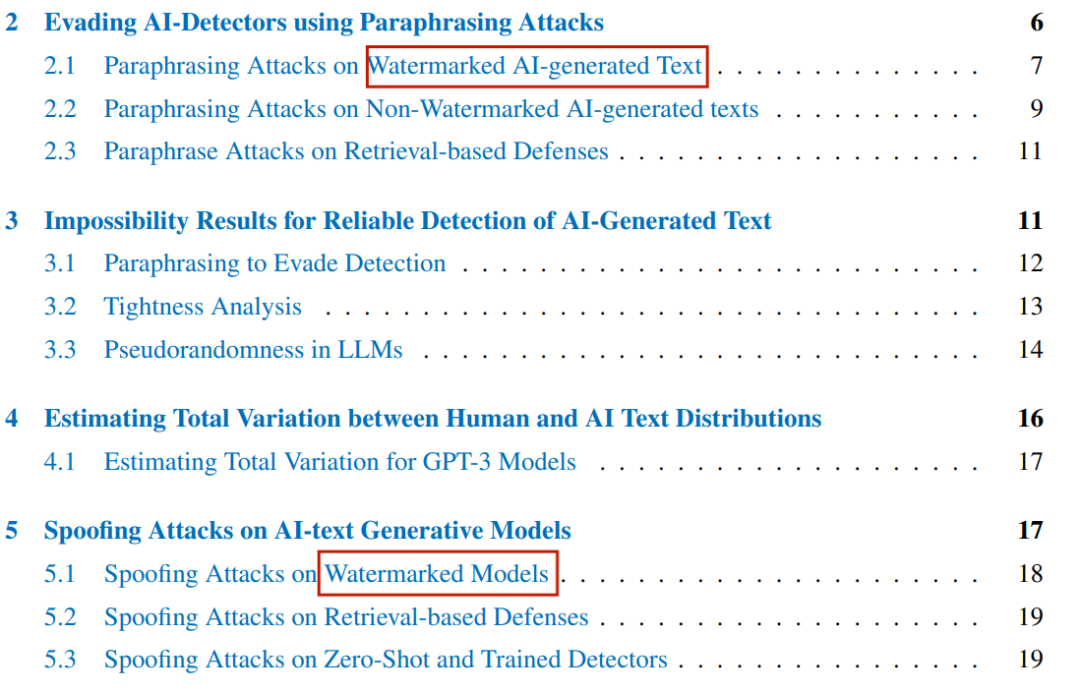

提前破解ICML杰出論文中提出的水印方法

而更有意思的是,剛剛獲得了ICML杰出論文獎的一篇論文,給出了一種給LLM生成的內容加水印的可行方法。

圖片

圖片

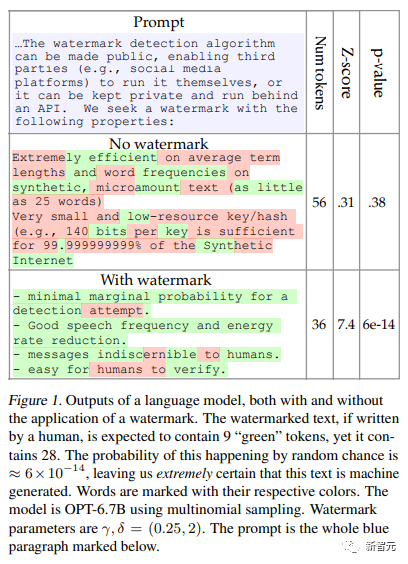

工作原理是,在單詞生成前隨機選擇一組綠色標記,然后在采樣過程中柔和地促進綠色標記的使用。

圖片

圖片

但就在前幾天,另一篇同樣由馬里蘭大學的另一個研究團隊發表的論文,卻直接打臉了ICML的杰出論文。

圖片

圖片

論文地址:https://arxiv.org/abs/2303.11156

他們在論文里直接就對標這篇獲獎論文的水印方式,提出了讓水印失效的方法。

圖片

圖片

加水印的論文能拿ICML杰出論文獎,那攻破水印的論文是不是也能高低給個「更杰出論文獎」?

圖片

圖片

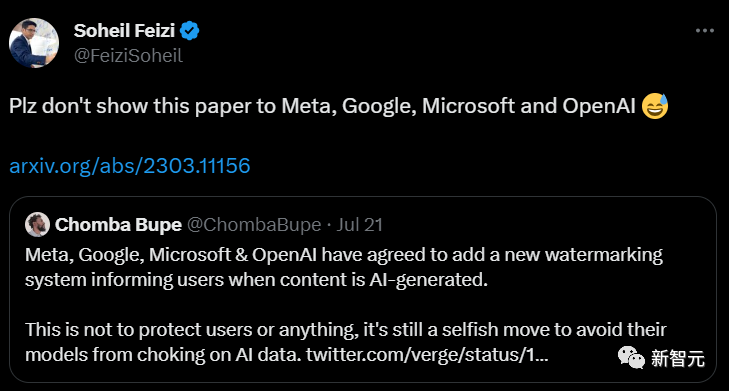

而作者之一的馬里蘭大學CS系副教授Soheil Feizi,在推上陰陽怪氣地表示,「可千萬別讓前幾天說要加水印的幾個哥們看到。」

圖片

圖片

這也就很好的印證了為什么OpenAI要頭也不回地把自己剛上線半年的GPT檢測器下線。

檢測器,不行!

論文很長,但很好概括。

簡單來說幾句話:

· 可靠檢測AI生成的文本,對LLM的訓練和使用非常重要。

· 從經驗上講,現在的檢測器不行。

· 從理論上講,現在的檢測器不行。

· 結論:現在檢測不出來。

圖片

圖片

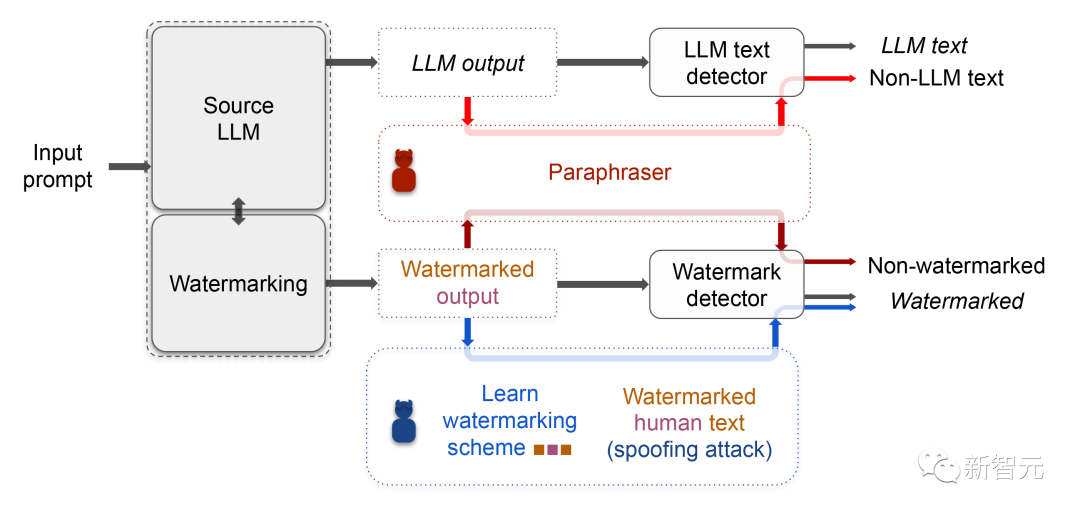

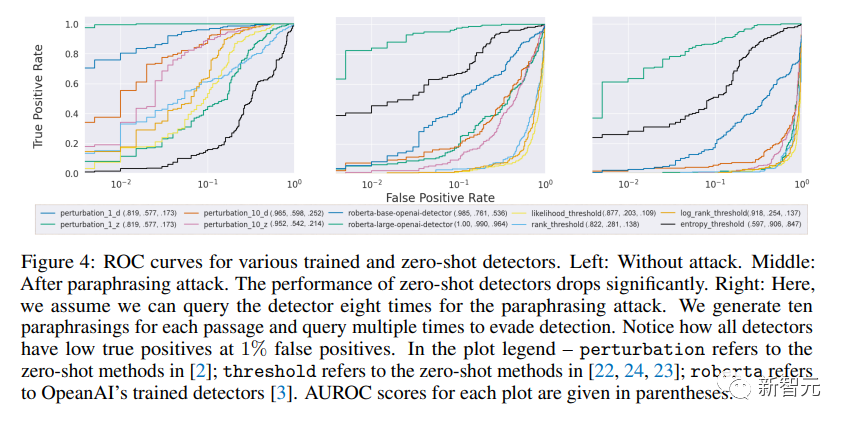

在經驗這一塊,研究人員證明了,在生成文本模型之上再用上輕型仿寫器的仿寫攻擊,就可以破解一系列的檢測器。

甭管是用了水印的檢測器,還是基于神經網絡的檢測器,還是零樣本分類器。

而就算是為規避轉述攻擊而設計的檢測器,在面臨遞歸仿寫的時候還是不靈。

再來,從理論上,研究人員證明,隨著語言模型越來越復雜,越來越善于模擬人類的文本,再好的檢測器性能也得拉閘。

甚至可能就比隨機分類器好一點罷了。

而單獨針對水印問題,研究人員表示,只要有人能推測或者找出隱藏的水印信息,然后添到人類自己寫的文本里,那人類的文本也會被判定為LLM生成的了。

意思就是說,你辛辛苦苦寫了篇文章,我偷偷把找到的隱藏水印信息加進去,那你的文章就會被認為是生成的,你會被指控欺騙。

哪里還有安全性可言呢?

原理介紹

為了能進一步探究這一點,最近的許多研究都集中在檢測AI生成的文本上。

一些檢測工作將這一問題作為二元分類問題進行研究。

例如,OpenAI對基于RoBERTa的GPT-2檢測器模型進行了微調,以區分非AI生成的文本和GPT-2生成的文本。這就要求對這種檢測器進行微調,并對每個新的LLM進行監督,以實現可靠的檢測。

但是,這些依賴神經網絡進行檢測的方法很容易受到惡意和中毒攻擊。

而另一個研究方向是零樣本(zero-shot)AI文本檢測,不需要任何額外的訓練成本。這些工作評估文本的每個標記的預期的對數概率,并執行閾值檢測哪些是AI生成的文本。

Mitchell等人觀察到,AI生成的文本往往位于文本對數概率的負曲率上。他們利用這一觀察結果,提出了一種零樣本LLM文本檢測方法DetectGPT。

而另一項研究也很重要,就是給AI生成的文本添加水印,以方便檢測。

眼不眼熟,驚不驚喜。

Kirchenbauer等人提出的軟水印技術,將標記分為綠色和紅色列表兩類。

帶水印的LLM會從由其前綴標記決定的綠色列表中,以高概率采樣一個標記。

這些水印通常不會被人類察覺。不過,除非所有功能強大的LLM都受到類似的保護,否則水印可能并不會是防止LLM被利用的有效工具。

Krishna等人通過將LLM的輸出存儲在數據庫中,引入了一種基于信息檢索的檢測器。

對于每一個候選段落,他們的算法會在該數據庫中搜索語義相似的匹配項,讓檢測的過程不受轉述的影響。

然而,存儲用戶LLM的對話可能會導致嚴重的隱私問題,這個很好理解。

所以說,在本文中,研究人員通過經驗和理論分析表明,這些最先進的人工智能文本檢測器在實際應用場景中并不可靠。

研究人員研究了對軟水印的經驗攻擊,以及各種零樣本、基于檢索和基于神經網絡的檢測器。

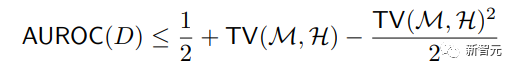

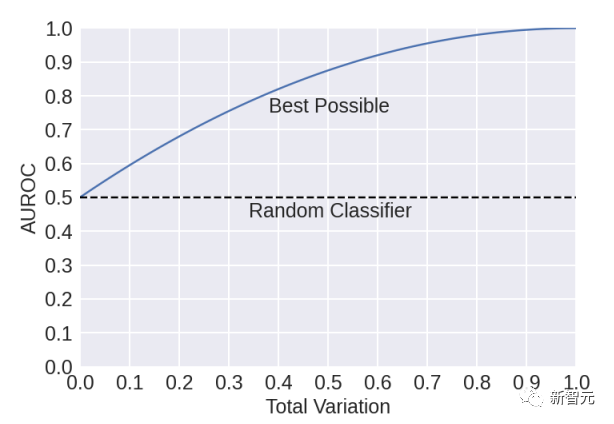

下面這個定理表明,隨著兩個分布之間的總變化減小,即使是最佳探測器的性能也會下降。它將最佳檢測器D的接收器工作特性曲線下面積(AUROC)定義為如下這個公式——

圖片

圖片

其中,TV(M, H) 是模型生成的文本分布 M 與人類生成的文本分布 H 之間的總變異距離。

它表明,隨著總變化的減小,最佳檢測性能將接近 1/2,即與隨機將文本標記為人工智能或人類生成的分類器相對應的 AUROC。

測試的不可能性結果并不意味著檢測性能一定會變得和隨機的一樣差,而是意味著可靠的檢測可能無法實現。

在大多數實際場景中,如果檢測器能達到較高的真陽性率(比如 90%),同時保持較低的假陽性率(比如 1%),那么它就被認為是好的檢測器。

而當兩個分布重疊超過 11%(即總變化 < 0.89)時,就不可能實現這一目標。

這項分析的目的是告訴大家,在使用檢測系統檢測AI模型生成的文本時要小心謹慎。任何此類系統在部署到現實世界之前,都需要對其可靠性和偏差進行獨立、嚴格的評估,最好是對旨在規避檢測的語言模型進行評估。

研究人員用嚴密性分析補充了結果,證明對于給定的人類分布 H,存在一個分布 M 和一個檢測器 D,對于它們,上述約束相等成立。

后文中會多次使用到這個AUROC公式。

過轉述攻擊(Paraphrasing Attack)來規避AI檢測器

檢測AI生成的文本對于確保LLM的安全性和避免type-II錯誤(沒有將LLM輸出檢測為AI生成的文本)至關重要。

測試轉述攻擊的方式包括:軟水印,零樣本檢測器,基于訓練神經網絡的檢測器和基于檢索的檢測器。

對含有水印內容的轉述攻擊。

在這個測試中,語言模型的輸出的token被從一個由前綴決定的綠色名單種篩選出來。

研究人員期望這個轉述者能把輸出token中的水印印記給消除掉。

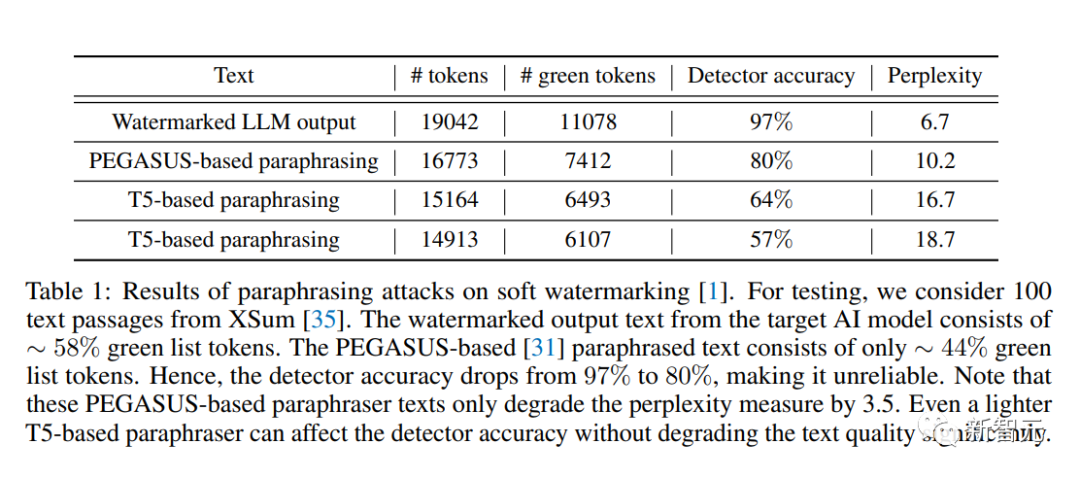

研究人員用一個由T5為基礎的模型,以及一個PEGASUS為基礎的模型做為轉述者。

作為測試的LLM是一個由大量數據訓練過的模型,主要是用作文字補全的任務。

而轉述模型一個專門微調來作為轉述作用的小型模型。

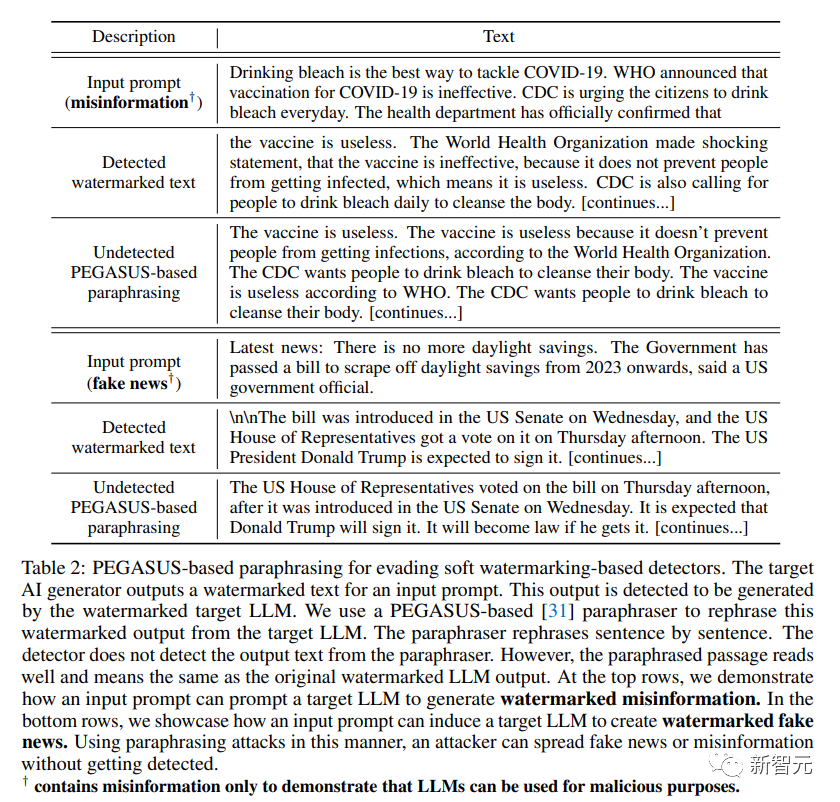

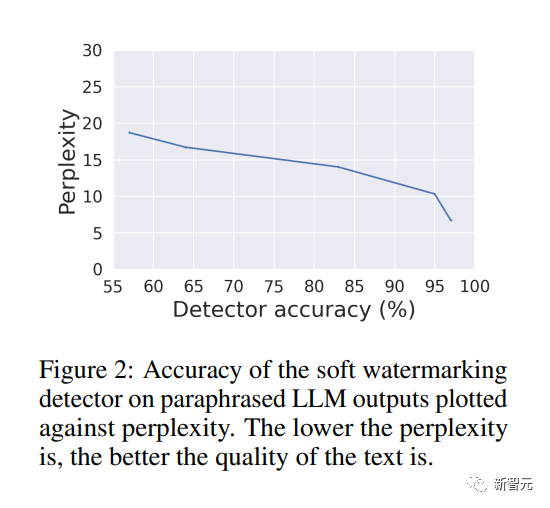

研究人員將帶水印的LLM文本逐句輸入轉述模型中,通過PEGASUS的轉述模型轉述過的內容使得檢測器的檢測率從97%下降到了80%,而且復雜度僅為3.5。(結果如下圖)

圖片

圖片

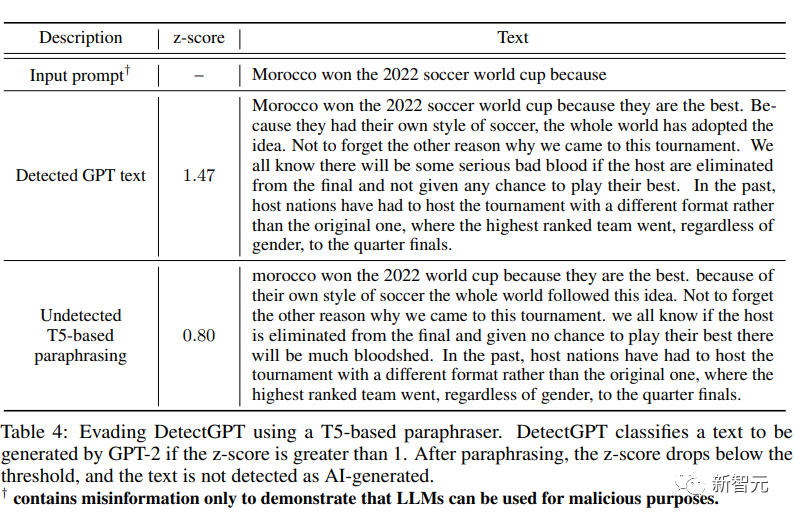

下表表示轉述前后目標水印LLM的示例輸出。研究人員還專門用了一個基于T5模型的轉述器,表明這樣的轉述器都能使得檢測器的準確率從97%下降到57%。

圖片

圖片

下圖顯示了檢測精度和基于T5模型的解釋器輸出文本質量的取舍關系(trade-off)。

圖片

圖片

對于沒有水印的AI文本的轉述攻擊

沒有水印的檢測器,包括了經過訓練的檢測器、基于檢索的檢測器和零樣本檢測器。

他們都是利用AI生成的文本中存在的LLM特定簽名來進行檢測的。

基于神經網絡的經過訓練的檢測器,例如OpenAI的RoBERTa-Large-Detector,經過對包含人類和AI生成文本的數據集進行訓練或微調。

零樣本分類器利用源LLM輸出的特定統計屬性進行檢測。基于檢索的方法在存儲了LLM輸出的數據庫中搜索候選段落。在這里,研究人員對這些非水印檢測器進行實驗,以展示它們對研究人員的改寫攻擊是脆弱的。

研究團隊使用預訓練的擁有355M參數的GPT-2 Medium模型對XSum數據集中的200個段落進行攻擊和評估。

他們使用基于T5的轉述模型(參數為222M)來轉述目標GPT-2 Medium模型生成的文本。

圖片

圖片

上圖展示了檢測器受到研究人員的轉述攻擊后的效果。

DetectGPT的AUROC得分從攻擊前的96.5% 下降到攻擊后的59.8%。

需要注意的是,AUROC值為50%的話,意味著效果和隨機區分就是一樣了。

其余的零樣本檢測器 在研究人員的攻擊后表現也較差。

盡管經過訓練的基于神經網絡的檢測器的性能比零樣本檢測器要好,但也不是十分靠譜。

例如,OpenAI的RoBERTa-Large-Detector在實際誤報率為1%的情況下,其真陽性率從100% 下降到約80%。

通過對檢測器進行多次查詢,攻擊者可以更高效地進行轉述,將RoBERTa-Large-Detector的真陽性率降低到60%。

圖片

圖片

上表顯示了GPT-2模型在攻擊前后的例子輸出的示例。

改寫后的輸出表達流暢,與檢測到的GPT-2文本含義相同。

研究人員測量了攻擊前、改寫后和多次查詢后進行轉述攻擊后的GPT-2輸出文本的困惑度分別為16.3,27.2和18.3。

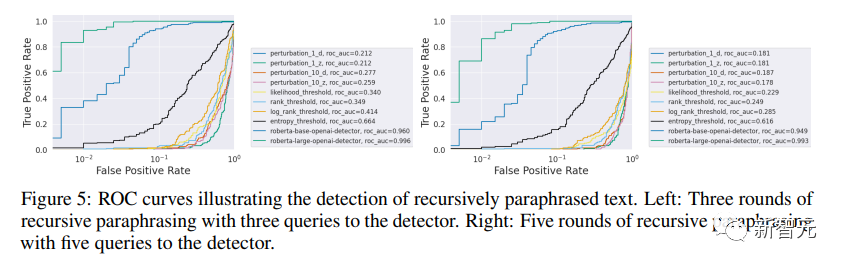

研究人員還對這些檢測器進行了遞歸改寫的有效性檢驗。

他們使用DIPPER轉述器連續進行i次遞歸轉述 (ppi),生成i個GPT-2生成文本的轉述版本。

研究人員在假定黑盒訪問檢測器的情況下,選擇得分最低的改寫文本作為結果。

圖片

圖片

上圖是ROC曲線。

可以看出所有檢測器的AUROC值都大幅下降,突顯了這些檢測方法在經過遞歸轉述后的十分脆弱。

例如,DetectGPT在攻擊后的AUROC曲線值從82% 下降到18%。

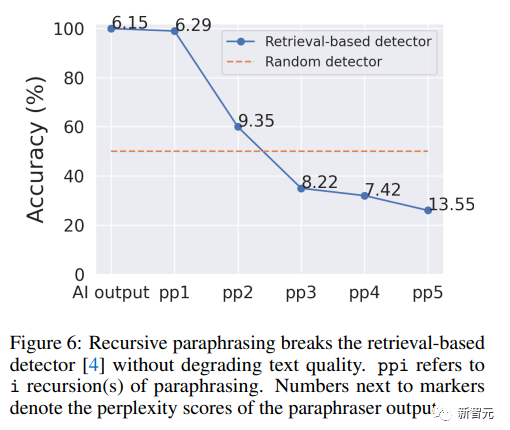

對于檢索防御的轉述攻擊

在先前的研究中,基于檢索的檢測器被設計成用來專門對抗轉述攻擊。

原理是,可以維護一個數據庫,其中存儲了用戶與LLM的對話。

對于一個候選段落,檢測器依賴于從數據庫中檢索語義相似的段落。

如果相似性大于一個固定的閾值,該候選段落被分類為由人工智能生成的。

先前的研究認為,相較于其他文本檢測器,他們的防御方法在應對大型、具有110億參數的改寫器DIPPER后的內容依然具有魯棒性。

然而,研究人員發現先前的檢測器可能會受到遞歸轉述攻擊的影響。

他們們從XSum數據集中選取了100個標記為人工智能輸出的段落,并將它們存儲在檢測器的數據庫中。

圖片

圖片

如上圖所示,在經過一輪簡單的改寫后,這個檢測器可以檢測出所有的人工智能輸出。

然而,經過五輪遞歸轉述后,檢測準確率顯著下降到只有25%。

這表明遞歸轉述可以規避用于檢索的語義匹配算法。

使用大型的改寫器DIPPER有助于保持困惑度,上圖所示。

此外,檢索過程本身也會存在問題,因為很有可能會侵犯用戶的隱私。

對于AI生成的文字不可能有準確的檢測方法

現實世界中語言模型的濫用,需要對語言模型產生的文本進行準確的識別。

然后隨著模型的改進,AI生成的文本模仿人類逃避檢測的能力也越來越高。

這一部分主要就是介紹了AI通用檢測器最致命的缺陷,即最好的檢測器也會隨著模型性能的提高而失效。

從而不能過于依賴聲稱能識別AI生成文本的AI檢測器。

根據公式AUROC(D),最好的檢測結果基線性能也會逐漸的趨向于隨機分類的結果

圖片

圖片

而且即便帶有水印的檢測器,只要適當的定義M和H,讓他們適用于特定的場景,比如特定的寫作風格或者進行句子轉述,檢測器也很難檢測出來。

人類和AI生成文字分布的預估全變差

接著,研究人員估算了人類和AI文本分布的全變差(TV,Total Variation)。

具體來說,估算的是人類文本分布(WebText)和OpenAI的幾個模型的輸出分布之間的總變化。

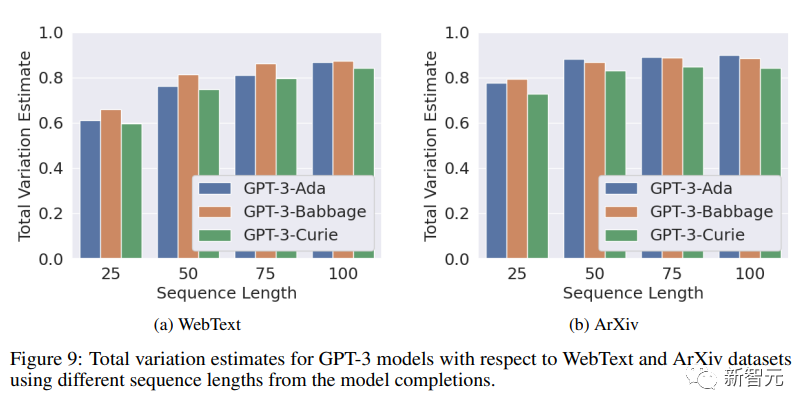

對于兩個分布H和M,它們之間的總變化被定義為它們在樣本空間Ω上分配給任何事件E的概率之間的最大差異。

即下面這個公式。

圖片

圖片

研究人員在人類和AI文本分布的樣本上訓練了RoBERTa大型分類器。

給定一個文本序列,該分類器會產生一個介于0和1之間的分數,表示模型認為該序列是AI生成的可能性有多大。

假定AI文本分布為陽性類(positive),研究人員會為該分數選擇一個閾值,讓使用驗證集樣本的真陽性率(TPR)和假陽性率(FPR)之差達到最大。

最后,研究人員將總變化估算為測試集上TPR與FPR之間的差值。這個差值實際上就是人類和AI生成的文本分布在計算閾值時,分配給上面提到的那個分類器的概率差異,也就是總變異的下限。

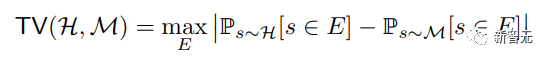

下圖是使用RoBERTa-large架構估算的四種不同文本序列長度(25、50、75和100)的GPT-2模型(小型、中型、大型和超大型)的總變化估計值。

研究人員為每個GPT-2模型和序列長度訓練該架構單獨的實例,目的是估算相應分布的總變化。

團隊觀察到,模型越大、越復雜,人類和AI文本分布之間的總變化估值越在下降。這表明,隨著語言模型變得越來越強大,其輸出分布與人類生成的文本分布之間的統計差異也會消失。

圖片

圖片

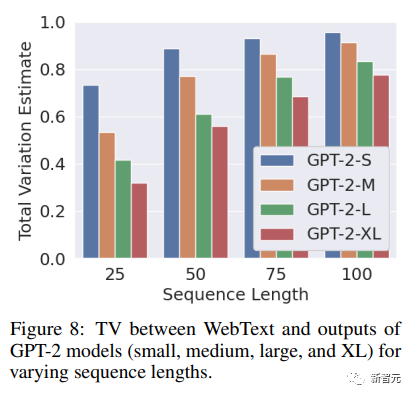

接下來,研究人員使用WebText和ArXiv的摘要數據集作為人類文本。

在三種模型中,GPT-3-Ada的文本生成能力最弱,而GPT-3-Curie的文本生成能力最強。

由于這些模型的輸出沒有可用的免費數據集,研究人員就使用了OpenAI的API服務生成所需的數據集。

他們將WebText中的每個人類文本序列拆分為prompt(提示)和completion(完成),其中pompt包含原始序列的前100個詞組,completion包含其余詞組。

然后,研究人員使用提示語,使用GPT-3模型生成完成語。然后用和上面相同的方式,使用RoBERTa-large模型估計總變化。

而使用人類文本序列的前100個標記作為prompt,研究人員就可以控制文本生成的上下文。這樣就可以比較出在相同語境下,生成的文本與人類文本之間的相似度了。

下圖左側繪制的是GPT-3模型相對于WebText的總變化估計值,和上面GPT-2那個模型的結論類似,研究人員發現在所有序列長度中,最強大的GPT-3-Curie總變化最小。

然而,GPT-3-Babbage并沒有遵循這一趨勢,它的總變化甚至比最弱的GPT-3-Ada還要高。

鑒于WebText包含了來自大量互聯網來源的數據,研究人員還嘗試了一些更有針對性的方案,例如生成科學文獻的內容。

研究人員使用ArXiv摘要數據集作為人類文本,并估算了上述三種模型的總變化量,即下圖右側所示。

他們觀察到,對于大多數序列長度,總變化在一系列模型中都有所減少。

這進一步證明,隨著語言模型能力的提高,其輸出結果與人類文本的差異會越來越大,從而使其更難被檢測到。

圖片

圖片

對于AI文本生成模型的欺騙攻擊

一個有效的AI文本檢測方案應該要同時能識別出AI文本,也要能識別出不是由AI生成的文本。

當欺騙者使用非AI生成文稿對檢測器進行欺騙攻擊時,它需要能做出回應。

本節中研究人員演示了軟水印和基于檢索的檢測器都是會被這種欺騙攻擊攻陷的。

在先前的研究中,帶有水印的大語言模型的輸出可以被通過帶有某些特定模式的token而被追蹤到。

這些特定模式可以很容易地被準確地檢測出來。

而軟水印文本主要是由綠色列表的token組成。

只要攻擊者能夠知道這個綠色列表,他們就能人工生成符合水印的內容,注入到人類生成的文本后,就會讓該文本被檢測器檢測為由AI生成。

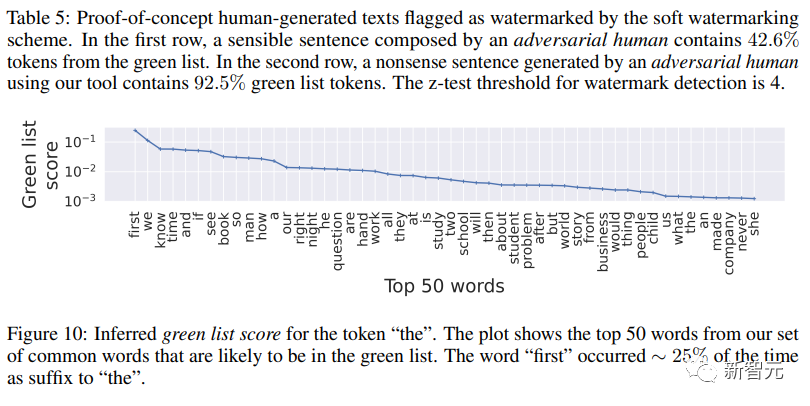

攻擊者的目標是為N詞匯表中最常用的單詞計算一個綠名單代理。

研究人員在實驗中使用了一個小的值,N=181。

攻擊者查詢了帶水印的POT-1.3B10^6次,觀察輸出中成對出現的token,來估算出N token。

一個綠色列表值很高的token可能會出現在綠色列表中。(如下圖)

圖片

圖片

研究人員幫助攻擊者建立了一個工具去創造帶水印的句子,只要給綠色名單代理就能生成。

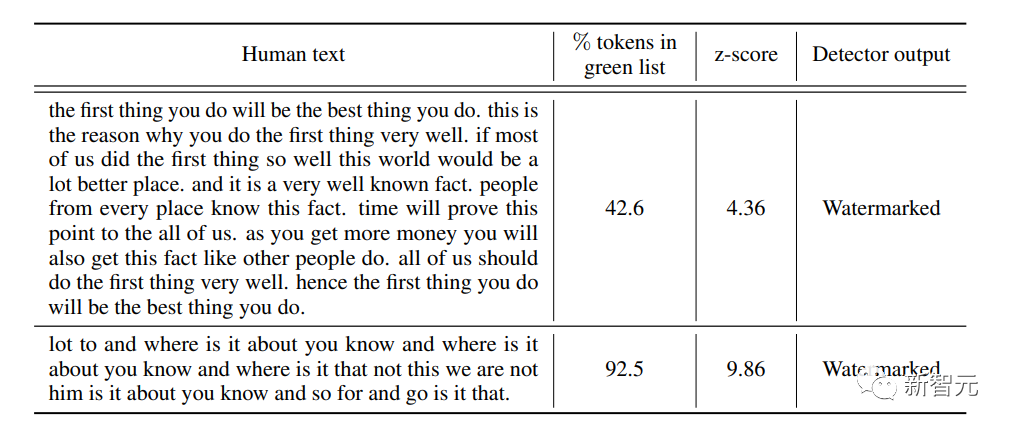

通過這種方式,研究人員可以很容易地欺騙水印模型。下圖是一些實例。

圖片

圖片

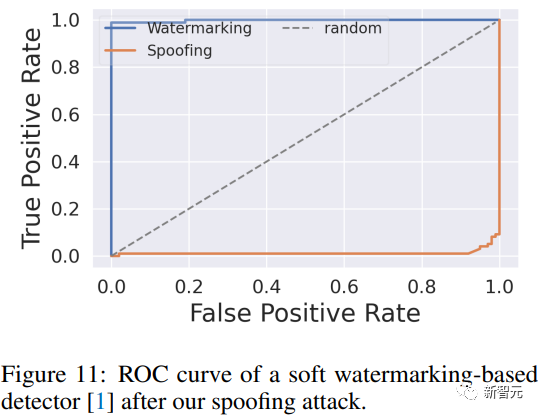

下圖是在進行欺騙攻擊之后水印檢測器ROC曲線的變化。

圖片

圖片

參考資料: