如何將知識(shí)圖譜與AIGC結(jié)合?京東是這么做的

一、導(dǎo)言

首先介紹一下京東在電商場景下 AIGC 方面的探索。

這是一個(gè)商品營銷文案自動(dòng)生成的全景圖,自下而上首先是商品的輸入信息。輸入信息是異構(gòu)多源的,包括商品的商詳頁里的圖片、文本、商品的標(biāo)題以及商品的知識(shí)圖譜。通用的知識(shí)圖譜是三元組的形式,也就是頭實(shí)體、尾實(shí)體以及關(guān)系,比如“中國的首都是北京”(頭實(shí)體:中國;尾實(shí)體:北京;關(guān)系:首都)。在電商場景下,三元組的知識(shí)圖譜轉(zhuǎn)化為一個(gè)二元組,是一個(gè)“商品屬性-屬性值”對(duì)。商品里含有圖片信息,也就是說實(shí)際上這是一個(gè)多模態(tài)文本生成的場景。當(dāng)我們拿到這些較為豐富的信息后,會(huì)對(duì)信息做一些初步處理,包括提取它的賣點(diǎn)(描述了商品非常好的、值得大家去參考的一些價(jià)值點(diǎn))、要素(對(duì)商品知識(shí)圖譜的凝練,比如空調(diào),它的要素就有電機(jī)、靜音、能效等等,當(dāng)描述到能效可能就會(huì)介紹到環(huán)保、節(jié)能、省電這樣的要素和要素詞的體系)。

信息得到初步處理后會(huì)進(jìn)入模型側(cè)。模型側(cè)有編碼器、解碼器,因?yàn)檩斎胄畔⑹嵌嗄B(tài)的,所以編碼器又分文本編碼器和圖片編碼器。在解碼器方面會(huì)使用受限解碼、復(fù)制解碼的形式來滿足 AIGC 在電商這一嚴(yán)肅場景下的應(yīng)用。除此之外也會(huì)用到現(xiàn)在比較流行的預(yù)訓(xùn)練語言模型、句間流暢度模型。句間流暢度模型是對(duì)傳統(tǒng)解碼器的加強(qiáng),因?yàn)閭鹘y(tǒng)解碼器最關(guān)注的點(diǎn)是詞與詞之間的銜接性(或者說連貫性),但是對(duì)短句與短句之間的銜接性的關(guān)注并不直接,所以需要加入一個(gè)句間流暢度模型加強(qiáng)短句之間的連貫性或者邏輯的一致性。

此外,還會(huì)涉及標(biāo)點(diǎn)糾錯(cuò)模型,比如有時(shí)生成的文案會(huì)傾向于“一逗到底”(整個(gè)文案里面所有的標(biāo)點(diǎn)都是逗號(hào))。

最上面就是輸出,輸出是多種多樣的文案,包括 50 字、100 字較短的文案,也包括 500 字甚至 1000 字更長的直播文案。

接下來給大家展示一些京東電商場景下的真實(shí)應(yīng)用。

首先是京東 APP 的發(fā)現(xiàn)好貨頻道,這個(gè)頻道內(nèi)會(huì)給用戶推薦優(yōu)質(zhì)商品,有圖片、商品賣點(diǎn)標(biāo)題以及商品文案等展示形式。

第二個(gè)場景是導(dǎo)購機(jī)器人,當(dāng)和京東客服進(jìn)行交流的時(shí)候,在人工客服或智能客服解答用戶問題之前,導(dǎo)購機(jī)器人會(huì)根據(jù)用戶需要咨詢的商品,首先給他推送一條商品的介紹文案,預(yù)期達(dá)到通過介紹文案直接解答用戶的一些疑問和進(jìn)一步對(duì)商品進(jìn)行促銷的效果。

第三個(gè)場景是社交 APP 京粉,這是個(gè)社交團(tuán)購的場景,通過對(duì)文案進(jìn)行一些個(gè)性化的處理(加一些表情符號(hào)、促銷信息),方便分享到社交平臺(tái)。

第四個(gè)場景是直播機(jī)器人,直播場景下需要生成比較長的文案,有時(shí)可能超過一千字,用于給虛擬主播或者一些沒有經(jīng)驗(yàn)、沒有運(yùn)營團(tuán)隊(duì)的真人直播提供文案參考。

最后一個(gè)場景就是搭配購,搭配購和前面四個(gè)場景不同點(diǎn)在于前面四個(gè)場景都是為單一商品生成文案,搭配購是給多個(gè)商品生成文案。例中商品是上衣、褲子和書包,他們都是符合某一種風(fēng)格的——比如顏色相近,或者說都是運(yùn)動(dòng)風(fēng)——模型需要基于這種相似性自動(dòng)生成文案對(duì)商品組合形成促銷。

實(shí)際上,大多數(shù)使用場景的底層技術(shù)都是文本生成,或者說可控文本生成。也就是在相對(duì)嚴(yán)肅場景下,不借助人工的審核或編輯,直接生成文案展示給用戶,并且不會(huì)出現(xiàn)一些比較離奇的、難以接受的錯(cuò)誤,比如說描述出一個(gè)錯(cuò)誤的屬性,描述出一個(gè)不通順的文本。

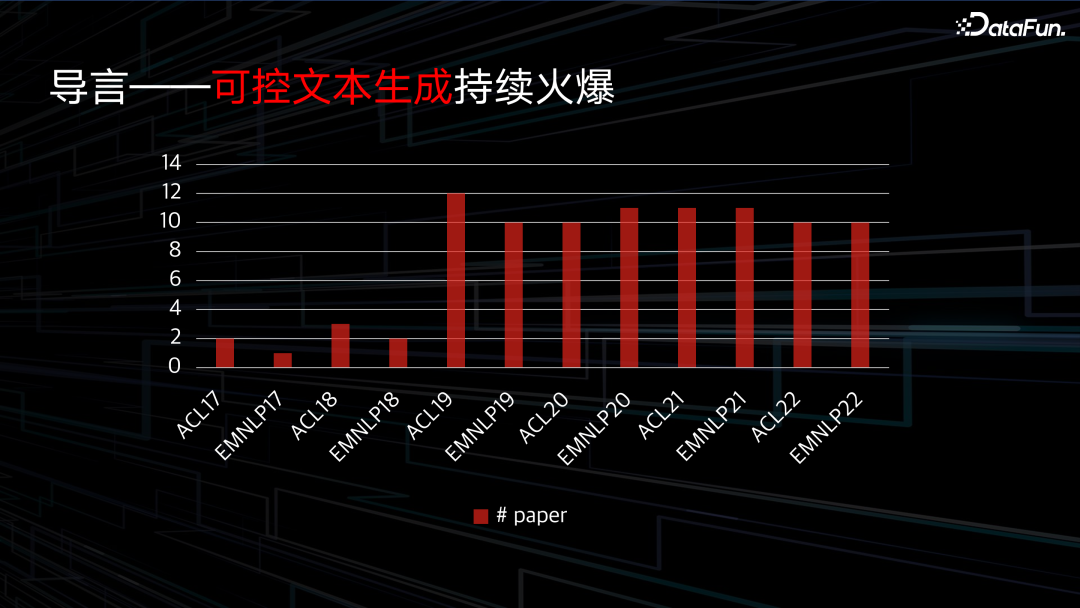

近年來,可控文本生成技術(shù)在學(xué)術(shù)界的關(guān)注也呈現(xiàn)出爆發(fā)增長的趨勢,根據(jù)最近幾年 NLP 領(lǐng)域兩個(gè)頂會(huì) ACL 和 EMNLP 的文本生成相關(guān)論文統(tǒng)計(jì),2018 年之前相關(guān)論文投稿數(shù)僅有個(gè)位數(shù),而到 2019 年之后出現(xiàn)了激增,并一直保持在兩位數(shù)以上,說明相關(guān)話題在學(xué)術(shù)界已經(jīng)得到了足夠的關(guān)注。

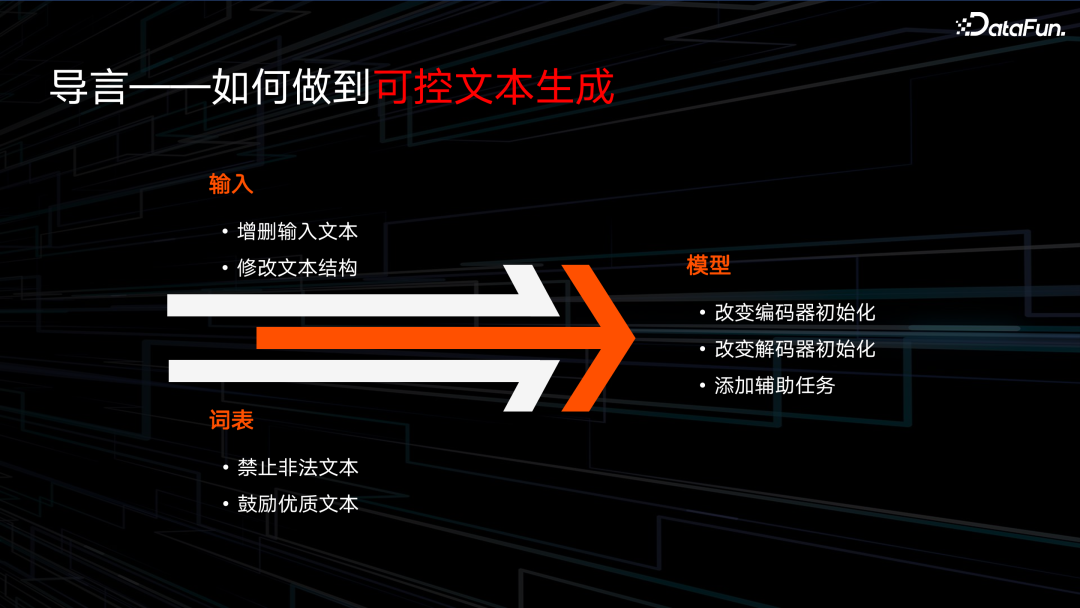

那么如何做到可控文本生成呢?主要有三個(gè)角度去實(shí)現(xiàn)。

首先第一個(gè)角度,是從輸入方面控制輸入文本,我們知道“garbage in garbage out”,如果輸入里面有非常多的垃圾信息,模型學(xué)習(xí)壓力就比較大。比如說一些違反廣告法的“最”、“頂級(jí)”等詞,就不希望出現(xiàn)在輸入里面。

第二個(gè)控制方向是詞表,比如希望某些詞(如賣點(diǎn)詞、屬性詞、知識(shí)圖譜相關(guān)的描述詞)被鼓勵(lì),或某些詞是被禁止的,我們可以以調(diào)整詞表的形式,在解碼端對(duì)詞的概率進(jìn)行調(diào)整。

第三個(gè)角度是模型,這是一個(gè)比較有效但難度也比較大的方式,例如可以通過改變解碼器的初始化、解碼器改變編碼器的初始化、添加一些輔助任務(wù)以及做一些多任務(wù)學(xué)習(xí)來調(diào)整模型。

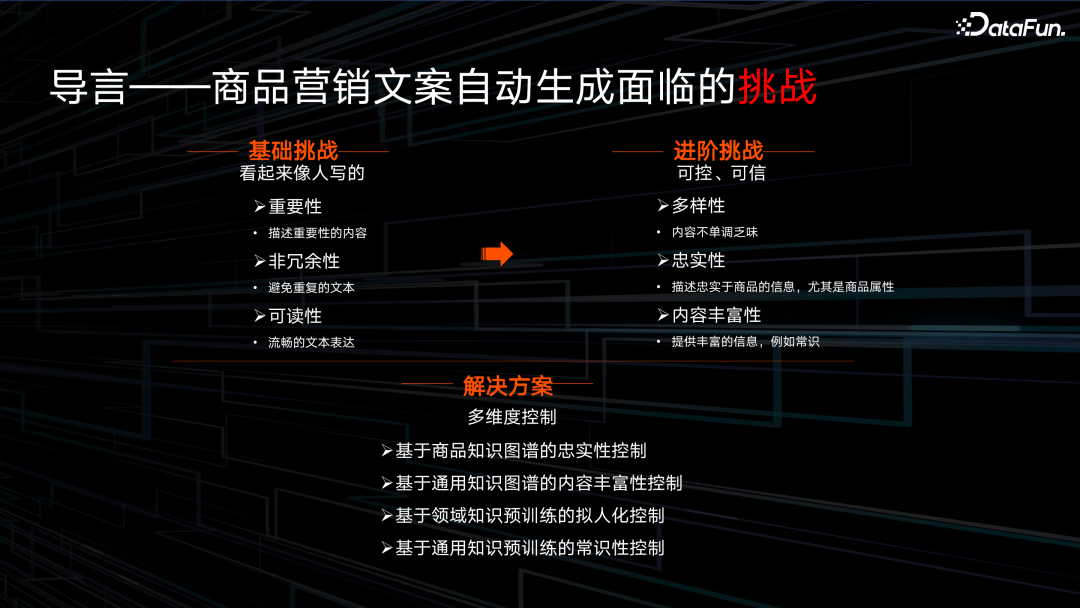

電商領(lǐng)域的文本生成研究面臨著非常多挑戰(zhàn)。

首先就是文本生成的基礎(chǔ)挑戰(zhàn)。所謂文本生成的基礎(chǔ)挑戰(zhàn)就是指無論在學(xué)術(shù)界使用,還是在做閑聊機(jī)器人、生成文案等任務(wù)時(shí),都會(huì)面臨的挑戰(zhàn),概括來說主要是希望生成的內(nèi)容像人寫的,有以下幾個(gè)性質(zhì)的表現(xiàn):

- 重要性,讓生成的文案會(huì)描述重要的內(nèi)容而不是閑聊。

- 非冗余性,當(dāng)生成一個(gè)較長的文案——例如 500 字文案——時(shí),不會(huì)一直重復(fù)某一個(gè)角度。

- 可讀性,要能比較流暢地表達(dá)。

在電商場景,會(huì)面臨一些進(jìn)階的要求:

- 多樣性,要求描述商品的角度非常豐富。

- 忠實(shí)性,要求描述出來的商品的屬性必須符合商品知識(shí)圖譜。

- 商品的內(nèi)容的豐富性,比如說除了描述商品本身的信息外,還希望有一些常識(shí)性的信息,例如有一些和通用知識(shí)圖譜相關(guān)的信息能夠展示給用戶,從而使文案的促銷性更強(qiáng)。

接下來,我們將針對(duì)上述提到的四個(gè)方面正式展開介紹。一是基于電商知識(shí)圖譜對(duì)真實(shí)性的控制,通過電商知識(shí)圖譜使屬性的描述更加忠實(shí)。二是基于通用知識(shí)圖譜的內(nèi)容豐富度拓展,讓商品的文案里面不僅有商品信息,還有額外的能夠引發(fā)用戶共鳴的信息。第三和第四個(gè)角度是在大模型方面的探索——將領(lǐng)域知識(shí)和通用知識(shí)融入到大模型里。

二、基于領(lǐng)域知識(shí)圖譜的商品文案生成

領(lǐng)域知識(shí)圖譜可以定義成一個(gè)屬性規(guī)格參數(shù),比如說一款洗衣機(jī)的兩個(gè)規(guī)格:

容量:9 kg,

產(chǎn)品類型:波輪洗衣機(jī)。

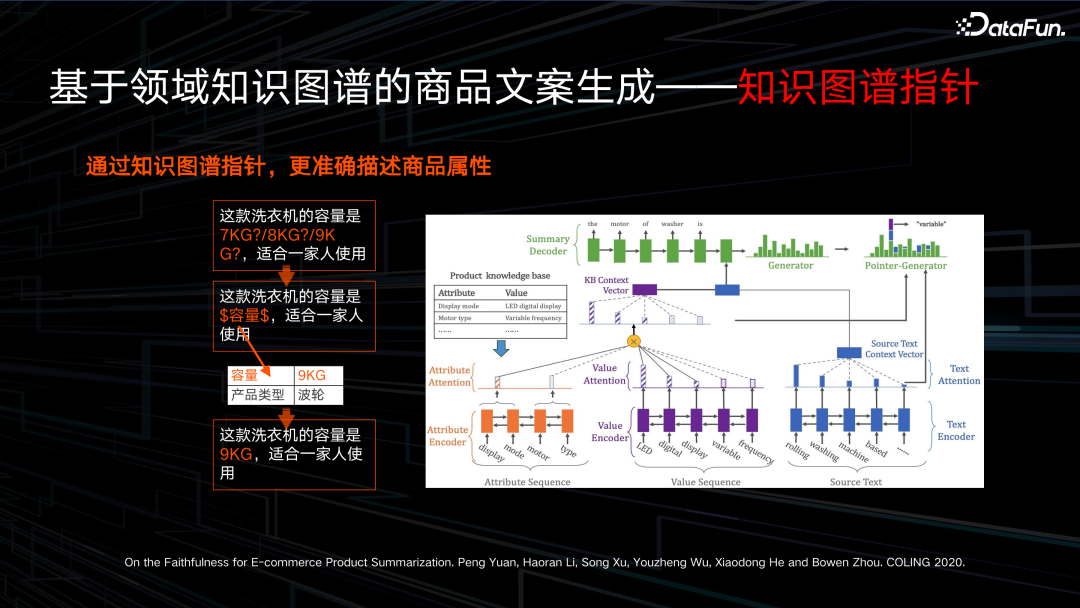

在這種情況下,有一些屬性很容易出現(xiàn)描述錯(cuò)誤的問題,比如說屬性值為數(shù)字的容量。我們通過查詢商品知識(shí)圖譜,很容易得知這款商品的容量是 9kg,但實(shí)際上眾多洗衣機(jī)里,還有各種其它規(guī)格的洗衣機(jī),比如一些非常尾部的 1-2kg 的小型洗衣機(jī),當(dāng)模型描述這些數(shù)字相關(guān)的屬性值的時(shí)候,很容易出錯(cuò)。我們可以回憶,早年在機(jī)器翻譯任務(wù)比較火熱時(shí),對(duì)數(shù)字的翻譯就一直是一個(gè)難題;現(xiàn)在在商品文案生成中,數(shù)字相關(guān)信息的處理也還是一個(gè)難點(diǎn),尤其對(duì)一些低頻的屬性數(shù)值。而在電商場景下,數(shù)值是一定不能出錯(cuò)的,否則很容易引發(fā)用戶的投訴。

在這里,我們想描述出真實(shí)的 9kg 這個(gè)屬性值,如何讓模型在解碼(模型解碼就是在一個(gè)大詞表里面去找到一個(gè)概率最高的值,讓模型去參考的信息是最正確的。)時(shí)找到最高、最好的那個(gè)正確值呢?模型可能有非常多的參考信息來源,第一種是模型通過理解輸入,綜合性地判斷哪個(gè)屬性值是正確的。第二種是,比如前面介紹的商品的各種描述——有可能來自于商品的標(biāo)題,有可能來自于商品詳情頁的文本——在成百上千字的文本里,找到這個(gè)正確屬性值。

第三種方式就是我想介紹的一個(gè)非常好的捷徑——通過商品知識(shí)圖譜直接查找。比如這里我們希望使模型意識(shí)到,當(dāng)他在描述到“這款洗衣機(jī)的容量是”時(shí),要形成一種模式讓模型知道這里要描述的是商品容量屬性。當(dāng)模型能學(xué)習(xí)到這個(gè)模式,就可以直接去查詢商品知識(shí)圖譜,找到容量對(duì)應(yīng)的屬性值,確保一定不會(huì)出錯(cuò)。而不必通過綜合理解輸入來判斷應(yīng)該輸入什么屬性值,綜合理解輸入對(duì)于模型是非常難的。

綜合來說,我們希望通過類似于檢索的形式,讓知識(shí)圖譜充當(dāng)一個(gè)指針,讓模型查詢知識(shí)圖譜,從而使商品屬性值一定不會(huì)出錯(cuò)。

如何用公式來表達(dá)這個(gè)過程呢?

首先是原始的復(fù)制機(jī)制,就是當(dāng)拿到商品屬性值時(shí),在輸入的所有信息里面找到一個(gè)正確的解碼的詞。那么我們提出的改進(jìn)的復(fù)制機(jī)制就不僅僅是從輸入的文本中進(jìn)行復(fù)制,而是先找到 token 的屬性類型,比如這里的“容量”,然后再檢索”容量”這一屬性對(duì)應(yīng)的屬性值,從而使這類屬性值 token 的解碼結(jié)果忠實(shí)度更高。

使用知識(shí)圖譜參與到過程里的一個(gè)難題是如何使知識(shí)圖譜能夠提供足夠的信息,電商平臺(tái)上的商品可能是上千萬甚至上億的,很多商品的知識(shí)圖譜是非常稀缺的。以服飾為例,電商場景下服飾是分 12 個(gè)季的,更換頻率非常高,有的大店鋪可能有幾千上萬件的商品,很容易有一些知識(shí)圖譜的缺失現(xiàn)象。我們希望利用商品的信息去補(bǔ)齊商品的知識(shí)圖譜,在補(bǔ)齊過程中,我們也注意到很多屬性值在補(bǔ)齊過程中會(huì)有一些“奇怪”現(xiàn)象,比如有時(shí)候會(huì)描述一個(gè)尺寸,但是我們不知道尺寸是內(nèi)徑還是外徑,有的會(huì)描述到一個(gè)長度,我們不知道是袖長還是褲長。但是通過觀察商品的圖片,我們很容易知道它的顏色,具體是描述哪個(gè)部分,或者說長度描述的是褲子還是上衣,所以我們希望利用商品的多模態(tài)信息——就是圖片信息和文本信息——一起補(bǔ)齊商品知識(shí)圖譜。

具體來說,商品的圖片信息可以提供兩方面的幫助,第一方面就是通過商品的圖片能夠清楚地知道某一部位的屬性是什么。比如可以通過觀察圖片里衣服的領(lǐng)子部分,知道領(lǐng)子是圓領(lǐng)還是直領(lǐng),所以這里用了一個(gè)局部的視覺門,就是想在描述不同的商品屬性時(shí),讓模型關(guān)注到具體商品圖片的某個(gè)區(qū)域。

第二個(gè)方面就是我們根據(jù)任務(wù)(我們定義的實(shí)際上是一個(gè)序列標(biāo)注任務(wù),就是從文本里邊去抽出具體的屬性對(duì)應(yīng)的屬性值)非常容易可以想到的方向:如何增強(qiáng)文本的理解。圖片實(shí)際上和文本之間是有跨模態(tài)的聯(lián)系的,所以我們希望利用圖片的信息去提升模型對(duì)文本的理解,所以這里定義了第二個(gè)門——一個(gè)全局視覺門——去利用圖片信息增強(qiáng)文本理解。最后在這兩個(gè)視覺信息的幫助下,完成商品知識(shí)圖譜的補(bǔ)齊問題。

下面是如何使用商品知識(shí)圖譜進(jìn)一步加強(qiáng)復(fù)制機(jī)制。

傳統(tǒng)的文本生成模型在生成文本時(shí)有一個(gè)非常好的機(jī)制——復(fù)制機(jī)制。解碼文本是由兩部分構(gòu)成的,第一部分是一個(gè)生成概率,需要計(jì)算生成詞表里哪個(gè)詞的概率是最大的,第二個(gè)方面是復(fù)制概率,計(jì)算在當(dāng)前時(shí)刻輸入里哪個(gè)詞放到輸出里,最終解碼概率實(shí)際上是兩個(gè)概率的疊加。傳統(tǒng)的復(fù)制概率,在選擇復(fù)制某一個(gè)詞時(shí),是從輸入里去復(fù)制,但是生成概率則不一定。

比如這個(gè)“美的”的變頻空調(diào),我們探討它會(huì)不會(huì)生成錯(cuò)誤的“定頻”屬性,傳統(tǒng)的復(fù)制概率在計(jì)算“定頻”的解碼概率時(shí),是由兩部分構(gòu)成,復(fù)制概率(Pcopy)和生成概率(Pgen),因?yàn)檩斎胫兄挥小白冾l”,沒有“定頻”,所以“定頻”的復(fù)制概率為 0。但是生成概率,因?yàn)椤倍l”和”變頻“這兩個(gè) token 都處于解碼詞表中,所以很難保證”定頻“的解碼生成概率一定等于 0。最終結(jié)論就是我們不能夠確保傳統(tǒng)的復(fù)制概率不生成一個(gè)錯(cuò)誤的屬性值——也就是”定頻“。所以我們對(duì)這種現(xiàn)象進(jìn)行了一個(gè)改進(jìn),就是在生成屬性值的時(shí)候,將生成概率置 0,也就是說當(dāng)生成屬性值時(shí),它的解碼概率只剩下復(fù)制概率,只有出現(xiàn)在輸入中的屬性值才能被解碼到輸出里,這樣就避免了錯(cuò)誤的屬性值出現(xiàn)在解碼文本中。

接下來我們看一下最終的實(shí)驗(yàn)結(jié)果。我們使用了從屬性詞表里復(fù)制以及加入屬性詞 Only-Copy,最終就能夠取得一個(gè)非常好的一個(gè)結(jié)果。從忠實(shí)度和可讀性人工評(píng)價(jià)表可以看出,最早的也就是第一個(gè)模型 PGNet 是傳統(tǒng)的 pointer-generator,傳統(tǒng)的復(fù)制模型忠實(shí)度只有 64%,加入 Only-Copy 機(jī)制之后能提升到 93% 以上。

三、基于通用知識(shí)圖譜的商品文案生成

接下來介紹如何將通用知識(shí)圖譜用在商品文案生成的場景里。

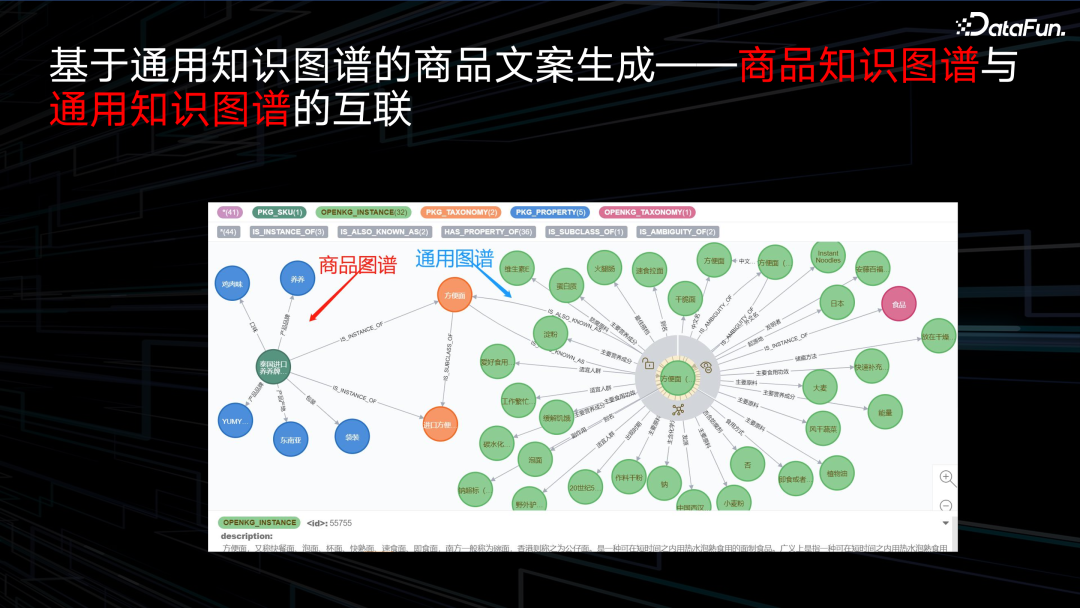

我們在實(shí)際使用知識(shí)圖譜時(shí),存在知識(shí)圖譜融合的問題,比如在使用商品知識(shí)圖譜時(shí),希望商品知識(shí)圖譜和通用知識(shí)圖譜互聯(lián),我們在這里互聯(lián)是比較簡單地使用產(chǎn)品詞作為一個(gè)橋梁進(jìn)行互聯(lián),比如一個(gè)方便面,我們從商品的知識(shí)圖譜里知道產(chǎn)地、原材料等,但是通用知識(shí)圖譜——就是右邊綠色的圖譜——能給我們提供更加豐富的信息,比如在食用方便面時(shí)能搭配什么,方便面的原材料會(huì)有一些什么,會(huì)有一些什么樣的食用場景。在這種情況下,我們就能給用戶提供更多的信息,比如當(dāng)你在工作繁忙,沒有時(shí)間做飯,你可以食用方便面,然后使文案更具有促銷效果。

當(dāng)然我們也注意到一個(gè)問題,就是當(dāng)使用商品知識(shí)圖譜時(shí),當(dāng)前商品的商品知識(shí)圖譜——也就說它的屬性和屬性值——都是符合當(dāng)前商品的。但是我們關(guān)聯(lián)進(jìn)來的通用知識(shí)圖譜里的一些信息,它并不一定忠實(shí)于我們當(dāng)前的商品。比如說方便面,是有小麥作為原料也有蕎麥作為原料的,通常很難區(qū)分出哪個(gè)通用知識(shí)圖譜引進(jìn)的信息是忠實(shí)的,但是又希望能使用通用知識(shí)圖譜,所以我們進(jìn)行一定改進(jìn),將輸入信息的信息來源做了一個(gè) token,因?yàn)閭鹘y(tǒng)做編碼時(shí),基于 Transformer 模型是有兩部分編碼的,一部分是輸入 token,另外一部分是位置信息,那么這時(shí)我們加入第三部分,就是 token 的類別信息,比如來自于商品類目的描述 token,它描述的是商品的產(chǎn)品詞,然后 token 是來自于商品商詳,或者說來自于商品的知識(shí)圖譜,或者來自于通用知識(shí)圖譜,那么引入 token 向量想要做什么事呢?就是當(dāng)我們模型在解碼時(shí),在參考輸入信息的過程中,如果是參考的是商品知識(shí)圖譜應(yīng)該完全信賴,但是在使用通用知識(shí)圖譜時(shí),應(yīng)該選擇性地使用,而不是一味從里面拿信息。

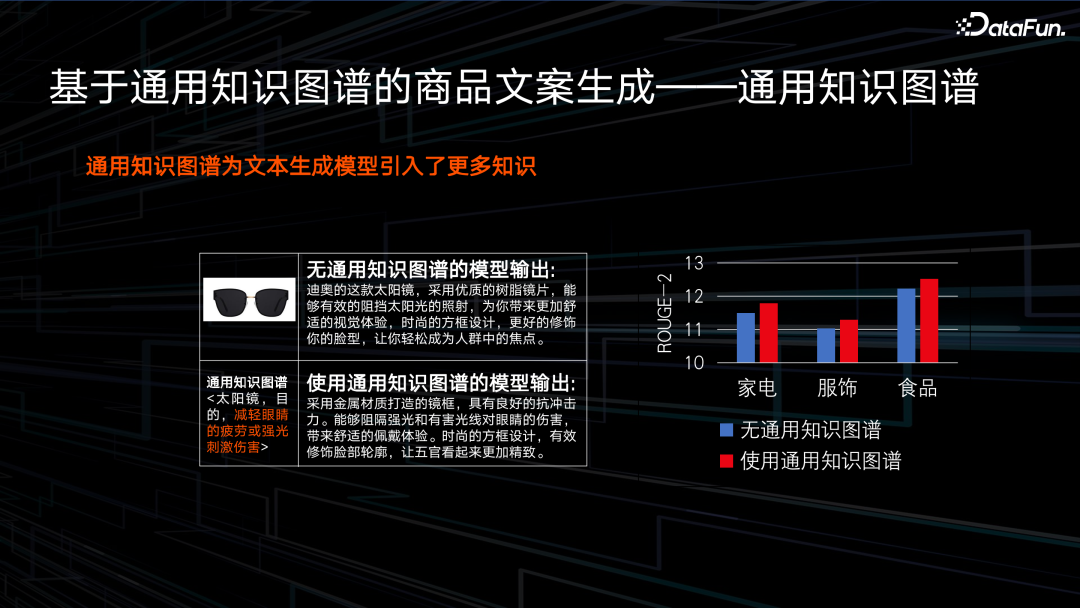

最終我們可以看一個(gè) case,就是當(dāng)我們引入通用知識(shí)圖譜后,比如對(duì)于一款太陽眼鏡,它的功效是能夠減輕眼睛疲勞和強(qiáng)光的刺激傷害,引入通用知識(shí)圖譜之后,它會(huì)對(duì)功效信息做一個(gè)描述,它描述的信息就是能夠阻隔強(qiáng)光和有害光線對(duì)眼睛的傷害。我們在家電、服飾、食品三個(gè)類目上評(píng)測了 ROUGE 指標(biāo)。所謂 ROUGE 指標(biāo)就是衡量模型生成的文案和人工寫的文案之間有多少相似度。可以看到,加入了商品通用知識(shí)圖譜之后,也就是圖里的紅色柱形,ROUGE 指標(biāo)有一定提升。

在使用改進(jìn)之后,其實(shí)還有另外一個(gè)發(fā)現(xiàn),就是當(dāng)我們將 token 的類別信息加入后,模型對(duì)產(chǎn)品詞的描述有一個(gè)比較明顯提升。如果讀第一個(gè)文案的時(shí)候,他沒有提到耳機(jī),我們有可能還認(rèn)為它是一個(gè)手機(jī),加入 token 類別向量之后,他明確地描述這是一款耳機(jī),這其實(shí)對(duì)我們來說是非常希望看到的一個(gè)現(xiàn)象。

四、基于領(lǐng)域知識(shí)圖譜的 LLM

下面分享一下我們在大模型方面的探索,首先是基于領(lǐng)域知識(shí)圖譜的一個(gè)大模型。

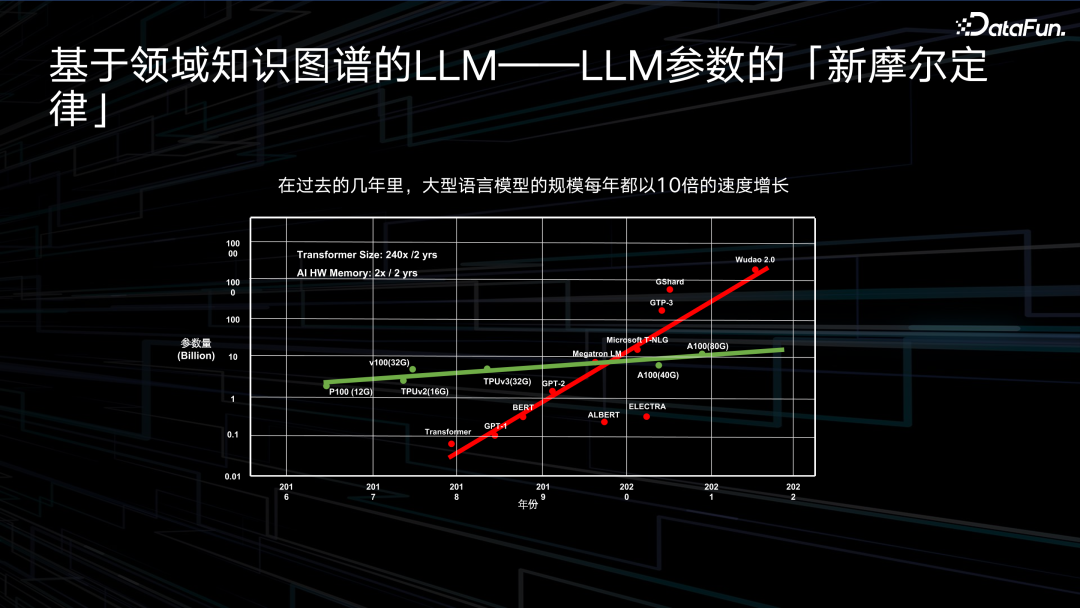

近幾年,大模型的發(fā)展非常迅猛,從 2017 年 Transformer 出現(xiàn)之后,這幾年模型參數(shù)量已經(jīng)由十億、百億,增長到了萬億級(jí)別。但是硬件資源進(jìn)展卻非常緩慢,還是停留在兩三年前的 A100 這樣一個(gè)水平,雖說現(xiàn)在推出了 H800、A800,但是實(shí)際計(jì)算能力上沒有見到明顯的提升,所以在這種情況下,到底應(yīng)該怎么去看待大模型,也是值得我們思考的一個(gè)話題。

我們可以簡單回顧一下,從最開始推出的大家關(guān)注到的通用大模型,比如說在自然語言理解 NLU(Natural Language Understanding)方向,有個(gè)非常里程碑式的就是 BERT(Bidirectional Encoder Representation from Transformers)模型,以及文本生成方向,有一個(gè)非常里程碑的 BART(Bidirectional and Auto-Regressive Transformers)模型,分別作用在文本生成、文本摘要或者一些翻譯任務(wù)上。然后業(yè)界出現(xiàn)了一些基于通用知識(shí)的大模型,比如說基于知識(shí)圖譜的 KGPT(Knowledge-grounded Pre-training),以及百度提出的 ERNIE。我們針對(duì)趨勢做了一些思考,就是如何將大模型真正應(yīng)用于產(chǎn)業(yè)界或者應(yīng)用場景里為我們創(chuàng)造價(jià)值。我們最終得出的結(jié)論是領(lǐng)域大模型,面臨的挑戰(zhàn)是如何將領(lǐng)域知識(shí)圖譜或者領(lǐng)域知識(shí)融合到大模型里面。

為了實(shí)現(xiàn)這一目標(biāo),我們首先要定義我們需要的領(lǐng)域知識(shí),這里定義了四類領(lǐng)域知識(shí):

- 比較通用的商品的知識(shí)圖譜,比如商品的二元組信息,商品的一些相關(guān)聯(lián)的通用知識(shí)圖譜信息等。

- 商品的要素知識(shí),要素知識(shí)其實(shí)是對(duì)商品知識(shí)圖譜的一個(gè)凝練,商品知識(shí)圖譜或商品屬性的某些類目量級(jí)是非常大的,可能有幾萬甚至幾十萬這樣一個(gè)量級(jí),這導(dǎo)致某些尾部商品的知識(shí)圖譜非常低頻,所以我們需要對(duì)這些知識(shí)圖譜,或者對(duì)他的一些 schema 進(jìn)行一些重新設(shè)計(jì),這就是我們的商品要素。

- 一些類別信息,比如說商品它是耳機(jī)還是手機(jī)。

- 商品賣點(diǎn),我們希望賣點(diǎn)知識(shí)被我們文案生成模型更好的去捕捉到,從而有助于賣點(diǎn)文案生成的場景。

針對(duì)這四類知識(shí),我們定義了五個(gè)預(yù)訓(xùn)練任務(wù),前兩類是比較通用的掩碼的語言模型任務(wù),分別是掩碼生成單個(gè)詞和掩碼生成文本片段,我們在設(shè)計(jì)這樣的任務(wù)時(shí),也著重對(duì)知識(shí)信息優(yōu)先去掩碼。剩下三類是針對(duì)我們的知識(shí)去設(shè)計(jì)的三類預(yù)訓(xùn)練任務(wù)。第三類是商品的要素檢測任務(wù),因?yàn)樵诿枋鲆豢钌唐窌r(shí)會(huì)分很多角度,比如說在描述洗衣機(jī)時(shí),會(huì)描述它的電機(jī)、是否靜音,我們能否讓模型意識(shí)到前兩句是在描述電機(jī),后兩句在描述靜音,實(shí)際上就是去檢測這兩個(gè)要素的分界點(diǎn)。第四個(gè)任務(wù)是商品的類別分類任務(wù),我們需要讓模型意識(shí)到商品的文案是在描述耳機(jī)而不是手機(jī)。第五個(gè)是商品的賣點(diǎn)短語,或者說商品賣點(diǎn)句,它的生成任務(wù)實(shí)際上是為了作用在 AIGC 場景里,通過設(shè)計(jì)我們希望模型在預(yù)訓(xùn)練過程中既能學(xué)習(xí)到一些語言相關(guān)的信息,也能學(xué)習(xí)到知識(shí)圖譜相關(guān)的信息。

接下來是對(duì)我們模型的一個(gè)評(píng)價(jià),我們分別測評(píng)了 NLU 任務(wù)和 NLG 任務(wù),分別是知識(shí)圖譜補(bǔ)齊、電商多輪對(duì)話以及商品摘要生成任務(wù)。一共測試了三類模型,一個(gè)是 C-PLUG,C-PLUG 就是通用的、不加入任何知識(shí)的模型;一個(gè)是 E-PLUG 就是將通用知識(shí)加入到模型里去;最后就是 K-PLUG,是將電商知識(shí)注入到模型中去。我們發(fā)現(xiàn)加入電商知識(shí)后,在我們電商領(lǐng)域下的三個(gè)下游任務(wù)上,模型表現(xiàn)有一個(gè)比較明顯的提升。然后這里我們也給大家看一個(gè)非常有意思的 case,是一個(gè)電商場景下的真實(shí)場景。一個(gè)紙皮核桃,它的尺寸在三到五厘米,產(chǎn)地是新疆,然后模型根據(jù)商品的知識(shí)圖譜回復(fù)顧客,顧客其實(shí)問的就是這是不是紙皮核桃,然后是不是特級(jí)的紙皮核桃。但是我們把問題輸入給 ChatGPT,當(dāng)然也是把商品的知識(shí)圖譜以知識(shí)注入的形式輸給了 ChatGPT,但是 ChatGPT 并沒有意識(shí)到“特級(jí)”是什么意思,因?yàn)樗鼪]有特級(jí)的評(píng)價(jià)指標(biāo)。但是如果是有領(lǐng)域知識(shí)的,就可以知道“特級(jí)”其實(shí)就是尺寸在三到五厘米的這個(gè)尺寸內(nèi),通過融入知識(shí),模型能夠意識(shí)到,如果它的尺寸是三到五厘米,那就是一個(gè)特級(jí)核桃。

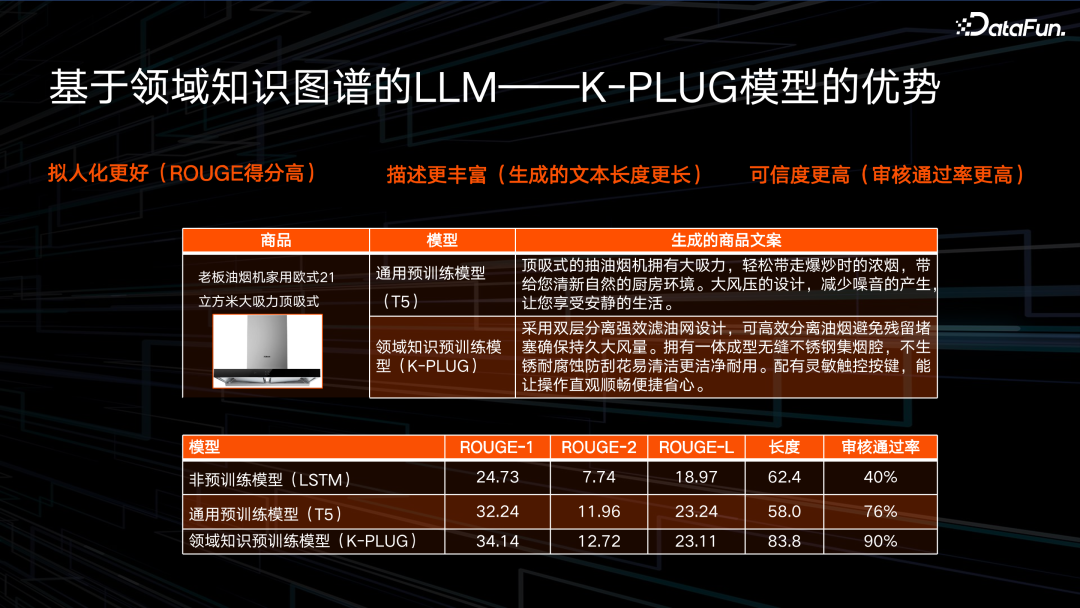

這是我們在一個(gè)文本生成任務(wù)里的一個(gè)更直觀的評(píng)測,我們發(fā)現(xiàn)三點(diǎn):第一個(gè)就是融入知識(shí)后,擬人化更好,也就是 ROUGE 得分更高,模型生成的文案和人寫的文案相似度更高。第二個(gè)角度就是描述更豐富,我們對(duì)比了通用預(yù)訓(xùn)練模型 T5,它的描述的長度只能達(dá)到 60 個(gè)字左右,而融入知識(shí)訓(xùn)練后,單條文案的描述長度能達(dá)到 80 個(gè)字以上。第三點(diǎn)就是它的可信度會(huì)更高,通過對(duì)模型進(jìn)行人工評(píng)測,我們可以看到傳統(tǒng)通用的預(yù)訓(xùn)練模型 T5 只能達(dá)到 76% 的審核通過率,而我們模型僅僅是融入知識(shí)的訓(xùn)練,沒有做任何的后處理,就能達(dá)到 90% 的審核通過率。

五、基于通用知識(shí)圖譜的 LLM

最后要分享的是如何使用通用知識(shí)圖譜去加強(qiáng)預(yù)訓(xùn)練語言模型。

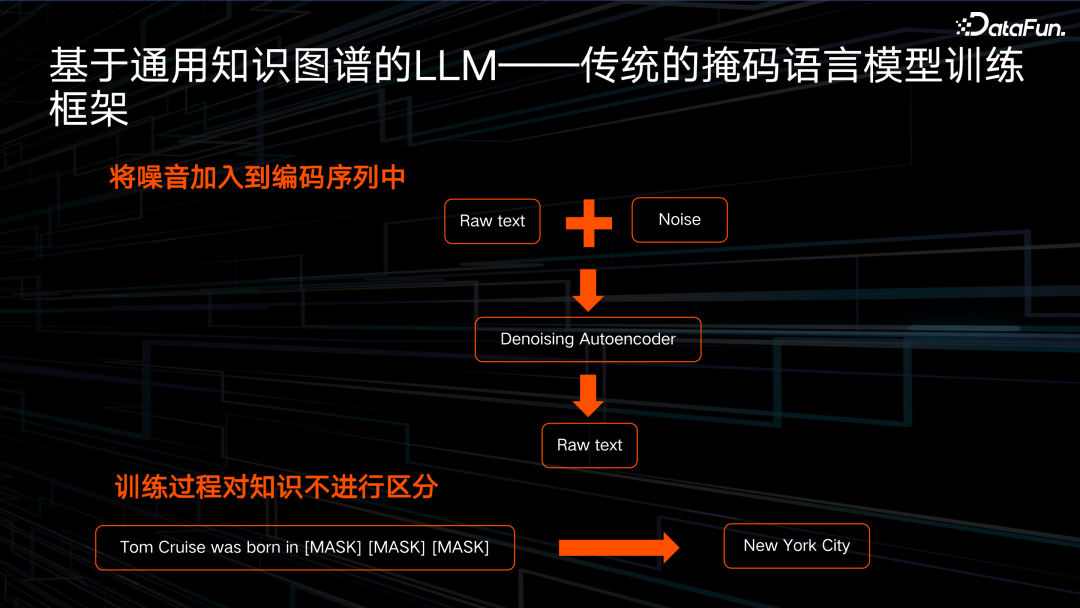

最初代的預(yù)訓(xùn)練語言模型有一個(gè)預(yù)訓(xùn)練方式是去噪的自編碼器,就是選擇性或者隨機(jī)性地對(duì)輸入文本進(jìn)行掩碼,輸入在掩碼過程中變成一個(gè)含噪音的輸入,然后希望文本生成模型對(duì)輸入去噪。但是我們發(fā)現(xiàn)其中有一些問題的,第一個(gè)方面是在訓(xùn)練過程中,模型不會(huì)對(duì)所有的信息進(jìn)行區(qū)分對(duì)待,比如如果是對(duì)知識(shí)進(jìn)行加強(qiáng)學(xué)習(xí),我們會(huì)希望知識(shí)的掩碼概率要大。第二個(gè)方面是在訓(xùn)練過程中,無論是掩碼語言模型,還是現(xiàn)在比較流行的 Decoder-only 的語言模型,訓(xùn)練方式都是 Teacher-Forcing 的形式,就是當(dāng)我們預(yù)測下一個(gè)詞時(shí),模型會(huì)給到上個(gè)詞或者說歷史信息的真值的詞。

這里舉一個(gè)例子,傳統(tǒng)的預(yù)訓(xùn)練語言模型在預(yù)訓(xùn)練的時(shí)候,比如要訓(xùn)練 Tom Cruise 出生于什么地方,這時(shí)因?yàn)樗鎸?shí)出生地是紐約,那么在預(yù)測出生地第一個(gè)字時(shí),模型可能根據(jù)上文“出生于”,預(yù)測出第一個(gè)字是“紐”,但是可能模型沒有學(xué)習(xí)到這樣一個(gè)知識(shí),所以預(yù)測出來的是華盛頓,也就是算出來概率最高的第一個(gè)字是“華”,但是在預(yù)測第二個(gè)詞時(shí),模型不會(huì)將第一個(gè)詞最高的那個(gè)概率“華”作為輸入,而會(huì)把“紐”詞作為輸入預(yù)測“約”。這會(huì)導(dǎo)致雖然我們看起來模型使用的是“紐約”詞做訓(xùn)練,但實(shí)際上它根本就沒有學(xué)習(xí)到這個(gè)知識(shí),它還是認(rèn)為華盛頓才是 Tom Cruise 的出生地,也就是這種 Teacher-Forcing 形式并不足以使模型很好地學(xué)習(xí)到知識(shí)的表達(dá)。

為了解決這個(gè)問題,我們提出了一個(gè)不僅要在編碼器或者在輸入信息里加噪,還要在輸出里加噪,就是當(dāng)模型去預(yù)測這樣的一個(gè)知識(shí) entity(實(shí)體)時(shí),我們并不只是用 Teacher-Forcing形式,而是要讓他完整地預(yù)測,比如說在預(yù)測第二詞“約”時(shí),我們并不把“紐”作為一個(gè)輸入,而是把噪音作為輸入,例如一個(gè)[MASK]token,讓模型完整地依次預(yù)測出“紐”、“約”這兩個(gè)字。

具體來說就是傳統(tǒng)的掩碼只在 Encoder(編碼器)端加噪,比如說對(duì)所有的詞隨機(jī)加噪,80% 換成一個(gè)[MASK]字符,10% 替換成隨機(jī)字符,10% 保持不變,然后在 Decoder(解碼器)端不再做加噪處理。但是我們提出的策略,不僅延續(xù)了在編碼器加噪的處理,在解碼器也會(huì)加噪。也就是在我們已經(jīng)解碼出的文本里,不是將一個(gè) Ground-Truth 的 token 作為 Decoder 的一個(gè)輸入,而是說有 80% 替換成一個(gè)[MASK]字符,10% 替換成一個(gè)隨機(jī) token,10% 保持不變的這樣一個(gè)加噪方式,讓模型去完整地預(yù)測出一個(gè)實(shí)體 token。當(dāng)然,雖然我們這些工作是 2022 年 EMNLP 的工作,當(dāng)時(shí) Decoder-only 框架可能還沒引起大家的轟動(dòng),但實(shí)際上,我們提出的訓(xùn)練框架也是能夠很好適用于 Decoder-only 框架的。

我們也圍繞實(shí)體 NLG 的任務(wù),在 WebNLG 和 WikiBio 這兩個(gè)數(shù)據(jù)上進(jìn)行了測試,可以看到我們提出的面向知識(shí)的、在解碼側(cè)加入噪音的掩碼預(yù)訓(xùn)練大模型的提升是非常明顯的。