國產動漫視頻AI火了!二次元老婆隨意捏,哥特、夢幻、機甲一鍵get

現在,各位二次元萌新們,不用再等「太太」出圖啦!

我們不僅可以自己產糧,而且還是會動的那種。

圖片

圖片

圖片

圖片

如今,AI視頻生成這個賽道,可謂是殺得如火如荼。這些更新更強的模型,思路和Scaling Law一脈相承,主打一個「又大又全」。

然而出圖效果如何,全靠「抽卡」運氣,更別提真實視頻生成的恐怖谷效應、動漫視頻生成的畫風突變。

圖片

圖片

和大語言模型類似,在應用落地上想要全盤通吃的,就很難根據行業特征和專屬訴求去進行專注的服務。

尤其是對于「二刺螈」小編來說,一直以來都沒有找到合適的模型。

畢竟,作為普通動漫愛好者,想要和喜愛的角色同框出鏡,或二創,沒有繪畫技能也只能空想。

從腳本構思、關鍵幀繪圖、骨骼綁定到動態渲染,都需要付出大量的時間和精力。

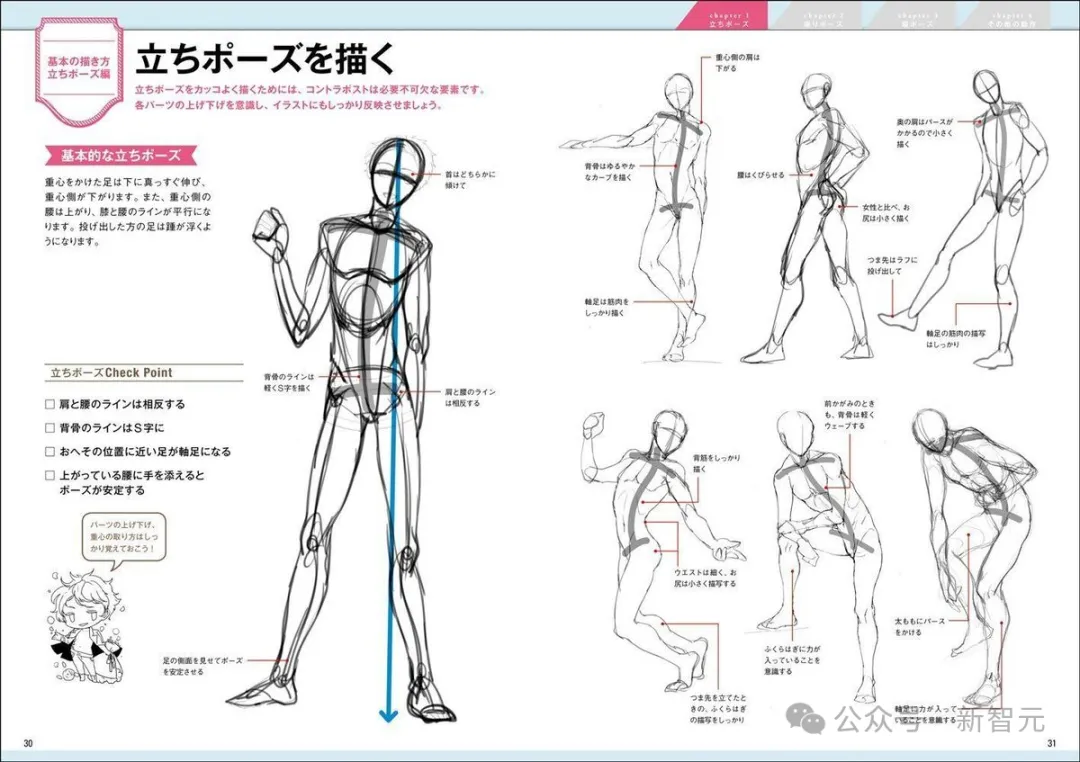

圖片

圖片

來源網絡

最近,小編發現了一個專為二次元打造的創作網站「YoYo」——

只需通過文字提示或者上傳圖片等簡單操作,即可一鍵獲得生成高質量一致性強的動漫內容,讓喜歡的角色栩栩如生地出現在「同人視頻」中了!

圖片

圖片

大陸站傳送門:yoyo.avolutionai.com

國際站傳送門:yoyo.art

同人視頻一鍵get

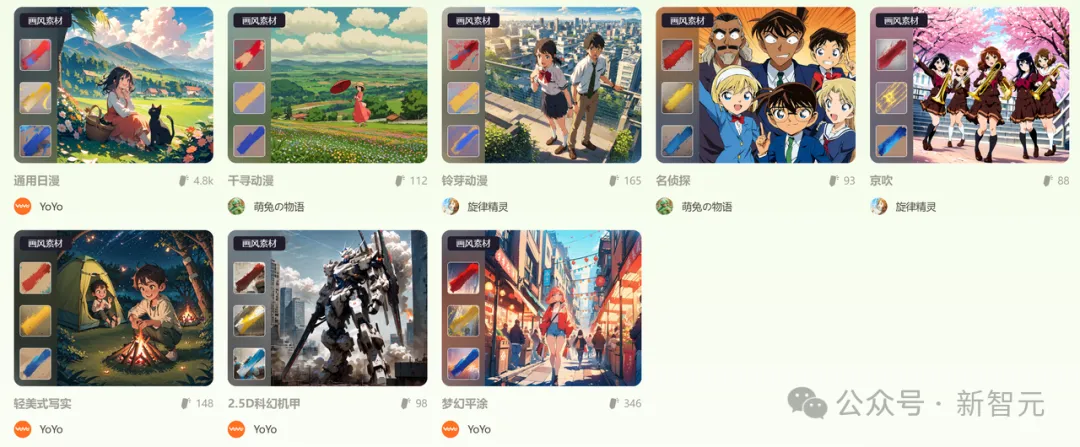

可以看到,YoYo不僅創作界面簡潔,而且操作起來也非常容易上手。

而且最重要的是,對于動漫愛好者和創作者來說,二次元氛圍沉浸感極強。

不管是提示詞還是圖片,都有著非常豐富的高質量素材——幾十個流行人物角色,以及通用、平涂、機甲等各種風格,可謂是一站式集齊,讓人直呼過癮。

這些定制選擇,可以在生成過程中控制角色的設計、故事走向,甚至是每一個細微的動畫效果。

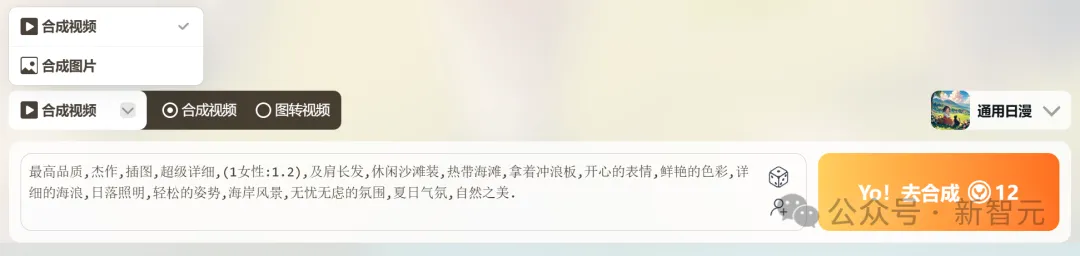

圖文生動漫

話不多說,先來一波實測。

櫻花飄落、頷首淺笑,再加上精致的的背景和服裝,日漫的氛圍感一下就出來了。

圖片

圖片

prompt:穿著和服的女子在開滿印花的庭院

燃燒的蠟燭,火焰般的眼眸,黑色的lolita,詭異的氛圍,拿捏得十分到位。

圖片

圖片

prompt:最高品質,杰作,插圖,超級詳細,(1女性:1.2),及肩長發,哥特服飾,鬧鬼的大廈,拿著蠟燭,詭異

接下來,再看看出色的人物一致性。(白毛控狂喜)

從嫉惡如仇的屠龍少女——

圖片

圖片

prompt:1girl ,hair between eyes ,white hair, blue eyes,long hair,no hat,white dress ,elf,pointy ears, fight with a big dragon, sword

到林間散步的青澀女孩——

圖片

圖片

prompt:1girl,white hair,elf,blue eyes,long hair,pointy ears,sitting in river,stars,white dress,pink canvas backpack,taking a walk in the forest

亦或是坐在水中的精靈公主——

圖片

圖片

prompt:1girl,white hair,elf,blue eyes,long hair,pointy ears,sitting in river,stars,white dress,sitting quietly on the water

順便一提,中英混合的prompt也是可以支持的。

圖片

圖片

prompt:1girl,hair between eyes,white hair,blue eyes,long hair,no hat,white dress,elf,pointy ears,瀑布,坐在瀑布下面,雙手合十,閉眼

從上面這些動圖可見,AI還原出了精準而富有表現力的人物表情,讓短短幾秒的視頻充滿了故事感。

頭發、蒲公英和身上的裙子,一同在隨風飄動非常自然。

圖片

圖片

prompt:一個紫色長發的女孩,在長滿蒲公英的草原迎風微笑,天空中閃爍極光

落下的雪和杯中的熱氣升騰,即使相互交織在一起也能一眼分清。

圖片

圖片

prompt:一個圍著圍巾的短發女孩,在大雪天喝著熱茶

一臺巨大的「蘿卜」矗立在城市里,林立的高樓描繪出震撼的場景。

圖片

圖片

prompt:機甲,無人,獨自,云,武器,科幻,發光,天空,拿著武器,建筑物,城市

除了人物角色之外,背景的生成也非常有電影鏡頭的感覺。

圖片

圖片

prompt:夢幻的森林大陸的鳥瞰全貌,有森林湖泊,有小小的城鎮,也有遠遠的高山

圖片

圖片

prompt:一個古樸小鎮熱鬧的街市

從此,不論我們腦海有多么奇幻的場景,都可以讓它在動畫中還原出來了!

圖片

圖片

prompt:夢幻的森林大陸上的森林,小兔子,小松鼠,五彩的蘑菇

圖片

圖片

prompt:一只通體雪白,角生梅花的鹿站在雪山頂峰眺望遠方,身邊發出微光

畫面一鍵「復刻」

在「風物」這個場景中,我們可以一鍵「復刻」同好們生成的心儀場景。

圖片

圖片

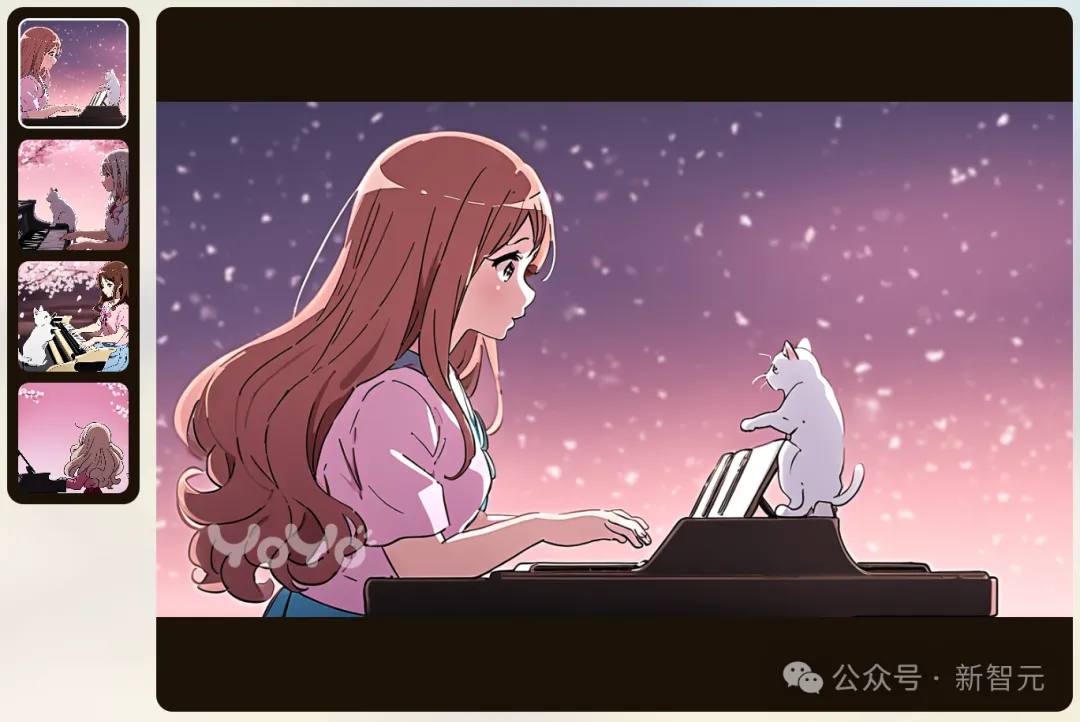

選擇「取材」后,模型根據同樣的prompt,就生成了類似風格的圖。

圖片

圖片

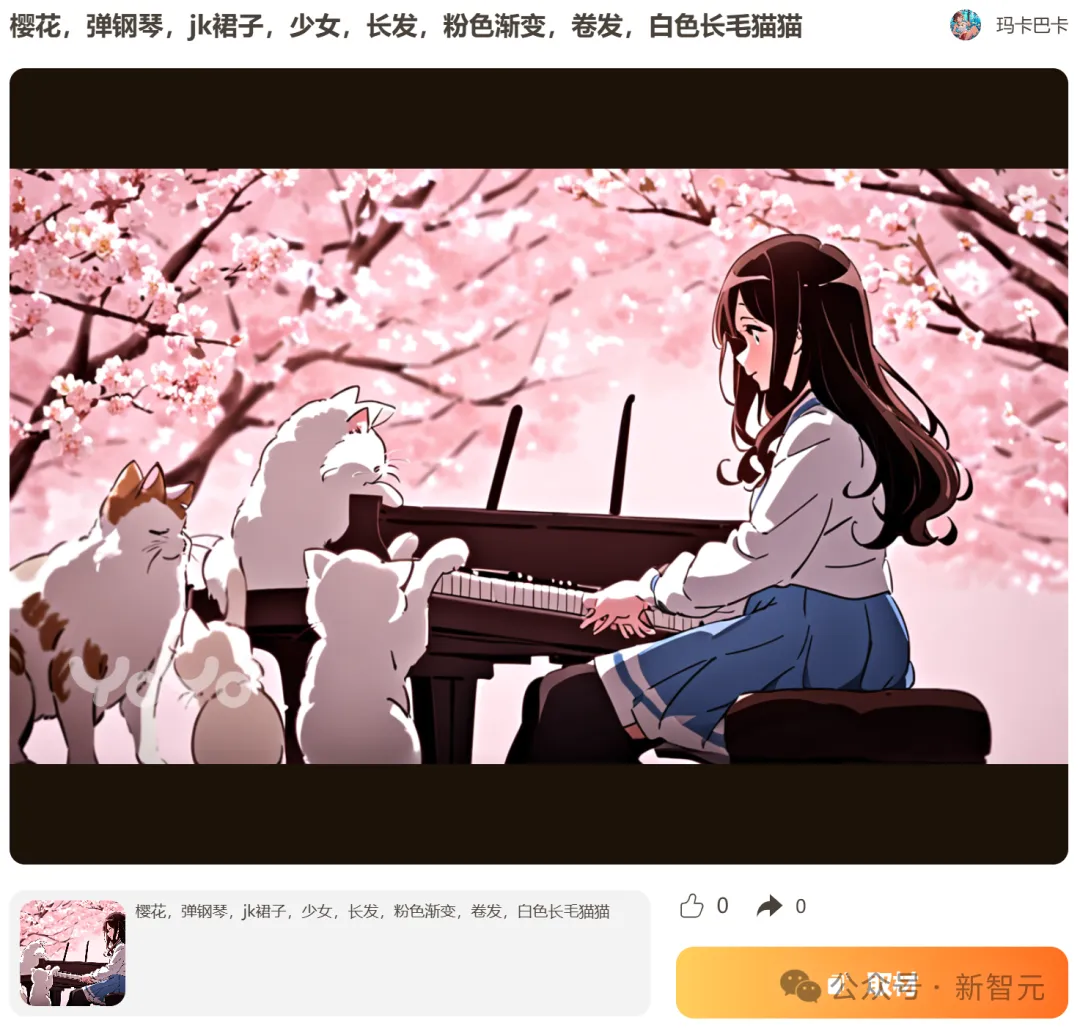

接著點「生成視頻」——穿著JK制服的長發女孩,和彈鋼琴的白色貓貓,這畫面簡直不要太美。

圖片

圖片

生成模型

當前AI生成的視頻存在兩大技術缺陷,一是可控性,二是生成速度。

以往的模型大多使用圖像或文本指令作為生成條件,但缺少對視頻中動作的精確、交互式控制。在生成視頻時速度也非常慢,這對于C端應用來說也會嚴重影響用戶體驗。

為了解決這些模型缺陷,鹿影團隊長期專注于技術攻關,并取得了豐碩的成果,發表了多篇「干貨滿滿」的高水平論文。

Motion-I2V

今年1月剛剛發表的Motion-I2V論文提出了創新的圖生視頻框架,對于復雜圖像,也能生成一致且可控的視頻。

圖片

圖片

論文地址:https://arxiv.org/abs/2401.15977

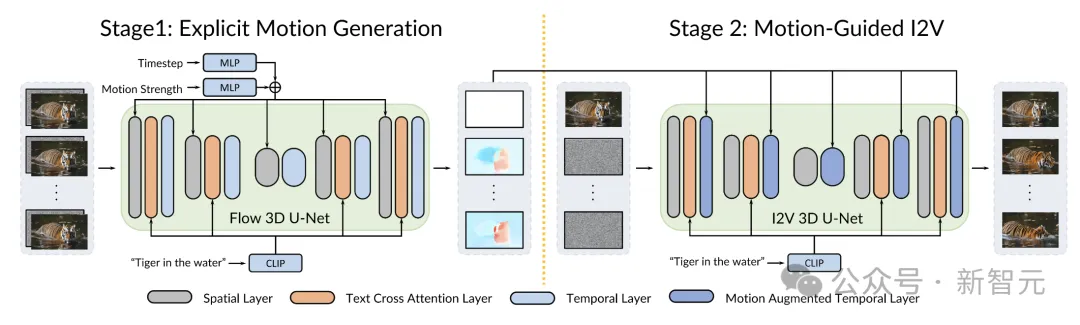

之前的方法,例如AnimateDiff架構,通常會讓模型同時負責運動建模和視頻生成,直接學習從圖像到視頻的映射關系。

論文提出,這種合二為一的做法會導致細節上的動作失真和時序不一致。Motion-I2V則選擇解耦這兩個過程。

第一階段使用基于擴散模型的運動場預測器(motion field predictor),參考給定的圖像和文本提示,專注于像素級的運動軌跡推斷,預測參考幀和所有未來幀之間的運動場映射。

第二階段則提出了一種新穎的運動增強時序層,用于增強模型中有限的一維時間注意力。這個操作可以擴大時序感受域,減輕了同時學習時空模式的復雜性。

圖片

圖片

有了第一階段軌跡預測的指導,第二階段的模型能更有效地將所給圖像的特征傳播至合成的視頻幀,加上稀疏的軌跡控制網絡Control-Net,Motion-I2V還可以支持用戶對運動軌跡和運動區域的精準控制。

與僅依賴文本prompt相比,這種方法為I2V過程提供了更多的可控性。此外,第二階段的模型還天然地支持零樣本生成,以及視頻到視頻的轉換。

與現有方法相比,即使在運動幅度較大、視角變化的情況下,Motion-I2V也能生成更一致的視頻。

從demo中可以明顯看出,相比Pika、Gen-2等模型,Motion-I2V的確能模擬出更好的運動形態,視覺細節也更逼真。

圖片

圖片

AnimateLCM

在文生視頻方面,今年2月發表的AnimateLCM模型公開了源代碼和預訓練權重,僅需4個迭代步驟就能生成質量優秀的動畫,因此受到了開源社區的廣泛歡迎,僅單月下載量就超過6萬。

圖片

圖片

倉庫地址:https://huggingface.co/wangfuyun/AnimateLCM

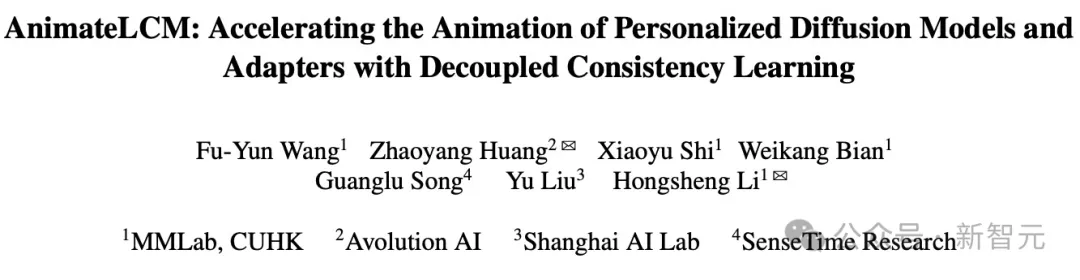

文章提出,擴散模型的雖然有優秀的生成效果,但其中迭代去噪過程包含30~50個步驟,計算量很大且比較費時,因而對實際應用造成了限制。

團隊從潛在一致性模型(Latent Consistency Model,LCM)中得到啟發,旨在用最少步驟生成高質量的逼真模型。

圖片

圖片

論文地址:https://arxiv.org/abs/2402.00769

AnimateLCM沒有直接在原始的視頻數據集上進行訓練,而是從訓練好的Stable Diffusion模型中蒸餾出先驗知識。并且采用了解耦策略,將圖像生成和運動生成的先驗分開,再對圖像模型進行3D膨脹,能夠提高訓練效率和生成質量。

圖片

圖片

此外,為了讓AnimateLCM模型更好地適應社區中被廣泛應用的各種適配器(adapter),論文提出了一種不需要額外教師模型的「加速」策略來訓練適配器。

實驗證明,這種策略行之有效。搭配圖像條件適配器或布局條件適配器時都有很好的兼容性,不僅沒有損害采樣效率,還實現了模型功能的擴展。

除了文生視頻和圖生視頻,AnimateLCM還能在零樣本情況下進行高效的視頻風格遷移,或者用于擴展視頻長度,最多可達到基本長度的4倍,并且實現了近乎完美的一致性。

圖片

圖片

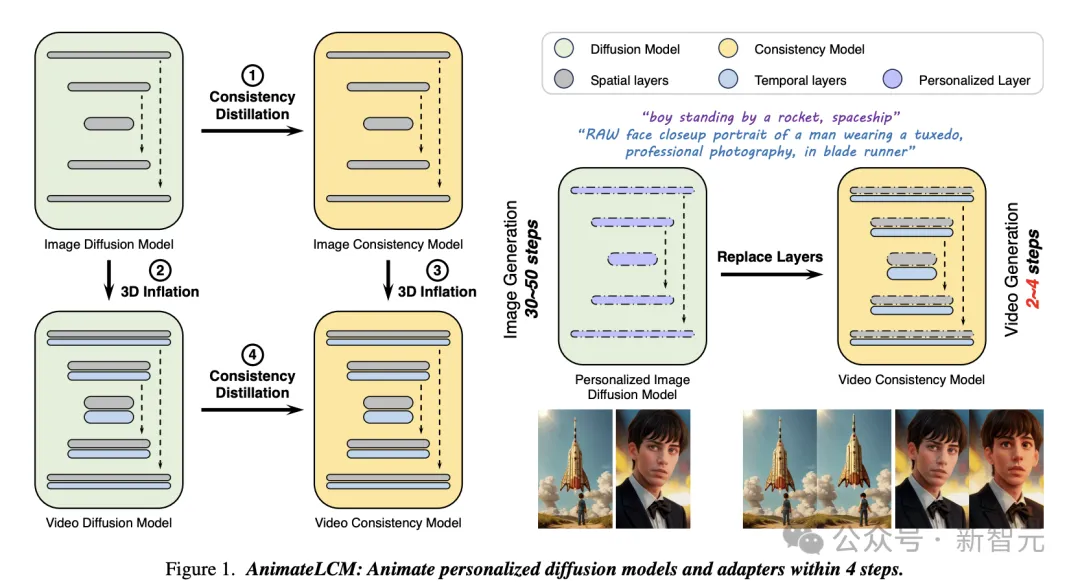

Phased Consistency Model

雖然AnimateLCM已經取得了很好的效果,但開發團隊并沒有就此止步,而是選擇在此基礎上進一步探索。

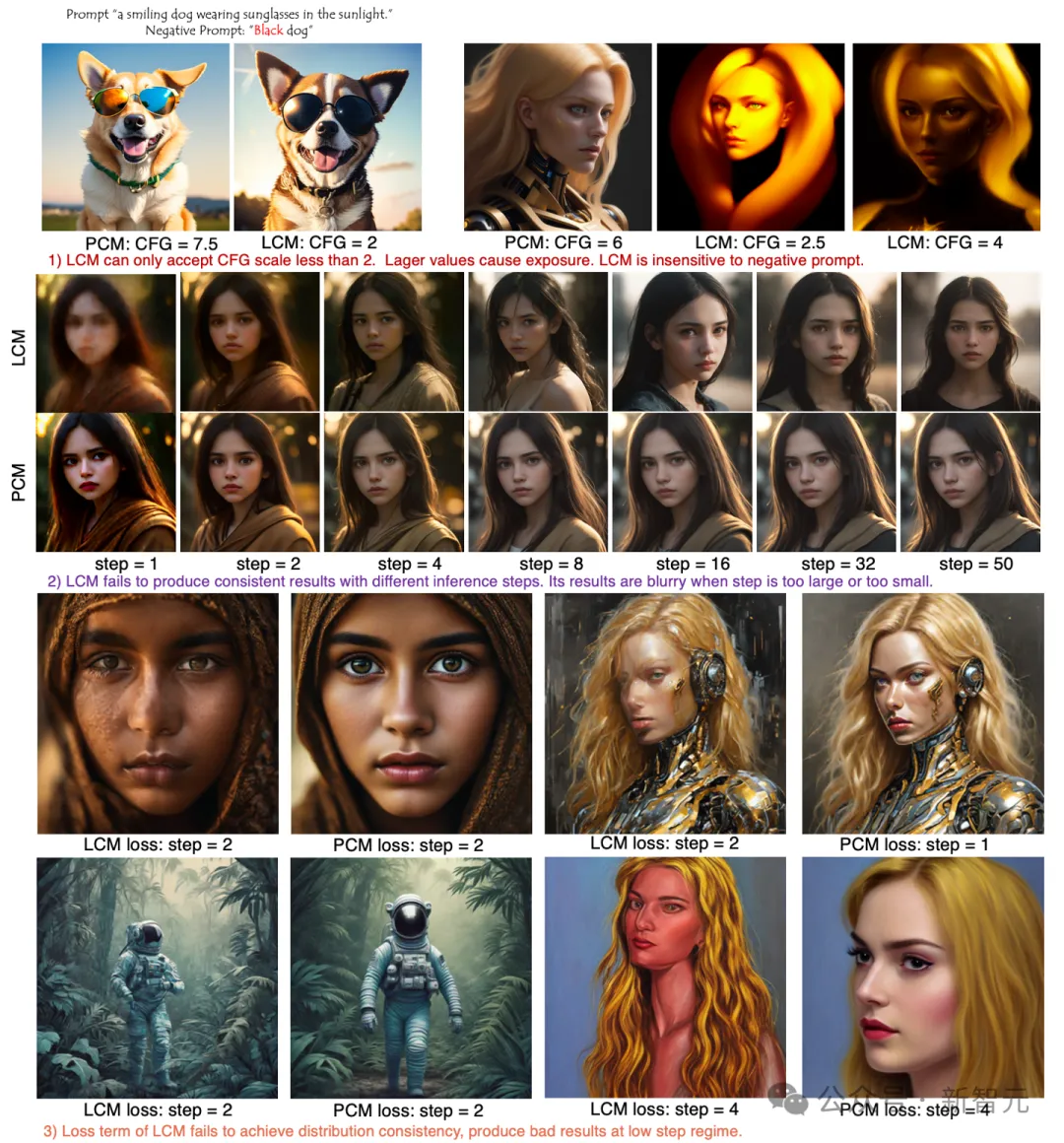

在5月發表的最新論文中,作者指出,潛在一致性模型依舊存在一些本質缺陷。論文逐個調查了這些缺陷背后的成因,并提出了改進過的階段一致性模型(Phased Consistency Model,PCM),實現了顯著的提升。

圖片

圖片

論文地址:https://arxiv.org/abs/2405.18407

CM和LCM的設計局限主要體現在三方面:

1. 可控性:在圖像和視頻生成中,有一個名為CFG的重要參數(classifier-free guidance),控制文本提示對生成結果的影響程度。CFG值越高,圖像或視頻與提示的相關程度就越高,但也提高了畫面失真的可能性。

Stable Diffusion模型在較大的CFG值范圍內(2~15)都能生成出較好的畫面,但LCM可接受的CFG值一般不能超過2,否則就會出現過度曝光問題。

無法提高CFG值,大大限制了文本提示對生成視頻的可控性。此外,LCM對負面提示也非常不敏感,比如下圖的第一個例子中,模型會「明目張膽」地無視提示要求,偏要生成一只帶黑色毛的狗。

2. 一致性:這兩種模型都只能使用隨機的多步采樣算法,因此即使采用同一個種子開始生成,在推理過程中也能看到各步驟之間明顯的不一致。

圖片

圖片

3. 效率:除了上面兩個硬傷之外,作者發現,LCM在少于4步的少步驟推理中無法給出較好的生成結果,因而限制了采樣效率。

PCM的架構設計就很好地解決了以上三個缺陷:

- PCM模型支持確定性采樣,能夠保持多個推理步驟中的圖像一致性

- PCM可以使用LCM中不可用的普通常微分方程求解器,代替原有的CFG增強的求解策略,從而讓模型能夠接受更高的CFG值

- 在隱空間中引入對抗性損失來確保圖像分布的一致性,大大提升了少步驟推理情況下的生成效果

實施了針對性的解決措施后,PCM在1~4步推理時生成的視頻效果相比LCM有了肉眼可見的顯著優化。后續的消融實驗也證明了PCM這些創新設計的必要性。

圖片

圖片

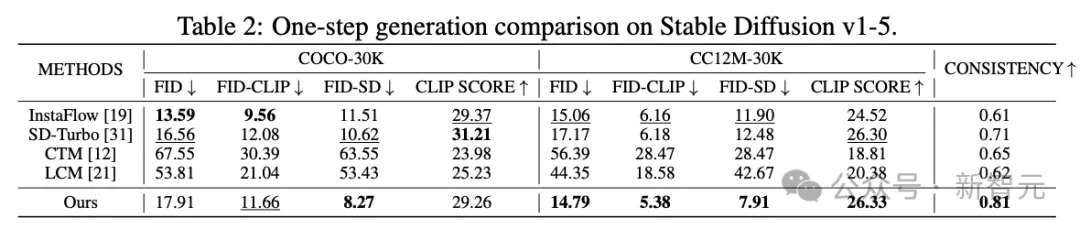

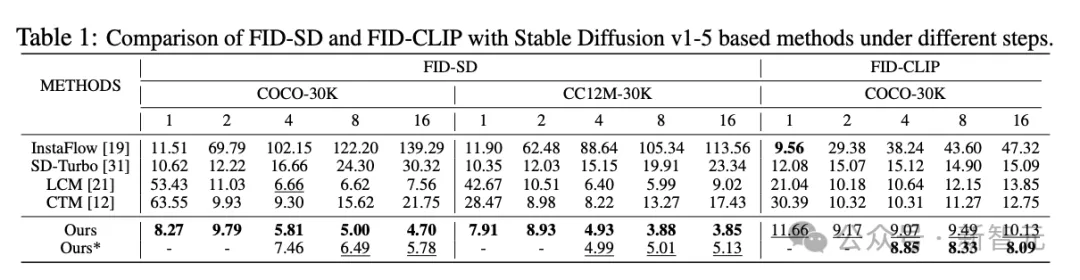

從MotionI2V到AnimateLCM,再到最新的PCM,鹿影團隊逐步的迭代中不斷尋求突破和提升,實現了PCM的驚艷效果,模型的先進性能從基準測試的得分和橫向對比中就可見一斑。

在單步推理生成圖像時,PCM方法在2個數據集、5個指標上幾乎都超過了Stable Diffusion-Turbo的得分,一致性得分的優勢更加顯著,從SD-Turbo的0.71提升至0.81。

圖片

圖片

當推理步驟從第1步逐漸增大到第16步時,這種優勢依舊明顯。多數情況下,使用普通ODE求解方法的更勝一籌。

圖片

圖片

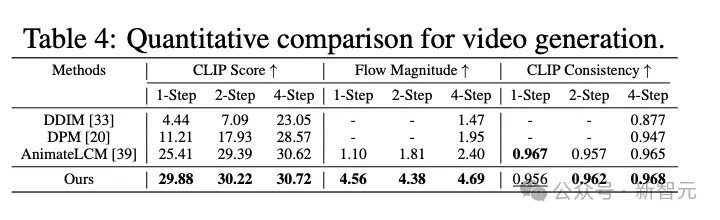

使用CLIP分數、光流估計、CLIP一致性三個指標量化評估視頻生成質量時,PCM模型依舊在少步驟推理(≤4步)中取得了明顯的優勢,相比其他兩個Diffusion架的構基線模型DDIM、DPM以及AnimateLCM都有大幅度提升。

圖片

圖片

值得一提的是,鹿影科技的研發并非一朝一夕之功,他們的技術創新持續數年并不斷迭代。

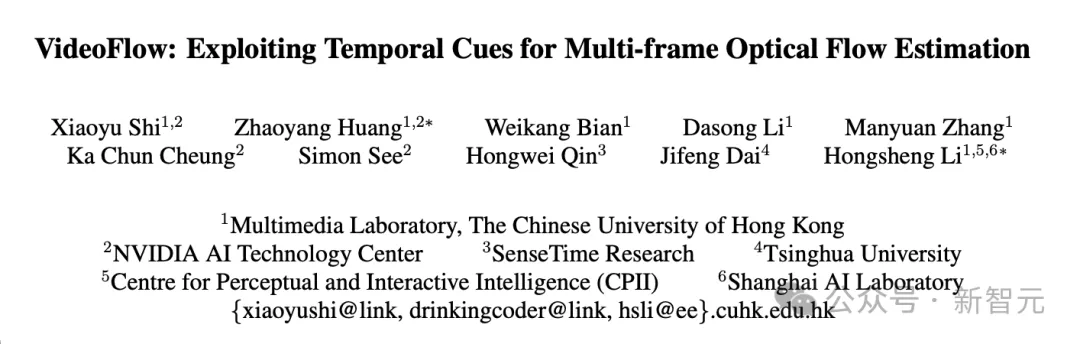

比如2022年提出的新穎架構FlowFormer在當時的Sintel光流基準測試中排名第一,2023年發布的視頻光流估計框架VideoFlow在所有公共基準測試上刷新了SOTA。

圖片

圖片

論文地址:https://arxiv.org/abs/2203.16194

圖片

圖片

論文地址:https://arxiv.org/abs/2303.08340

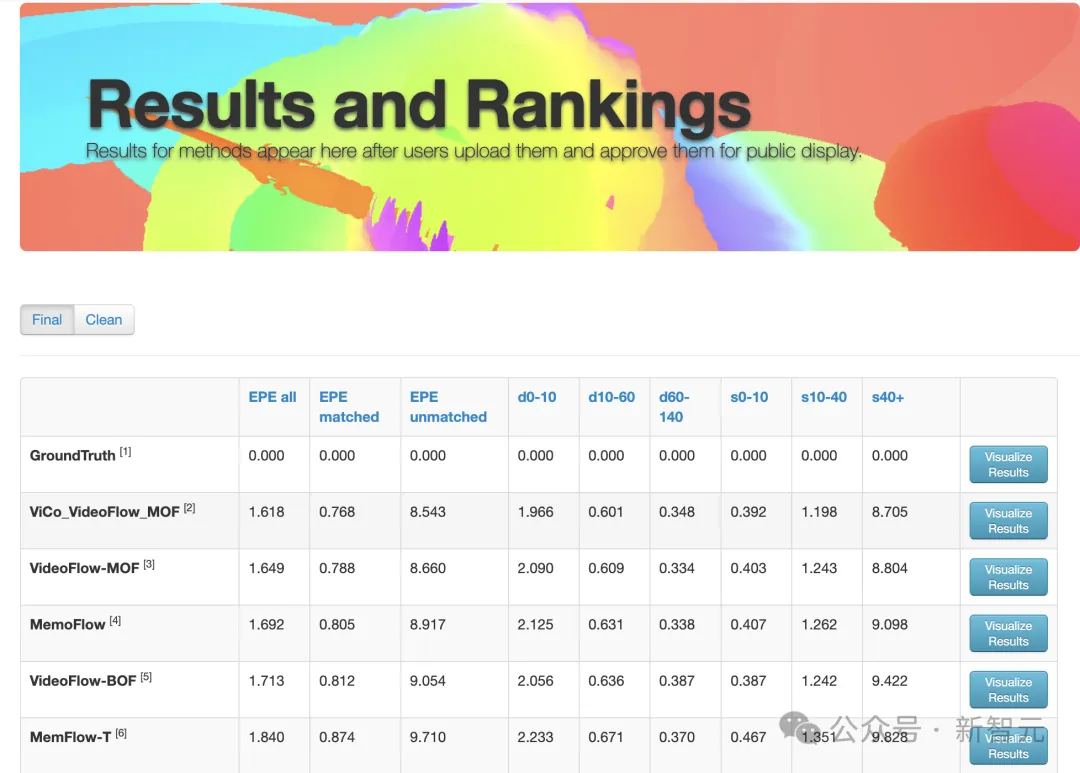

MPI Sintel是由華盛頓大學、佐治亞理工學院和馬克·普朗克研究所的多名研究人員共同開發的開源數據集,是目前光流算法領域使用最廣泛的基準之一。其中的樣本很好地代表了自然場景和運動,對當前的方法極具挑戰性。

在最新的排行榜上,前五名中VideoFlow系列就占據了三個位置,其中ViCo_VideoFlow_MOF更是排名第一,足可見鹿影團隊的技術沉淀和硬實力。

圖片

圖片

一直以來,我們高喊國漫崛起,但新作品發展遲緩,始終未能實現真正的突破。

未來,有了AI的入局,會讓動漫制作的現狀和創意,得到極大地改善。

對于鹿影科技,接下來要做的是,讓科研成果迅速轉化,讓AI工具幫助原創動漫實現指數級增長。