ChatGPT的真實能力如何?七大NLP任務一探究竟! 精華

文章:https://arxiv.org/pdf/2405.00704

ChatGPT已經改變了人工智能社區,一個活躍的研究方向是ChatGPT的性能評估。評估的一個關鍵挑戰是ChatGPT仍然是閉源的,傳統的基準數據集可能已被ChatGPT用作訓練數據。在本文中:

- 調查了最近的研究,揭示了ChatGPT在七個NLP任務中的真實性能水平

- 審查了ChatGPT的社會影響和安全問題

- 強調了評估的關鍵挑戰和機遇。

希望本調查能夠揭示其黑盒性質,以便研究人員不會被其表面生成所誤導。

介紹

自從OpenAI發布ChatGPT(Chat Generative Pre-trained Transformer)以來已經過去了一年多的時間。根據2024年1月的最新統計數據,ChatGPT目前擁有超過1.805億月活躍用戶,openai.com每月約有15億次訪問量。ChatGPT構建在GPT-3.5或GPT-4之上,它們都是OpenAI專有的一系列生成式預訓練Transformer模型的成員,基于Transformer架構,并通過監督學習和強化學習的組合進行了對話應用的微調。

盡管其成功改變了AI和自然語言處理社區的生態系統,但這個大語言模型(系統)仍然是一個黑盒子,研究人員對訓練細節知之甚少。傳統的評估方法依賴于使用一些基準數據集進行訓練和測試分割,但這些方法可能不可行,因為這些數據很可能已經在ChatGPT的訓練階段中使用了。因此,像chatbot-arena-leaderboard這樣的新榜單結合了自動評估和人工投票。然而,這些榜單只展示了ChatGPT的一般能力,并不能準確地反映其在特定自然語言處理任務上的性能。

本文回顧了機器學習和自然語言處理領域中關于ChatGPT評估的最新的論文。具體來說,調查了以下三個方面:

- ChatGPT在七個主要自然語言處理任務類別上的性能。

- ChatGPT的社會影響和安全問題。

- ChatGPT隨時間的性能。

此外,還突出了ChatGPT評估的關鍵挑戰和機遇。主要發現是:

- 首先,ChatGPT在zero-shot和少樣本情況下的表現往往良好,但仍然不及精細調節模型。

- 其次,當ChatGPT在新收集的數據上進行評估時,其泛化能力有限。

- 再者,大多數評估工作利用提示工程,依賴于人類啟發式,并不能保證可重現性。

- 最后,但同樣重要的是,ChatGPT的性能隨時間而下降。

大型語言建模

建模范式

在統計時代,n-gram語言建模計算n個字統計,并使用規則或馬爾可夫模型進行語言建模。這些技術通常會丟失關鍵的文本信息(例如詞序)并且不能處理未知詞匯。因此,廣泛使用平滑技術來避免對未見或不頻繁的n-gram產生零概率。

在神經網絡時代,分布式表示的概念基本上是使用深度神經網絡為單詞學習高維語義嵌入。通常使用自監督學習來設計學習目標,例如,下一個token預測,鄰近句子分類。神經語言建模的幾個重大里程碑包括word2vec,BERT和GPT模型。就語言建模的神經架構而言:有編碼器-解碼器(例如BERT),編碼器-解碼器(例如BART,T5)和僅解碼器(例如GPT3)。工業界的最近趨勢表明了僅解碼器架構的吸引力能力。

開源模型

許多開源的大語言模型在與商業替代方面競爭時表現出色,特別是在經過微調和優化之后。開源模型的一個關鍵優勢是它們不需要個人或企業將其數據發送到第三方遠程服務器,從而保護用戶隱私。一些開源的預訓練大語言模型包括Meta的LLaMA、Mistral的Mistral 7B、TII的Falcon LLM、OpenAI的GPT2、EleutherAI的GPT-J、MosaicML的MPT、BigScience的BLOOM、以及Zhipu的Chat-GLM 6B。LLaMA 2目前在研究社區中被廣泛使用。它訓練了2萬億個token,并且其上下文長度是LLaMA 1的兩倍。其微調模型已經在超過100萬個人類標注上進行了訓練。

閉源模型

截止到撰寫本文的日期,ChatGPT和GPT-4是兩個廣受認可的商業化系統。ChatGPT的一般訓練過程包括自監督訓練、獎勵模型學習和強化學習,但目前還不清楚在訓練ChatGPT時使用了多少訓練數據和人類標注。目前尚未從OpenAI確認GPT-4是否是一個專家混合系統,其中包含了8個不同數據和任務分布的220B專家。GLaM引入了稀疏激活的專家混合架構,以擴展模型容量,同時與密集變體相比,訓練成本大大降低。因此,最大的GLaM具有1.2萬億個參數,大約是GPT-3的7倍。

ChatGPT性能評估

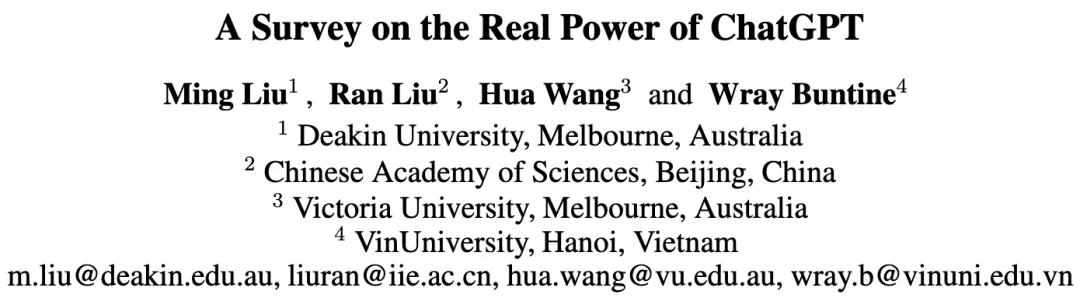

這一部分回顧了最近的一些研究,這些研究直接使用ChatGPT來完成特定的自然語言處理任務。這些任務包括但不限于:分類、文本生成、序列標注、信息檢索、解析、推理、多語言處理以及其他混合任務。下表1展示了ChatGPT在一些自然語言處理任務上的表現,將在接下來的章節中逐一說明這些任務。

分類

傳統的文本分類任務將情感或主題作為主要輸出標簽,SuperGLUE基準測試在大多數文本分類任務上都達到了超過90%的準確率。問題是:對于現實世界的文本分類任務,ChatGPT能否達到超過90%的準確率?這里回顧了10個文本分類任務,答案是否定的。

一些研究展示了ChatGPT在zero-shot設置下具有吸引人的分類性能。例如,[Heck等,2023]在對話狀態跟蹤上評估了ChatGPT,并顯示其平均準確率達到了56.44%,這在zero-shot設置下是最先進的,但仍然無法與監督系統相匹配。[Zhao等,2023]探討了使用ChatGPT和提示學習進行文本蘊含分類的可行性,并顯示其與基于BERT的zero-shot模型相競爭。其他研究認為ChatGPT仍然無法與精細調整的Transformer或BERT模型相匹敵。例如,[Ghanadian等,2023]對ChatGPT進行了自殺風險評估,并顯示zero-shotChatGPT達到了0.73的準確率,而精細調整的ALBERT達到了0.86的準確率,同時他們發現few-shot ChatGPT甚至不如zero-shot ChatGPT。[Kim等,2023]還表明,在科學論點分類任務上,ChatGPT仍然落后于現有的精細調整BERT模型很大一部分。

更近期的研究中,[Koopman和Zuccon,2023]評估了ChatGPT在TREC 2021和2022年健康虛假信息跟蹤中的100個主題上的表現,當提示為“是/否”和“是/否/不確定”答案時,ChatGPT的準確率從80%下降到33%,當提示被重新表達時,準確率進一步下降至不到60%但含有相同意義。[宋等,2023]探索了ChatGPT在通用領域內(GID)和域外意圖發現和識別上的應用,發現在域內ChatGPT的整體性能不如精細調整的基準模型,并且在域外意圖發現上,ChatGPT在多樣本或多類別情景下表現比精細調整的基準模型差得多,同時還指出ChatGPT無法從域內演示中進行知識轉移并將其推廣到域外任務。[2023]評估了ChatGPT和GPT4在對話情感分類上的表現,兩個系統在三個數據集中的兩個數據集上均達到了可比較的性能(40%至60%的準確率),與監督模型相當。

另一個有前景的工作是使用ChatGPT進行LLM生成文本檢測,[朱等,2023]開發了一個在六個數據集上進行實驗的pipeline,平均準確率達到了90.05%,而其他zero-shot方法僅達到了60%-70%的準確率,但這是一個相當簡單的二元分類任務,pipeline工程技巧可能對其他文本分類任務不可用。

對于分類任務,有幾個關鍵發現:首先,在zero-shot分類設置下,ChatGPT的表現很好,但仍然落后于監督模型。其次,當標簽空間增加時,ChatGPT的準確率顯著下降。第三,即使提供了一些演示,知識轉移在領域外分類任務中幾乎不可能發生。第四,當存在與目標任務相關的公共數據時,ChatGPT的分類性能往往很好。

生成

摘要

文本摘要旨在將文本或文本集合轉換為包含關鍵信息的簡短文本。簡潔性是摘要的主要目標之一,然而一些研究指出,在提示中沒有長度限制時,由ChatGPT生成的摘要往往是冗余的。這可以通過使用限制性提示來改善,從而在精確度和召回率之間取得平衡。

盡管ChatGPT在zero-shot設置下表現良好,但在基于自動評估指標的精細調整最新模型中仍表現不佳。例如,精細調整的BART遠遠優于zero-shot ChatGPT。在多文檔摘要中,[Caciularu等,2023]設計了新穎的預訓練目標,他們的模型明顯優于基于GPT的大語言模型。對于生物醫學任務等特定領域,ChatGPT在具有專門訓練集的數據集中表現比精細調整的BioBART差得多。然而,在缺乏大量訓練數據時,zero-shot ChatGPT比領域特定的精細調整模型更有用,表現出其良好的zero-shot性能。

由ChatGPT生成的摘要往往受人類偏好,因為它們具有較少的語法錯誤,更加流暢和連貫。與此同時,這些摘要的信息量不高。通過人類反饋的強化學習導致ChatGPT傾向于關注語言方面,但在確保忠實于事實信息和與原始來源的一致性方面有困難,因此它可能會過度擬合不受限制的人類評估,這受到標注者的先驗、與輸入無關的偏好的影響。

有時候,特別是在專業和技術領域,ChatGPT可能不夠可靠,因為它可能會自信地產生事實上不正確的輸出。[Ye等,2023]已經確認,在二進制代碼摘要中,ChatGPT只具有對匯編代碼的基礎理解,沒有任何更高層次的抽象語義理解。在合同摘要中,[Sancheti等,2023]指出,ChatGPT中的幻覺使得執行此任務變得困難。一些研究得出了相反的結論,因為提示設計可以極大地影響ChatGPT的性能。例如,[Qin等,2023b]發現控制摘要長度可能會損害ChatGPT的摘要能力,這與本節前面提到的內容相反,表明ChatGPT的不穩定性。

總的來說,ChatGPT在zero-shot摘要中表現良好,其摘要更符合人類的偏好,但在基于自動評估指標的精細調整模型下表現不佳,信息量也不高。此外,由于幻覺和不穩定性,ChatGPT不太可能在專業領域的摘要中發揮作用。

問答和對話

問答(QA)和對話任務可以評估ChatGPT的檢索、理解和生成能力。在開放領域的問答中,[Bai等,2023]對幾個大語言模型進行了基準測試,并證明了ChatGPT的近乎完美的性能。在提供錯誤前提的情況下,ChatGPT在明確指出錯誤前提方面表現良好。在實踐中,ChatGPT的表現與傳統的基于檢索的方法相當,但落后于像Bing Chat這樣的新型語言模型。

[Nov等,2023]使用ChatGPT來回答健康問題,患者對聊天機器人功能的信任響應相對積極,普通人似乎信任使用聊天機器人來回答較低風險的健康問題。但是隨著問答任務的復雜性增加,人們對ChatGPT的響應信任降低。此外,無論使用廣泛和多樣化的訓練語料庫,ChatGPT在資源匱乏的問答上表現不佳。

[Feng等,2023]證實了ChatGPT在對話狀態跟蹤方面優于先前的方法,而較小的精細調整模型可以達到可比較的性能。在開放領域的對話中,ChatGPT可以生成流暢的響應,但在自動評估指標上落后于精細調整的GPT-2,并在某些配置下略微不及Claude。在任務導向的對話中,ChatGPT在生成響應時往往難以區分檢索到的知識庫記錄中的微小差異,并且往往會在給定的知識之外生成幻覺信息。

總的來說,在簡單的開放領域任務中,ChatGPT表現良好,人們更喜歡其響應。然而,在復雜、資源匱乏或任務導向的場景中,它仍然有很大的改進空間。

機器翻譯

機器翻譯指的是將一種自然源語言轉換成另一種目標語言的過程。作為大語言模型最常見的用途之一,它極大地促進了現代生活。ChatGPT在高資源語言(如歐洲語言)之間的翻譯效果很好,甚至與商業系統不相上下,但是當面對低資源語言時,它落后于精細調整的模型和商業系統。另一個普遍的發現是,ChatGPT在XX → Eng任務中翻譯效果良好,但在Eng → XX翻譯方面仍然缺乏能力。與其他任務類似,ChatGPT在機器翻譯中表現不穩定,有時會出現遺漏和明顯的抄襲行為。

與其他翻譯系統不同的是,ChatGPT能夠更好地建模長期依賴關系并捕捉話語層面的信息,而其他系統更注重詞級準確性,導致ChatGPT更受人類歡迎。此外,ChatGPT具有零代詞解析和恢復的能力,這是自然語言處理中最困難的問題之一。因此,我們可以得出結論,由ChatGPT生成的翻譯更注重整體語言質量,在高資源語言上表現出色,但在詞級準確性和低資源語言上,ChatGPT的表現不及精細調整的模型。

改寫和數據增強

ChatGPT在數據增強和改寫等任務中效率高且成本效益高。幾項研究表明,ChatGPT可以生成更多樣化的數據,在改寫生成方面顯示出類似于從人類工作者收集的數據的模型穩健性。例如,[Jon和Bojar,2023]使用ChatGPT為一個句子生成了40個不同的改寫,而[Michail等,2023]使用ChatGPT生成的合成推文作為訓練數據,這些方法取得了預期的效果。但是,ChatGPT也有缺點,它不會為命名實體(如地點、歌曲、人名等)產生替代名稱,這是眾包數據處理得很好的方面。盡管如此,對于這些任務來說,它仍然是一種高效且成本效益高的選擇。

可控生成

可控生成旨在生成具有特定特征的文本,近年來受到了廣泛關注。盡管ChatGPT可以符合人類的偏好,但在可控生成任務中表現不佳。[Pu和Demberg,2023]提示ChatGPT為普通人和專家生成不同摘要,盡管其勝過先前的最先進模型,但生成的摘要與人類撰寫的文本相差甚遠。一些研究發現,ChatGPT未能正確遵循數值限制,這可能是由于錯誤的token化引起的。另一項研究由[Valentini等,2023]嘗試讓ChatGPT為不同年齡段的兒童生成故事,他們發現ChatGPT無法避免使用復雜詞匯,因此生成的故事可讀性明顯低于人類撰寫的故事。此外,ChatGPT在一些其他任務上表現不佳,例如去文本化和復雜受控改寫生成。盡管ChatGPT在上述精細的嚴格約束下表現困難,但它可以處理粗略的約束。例如,zero-shot ChatGPT在內容受限的文本生成(如情感和關鍵詞約束)上優于監督基線。此外,它可以在給定故事開頭文本的情況下繼續寫出更流暢、更連貫的故事。ChatGPT擅長模仿而不是掌握復雜的理解、組織和生成能力,因此它在硬控制信號方面表現不佳。

其他生成任務

ChatGPT可以用于各種生成任務。對于代碼生成,[Liu等,2023]根據他們提出的評估框架,顯示兩個開源模型可以優于ChatGPT。[Singh等,2023]指出,在Bash和CF規則的代碼生成方面,ChatGPT表現不及T5。[Xiao等,2023]利用ChatGPT在教育領域,由ChatGPT生成的閱讀材料和相應的練習題都適合學生,甚至超過了現有人工撰寫的內容的質量。還有其他使用ChatGPT的生成任務,例如生成閱讀理解測試中的多項選擇項的解釋,提供片段和提示來推導問答對,給定一個句子和一個實體來生成與該實體相關的問題,ChatGPT在這些任務中表現良好,有時甚至與人類相媲美。

當涉及到生成建設性或復雜內容時,ChatGPT往往表現不佳。例如,在教育方面,ChatGPT可以充當教學輔導員,但在生成富有見地和新穎的反饋方面仍有改進空間。[Jentzsch和Kersting,2023]嘗試弄清楚ChatGPT是否有幽默感。ChatGPT只能識別、復制和解釋符合固定模式的雙關語,無法產生原創的有趣內容,因此,ChatGPT只能學習特定的笑話模式,而不能真正有趣。

對于文本生成任務,ChatGPT的主要優勢在于它具有良好的寫作能力和與人類價值觀的一致性,這解釋了為什么它在一些簡單的生成任務上與人類表現相當。但是,在需要生成創造性內容或理解復雜的語義特征和句法分析的任務中,它仍然表現不佳。

序列標注

序列標注是將標簽分配給序列中的單詞或短語,例如命名實體識別(NER)、詞性標注和名詞短語識別。傳統的統計方法使用隱馬爾可夫模型(HMM)或條件隨機場(CRF)進行序列標注,當前的最先進方法依賴于具有CRF的深度表示。與分類或生成任務不同,序列標注任務的標簽是針對局部文本片段的,并且文本片段的特征表示通常限制在一個小窗口內。[Xie等,2023]對zero-shot NER進行了實證研究,將NER任務分解為更簡單的子問題,并通過標簽對其進行了拆分,同時實驗了句法提示和工具增強,在中英文場景以及領域特定和通用領域數據集上驗證了他們方法的有效性。

信息檢索

典型的信息檢索系統包括兩個步驟:在第一步給定一個query,在第二步搜索相關的文檔并對返回的文檔進行排序。許多工作已經將LLMs應用到信息檢索過程中。LLMs可以輔助四個通用模塊:重寫器、檢索器、重新排名器和閱讀器。

重寫器是一個重要的IR模塊,旨在提高用戶query的精確性和表達性。query重寫在兩種情況下起作用:一是即時檢索,它彌合了query和文檔之間的詞匯不匹配,二是會話搜索,它根據不斷演變的對話迭代地完善和調整系統響應。例如,Query2Doc [Wang et al., 2023c]通過少量提示LLMs生成偽文檔,然后使用生成的偽文檔擴展query。LLM4CS [Mao et al., 2023]利用ChatGPT作為基于文本的搜索意圖解釋器來幫助會話搜索,使用了三種提示方法生成多個query重寫和假設響應,這些query重寫被聚合成一個集成的用戶query表示。

檢索器通常用于IR的早期階段以提高召回率,經典的詞袋模型BM25在許多檢索任務中表現出強大的魯棒性。SGPT [Muennighoff, 2022]將GPT模型修改為跨或雙編碼器以進行語義搜索。GENRET [Sun et al., 2023c]通過離散自動編碼方法學習將文檔token為短離散表示。

重新排名器是另一個重要的模塊,它返回一個相關文檔的有序列表。它作為細粒度文檔過濾的關鍵部分。UPR [Sachan et al., 2022]使用LLMs對檢索到的段落進行評分,并根據問題上的對數似然得分對段落進行重新排序。

閱讀器或內容生成可以被視為信息管理的最后過程,它可以將搜索到的文本壓縮成用戶友好的輸出。GenRead [Yu et al., 2022]首先提示一個大語言模型根據給定的問題生成上下文文檔,然后閱讀生成的文檔以產生最終答案。

盡管生成能力在LLMs的預訓練目標和排名目標之間帶來了一些差異,但兩項最近的研究 [Zhang et al., 2023a]已經表明,與強基線相比,ChatGPT在IR任務上取得了有競爭力的結果。[Zhang et al., 2023a]在從專業和普通文檔中檢索需求信息方面對ChatGPT進行了實證評估,在zero-shot設置下,定量和定性結果均顯示ChatGPT具有檢索需求相關信息的良好能力(高召回率)和檢索更具體需求信息的有限能力(低精確度)。類似地,[Sun et al., 2023b]探索了ChatGPT在各種段落重新排序基準上的指導方法,并驗證了其對監督模型的能力。

分析

在統計時代的NLP中,解析是其支柱。許多高級NLP任務,如機器翻譯和信息提取,都依賴于成分解析或依賴解析。在神經時代,解析步驟可以被跳過,因為文本的分布式表示可以直接饋送到下游任務中。因此,如今解析任務通常可以通過序列到序列學習來解決。[Sun et al., 2023a]比較了ChatGPT與其他五個開源LLMs在文本到SQL解析任務上的性能。發現與封閉源模型相比,開源模型的性能明顯不足。然而,值得注意的是,即使是GPT-3.5在幾個經典的文本到SQL解析數據集上也比較小的基線模型表現差。

推理

推理是人類智能的基本組成部分,它是根據過去的經驗或背景以邏輯和系統的方式思考前提的過程。目前尚不清楚LLMs是否具有真正的推理能力。從“LLMs是少樣本學習者”的早期主張開始,關于推理的其他類似主張包括“LLMs是體面的zero-shot推理者”,以及“LLMs在常見的規劃/推理任務上仍然遠未達到可接受的性能”,或者LLMs尚不能自我修正推理。在概述改進LLMs推理技能的技術以及評估推理能力的方法和基準之后,發現LLMs是否根據真實推理還是啟發式進行預測還不清楚。它們逐步推理并返回原因可能是不正確和不一致的。

一些最近的工作分析了ChatGPT的具體推理能力。例如,[Jang和Lukasiewicz,2023]調查了邏輯推理中的四個屬性:語義等價、否定、對稱性和轉移,并顯示ChatGPT表現出增強的否定和傳遞一致性,但仍然會犯違反邏輯屬性的錯誤。此外,當輸入文本被改寫或輸入句子的順序被改變時,ChatGPT經常會改變其答案。[Wang et al., 2023a]通過辯論探索了ChatGPT的推理能力:他們首先獲得ChatGPT的初始解決方案,并對在其中獲得正確答案的示例進行評估。然后,他們通過在錯誤的目標答案上進行條件推斷來合成無效的解決方案。然后,他們在ChatGPT和用戶之間(由ChatGPT條件化的無效解決方案模擬)開始了類似辯論的對話,以查看ChatGPT在辯論過程中是否能夠堅持并捍衛其對真理的信念。結果發現,ChatGPT的信仰和懷疑并不穩健,并且很容易受到用戶的干擾,它經常承認或被用戶的無效回答/論點所誤導,盡管它能夠在開始時產生正確的解決方案。

[Qin et al., 2023a]對ChatGPT進行了算術、常識、符號和邏輯推理的實驗,結果表明,在使用鏈式思維進行算術推理時,ChatGPT的表現優于GPT-3.5,但在常識推理中使用鏈式思維并不總是提供更好的性能,而且在許多情況下,它甚至比GPT-3.5的符號和邏輯推理表現更差。在法律應用中,[Kang et al., 2023]表明ChatGPT可以產生合理的答案,但大多數情況下未能提供與法律專家一致的正確推理路徑。通過提供部分標注的推理路徑,包括上下文學習的類似標注場景和將復雜問題分解為更簡單問題,可以提高其性能。

總的來說,我們發現ChatGPT是否具有真正的推理技能還是僅基于記憶進行預測還不清楚。此外,諸如鏈式思維之類的技術會導致不一致的生成。提示和使用更大的語言模型可能不是解決推理問題的最終解決方案。我們建議將啟發式和概率(例如貝葉斯網絡)推理引入LLMs中,以增強它們的推理能力。

多語言能力

許多研究表明,當輸入語言為英語時,ChatGPT的性能更好,一個重要原因是訓練數據集嚴重偏向于英語。[Zhang et al., 2023b]采用了一種提示回譯方法,并顯示ChatGPT可以在翻譯等價任務中返回一致的結果,但在翻譯變體任務中難以提供準確的答案。

[Khondaker et al., 2023]對44個阿拉伯語理解和生成任務對ChatGPT進行了評估,并發現它在總體上被一直被細調過的較小模型所超越,這些模型已經在阿拉伯語上進行了微調。

混合任務

有一些研究調查了ChatGPT是否是特定領域的通用求解器。[Jahan et al., 2023]表明,與生物醫學領域的微調模型(如BioGPT和BioBART)相比,ChatGPT在生物醫學領域的表現相當差,而在訓練數據量較小的數據集上,它的表現則優于微調模型。[Li et al., 2023b]對ChatGPT進行了實證研究,并指出它在金融領域可以與微調模型競爭,但在需要更深層次的語義和結構分析的任務上仍然落后。

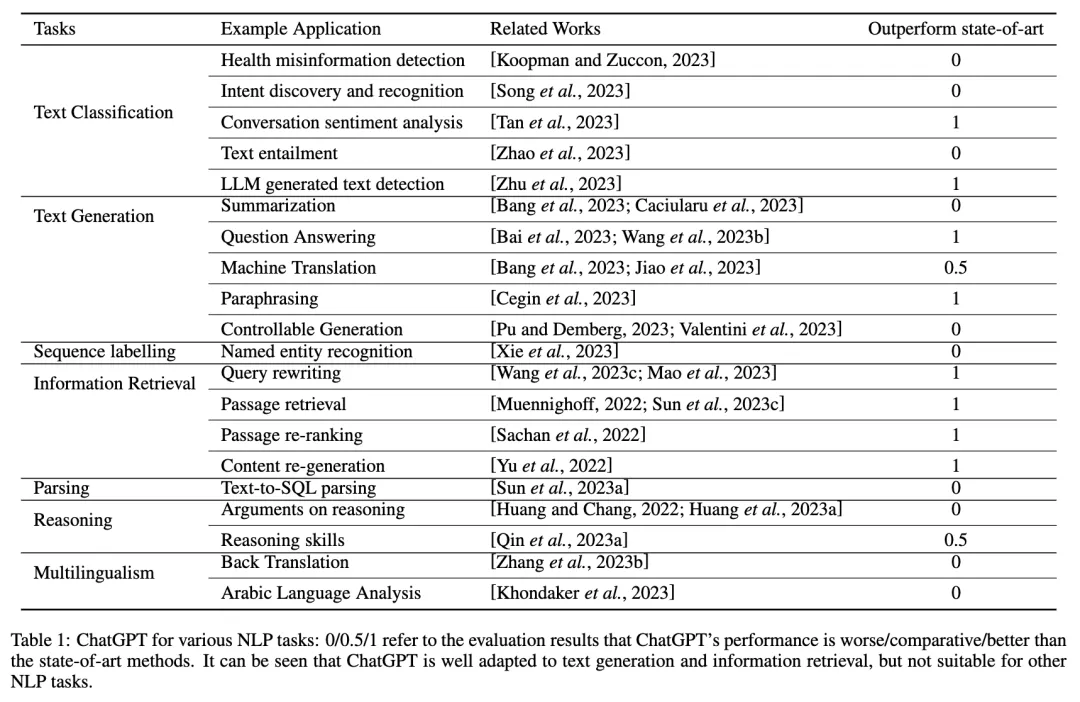

社會影響與安全

在下表2中列出了 ChatGPT 最近關于社會影響和安全問題的工作

社會影響:偏見和公平性源自哲學概念,即模型應該平等對待人類。然而,偏見可能是由于無意識行為引起的,來源包括訓練數據收集、模型設計和人類交互與標注等。最近[Ra,2023]的研究將偏見分類為不同類別,如種族和性別偏見、語言偏見、文化偏見、地域偏見等。ChatGPT對英語表現出強烈的語言偏見,[Wang等人,2023年]研究了ChatGPT的首位效應,并顯示ChatGPT的決策對提示中標簽的順序敏感,它更有可能選擇在前幾個位置的標簽作為答案。

[Espa?a-Bonet,2023]發現了2023年ChatGPT的政治和語言偏見:在2023年2月至8月期間,ChatGPT從左翼轉變為中立政治取向,在中間出現了向右傾斜的時期,而到2023年8月為止的當前版本在4種語言中一直呈現左傾。[Deshpande等人,2023]揭示了當ChatGPT被分配了一個角色時,與默認設置相比,它可能會顯著地具有有毒和不安全的傾向。其他社會因素還考慮了倫理[Stahl和Eke,2024]、對就業的影響[George等人,2023]以及能源消耗[Rane,2023]。

安全:ChatGPT的隱私攻擊是通過不斷的提示修改來實施的。ChatGPT的訓練數據隱私是通過多輪提示修改來提取的。一些研究調查了開源LLM的隱私保護,主要遵循兩種方法:通過修改學習目標函數進行遺忘,或直接編輯選定的神經元。[Huang等人,2023b]發現kNN-LM比參數模型更容易從其私有數據存儲中泄露私人信息,用于檢索式語言模型。另一個安全問題是虛假信息的傳播,[Li等人,2023a]表明ChatGPT可以植入數據并誤導使用真實新聞訓練的虛假新聞檢測系統。與此同時,對ChatGPT的對抗性攻擊可以通過向用戶query附加特殊字符序列來進行,這將導致系統遵循用戶命令,即使產生有害內容也是如此。

隨著時間推移的表現

機器學習模型的泛化能力對于在未見數據上的應用至關重要。許多研究人員認為,大語言模型是幾乎zero-shot學習者,因為一些大語言模型在預訓練階段已經接觸過一系列任務示例,因此對于這些任務而言,它們不再是zero-shot或幾乎zero-shot。此外,對于沒有可能受到任務污染的分類任務,[Li和Flanigan,2023]顯示,大語言模型在zero-shot和幾乎zero-shot設置中很少表現出與簡單的多數基線相比的統計顯著改善。[Chen等人,2023]還證明,GPT-3.5和GPT-4的行為在相對較短的時間內有了顯著變化,例如,2023年6月,GPT-4對回答敏感問題的意愿較3月份更低,而2023年6月,無論是GPT-4還是GPT-3.5,在代碼生成方面的格式錯誤都比3月份更多。

挑戰與機遇

還值得注意的是,最近的LLM排行榜,如AlpacaEval和Chatbot Arena Leaderboard,顯示一些參數較少的開源模型已經實現了與gpt-3.5-turbo類似或更好的NLP能力。然而,公共模型是否存在測試數據污染尚不清楚。我們確定了封閉和開放式大語言模型評估的三個關鍵挑戰:

可解釋性提供有意義的解釋是可信系統的關鍵部分。 ChatGPT可以提供帶解釋的答案。然而,一些研究表明,ChatGPT返回的解釋在上下文中并不一致。我們在此說明了兩種可解釋LLM的方法:一種是構建多代理系統,并為解釋功能分配特定代理,另一種方法是為說明性訓練數據配備可解釋項目,這可能會更昂貴。

持續學習隨著新數據和任務的到來,持續學習能力變得越來越重要。 典型的持續學習方法,如記憶重播、正則化和模型架構重新設計,對于像ChatGPT這樣的LLM來說并不可擴展。更有效的方法使用凍結和微調方法,例如Adapter[Pfeiffer等人,2020]和LoRA[Hu等人,2021]。最近的專家混合方法[Diao等人,2023]促進了學習和遺忘之間的權衡,并且可以是LLM持續學習的更應用方法。

輕量級建模ChatGPT的巨大規模限制了其在本地部署上的應用。 最近的研究涉及小型語言建模,包括從LLM中蒸餾模型、在更大數據集上訓練小型LM和超參數化。然而,目前還不清楚在小模型上使用更大數據還是在更大預訓練模型上使用更小數據對于生成式語言建模效果更好。

結論

大型語言建模的研究正在進行中,可靠的模型評估至關重要。本文回顧了ChatGPT在不同NLP任務上的實際表現水平,并發現在許多任務中它經常表現不及微調模型。其zero-shot或幾乎zero-shot學習能力在很大程度上取決于其大量的訓練數據,而這些數據對公眾不可見。其性能隨時間的降低可能會阻礙其廣泛的應用。此外,其偏見顯著且隨時間變化。

本文轉自 AI生成未來 ,作者:Ming Liu等