清華、北大等發布Self-Play強化學習最新綜述

本文作者來自于清華大學電子工程系,北京大學人工智能研究院、第四范式、騰訊和清華-伯克利深圳學院。其中第一作者張瑞澤為清華大學碩士,主要研究方向為博弈算法。通訊作者為清華大學電子工程系汪玉教授、于超博后和第四范式研究員黃世宇博士。

自博弈(self-play)指的是智能體通過與自身副本或歷史版本進行博弈而進行演化的方法,近年來在強化學習領域受到廣泛重視。這篇綜述首先梳理了自博弈的基本背景,包括多智能體強化學習框架和博弈論的基礎知識。隨后,提出了一個統一的自博弈算法框架,并在此框架下對現有的自博弈算法進行了分類和對比。此外,通過展示自博弈在多種場景下的應用,架起了理論與實踐之間的橋梁。文章最后總結了自博弈面臨的開放性挑戰,并探討了未來研究方向。

- 論文題目:A Survey on Self-play Methods in Reinforcement Learning

- 研究機構:清華大學電子工程系、北京大學人工智能研究院、第四范式、騰訊、清華-伯克利深圳學院

- 論文鏈接:https://arxiv.org/abs/2408.01072

引言

強化學習(Reinforcement Learning,RL)是機器學習中的一個重要范式,旨在通過與環境的交互不斷優化策略。基本問題建模是基于馬爾可夫決策過程(Markov decision process,MDP),智能體通過觀察狀態、根據策略執行動作、接收相應的獎勵并轉換到下一個狀態。最終目標是找到能最大化期望累計獎勵的最優策略。

自博弈(self-play)通過與自身副本或過去版本進行交互,從而實現更加穩定的策略學習過程。自博弈在圍棋、國際象棋、撲克以及游戲等領域都取得了一系列的成功應用。在這些場景中,通過自博弈訓練得到了超越人類專家的策略。盡管自博弈應用廣泛,但它也伴隨著一些局限性,例如可能收斂到次優策略以及顯著的計算資源需求等。

本綜述組織架構如下:首先,背景部分介紹了強化學習框架和基礎的博弈論概念。其次,在算法部分提出了一個統一的框架,并根據該框架將現有的自博弈算法分為四類,進行系統的比較和分析。在之后的應用部分中,展示自博弈具體如何應用到具體的復雜博弈場景。最后,進一步討論了自博弈中的開放問題和未來的研究方向,并進行總結。

背景

該部分分別介紹了強化學習框架以及博弈論基本知識。強化學習框架我們考慮最一般的形式:部分可觀察的馬爾可夫博弈(partially observable Markov game, POMGs),即多智能體場景,且其中每個智能體無法完全獲取環境的全部狀態。

博弈論基礎知識介紹了博弈具體類型,包括(非)完美信息博弈和(非)完全信息博弈、標準型博弈和擴展型博弈、傳遞性博弈和非傳遞性博弈、階段博弈和重復博弈、團隊博弈等。同樣也介紹了博弈論框架重要概念包括最佳回應(Best responce, BR)和納什均衡 (Nash equilibrium, NE)等。

復雜的博弈場景分析通常采用更高層次的抽象,即元博弈(meta-game)。元博弈關注的不再是單獨的動作,而是更高層的復雜策略。在這種高層次抽象下,復雜博弈場景可以看作是特殊的標準型博弈,策略集合由復雜策略組成。元策略(meta-strategies)是對策略集合中的復雜策略進行概率分配的混合策略。

在該部分最后,我們介紹了多種常用的自博弈評估指標,包括 Nash convergence(NASHCONV)、Elo、Glicko、Whole-History Rating(WHR) 和 TrueSkill。

算法

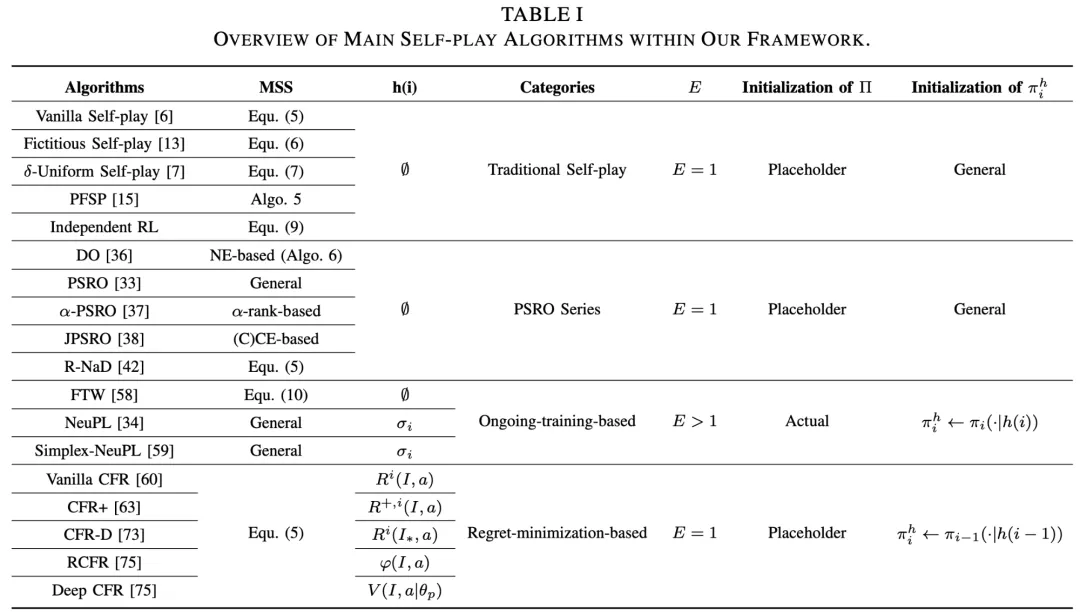

我們定義了一個統一的自博弈框架,并將自博弈算法分為四大類:傳統自博弈算法、PSRO 系列算法、基于持續訓練的系列算法和后悔最小化系列算法。

算法框架

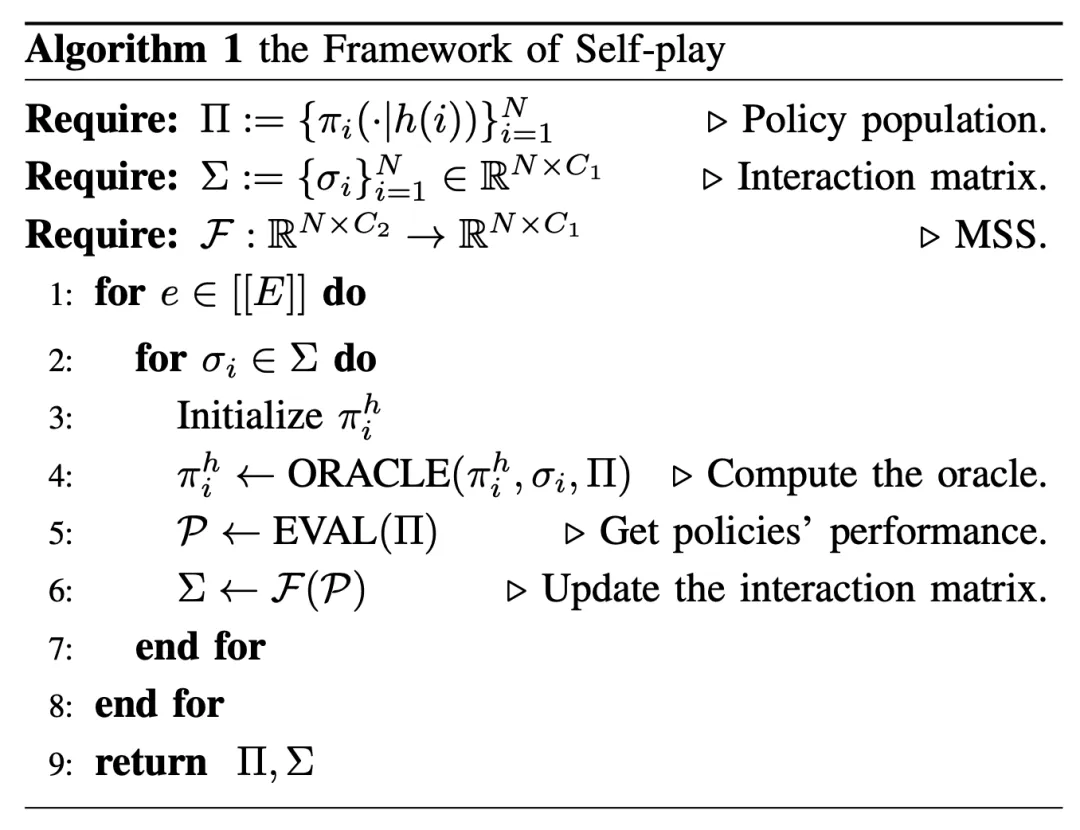

首先,該框架(算法1)的輸入定義如下:

● : 在策略集合 中,每個策略 都取決于一個策略條件函數 。

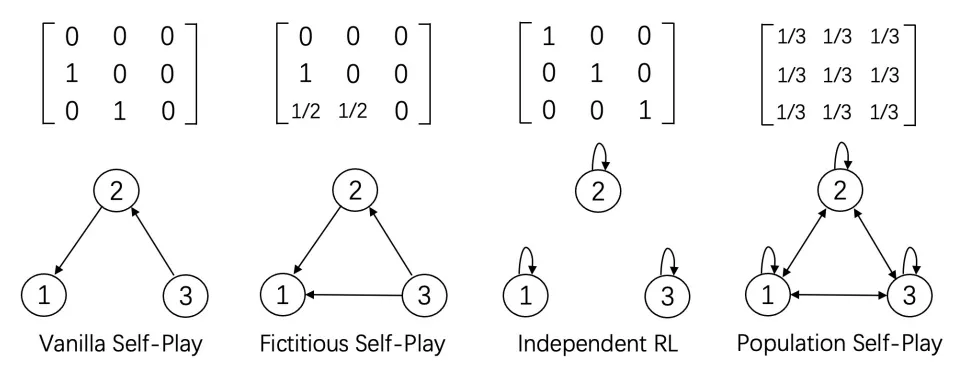

● : 策略集合的交互矩陣。 描述了如何為策略 采樣對手。例如, 可以用每個對手策略采樣概率表示(此時 如下圖所示)。

● : 元策略求解器(Meta Strategy Solver,MSS)。輸入是表現矩陣 ,并生成一個新的交互矩陣 作為輸出。 表示策略 的表現水平。

該框架(算法1)的核心步驟說明:

● 算法1偽代碼第1行: 表示整個策略集合的總訓練輪數,也即策略池中每個策略的更新次數。

● 算法1偽代碼第3行:各個策略初始化可以選擇隨機初始化、預訓練模型初始化或者是繼承之前訓練完成的策略進行初始化。

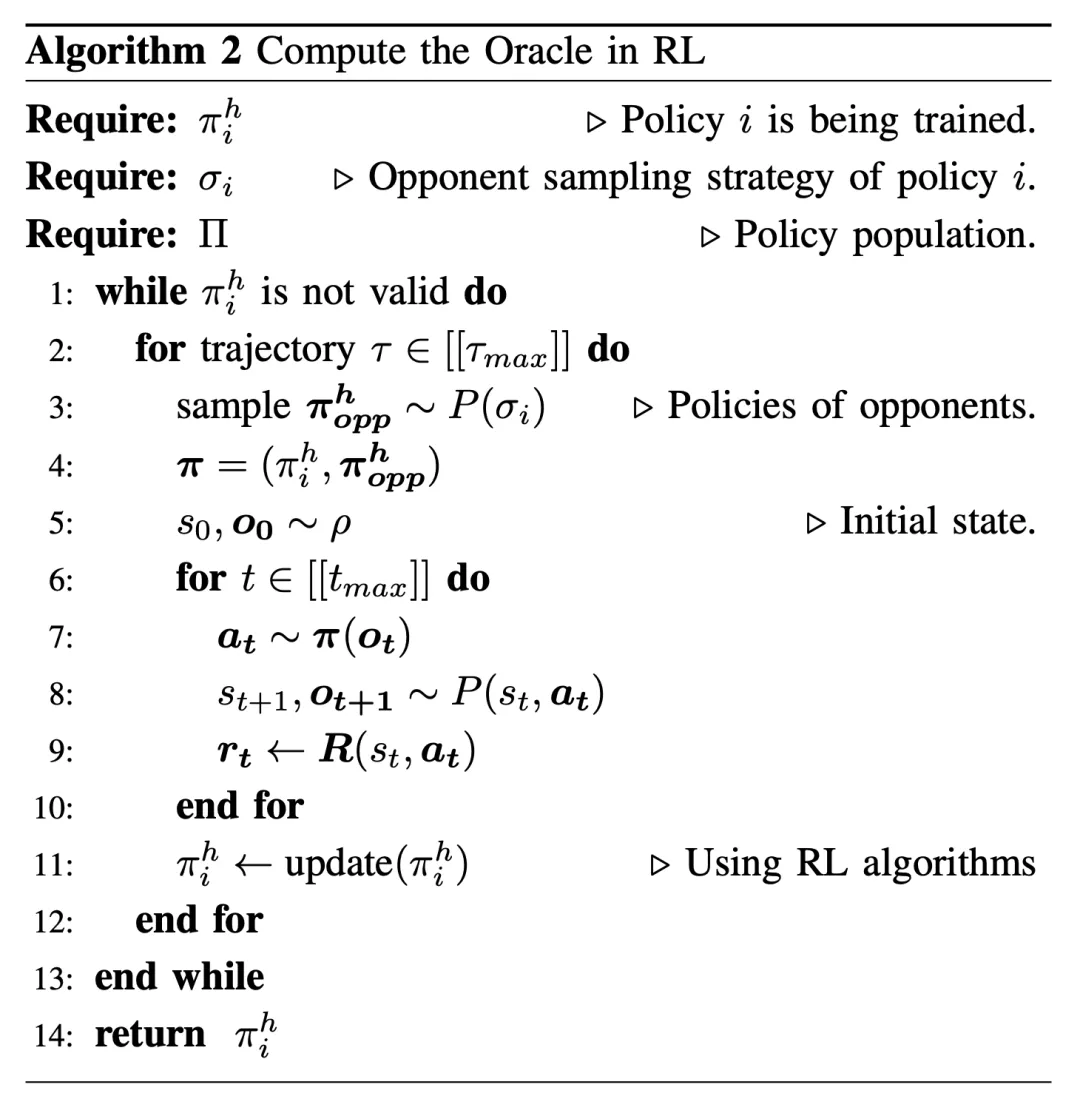

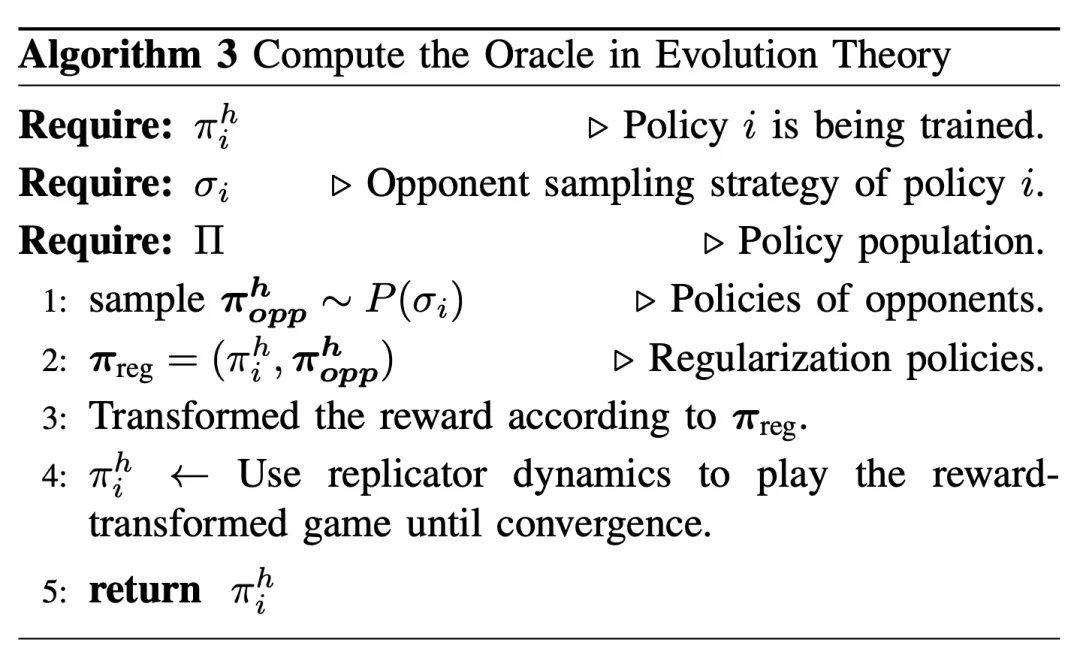

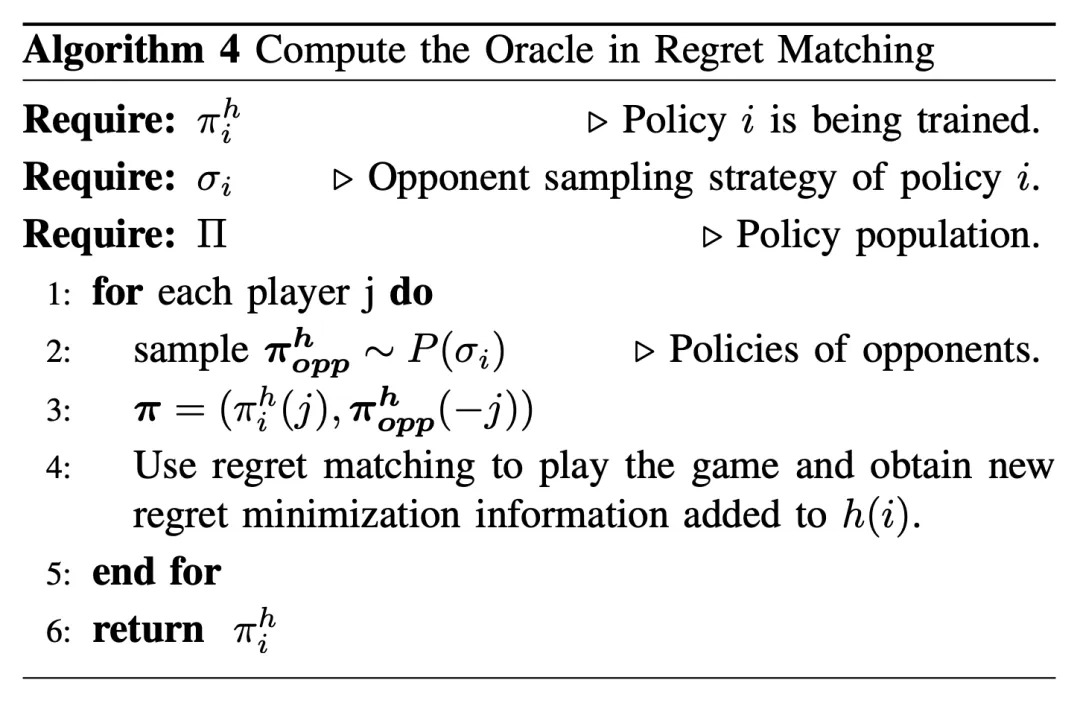

● 算法1偽代碼第4行:可以選用不同的 ORACLE 算法得到訓練策略,最直接的方式是計算 BR 。但是由于對于復雜任務來說,直接計算 BR 難度高,因此通常選擇訓練近似BR來訓練策略,可以采用強化學習(算法2),進化算法(算法3),后悔最小化(算法4)等方法。

類型一:傳統自博弈算法

傳統自博弈算法從單一策略開始,逐步擴展策略池,包括Vanilla self-play(訓練時每次對手都選擇最新生成的策略),Fictitious self-play(訓練時每次對手都在現有訓練完的策略中均勻采樣),δ-uniform self-play(訓練時每次對手都在現有訓練完的最近的百分之δ策略中均勻采樣),Prioritized Fictitious Self-play(根據優先級函數計算當前訓練完的策略的優先級,訓練時每次對手都根據這個優先級進行采樣),Independent RL(訓練時雙方策略都會改變,對手策略不再固定)。

類型二:PSRO 系列算法

類似于傳統自博弈算法,Policy-Space Response Oracle(PSRO)系列算法同樣從單一策略開始,通過計算 ORACLE 逐步擴展策略池,這些新加入的策略是對當前元策略的近似 BR 。PSRO 系列與傳統自博弈算法的主要區別在于,PSRO 系列采用了更復雜的MSS,旨在處理更復雜的任務。例如,α-PSRO 使用了基于 α-rank 的 MSS 來應對多玩家的復雜博弈。

類型三:持續訓練系列算法

PSRO 系列算法中存在的兩個主要挑戰:首先,由于訓練成本大,通常在每次迭代中截斷近似BR計算,會將訓練不充分的策略添加到策略池;其次,在每次迭代中會重復學習基本技能,導致效率較低。為了解決這些挑戰,基于持續訓練系列的算法提倡反復訓練所有策略。與前面提到的兩類最大區別是,持續訓練系列算法同時訓練整個策略池策略。這類算法采用多個訓練周期,并在每個訓練周期內依次訓練策略池所有策略,而不再是通過逐步擴展策略池進行訓練。

類型四:后悔最小化系列算法

另一類自博弈算法是基于后悔最小化的算法。基于后悔最小化的算法與其他類別的主要區別在于,它們優先考慮累積的長期收益,而不僅僅關注單次回合的表現。這種方法可以訓練得到更具攻擊性和適應性的策略,避免隨著時間的推移被對手利用。這些算法要求玩家在多輪中推測并適應對手的策略。這種情況通常在重復博弈中觀察到,而不是單回合游戲中。例如,在德州撲克或狼人游戲中,玩家必須使用欺騙、隱瞞和虛張聲勢的策略,以爭取整體勝利,而不僅僅是贏得一局。

各類型算法比較與總結圖

應用

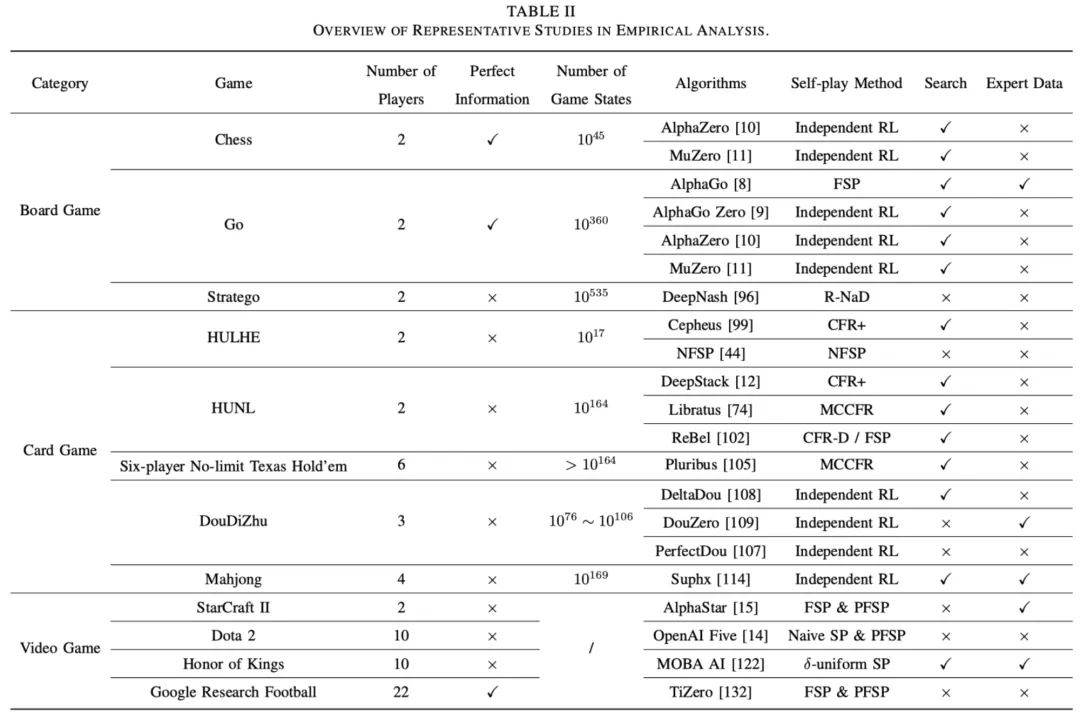

在本節中,我們通過將三類經典場景來介紹自博弈的經典應用:棋類游戲,通常涉及完全信息;牌類游戲(包括麻將),通常涉及不完全信息;以及電子游戲,具有實時動作而非簡單回合制游戲。

場景一:棋類游戲

棋類游戲領域,絕大多數是完全信息游戲,曾因引入兩項關鍵技術而發生革命性變化:位置評估和蒙特卡羅樹搜索。這兩項技術在象棋、西洋跳棋、黑白棋、西洋雙陸棋等棋盤游戲方面展現了超越人類的效果。相比之下,當這些技術應用于圍棋時,由于圍棋棋盤布局種類遠超于上述提到的棋類游戲,因此僅能達到業余水平的表現。直到 DeepMind 推出了 AlphaGo 系列而發生了革命性的變化,AlphaGo 系列算法利用自博弈的強大功能顯著提升了性能,為圍棋領域設立了新的基準。

除了圍棋,還有一種難度較高的棋類游戲是“軍棋”(Stratego)。與大多數完全信息的棋類游戲不同,“軍棋”是一個兩人參與的不完全信息棋盤游戲。游戲分為兩個階段:部署階段,玩家秘密安排他們的單位,為戰略深度奠定基礎;以及游戲階段,目標是推斷對手的布局并奪取他們的旗幟。DeepNash 采用基于進化的自博弈算法 R-NaD 達到了世界第三的人類水平。

場景二:牌類游戲

德州撲克(Texas Hold’em)是一種歐美流行的撲克游戲,適合 2 到 10 名玩家,當玩家數量增加,游戲變得更加復雜。此外,有三種下注形式:無限注、固定注和底池限注。每種形式在具有不同的游戲復雜度。在牌類游戲中,游戲抽象對于簡化游戲復雜程度至關重要,可以將游戲的龐大狀態空間減少到更容易處理的數量。Cepheus 采用后悔最小化系列算法 CFR+ 解決了最容易的雙人有限注德州撲克。對于更復雜的雙人無限注德州撲克,DeepStack 和 Libratus 采用子博弈重新計算的方式來實時做出決策,擊敗職業德州撲克選手。Pluribus 在 Libratus 基礎上更進一步解決了六人無限注德州撲克。

斗地主需要同時考慮農民之間的合作和農民地主之間的競爭。斗地主同樣是不完全信息博弈,這為游戲增加了不確定性和策略深度。DeltaDou 是基于 AlphaZero 開發的首個實現專家級斗地主表現的算法。之后的 DouZero 通過選擇采樣方法而非樹搜索方法來降低訓練成本,采用自博弈獲取訓練數據。

麻將同樣基于不完全信息做出決策,此外,麻將的牌數更多,獲勝牌型也更為復雜,對 AI 更具挑戰性。Suphx 通過監督學習和自我博弈強化學習成為首個達到與人類專家水平的算法。NAGA 和騰訊設計的 LuckyJ 同樣也在在線平臺上達到了人類專家水平。

場景三:電子游戲

與傳統棋類游戲和牌類游戲不同,電子游戲通常具有實時操作、更長的動作序列以及更廣泛的動作空間和觀察空間。在星際爭霸(StarCraft)中,玩家需要收集資源、建設基地并組建軍隊,通過精心的計劃和戰術執行,使對方玩家失去所有建筑物,來取得勝利。AlphaStar 使用監督學習、端到端的強化學習和分層自博弈訓練策略,在星際爭霸II的 1v1 模式比賽中擊敗了職業玩家。

MOBA游戲要求兩支玩家隊伍各自操控他們獨特的英雄,互相競爭以摧毀對方的基地。每個英雄都有獨特的技能,并在隊伍中扮演特定的角色,也無法觀測全部地圖。OpenAI Five 在簡化版本的 Dota 2 中擊敗了世界冠軍隊,其訓練過程使用混合類型自博弈,有 80% 的概率進行 Naive self-play,20% 的概率使用 Prioritized self-play。騰訊同樣采用自博弈訓練在王者榮耀游戲 1v1 和 5v5 模式中都擊敗了職業選手。

Google Research Football(GRF)是一個開源的足球模擬器,輸入是高層次的動作,需要考慮隊友之間的合作和兩個隊伍之間的競爭,且每隊有 11 人。TiKick 通過 WeKick 的自博弈數據進行模仿學習,再利用分布式離線強化學習開發了一個多智能體AI。TiZero將課程學習與自博弈結合,無需專家數據,達到了比TiKick更高的TrueSkill評分。

各場景類型比較與總結圖

討論

自博弈方法因其獨特的迭代學習過程和適應復雜環境的能力而表現出卓越的性能,然而,仍有不少方向值得進一步研究。

雖然許多算法在博弈論理論基礎上提出,但在將這些算法應用于復雜的現實場景時,往往存在理論與現實應用的差距。例如,盡管 AlphaGo、AlphaStar 和 OpenAI Five 在實證上取得了成功,但它們的有效性缺乏正式的博弈論證明。

隨著團隊數量和團隊內玩家數量的增加,自博弈方法的可擴展性面臨顯著挑戰。例如,在 OpenAI Five 中,英雄池的大小被限制在僅17個英雄。根本上是由于自博弈方法在計算和存儲兩個方面訓練效率有限:由于自博弈的迭代特性,智能體反復與自身或過去的版本對戰,因而計算效率較低;自博弈需要維護一個策略池,因而對存儲資源需求較高。

憑借卓越的能力和廣泛的泛化性,大型語言模型(LLM)被認為是實現人類水平智能的潛在基礎。為了減少對人工標注數據的依賴,自博弈方法被利用到微調LLM來增強LLM的推理性能。自博弈方法還在構建具有強大戰略能力的基于 LLM 的代理方面做出了貢獻,在”外交“游戲中達到了人類水平的表現。盡管近期取得了一些進展,將自博弈應用于 LLM 仍處于探索階段。

自我博弈面另一個挑戰是其在現實具身場景中無法直接應用。其迭代特性需要大量的試驗和錯誤,很難直接在真實環境中完成。因此,通常只能在仿真器中進行自博弈訓練,再將自博弈有效部署到現實具身場景中,關鍵問題仍在于克服 Sim2Real 差距。